AI API实用指南: GPT‑5、Claude 4.5、Gemini 2.5对比

AI API实用指南: GPT‑5、Claude 4.5、Gemini 2.5对比

目标读者:希望在国内低门槛调用多个主流大模型的个人与团队开发者,AI 初学者

你将获得:最新模型的选型建议、统一 API 平台的落地方法、最小代码骨架、稳定性与成本策略

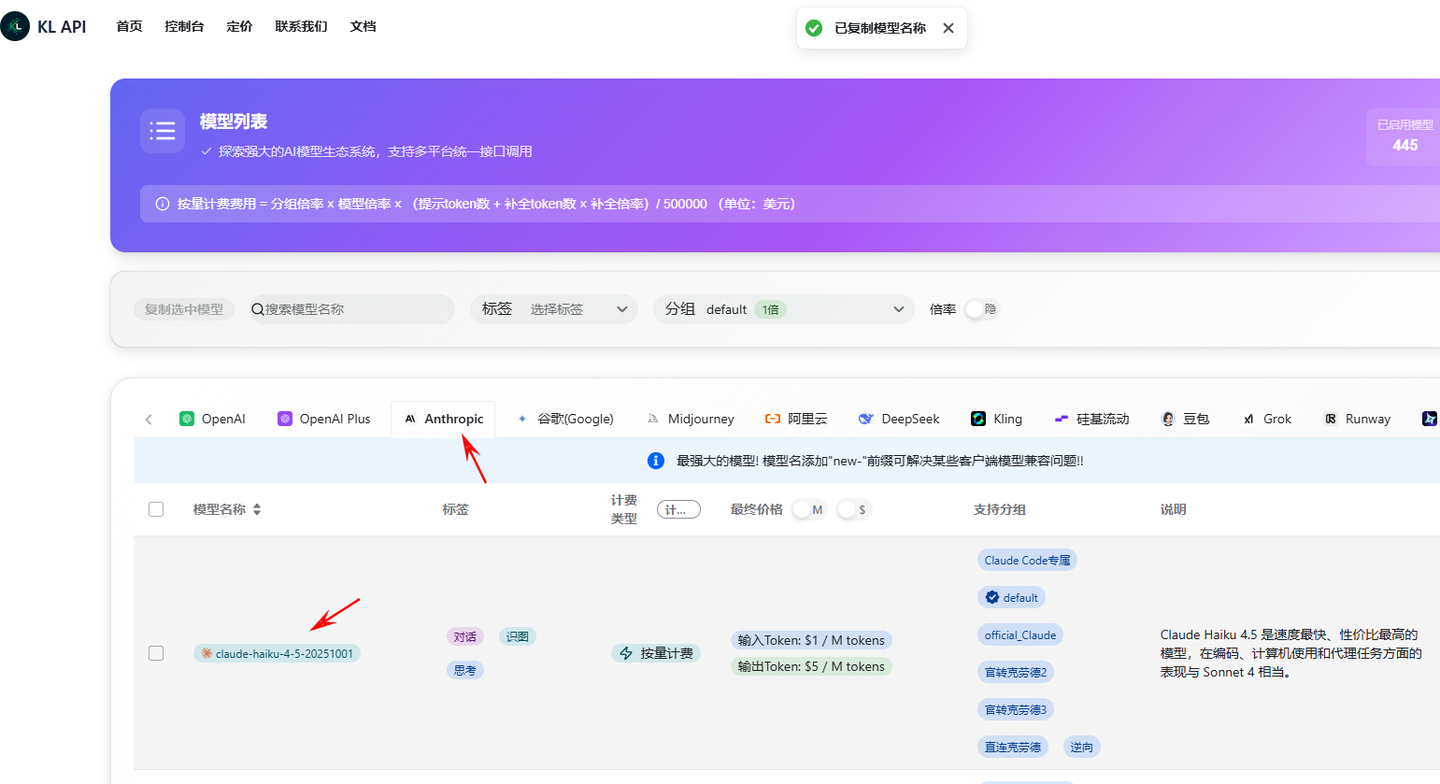

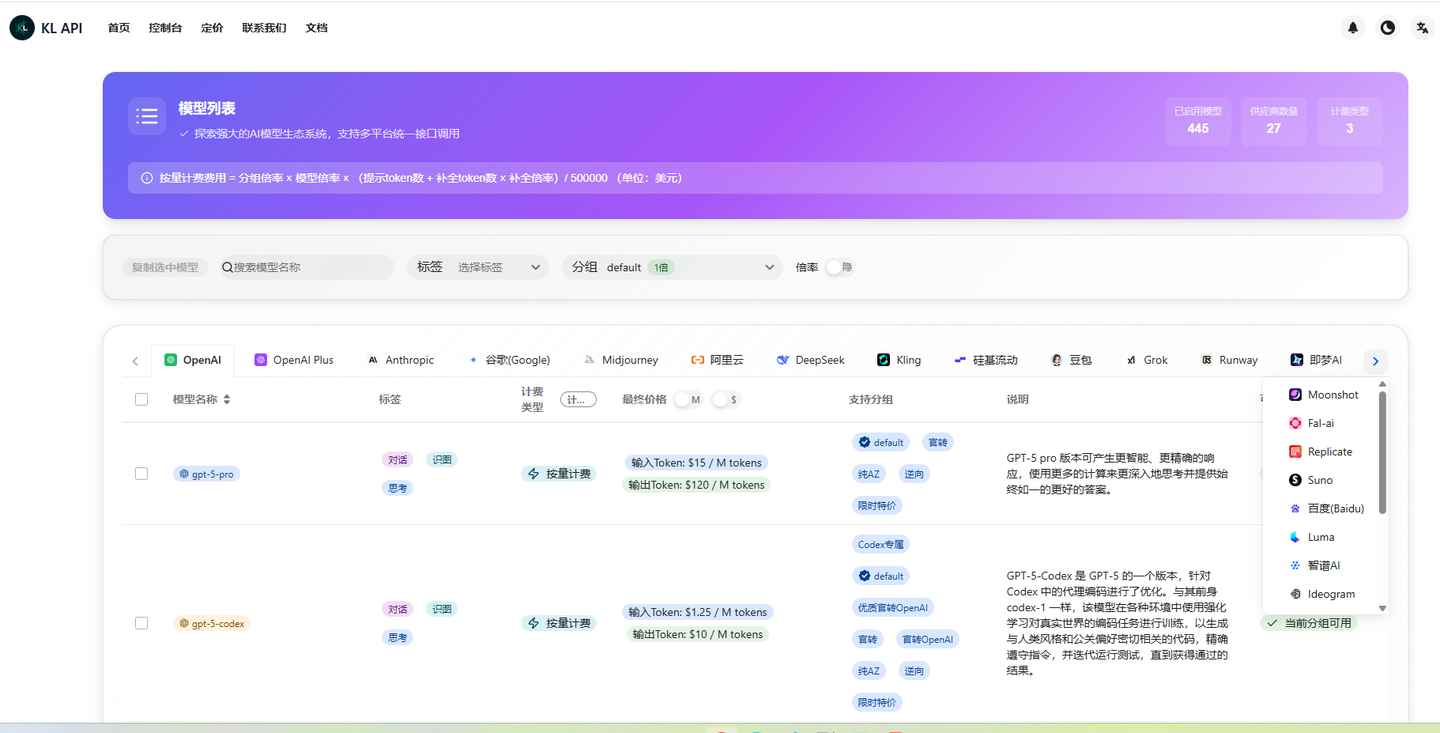

提醒:具体可用型号与价格以平台“模型列表”和后台为准,版本会动态更新

把模型想成你团队里的三位高手:一个通才型“全能队长”、一个“严谨审校专家”、一个“多模态导演”。选得对,项目就会一路顺滑。

一、三巨头模型对比:各司所长,互补协作

OpenAI:GPT‑5 系列(全能队长)

- 优势特征

- 指令遵循稳定,通用推理、代码生成、结构化工具调用都很均衡

- 生态最完整,插件/示例/社区资源丰富

- 典型场景

- 通用助理、复杂分析/推理、工具调用编排、内容创作

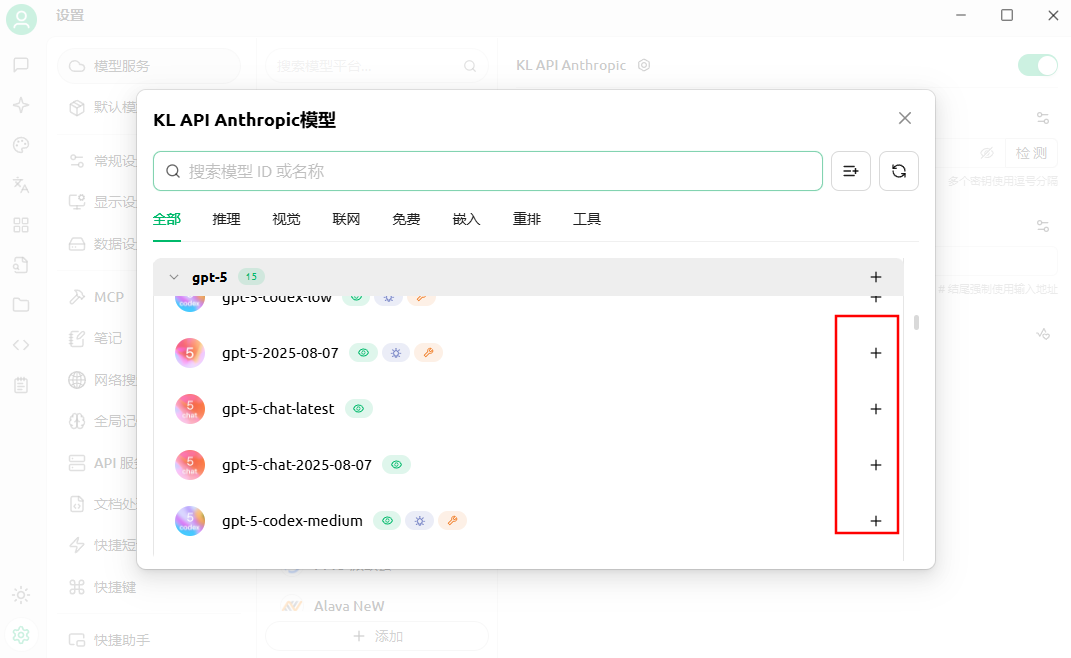

- 选型建议(以平台可用清单为准)

- 旗舰高质量场景:

gpt‑5 - 成本优先或大规模:同系列轻量/mini/nano 型号(以平台提供为准)

- 思考深度:可通过平台参数(如 reasoning_effort 等)在效果与成本间调节(值以文档为准)

- 快速对话:若平台提供

gpt‑5‑chat‑latest,速度与价格友好;如需函数/工具调用或更强推理,请选支持相应能力的子型号

- 旗舰高质量场景:

- 一句话直觉:当你“不确定用谁”且任务复杂,先用 GPT‑5 起步

Anthropic:Claude 4.5 系列(严谨审校专家)

- 优势特征

- 长文档与代码审查见长,输出稳健,安全与对齐表现好

- 专业写作风格更克制,适合高可信度场景

- 典型场景

- 代码生成与审查、长文档解读、技术研究、专业写作

- 选型建议

- 综合与代码任务:

claude‑4.5‑sonnet - 低延迟与快速响应:

claude‑4.5‑haiku - 更高阶推理:若平台提供更高阶型号(如 Opus 系列),用于更复杂任务

- 综合与代码任务:

- 一句话直觉:需要“稳、准、可信”的审查与长文本理解,选 Claude 4.5

Google:Gemini 2.5 系列(多模态导演)

- 优势特征

- 原生多模态(文本/图像/视频/音频),上下文更大,批量任务性价比高

- 对图像/视频结构化理解与生成有优势

- 典型场景

- 跨模态理解、图像/视频分析、架构图/设计图解读、大规模生成与推理

- 选型建议

- 复杂多模态与高质量:

gemini‑2.5‑pro - 成本敏感/大规模:

gemini‑2.5‑flash

- 复杂多模态与高质量:

- 一句话直觉:涉及图片/视频/音频的分析或生成,用 Gemini 2.5

快速选型提示(场景到型号)

- 通用对话与复杂推理:GPT‑5(旗舰)

- 代码审查/长文档:Claude 4.5 Sonnet

- 多模态(图像/视频/音频):Gemini 2.5 Pro

- 批量与低成本:Gemini 2.5 Flash 或同级轻量型号

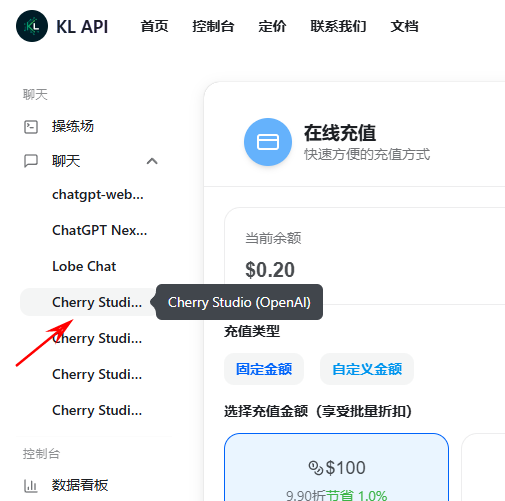

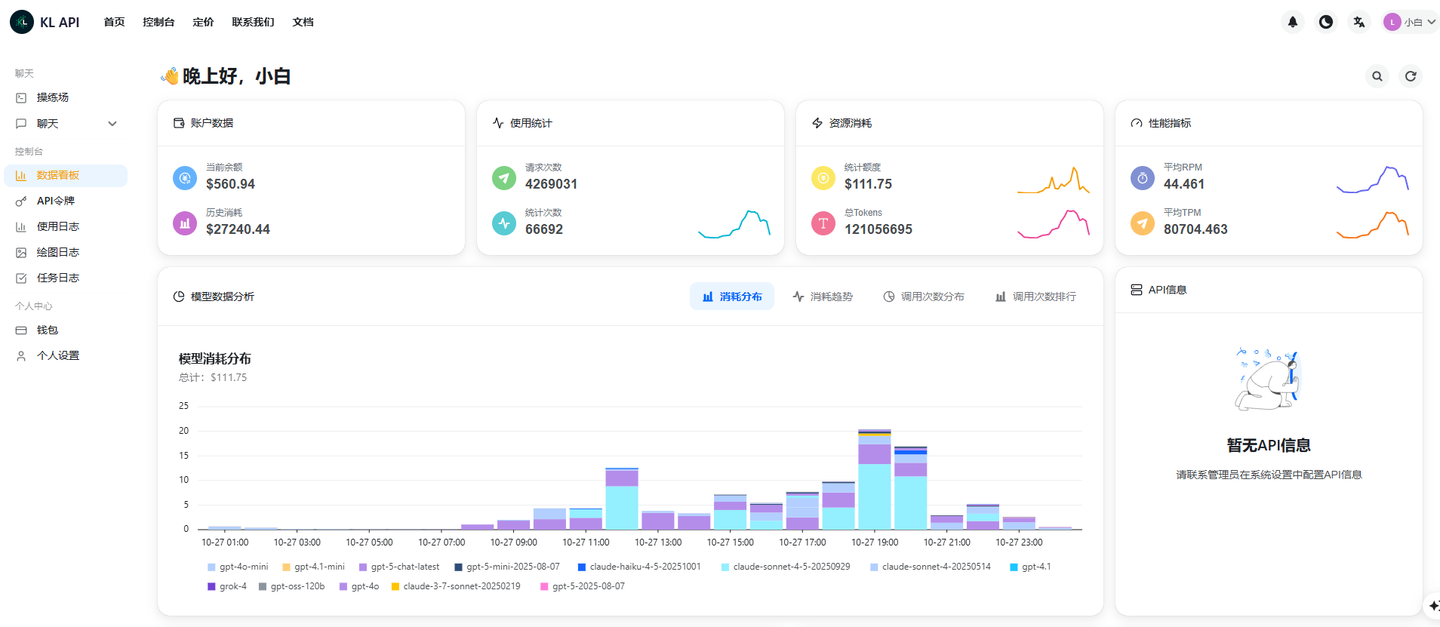

二、对接统一 API 平台

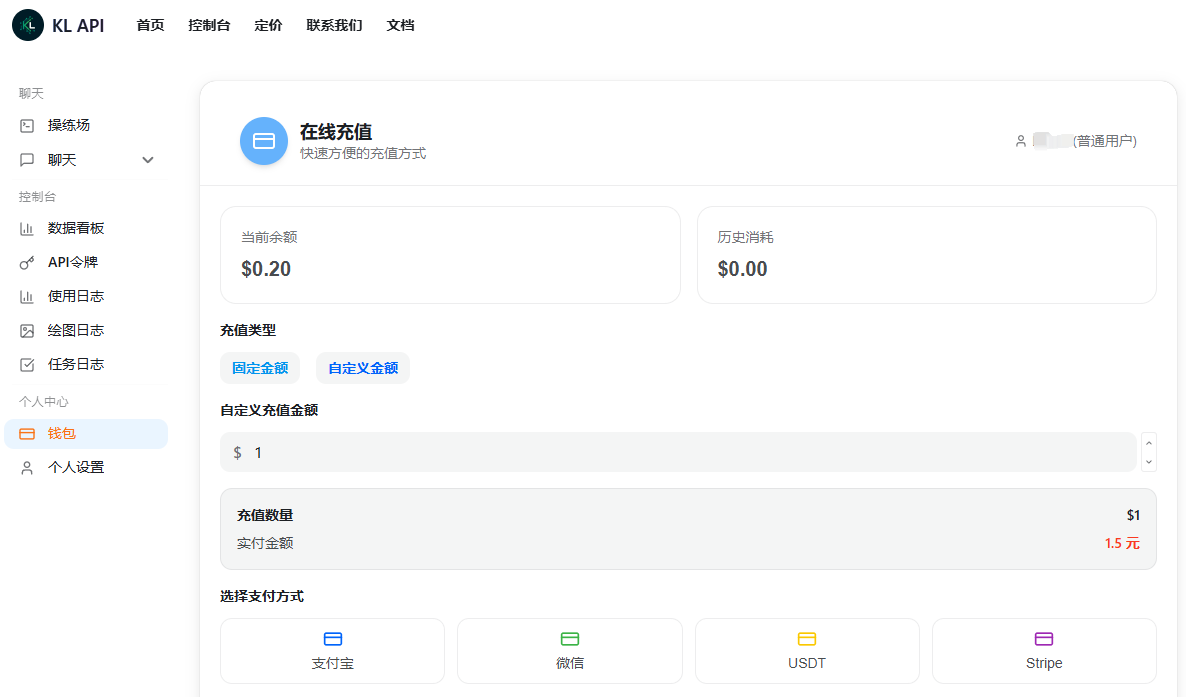

- KL聚合API平台地址:https://api.kl-api.info/

三、3 步上手(最小可用)

1) 注册与登录

- 访问

https://api.kl-api.info/注册登录

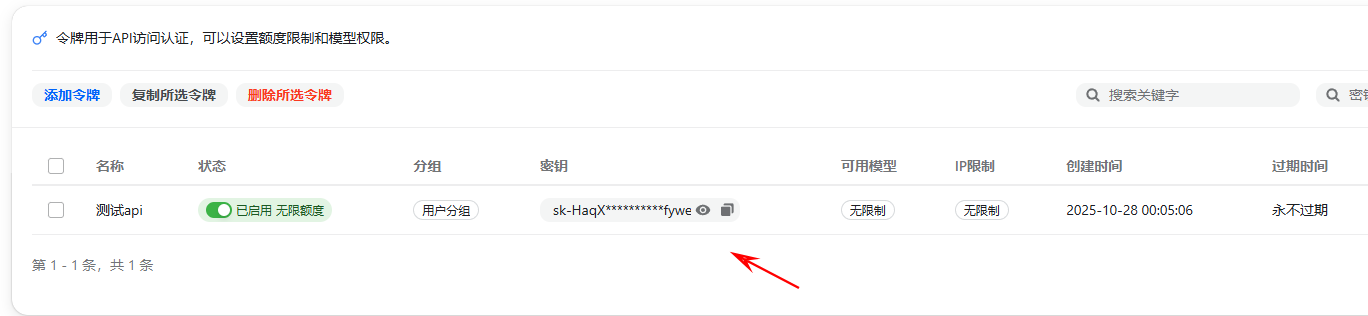

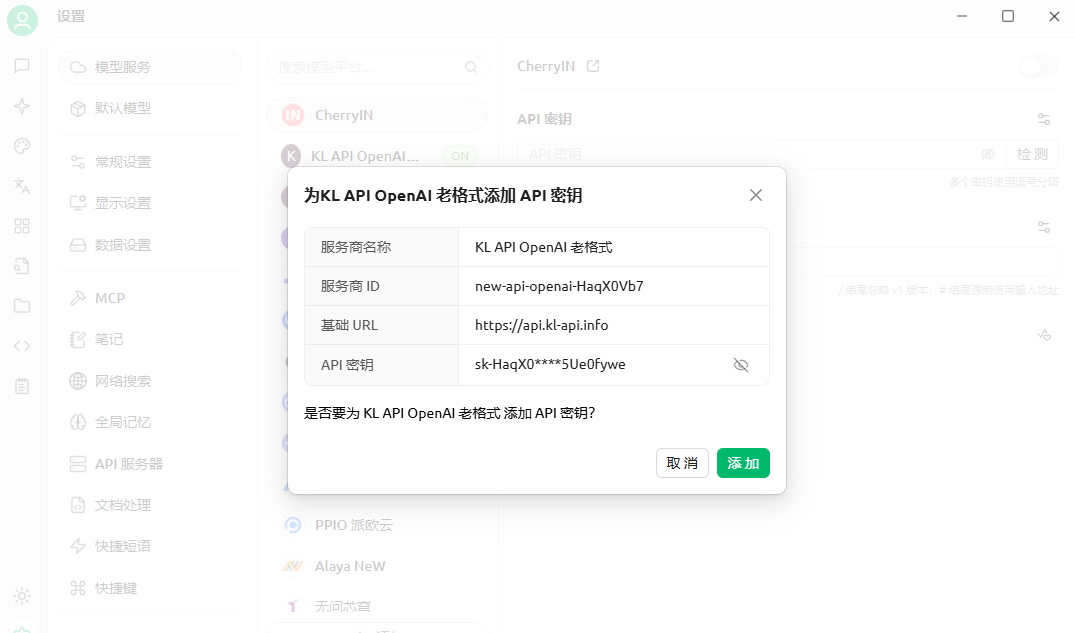

2) 获取 API Key

- 后台“API 管理”创建 Key,妥善保管;一旦泄露,立即作废并重建

3) 首个调用

Python

pip install openai

from openai import OpenAI

client = OpenAI(api_key="your-api-key", base_url="https://api.kl-api.info/v1")

resp = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "system", "content": "你是专业的AI助手"},

{"role": "user", "content": "用Python写一个快速排序,并解释时间复杂度"}

],

temperature=0.4,

max_tokens=800

)

print(resp.choices[0].message.content)

JavaScript / Node.js

npm install openai

import OpenAI from "openai";

const client = new OpenAI({ apiKey: "your-api-key", baseURL: "https://api.kl-api.info/v1" });

const r = await client.chat.completions.create({

model: "claude-4-5-sonnet",

messages: [

{ role: "system", content: "你是专业的代码审查助手" },

{ role: "user", content: "请审查这段代码的复杂度与可读性,并给出改进建议:\n<code here>" }

],

temperature: 0.3,

max_tokens: 800

});

console.log(r.choices[0].message.content);

cURL

curl https://api.kl-api.info/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer your-api-key" \

-d '{

"model": "gemini-2.5-pro",

"messages": [

{ "role": "system", "content": "你是专业的多模态分析助手" },

{ "role": "user", "content": "给我一份30秒的产品视频脚本结构要点" }

],

"temperature": 0.6,

"max_tokens": 600

}'

- 一键切换模型:仅改

model字段即可(如gpt-5/claude-4-5-sonnet/gemini-2.5-pro/gemini-2.5-flash)。精确命名以平台“模型列表”为准。

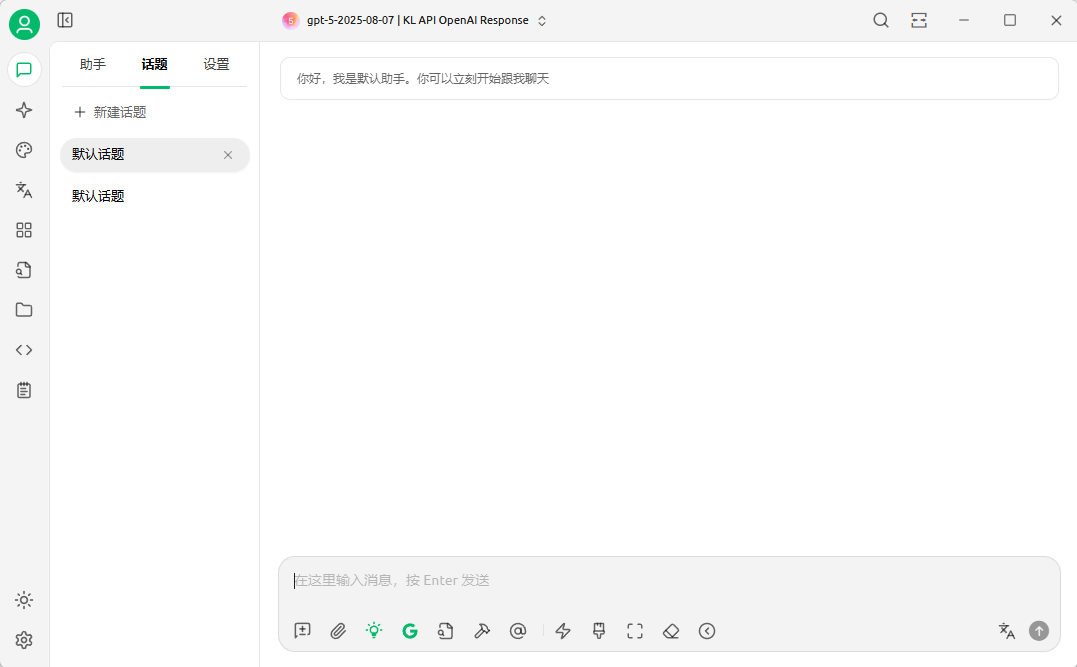

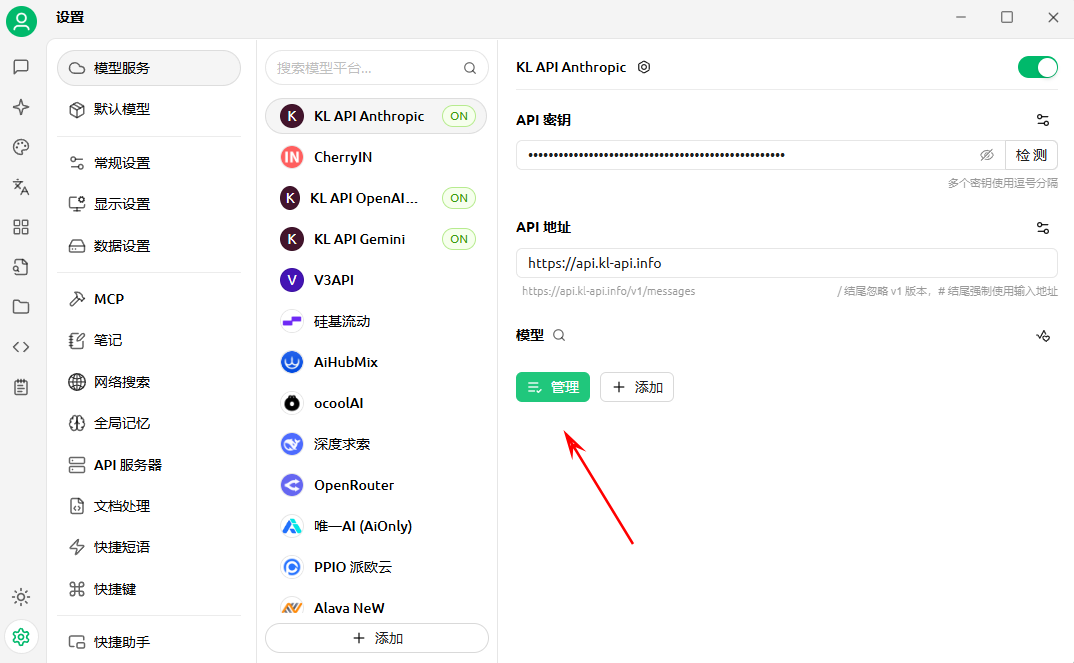

四、快速安装(客户端/CLI 通用)

- 根据你的平台,例如Cherry Studio,点击下载按钮

- 安装该文件

- 双击以打开应用程序

五、一个小而全的实战:代码审查助手(最新型号)

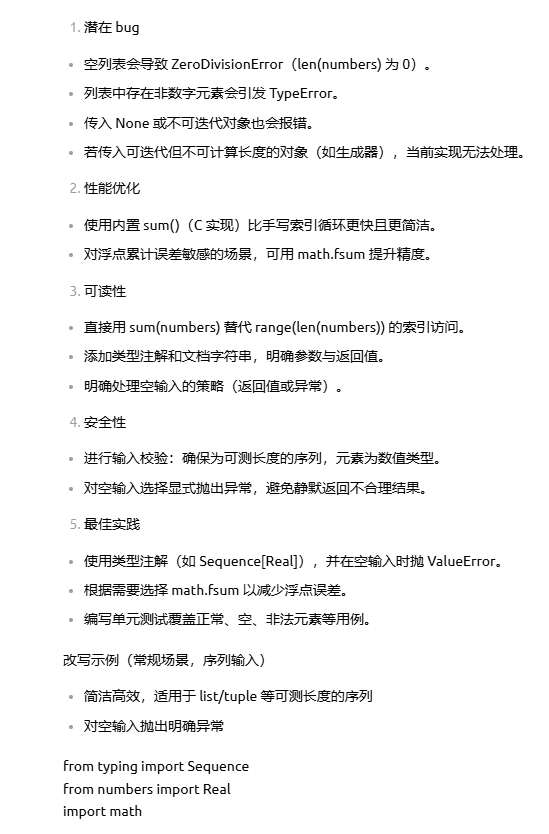

- 目标:输入一段代码,输出五维度审查(潜在 bug / 性能优化 / 可读性 / 安全性 / 最佳实践),必要时给改写示例

- 推荐型号:代码与长文档场景首选

claude-4.5-sonnet

from openai import OpenAI

client = OpenAI(api_key="your-api-key", base_url="https://api.kl-api.info/v1")

def review_code(code, model="claude-4-5-sonnet"):

system = ("你是一名资深代码审查专家。请输出:\n"

"1) 潜在bug 2) 性能优化 3) 可读性 4) 安全性 5) 最佳实践\n"

"给出简洁、可执行的建议,必要时附改写示例。")

r = client.chat.completions.create(

model=model,

messages=[{"role": "system", "content": system},

{"role": "user", "content": f"审查代码:\n{code}"}],

temperature=0.3,

max_tokens=1200

)

return r.choices[0].message.content

sample = """

def calculate_average(numbers):

total = 0

for i in range(len(numbers)):

total += numbers[i]

return total / len(numbers)

"""

print(review_code(sample))

六、稳定性与成本的“硬”做法(工程化清单)

- Key 安全:环境变量/密钥管控;按环境分 Key;泄露可迅速熔断替换

- 参数默认:分析/审查

temperature0.2–0.5;创作 0.7–1.0;max_tokens依据业务上限控制成本 - 流式输出:

stream=true,改善等待体验 - 重试与限流:对 429/5xx 做指数退避;鉴权失败立即中止

- 缓存与去重:FAQ/短翻译命中缓存(内存/Redis);提示词规范化减少重复开销

- 数据与合规:敏感数据先脱敏/摘要化;日志留存最小化

- 预算与监控:记录

model、输入/输出 tokens、耗时、错误码;设日/周/月预算告警与硬阈值

七、避免再次“过时”:版本占位与动态拉取

- 集中管理“当前主力型号”,发布前统一改一次:

LATEST = {

"chat_flagship": "gpt-5",

"code_flagship": "claude-4-5-sonnet",

"multimodal_flagship": "gemini-2.5-pro",

"bulk_economy": "gemini-2.5-flash"

}

# 调用时用 LATEST["code_flagship"] 等

- 动态校对:若平台支持“列出模型”接口,发布前自动拉取核验

from openai import OpenAI

c = OpenAI(api_key="your-api-key", base_url="https://api.kl-api.info/v1")

models = c.models.list()

print([m.id for m in models.data][:20]) # 校对是否包含期望型号

- 文内避免硬编码上下文窗口、速度、价格等易变数字;统一引导“以平台后台为准”

八、决策清单与组合打法(把三位高手排兵布阵)

- 统筹与编排:用 GPT‑5 做复杂推理与工具调用的“总控”

- 审校与长文档:把代码与长文本交给 Claude 4.5 Sonnet,追求稳健

- 跨模态:涉及图片/视频/音频理解与生成时,让 Gemini 2.5 Pro 上场

- 性价比策略:默认走经济型;遇到高难度自动升级到旗舰;失败重试与回退保障稳定

- 团队评测:同一提示在多模型做 A/B,按质量/时延/成本打分,形成你的“私有榜单”

尾声

选对模型是第一步,把它们放到一个好用、好管的统一平台才是真正的生产力。

保持“版本占位 + 动态拉取”的习惯,你的系统就能一直用到最新稳定款。

最后提醒:具体可用型号、价格与功能以平台后台为准;上线前在预发环境用你的提示集做一遍质量回归。

1294

1294

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?