需要安装hadoop

下载

wget https://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-3.5.2/spark-3.5.2-bin-hadoop3-scala2.13.tgz

mv spark-3.5.2-bin-hadoop3-scala2.13.tgz /opt/soft

解压

tar -zxvf spark-3.5.2-bin-hadoop3-scala2.13.tgz

mv spark-3.5.2-bin-hadoop3-scala2.13 spark

修改配置文件

cp spark-env.sh.template spark-env.sh

echo $HADOOP_HOME #查看hadoop环境变量

#添加

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

验证

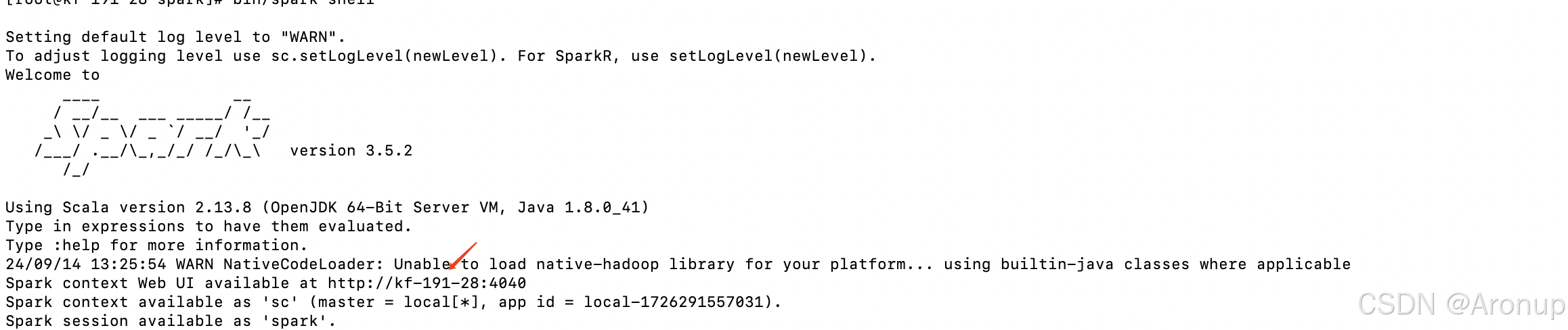

bin/spark-shell #启动spark

执行scala小例子

// 创建一个包含测试文本的RDD

val textRDD = sc.parallelize(Seq("Hello Spark", "Spark is fun", "Big Data Processing"))

// 对文本进行简单的转换操作,比如转换为大写

val upperRDD = textRDD.map(_.toUpperCase())

// 收集并打印结果

upperRDD.collect().foreach(println)

退出spark-shell

:quit

714

714

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?