经历了长达一年半,400 个版本的迭代, auto-coder 终于引来了第一个里程碑版本 1.0.0

这个版本迎来了生态版本的完整覆盖,并且带来了一些史诗级的特性。

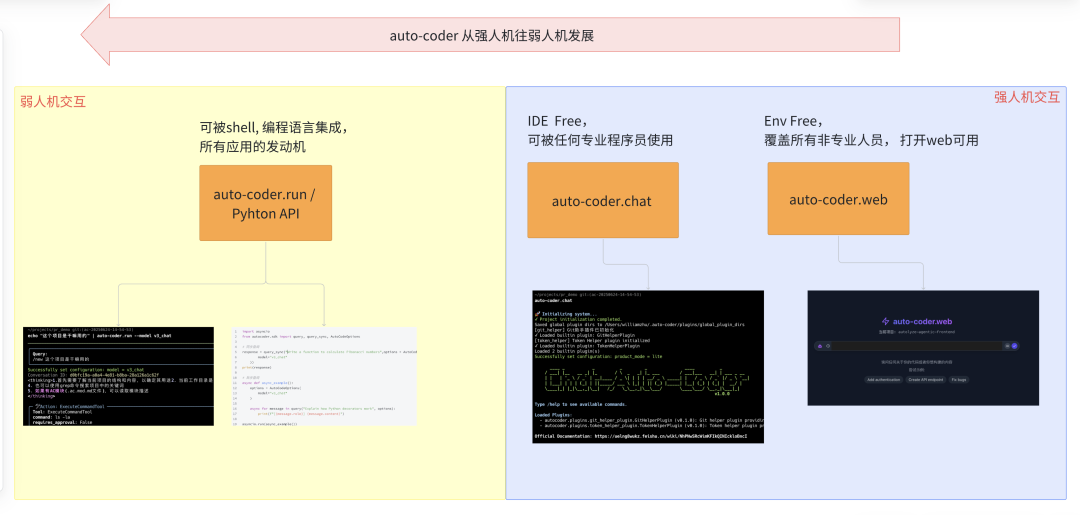

##生态版图

auto-coder 在 1.0.0 版本完成完整布局,覆盖了从手动到全自动化,强人机交互到弱人机交互,从专业程序员到普通用户,从 IDE Free 到 Env Free, 真正意义上的造福和服务所有人群。

1. 如果你想在你的应用中集成自动化生成代码能力,请使用我们的 auto-code.run 和 Python API

2. 如果你想通过代码来操控你的 Code Agent, 请请使用我们的 auto-code.run 和 Python API

3. 如果你希望在 Eclipse , Vim 等各种IDE中使用 AI 辅助编程,请使用我们的 auto-coder.chat , 成熟且健壮。

4. 如果你希望不使用任何 IDE 就能使用 AI辅助编程,请使用 auto-coder.web ,打开网页就可以开始生产软件。

5. 如果你希望能覆盖产品,运营等所有非程序员用户群体,请使用 auto-coder.web ,打开网页就可以开始生产软件。

## 史诗级特性

AC 模块机制的引入

AC Module(Auto Coder Module)是一种全新的以AI为中心的模块化组织方式,专为AI时代设计,我们可以很方便的利用 auto-coder 将传统的代码模块转化为 AC 模块,或者开发新的 AC 模块。 AC 模块可以让大模型完全深入的理解一个项目,无需人类再各种@代码,并且能够无需用户承受”惨烈的review负担“

超长对话支持

AC 模块的引入以及基于验证的编程,会极大的拉长对话,比如可能模型要组合1000次甚至一万次的工具调用才能最终完成功能和过”测试验收“。这个对 AI辅助编程工具是个巨大的挑战, auto-coder 完美解决了这个问题。你可以用200k 的窗口抛出2000k 的上下文。当然,也小心的你钱包。

大模型聚焦机制

支持了超长对话,大模型往往容易忘记最开始的需求。auto-coder 通过一些内置支持,可以在让用户无感的情况下,帮助大模型聚焦原始需求,而不会随着工具调用超过1000次以后就忘掉了之前要干什么了。

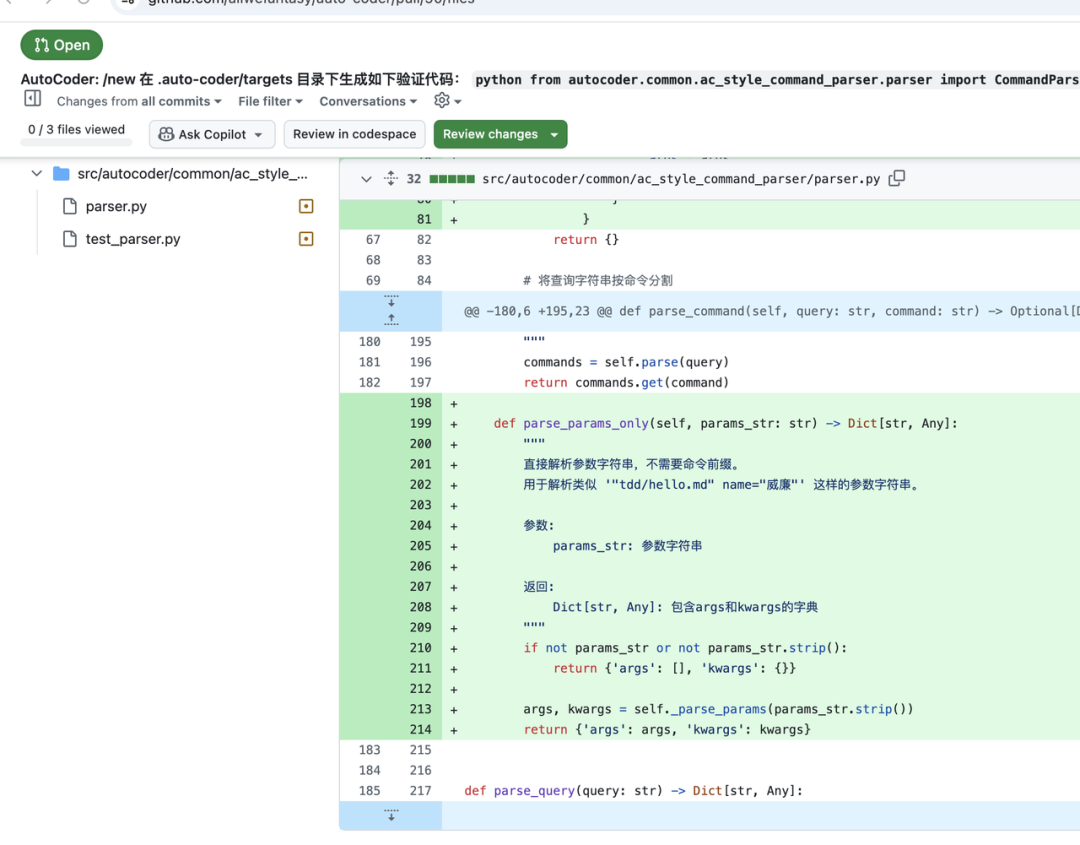

弱人机交互

现在大部分AI辅助编程工具都是强人机交互的,就是copilot 模式,我们提出需求,大模型完成,人review 和教调。随着 AC 模块的引入,AI辅助编程工具将直接给用户提交PR,而且很多情况无需review ,则个时候,我们只要提出需求和验证测试,其实就可以不管了,继续去做其他事情。当前的 chat 交互模式是不合适的。所以我们引入了 CLI(方便在shell脚本或者编程语言中调用) 和 Python API(方便在应用中灵活集成),可以实现异步。比如:

cat job1.md | auto-coder.run --model cus/anthropic/claude-sonnet-4 --pr然后你就可以去干别的,直到 github 接受到PR:

总结

auto-coder 1.0.0 稳定性也得到了极大的提升,将带来一个全新的体验,引领 AI 辅助编程进入一个新时代。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?