决策树每次选择最优的特征进行节点分裂,本文介绍两种最基础的特征选择方法,ID3和C4.5算法。

在介绍这两种算法之前,小编先介绍衡量数据不确定性的指标——熵,数据越随机或不确定,对应的熵越大。

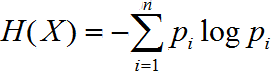

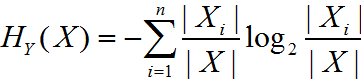

熵的公式:

其中  为变量X取值为i的概率,变量X共有n个取值。

为变量X取值为i的概率,变量X共有n个取值。

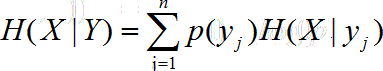

若基于某一个特征Y进行节点分裂,分裂后的熵为H(X|Y)。

条件熵公式:

其中 为变量Y取值

为变量Y取值 的概率。

的概率。

1. ID3算法

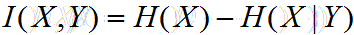

若某一特征划分后的数据不确定性减小的最多,我们就选择对该特征进行分裂,这一原理就是ID3算法。

若X表示特征划分前的数据,Y表示选择划分的特征,I(X,Y)表示对数据X进行特征Y划分后,数据不确定性的减少量。

公式为:

2. C4.5算法

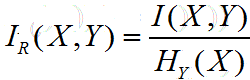

ID3算法的缺点在于:熵的减少量倾向于选择取值较多的特征进行划分,因此C4.5在ID3的基础上,对特征的取值多少进行了归一化。

公式:

其中 为基于特征Y划分后的熵,即特征熵。

为基于特征Y划分后的熵,即特征熵。

是特征Y取值为i的样本个数。

是特征Y取值为i的样本个数。

3. C4.5算法的不足

C4.5算法没有剪枝步骤,算法易于过拟合;

C4.5算法生成的决策树是多叉决策树,在构建机器学习模型的过程中,二叉树往往比多叉树更高效。

C4.5只能用来分类。

下节介绍CART决策树,可以较好的解决C4.5算法的不足。

欢迎扫码关注:

2356

2356

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?