1.引言

使用python的scrapy模块爬取豆瓣读书top250的图书信息,以json的形式保存并存储到mysql。项目所爬取的网站:https://book.douban.com/top250

2.实现代码

- 创建scrapy项目打开命令行在切换到预存储目录中,运行 scrapy startproject douban

生成项目

2.定义item容器

找到items.py文件,这个主要使用来封装爬虫所要爬取的字段。

3.编写spider在项目的spiders目录下新建python文件,用来编写爬取数据的类

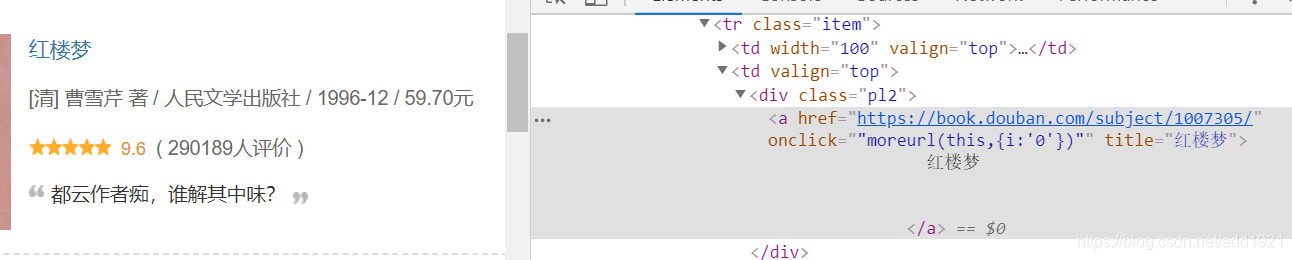

其中对数据的解析可通过浏览器的审查元素中找到对应字段的数据,如tiltle自段为tr[@class="item”]中的td[@valign=“top”]/div[@class=“pl2”]/a/@title。

4.存储pipelines

本文介绍了一个使用Python的Scrapy框架爬取豆瓣读书Top250图书信息的项目。首先创建Scrapy项目,然后定义Item容器来封装爬取字段。接着编写Spider解析数据,并通过审查元素确定数据位置。数据存储有两种方式:保存为JSON文件和存入MySQL数据库。在项目过程中,作者遇到了问题,但经过深入学习后成功解决,增加了对爬虫技术的理解。

本文介绍了一个使用Python的Scrapy框架爬取豆瓣读书Top250图书信息的项目。首先创建Scrapy项目,然后定义Item容器来封装爬取字段。接着编写Spider解析数据,并通过审查元素确定数据位置。数据存储有两种方式:保存为JSON文件和存入MySQL数据库。在项目过程中,作者遇到了问题,但经过深入学习后成功解决,增加了对爬虫技术的理解。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

928

928

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?