cgroup原理:可以参考美团的文章来理解:Linux资源管理之cgroups简介

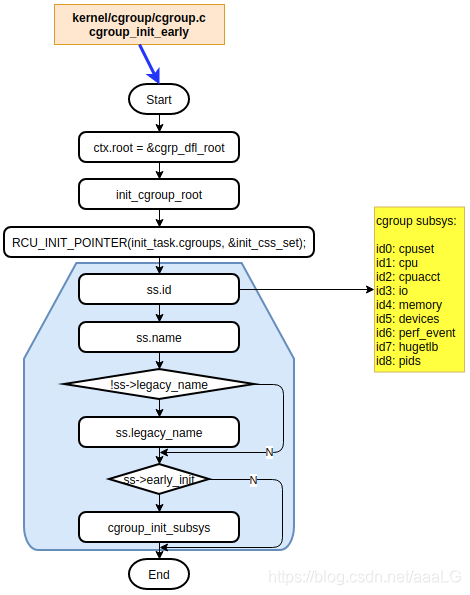

函数流程

函数作用:cgroup初始化,并按照是否需要early_init(Bool)配置,初始化相关的子系统

cgroup支持的各子系统

cpuset

/* kernel/cgroup/cpuset.c */

struct cgroup_subsys cpuset_cgrp_subsys = {

.css_alloc = cpuset_css_alloc,

.css_online = cpuset_css_online,

.css_offline = cpuset_css_offline,

.css_free = cpuset_css_free,

.can_attach = cpuset_can_attach,

.cancel_attach = cpuset_cancel_attach,

.attach = cpuset_attach,

.post_attach = cpuset_post_attach,

.bind = cpuset_bind,

.fork = cpuset_fork,

.legacy_cftypes = legacy_files,

.dfl_cftypes = dfl_files,

.early_init = true,

.threaded = true,

};

cpu

// kernel/sched/core.c

struct cgroup_subsys cpu_cgrp_subsys = {

.css_alloc = cpu_cgroup_css_alloc,

.css_online = cpu_cgroup_css_online,

.css_released = cpu_cgroup_css_released,

.css_free = cpu_cgroup_css_free,

.css_extra_stat_show = cpu_extra_stat_show,

.fork = cpu_cgroup_fork,

.can_attach = cpu_cgroup_can_attach,

.attach = cpu_cgroup_attach,

.legacy_cftypes = cpu_legacy_files,

.dfl_cftypes = cpu_files,

.early_init = true,

.threaded = true,

};

cpuacct

// kernel/sched/cpuacct.c

struct cgroup_subsys cpuacct_cgrp_subsys = {

.css_alloc = cpuacct_css_alloc,

.css_free = cpuacct_css_free,

.legacy_cftypes = files,

.early_init = true,

};

io

// block/blk-cgroup.c

struct cgroup_subsys io_cgrp_subsys = {

.css_alloc = blkcg_css_alloc,

.css_online = blkcg_css_online,

.css_offline = blkcg_css_offline,

.css_free = blkcg_css_free,

.can_attach = blkcg_can_attach,

.css_rstat_flush = blkcg_rstat_flush,

.bind = blkcg_bind,

.dfl_cftypes = blkcg_files,

.legacy_cftypes = blkcg_legacy_files,

.legacy_name = "blkio",

.exit = blkcg_exit,

.depends_on = 1 << memory_cgrp_id,

};

memory

// mm/memcontrol.c

struct cgroup_subsys memory_cgrp_subsys = {

.css_alloc = mem_cgroup_css_alloc,

.css_online = mem_cgroup_css_online,

.css_offline = mem_cgroup_css_offline,

.css_released = mem_cgroup_css_released,

.css_free = mem_cgroup_css_free,

.css_reset = mem_cgroup_css_reset,

.can_attach = mem_cgroup_can_attach,

.cancel_attach = mem_cgroup_cancel_attach,

.post_attach = mem_cgroup_move_task,

.dfl_cftypes = memory_files,

.legacy_cftypes = mem_cgroup_legacy_files,

.early_init = 0,

};

devices

// security/device_cgroup.c

struct cgroup_subsys devices_cgrp_subsys = {

.css_alloc = devcgroup_css_alloc,

.css_free = devcgroup_css_free,

.css_online = devcgroup_online,

.css_offline = devcgroup_offline,

.legacy_cftypes = dev_cgroup_files,

};

perf_event

// kernel/events/core.c

struct cgroup_subsys perf_event_cgrp_subsys = {

.css_alloc = perf_cgroup_css_alloc,

.css_free = perf_cgroup_css_free,

.css_online = perf_cgroup_css_online,

.attach = perf_cgroup_attach,

.implicit_on_dfl = true,

.threaded = true,

};

hugetlb

// mm/hugetlb_cgroup.c

struct cgroup_subsys hugetlb_cgrp_subsys = {

.css_alloc = hugetlb_cgroup_css_alloc,

.css_offline = hugetlb_cgroup_css_offline,

.css_free = hugetlb_cgroup_css_free,

.dfl_cftypes = hugetlb_files,

.legacy_cftypes = hugetlb_files,

};

pids

// kernel/cgroup/pids.c

struct cgroup_subsys pids_cgrp_subsys = {

.css_alloc = pids_css_alloc,

.css_free = pids_css_free,

.can_attach = pids_can_attach,

.cancel_attach = pids_cancel_attach,

.can_fork = pids_can_fork,

.cancel_fork = pids_cancel_fork,

.release = pids_release,

.legacy_cftypes = pids_files,

.dfl_cftypes = pids_files,

.threaded = true,

};

1250

1250

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?