参考:https://www.youtube.com/watch?v=aButdUV0dxI&list=PLvOO0btloRntpSWSxFbwPIjIum3Ub4GSC

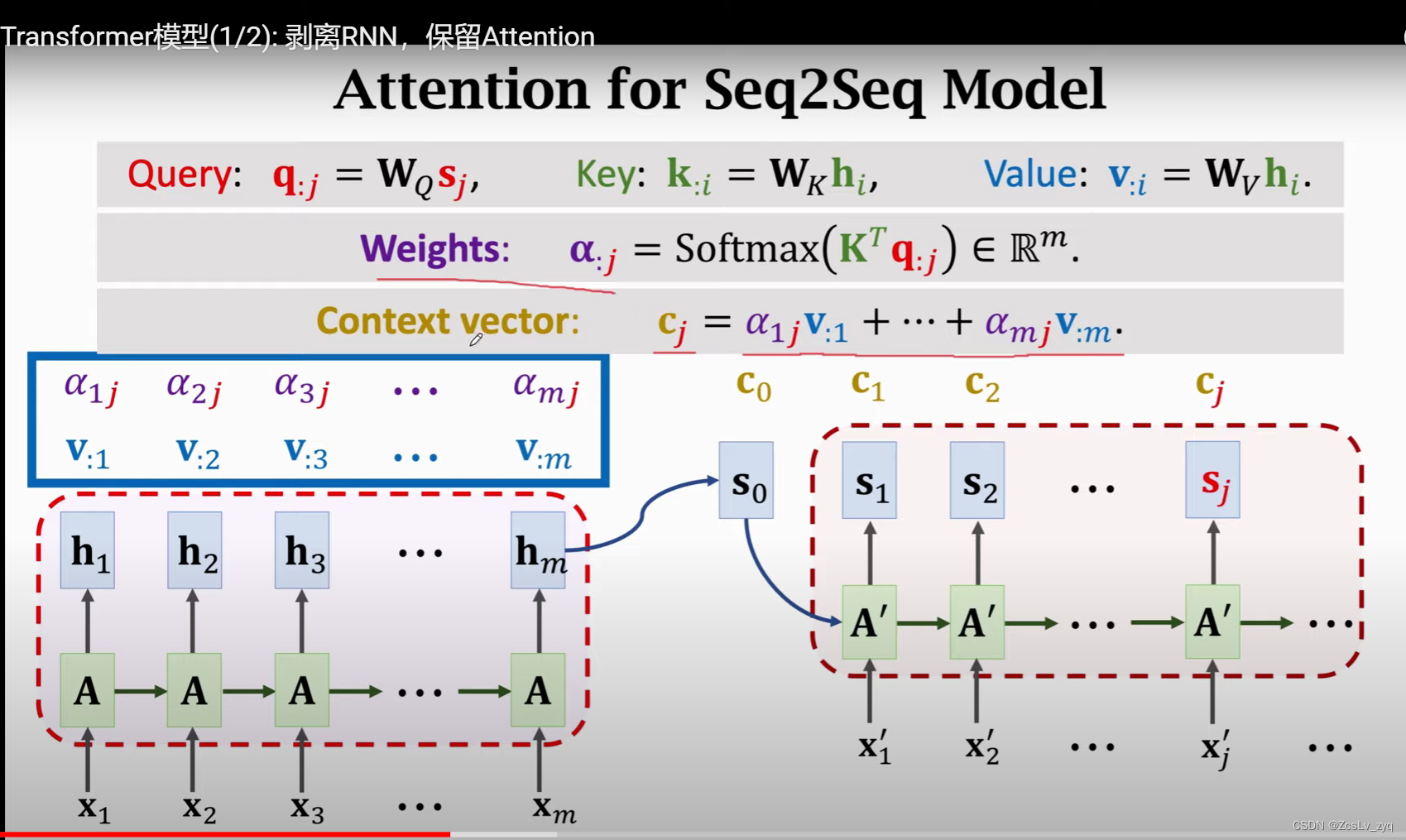

1、attention for seq2seq model

seq2seq包含一个encoder和一个decoder。encoder类似于rnn,deocder类似于文本生成器。

attention机制如何引入?

在计算decoder的每一个step生成时,会用到attention,那么其中的Q、K、V如何去理解?

首先,我们想得到每个step的生成c,c肯定是由权重乘积再相加得来的。那么权重参数以及与它相乘的数肯定是与encoder有关的。

1)对于encoder的每一个step的状态h,分别乘以W(k) W(v),得到key value ,所有的step的key value组成大矩阵K V。

2)K与decoder的当前step的状态s 进行softmax操作,得到权重矩阵 A。

3)A再与V值进行加权求和得到当前step的结果c。

本文介绍了注意力机制在深度学习中的应用,从seq2seq模型中的attention,到无需RNN的attention,再到self-attention层。在seq2seq中,attention通过计算Q、K、V来获取生成c的权重;去掉RNN后,直接用词向量获取K、V;self-attention层则在一个序列输入中,让每个输出都与所有输入相关。Transformer利用self-attention实现高效信息传递。

本文介绍了注意力机制在深度学习中的应用,从seq2seq模型中的attention,到无需RNN的attention,再到self-attention层。在seq2seq中,attention通过计算Q、K、V来获取生成c的权重;去掉RNN后,直接用词向量获取K、V;self-attention层则在一个序列输入中,让每个输出都与所有输入相关。Transformer利用self-attention实现高效信息传递。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?