Appearance-based Gaze Estimation using Visual Saliency

基于视觉显著性的外观注视估计

Y usuke Sugano, Y asuyuki Matsushita, and Y oichi Sato

【摘要】

本文提出了一种基于视觉显著性图的凝视感知方法,该方法不需要显式的个人标定。

我们的目标是创建一个凝视估计器,该估计器仅使用从观看视频剪辑的人捕获的眼睛图像。

我们的方法将视频帧的显著性映射 视为注视点的概率分布。

我们根据人眼图像的相似度 对显著性图进行聚合,以有效地从显著性图中识别注视点。

我们使用高斯过程回归建立了眼睛图像到注视点之间的映射。

此外,我们使用凝视估计器的反馈回路来细化凝视概率图,以提高凝视估计的准确性。

实验结果表明,该方法适用于不同的人和视频片段,达到了3.5度的准确度,足以估计用户在显示器上的注意力。

指标项:注视估计、视觉注意、面部和手势识别。

We aggregate the saliency maps based on the similarity in eye images to efficiently identify the gaze points from the saliency maps.

我们根据人眼图像的相似度对显著性图进行聚合,以有效地从显著性图中识别注视点。

We establish a mapping between the eye images to the gaze points by using Gaussian process regression.

我们使用高斯过程回归建立了眼睛图像到注视点之间的映射。

In addition, we use a feedback loop from the gaze estimator to refine the gaze probability maps to improve the accuracy of the gaze estimation.

此外,我们使用凝视估计器的反馈回路来细化凝视概率图,以提高凝视估计的准确性。

The experimental results show that the proposed method works well with different people and video clips and achieves a 3.5-degree accuracy, which is sufficient for estimating a user’s attention on a display.

Index Terms—Gaze estimation, Visual attention, Face and gesture recognition.

实验结果表明,该方法适用于不同的人和视频片段,达到了3.5度的准确度,足以估计用户在显示器上的注意力。

指标项:注视估计、视觉注意、面部和手势识别。

【介绍】

【介绍】

凝视估计对于预测人类注意力很重要,因此可以用来更好地理解人类活动以及交互系统。凝视评估有着广泛的应用,包括在线内容和数字看板的市场分析、凝视驱动的交互式显示以及许多其他人机界面。----------------------------过渡

一般来说,通过分析一个人眼睛的外观来进行凝视估计。基于相机的遥感方法有两类:基于模型的遥感方法和基于外观的遥感方法。基于模型的方法使用几何眼睛模型及其相关特征。他们使用专用硬件,如多个同步摄像头和红外光源,提取眼睛的几何特征以确定注视方向。另一方面,基于外观的方法使用从商品相机观察到的眼睛的自然外观,而不需要任何专用硬件。已经提出了基于摄像头的凝视估计器的各种实现,包括商业产品(最近的调查见[1])。---------简单介绍

在以前的凝视估计器中,一个关键的挑战是需要明确的个人校准来适应个人用户。这些现有系统中的用户总是需要通过注视明确的参考点来积极参与校准任务。大多数估算方法面临的另一个问题是校准漂移,其校准精度在很大程度上取决于用户和安装设置。在实际应用系统中,有时需要使用交互式局部校准方案,例如用户反馈[2],以纠正个人校准错误。在许多情况下,这种主动的个人校准限制性太大,因为它会中断自然的互动,并且无法进行不可见的凝视估计。虽然可以使用专用硬件(如多个光源[3]、[4]、[5]和立体相机[6])减少个人校准的参考点数量,但仍需要用户积极参与校准任务。

在基于模型的方法中,众所周知,凝视方向可以近似估计为光轴方向,而无需个人校准[7]。然而,它与视觉轴的偏移量(对应于实际的注视方向)可能高达5度[1],[4],并且精确度因个体而异。更重要的是,这种基于硬件的尝试为应用程序设置添加了强大的约束,这自然会限制用户场景。

以前的研究旨在完全消除对明确的个人校准过程的需要。Yamazoe等人使用一个简单的眼球模型进行凝视估计,并通过在用户移动眼睛时将模型与用户眼睛的外观相匹配来执行自动校准[8]。在Sugano等人的方法中,本着与[2]类似的精神,用户的自然鼠标输入用于基于外观的凝视估计的增量个人校准,无需任何校准说明[9]。

这两种方法都只使用单目相机,然而,这些方法仍有一些局限性。Y amazoe等人的方法由于简化的眼球模型而存在不精确性,Sugano等人的方法只能应用于有用户输入的交互环境

can be used to better understand human activities as well as interactive systems.

可以用来更好地理解人类活动以及交互系统。

There is a wide range of applications for gaze estimation including market analysis of online content and digital signage, gaze-driven interactive displays, and many other human-machine interfaces.

凝视评估有着广泛的应用,包括在线内容和数字看板的市场分析、凝视驱动的交互式显示以及许多其他人机界面。

In general, gaze estimation is achieved by analyzing the appearance of a person’s eyes.

一般来说,通过分析一个人眼睛的外观来进行凝视估计。

remote sensing methods: 遥感方法

Model-based methods use a geometric eye model and its associated features.

基于模型的方法使用几何眼睛模型及其相关特征

Using specialized hardware such as multiple synchronized cameras and infrared light sources, they extract the geometric features of an eye to determine the gaze direction.

他们使用专用硬件,如多个同步摄像头和红外光源,提取眼睛的几何特征以确定注视方向。 Appearance-based methods, on the other hand, use the natural appearances of eyes observed from a commodity camera without requiring any dedicated hardware.

另一方面,基于外观的方法使用从商品相机观察到的眼睛的自然外观,而不需要任何专用硬件。

专用硬件 use specialized hardware , require dedicated hardware.

by fixating their eyes on explicit reference points.

让他们的眼睛盯着明确的参考点。

Another problem that most estimation methods suffer from is calibration drift, and their calibration accuracy highly depends on the users and installation settings.

大多数估算方法面临的另一个问题是校准漂移,其校准精度在很大程度上取决于用户和安装设置。

An interactive local calibration scheme with, e.g., user feedback [2], is sometimes required in practical application systems to correct personal calibration errors.

在实际应用系统中,有时需要使用交互式局部校准方案,例如用户反馈[2],以纠正个人校准错误。

In many scenarios, such active personal calibration is too restrictive as it interrupts natural interactions and makes unnoticeable gaze estimation impossible.

在许多情况下,这种主动的个人校准限制性太大,因为它会中断自然的互动,并且无法进行不可见的凝视估计。

It is also well known in the class of model-based approaches that the gaze direction can be approximately estimated as the direction of the optical axis without requiring personal calibration [7]. However, its offset with the visual axis, which corresponds to the actual gaze direction, can be as large as 5 degrees [1], [4], and the accuracy varies significantly based on the individual.

在基于模型的方法中,众所周知,凝视方向可以近似估计为光轴方向,而无需个人校准[7]。然而,它与视觉轴的偏移量(对应于实际的注视方向)可能高达5度[1],[4],并且精确度因个体而异。

There are previous studies that aim at completely removing the need for explicit personal calibration processes. 以前的研究旨在完全消除对明确的个人校准过程的需要。

Yamazoe et al. use a simple eyeball model for gaze estimation and perform automatic calibration by fitting the model to the appearance of a user’s eye while the user is moving his/her eyes [8].

Yamazoe等人使用一个简单的眼球模型进行凝视估计,并通过在用户移动眼睛时将模型与用户眼睛的外观相匹配来执行自动校准[8]。

In Sugano et al.’s method, in a similar spirit to [2], a user’s natural mouse inputs are used for the incremental personal calibration of the appearance-based gaze estimation without any calibration instructions [9]

Sugano等人的方法中,本着与[2]类似的精神,用户的自然鼠标输入用于基于外观的凝视估计的增量个人校准,无需任何校准说明[9]。

Both methods use only a monocular camera, however, these approaches still have some limitations. Y amazoe et al.’s approach suffers from inaccuracy due to the simplified eyeball model, and Sugano et al.’s approach can only be applied to interactive environments with user inputs.

这两种方法都只使用单目相机,然而,这些方法仍有一些局限性。Y amazoe等人的方法由于简化的眼球模型而存在不精确性,Sugano等人的方法只能应用于有用户输入的交互环境。

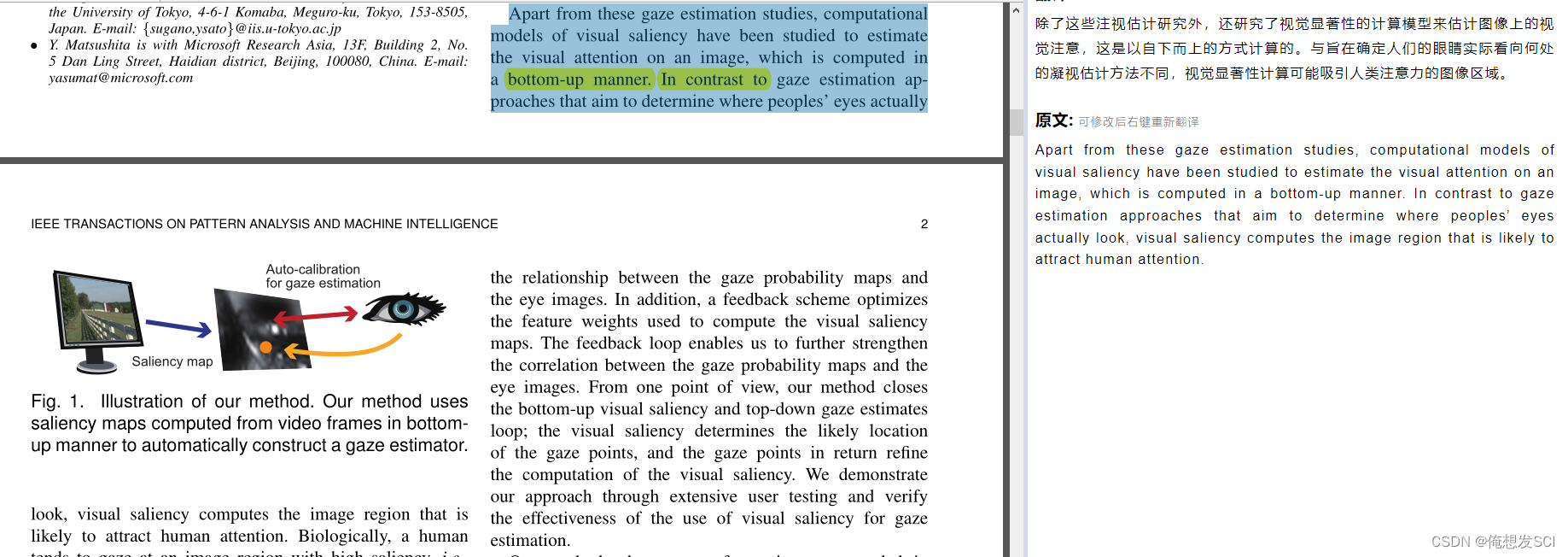

图1 :说明我们的方法。我们的方法使用自底向上方式从视频帧计算的显著性映射来自动构造注视估计器 ------------------------------在视频帧中用自底向上方式 ,计算出中间那个图就是显著性映射(图) ,来自动构造的一个注视估计器

除了这些注视估计研究外,还研究了视觉显著性的计算模型来估计图像上的视觉注意,这是以自下而上的方式计算的。与旨在确定人们眼睛实际看向何处的凝视估计方法不同,视觉显著性计算图像区域,以吸引人们的注意力。从生物学角度来看,人类倾向于注视具有高显著性的图像区域,即与周围区域相比,包含独特视觉特征的区域。继Koch和Ullman提出视觉显著性的原始概念【10】之后,在【11】、【12】、【13】、【14】、【15】中提出了各种自下而上的视觉显著性图计算模型。实验表明,自下而上的视觉显著性与注视位置之间存在相关性【16】。然而,视觉注意机制尚未被完全理解。众所周知,在自然动态场景下,注视预测变得更加困难,在这种场景中,高水平的任务和知识对注视控制的影响更大【17】。

-----------------------不研究注视估计了 ,研究视觉显著性的计算模型 --------------------之前的实验都表明 自下而上的视觉显著性&注视位置有关!!!视觉显著性有用!!!!!

Apart from these gaze estimation studies, computational models of visual saliency have been studied to estimate the visual attention on an image, which is computed in a bottom-up manner. In contrast to gaze estimation approaches that aim to determine where peoples’ eyes actually look, visual saliency computes the image region that is likely to attract human attention.

除了这些注视估计研究外,还研究了视觉显著性的计算模型来估计图像上的视觉注意,这是以自下而上的方式计算的。与旨在确定人们的眼睛实际看向何处的凝视估计方法不同,视觉显著性计算可能吸引人类注意力的图像区域。

. Experiments show that there is a correlation between bottom-up visual saliency and fixation locations [16]. However, the visual attention mechanism is not yet fully understood.实验表明,自下而上的视觉显著性与注视位置之间存在相关性【16】。然而,视觉注意机制尚未被完全理解。

It is already known that fixation prediction becomes much more difficult under natural dynamic scenes, in which a high-level task and knowledge have a stronger influence on the gaze control [17]

. 众所周知,在自然动态场景下,注视预测变得更加困难,在这种场景中,高水平的任务和知识对注视控制的影响更大【17】

注视估计(自上而下)和视觉显著性(自下而上)模型密切相关。尽管如此,并没有多少研究将这两个主题联系起来。

Kienzle等人[18]、[19]提出了一种利用凝视估计数据学习自下而上视觉显著性计算模型的方法。在他们的工作中,视觉显著性图被建模为高斯径向基函数的线性组合,并使用支持向量机(SVM)学习其系数。

Judd等人【20】以及Zhao和Koch【21】也将这种方法用于不同的功能和更大的数据库。低层图像特征(如颜色和强度)和高层特征(如人脸检测器)的线性权重通过SVM学习【20】。

在[21]中,通过使用活动集方法解决非负最小二乘问题来学习最佳特征权重。

这些方法使用注视点学习精确的显著性模型。

与这些方法不同,我们的目标是从视觉显著性图的集合中创建一个凝视估计器。据我们所知,这是第一次使用视觉显著性作为注视估计的先验信息。

-------------------------先验信息就是用啥去实现我们的目标

目前没有多少人研究 ,我们研究!!!

Gaze estimation (top-down) and visual saliency (bottomup) models are closely related. Nonetheless, not many studies exist that bridge these two subjects. 注视估计(自上而下)和视觉显著性(自下而上)模型密切相关。尽管如此,并没有多少研究将这两个主题联系起来。

Kienzle et al. [18], [19] propose a method for learning the computational models of bottom-up visual saliency by using the gaze estimation data.Kienzle等人[18]、[19]提出了一种利用凝视估计数据学习自下而上视觉显著性计算模型的方法。

A visual saliency map is modeled in their work as a linear combination of the Gaussian radial basis functions, and their coefficients are learned using a support vector machine (SVM). 在他们的工作中,视觉显著性图被建模为高斯径向基函数的线性组合,并使用支持向量机(SVM)学习其系数。

Judd et al. [20] and Zhao and Koch [21] also use this approach with different features and a larger database. The linear weights of low-level image features (e.g., color and intensity) and high-level features (e.g., face detector) are learned via the SVM in [20]. Judd等人【20】以及Zhao和Koch【21】也将这种方法用于不同的

本文提出了一种无需显式个人校准的凝视估计方法,利用视频帧的视觉显著性图。方法包括显著性提取、显著性聚合和估计器构造,生成的凝视概率图与实际注视点高度相关。实验表明,该方法在不同用户和视频片段上实现了约3.5度的精度,适用于显示器注意力的估计。

本文提出了一种无需显式个人校准的凝视估计方法,利用视频帧的视觉显著性图。方法包括显著性提取、显著性聚合和估计器构造,生成的凝视概率图与实际注视点高度相关。实验表明,该方法在不同用户和视频片段上实现了约3.5度的精度,适用于显示器注意力的估计。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

24

24

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?