jiebaR包

*

library(RColorBrewer)

library(wordcloud2)

library(jiebaRD)

library(jiebaRD)

cutter=woker()

cutter[./2018年政府工作报告全文.txt]

分词

f=scan(“./2018年政府工作报告全文.segment.2018-05-17_17_51_44.txt”,sep=”\n”,what=” “,encoding=”UTF-8”)

读取分词好的文件

mydata=read.csv(“2018年政府工作报告全文.txt”,stringsAsFactors=FALSE,header=FALSE)

seg=qseg[f]

过滤掉字长小于二的词语

seg=seg[nchar(seg)>1]

统计词频

seg=table(seg)

过滤掉数字

seg=seg[!grepl(‘[0-9]+’,names(seg))]

length(seg)

排序

seg=sort(seg,decreasing = T)[1:200]

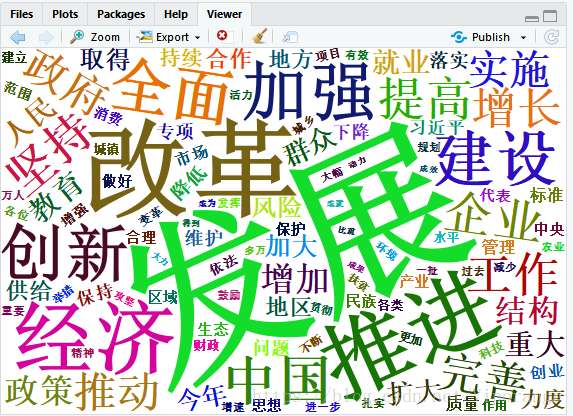

生成词云

wordcloud2(seg)

Rwordseg包

library(rJava)

library(Rwordseg)

library(wordcloud2)

分词

text=segmentCN(“D:/学习/R/work2/2018年政府工作报告全文.txt”,stringsAsFactors=FALSE,header=FALSE)

读入分词文件

text1=(“D:/学习/R/work2/2018年政府工作报告全文.segment.txt”,stringsfactors=FALSE,header=FALSE)

正则表达式按空格把词汇分开

word=lapply(X=text1,FUN=strsplit,”\s”) #返回一个list

word1=unlist(word)

统计词频

df=table(word1)

df=sort(df,decreasing=T)

把词汇词频存入数据框

df1=data.frame(word=names(df),freq=df)

dd=df[,2:3]

生成词云

wordcloud(dd)

本文介绍了如何利用R语言中的jiebaR和Rwordseg包进行中文文本分词,并制作词云。首先,通过jiebaR包对文本进行分词,然后过滤掉长度小于二的词语和数字,统计词频并排序,最后生成词云。接着,使用Rwordseg包进行分词,同样进行词频统计,最后制作词云。这两个包为R中处理中文文本提供了有效工具。

本文介绍了如何利用R语言中的jiebaR和Rwordseg包进行中文文本分词,并制作词云。首先,通过jiebaR包对文本进行分词,然后过滤掉长度小于二的词语和数字,统计词频并排序,最后生成词云。接着,使用Rwordseg包进行分词,同样进行词频统计,最后制作词云。这两个包为R中处理中文文本提供了有效工具。

814

814

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?