1、权重衰减

权重衰减(Weight Decay)是深度学习中的一种正则化技术,用于防止模型过拟合。它通过在损失函数中增加一个关于模型权重的惩罚项,来约束模型的权重大小,使得模型的权重不会过大,从而提高模型的泛化能力。

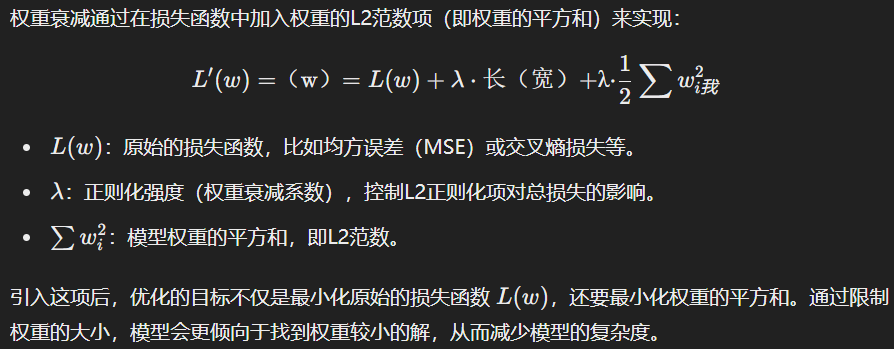

具体来说,权重衰减通过在目标损失函数中加入权重参数的L2范数(即权重的平方和),使得在优化过程中,不仅要最小化原始损失函数,还要最小化模型权重的大小。这样的做法能够有效地防止模型在训练集上表现得过于复杂,以至于在验证集或测试集上表现不佳。

作用

-

防止过拟合:减少模型复杂度,使得模型在训练集和验证集之间保持更好的一致性。

-

控制权重大小:防止权重变得过大,有助于提高模型的稳定性。

应用: 在许多深度学习框架中(如TensorFlow、PyTorch等),可以通过设置优化器中的参数来实现权重衰减。

2、权重衰减的原理

权重衰减的原理可以从优化过程中的正则化角度来理解,其主要目标是防止模型过拟合并提高泛化能力。它通过对模型的权重施加额外的约束,使模型更偏向简单的、具有良好泛化能力的解。

具体来说,权重衰减的原理可以从以下几个方面解释:

1. 正则化的思想

在机器学习中,正则化是一种用来防止过拟合的技术。过拟合指的是模型在训练集上表现很好,但在验证集或测试集上表现较差,通常是因为模型学习到了训练数据中的噪声或特定模式,而不是泛化规律。

正则化通过在损失函数中引入关于模型复杂度的惩罚项,迫使模型选择更简单的解,减少在训练数据中的过拟合。权重衰减是正则化的一种形式,它通过对模型的权重进行限制,使权重值不能过大。

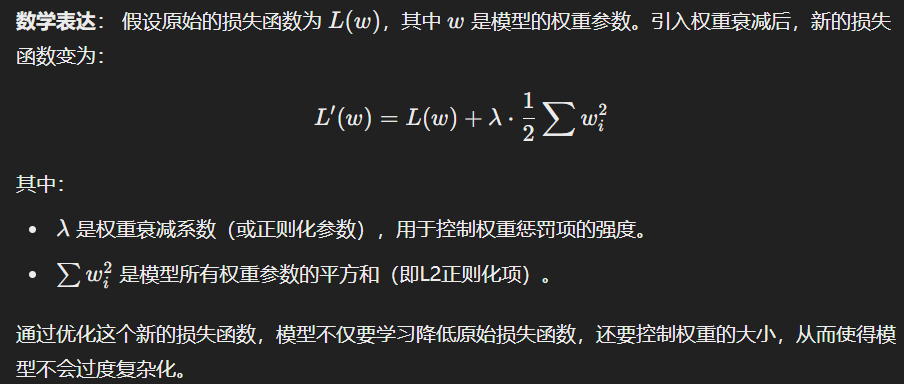

2.权重衰减的数学机制

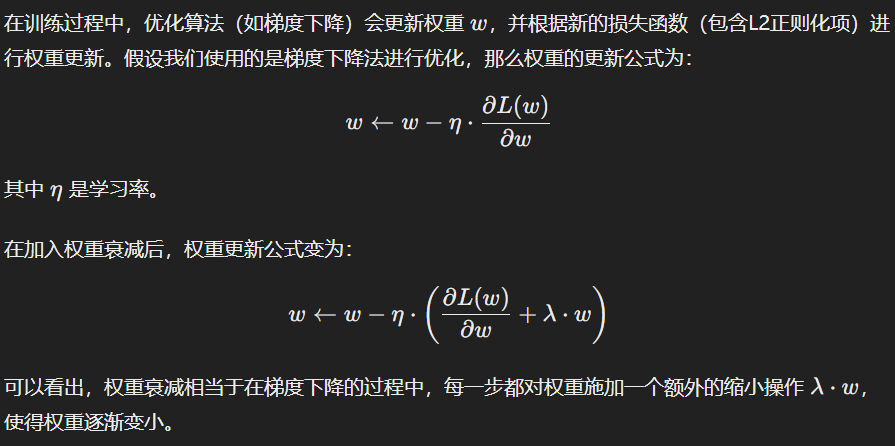

3.梯度下降中的权重衰减

4. 几何解释

从几何角度看,权重衰减引入的L2正则化项相当于在损失函数的优化过程中,限制了模型的权重空间。没有权重衰减时,模型可能会在高维参数空间中自由搜索,找到可能过拟合的解。而引入权重衰减后,相当于在优化过程中施加了一种约束,避免权重值过大,迫使模型找到权重较小、更加

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

436

436

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?