目录

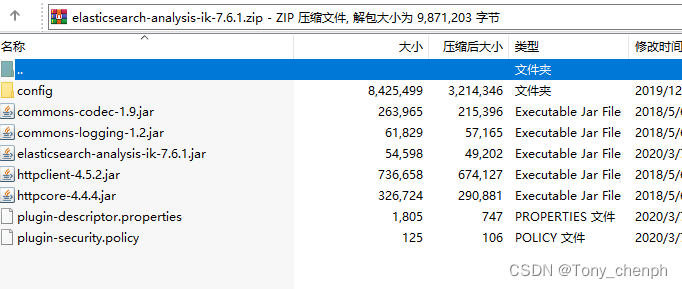

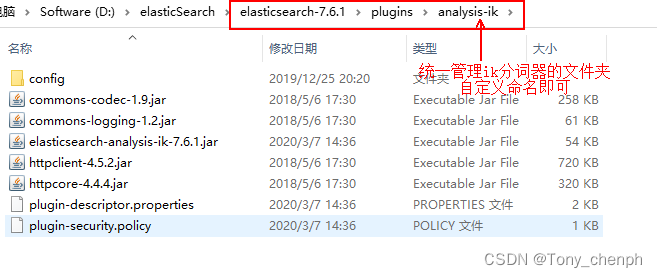

2、下载完毕后解压,放入到elasticsearch的plugins下即可

3、重启elasticsearch,可以看到ik分词器被加载了

4、也可以通过elasticsearch-plugin这个命令来查看加载进来的插件

6.2、在当前目录下新建一个词典,my.dic(以.dic结尾,命名自己定义)

6.3、打开IKAnalyzer.cfg.xml文件(ik分词器的配置文件)

6.4、重启elasticsearch即可把自定义的词典加载进来

IK分词器是elasticsearch的一个插件

分词的主要用于把一段中文或者英文的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词器是将每个字看成一个词,比如"我爱技术"会被分为"我","爱","技","术",这显然不符合要求,所以我们需要安装中文分词器IK来解决这个问题

IK提供了两个分词算法:ik_smart和ik_max_word

ik_smart为最少切分,添加了歧义识别功能,推荐

ik_max_word为最细粒度切分,能切的都会被切掉

1、IK分词器下载

下载地址:https://github.com/medcl/elasticsearch-analysis-ik

注意要下载release版本,具体版本最好与elasticsearch的版本对应

如果下载了源码则需要自己手动打包

2、下载完毕后解压,放入到elasticsearch的plugins下即可

在elasticsearch的plugins下,可以新建一个文件夹管理ik分词器解压后的文件

本文介绍了如何在elasticsearch中安装和配置IK分词器,包括下载对应版本的插件,将其放入plugins目录,重启服务,以及通过kibana测试分词效果。此外,还详细阐述了如何扩展配置词典,包括创建自定义词典,修改配置文件,并验证自定义词典的生效。

本文介绍了如何在elasticsearch中安装和配置IK分词器,包括下载对应版本的插件,将其放入plugins目录,重启服务,以及通过kibana测试分词效果。此外,还详细阐述了如何扩展配置词典,包括创建自定义词典,修改配置文件,并验证自定义词典的生效。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4992

4992

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?