1. 安装

1.1 安装ES

Elasticsearch下载地址 要求:JDK1.8+

Elasticsearch与 Tomcat类似,下载安装包后解压即可使用。我这里下载的是最新的7.6.2版本

解压后,首先设置跨域支持,后面可能用得上(连接es相关工具)。在./config/elasticsearch.yml中添加跨域支持

http.cors.enabled: true

http.cors.allow-origin: "*"

在bin目录上方地址栏输入cmd打开终端输入elasticsearch.bat或者双击elasticsearch.bat文件即可启动

在启动时碰到过以下几个问题:

1.cmd启动显示中文乱码问题

解决方案:

在./config/jvm.options配置文件中设置字符集格式,重新启动就不会显示乱码了。

-Dfile.encoding=GBK

2.启动后无法访问ES服务器地址 localhost:9200

控制台显示:

received plaintext http traffic on an https channel, closing connection Netty4HttpChannel

这是由于ES 7.X版本后默认开启了安全认证,改成false即可

至此, Elasticsearch就可以正常访问了

1.2 安装可视化插件Elasticsearch head

下载地址,该插件是一个web项目,需要nodejs环境,下载后执行

npm install

启动:

npm run start

启动后打开 : localhost:9100查看

1.3 安装可视化工具Kibana

注意: kibana版本需要与es版本一致 ,安装同样简单,下载解压即可使用,双击 ./bin/kibana.bat启动后

在浏览器中访问 5601端口即可

kibana界面默认为英文,支持国际化,在./config/kibana.yml中最后一行设置即可

i18n.locale: “zh-CN”

设置后重启服务

2. ES核心概念

elasticsearch是面向文档的,

| Relational DB | ElasticSearch |

|---|---|

| 数据库(database) | 索引(indices) |

| 表(tables) | types 慢慢会被弃用! |

| 行(rows) | documents |

| 字段(columns) | fields |

elasticsearch(集群)中可以包含多个索引(数据库) ,每个索引中可以包含多个类型(表) ,每个类型下又包含多个文档(行) ,每个文档中又包含多个字段(列)。

🍑 索引(“库”)

索引是映射类型的容器, elasticsearch中的索引是一个非常大的文档集合。 索引存储了映射类型的字段和其他设置。然后它们被存储到了各个分片上了。我们来研究下分片是如何工作的。

🍑 类型(“表”)

类型是文档的逻辑容器,就像关系型数据库一样,表格是行的容器。类型中对于字段的定义称为映射,比如name映射为字符串类型。我们说文档是无模式的,它们不需要拥有映射中所定义的所有字段,比如新增一个字段,那么elasticsearch是怎么做的呢?

elasticsearch会自动的将新字段加入映射,但是这个字段的不确定它是什么类型,elasticsearch就开始猜,如果这个值是18,那么elasticsearch会认为它是整形。但是elasticsearch也可能猜不对,所以最安全的方式就是提前定义好所需要的映射,这点跟关系型数据库殊途同归了,先定义好字段,然后再使用,别整什么幺蛾子。

🍑 文档(”行“)

之前说elasticsearch是面向文档的,那么就意味着索引和搜索数据的最小单位是文档,elasticsearch中,文档有几个重要属性:

- 自我包含,一篇文档同时包含字段和对应的值,也就是同时包含key:value !

- 可以是层次型的,一个文档中包含自文档,复杂的逻辑实体就是这么来的! {就是一个json对象 ! fastjson进行自动转换 !}

- 灵活的结构,文档不依赖预先定义的模式,我们知道关系型数据库中,要提前定义字段才能使用,在elasticsearch中,对于字段是非常灵活的,有时候,我们可以忽略该字段,或者动态的添加一个新的字段。

🍎 倒排索引

简单说就是 按(文章关键字,对应的文档<0个或多个>)形式建立索引,根据关键字就可直接查询对应的文档(含关键字的),无需查询每一个文档

elasticsearch使用的是一种称为倒排索引的结构,采用的是Lucene倒排索引作为底层,这种结构适合全文搜索,一个索引由文档中所有不重复的列表构成,对于每一个词,都有一个包含他的文档列表,例如,如下两个文档

study every day,good good up to forever # 文档1

To forever, study every day,good good up # 文档2

为了创建倒排索引,首先需要将每个文档拆分成独立的词条,然后创建一个包含所有不重复词条的排序列表

3. IK分词器

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一一个匹配操作,默认的中文分词是将每个字看成一个词(不使用用IK分词器的情况下,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。

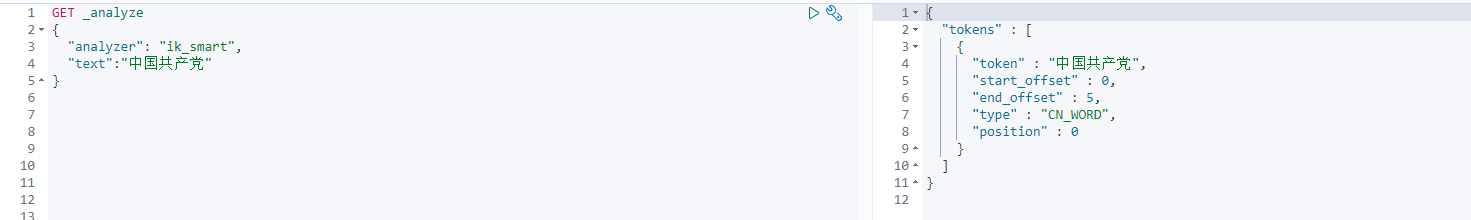

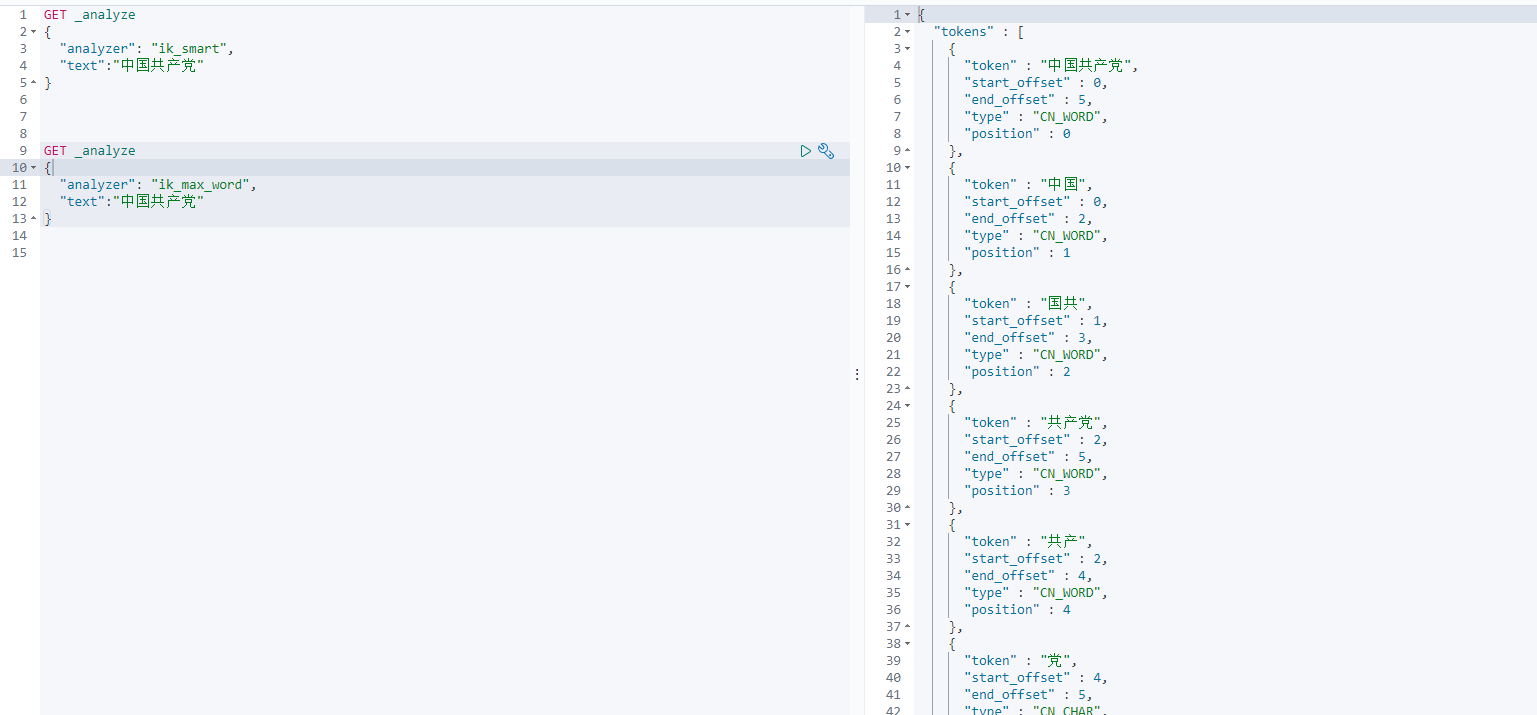

IK提供了两个分词算法: ik_smart和ik_max_word ,其中ik_smart为最少切分, ik_max_word为最细粒度划分!

下载地址,下载后解压到./plugins文件夹即可,

重启服务使用kibana测试

查看分词效果

ik_smart 分词器

ik_max_word 分词器

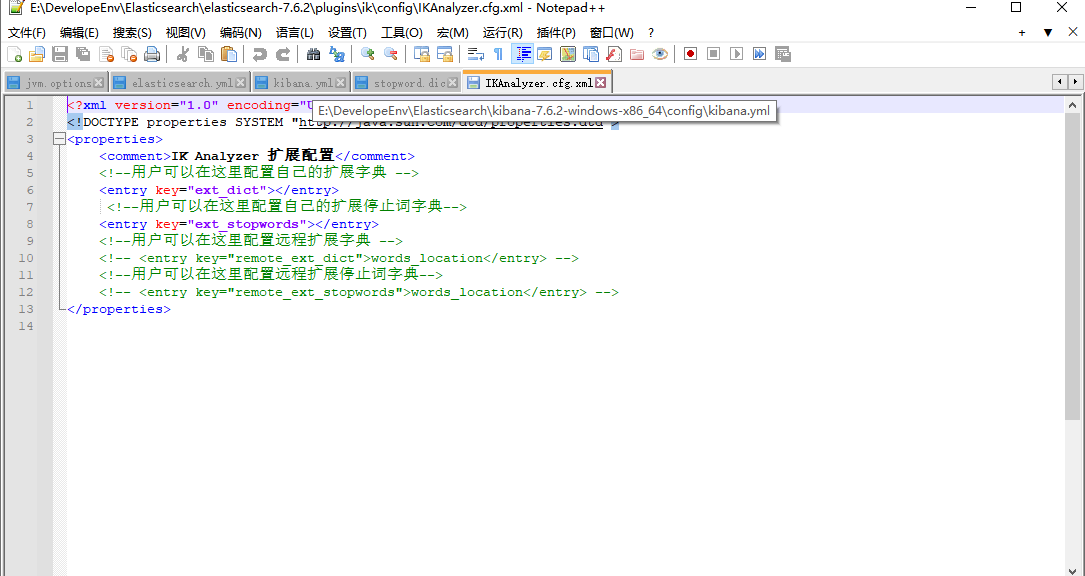

有时候,分词效果不是我们预期的,可以在./ik/config/IKAnalyzer.cfg.xml中配置我们自己需要的词典

4. RestAPI操作

一种软件架构风格,而不是标准,只是提供了一组设计原则和约束条件。它主要用于客户端和服务器交互类的软件。基于这个风格设计的软件可以更简洁,更有层次,更易于实现缓存等机制。

4.1 基本Rest命令说明

| method | url地址 | 描述 |

|---|---|---|

| PUT(创建,修改) | localhost:9200/索引名称/类型名称/文档id | 创建文档(指定文档id) |

| POST(创建) | localhost:9200/索引名称/类型名称 | 创建文档(随机文档id) |

| POST(修改) | localhost:9200/索引名称/类型名称/文档id/_update | 修改文档 |

| DELETE(删除) | localhost:9200/索引名称/类型名称/文档id | 删除文档 |

| GET(查询) | localhost:9200/索引名称/类型名称/文档id | 查询文档通过文档ID |

| POST(查询) | localhost:9200/索引名称/类型名称/文档id/_search | 查询所有数据 |

4.2 索引操作

创建一个索引,不指定类型

PUT /test1/type1/1

{

"name":"赵今麦",

"gae": 20

}

创建一个索引,同时指定字段类型

PUT /test2

{

"mappings": {

"properties": {

"name":{

"type": "text"

},

"age":{

"type": "long"

},

"birthday":{

"type": "date"

}

}

}

}

创建索引,指定默认类型

_doc默认类型(default type),type 在未来的版本中会逐渐弃用,因此产生一个默认类型进行代替

PUT /test2/_doc/1

{

"name":"maimai",

"age":"20",

"birth":"2002-09-29"

}

获取索引

GET test2

删除索引

DELETE test1

4.3 文档操作

修改

- PUT

# 首次PUT是创建

PUT /mmw/_doc/1

{

"name":"mmw",

"age":23,

"desc":"程序员",

"tags":[

"技术宅","温暖","直男"

]

}

# 再次对相同ID数据PUT则是修改

# 但是如果PUT时某个字段没写,则会将其更新为空值

PUT /mmw/_doc/1

{

"name":"mmw1",

"age":24,

}

- POST _update 进行更新

POST /mmw/_doc/1/_update

{

"doc":{

"age":31

}

}

删除

DELETE /mmw

查询

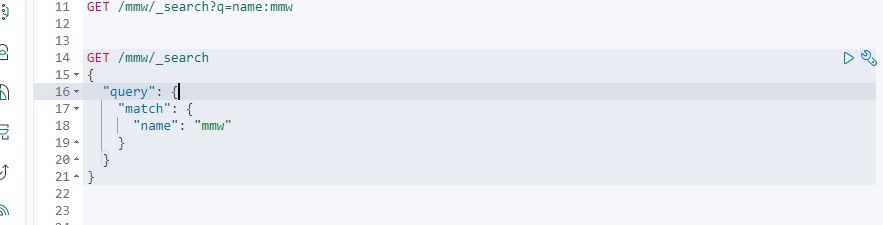

简单查询

GET /mmw/_doc/1

简单查询(带条件)

GET /mmw/_search?q=name:mmw

复杂操作搜索(重点): 排序 分页 高亮 模糊查询 精确查询

构建查询请求体 多个查询条件使用空格隔开

结果过滤,只显示指定字段 _source

GET /mmw/_search

{

"query": {

"match": {

"name": "mmw"

}

},

"_source": ["name","desc"]

}

排序 sort

GET /mmw/_search

{

"query": {

"match": {

"desc": "程序员"

}

},

"_source": ["name","desc","age"],

"sort": [

{

"age": {

"order": "desc"

}

}

]

}

分页查询

size 页大小 from 从第几条数据开始, 数据下标还是从0开始

GET /mmw/_search

{

"query": {

"match": {

"desc": "程序员"

}

},

"sort": [

{

"age": {

"order": "desc"

}

}

],

"from":0,

"size":2

}

布尔值精确查询

must 相当于 and

should相当于 or

must not 相当于 not

# must

GET /mmw/_search

{

"query": {

"bool":{

"must": [

{

"match": {

"desc": "程序员"

}

},

{

"match": {

"age": "26"

}

}

]

}

}

}

# should

GET /mmw/_search

{

"query": {

"bool":{

"should": [

{

"match": {

"desc": "程序员"

}

},

{

"match": {

"age": "26"

}

}

]

}

}

}

过滤器

# age大于21

GET /mmw/_search

{

"query": {

"bool":{

"filter": [

{

"range": {

"age": {

"gte": 21

}

}

}

]

}

}

}

term 精确查询 : 通过倒排索引指定的词条进程精确查找的

高亮 highlight

该可以自定义前缀后缀标签

GET /mmw/_search

{

"query": {

"match": {

"desc": "程序员"

}

},

"highlight": {

"pre_tags": "<p class='key' style='color:red'>",

"fields": {

"desc":{}

}

}

}

term 精确查询 : 通过倒排索引指定的词条进程精确查找的

高亮 highlight

该可以自定义前缀后缀标签

GET /mmw/_search

{

"query": {

"match": {

"desc": "程序员"

}

},

"highlight": {

"pre_tags": "<p class='key' style='color:red'>",

"fields": {

"desc":{}

}

}

}

本文介绍了Elasticsearch的安装过程,包括安装ES、可视化插件Head和Kibana,并讲解了ES的核心概念,如索引、类型、文档和倒排索引。同时提到了IK分词器的使用以及通过RestAPI进行基本操作。

本文介绍了Elasticsearch的安装过程,包括安装ES、可视化插件Head和Kibana,并讲解了ES的核心概念,如索引、类型、文档和倒排索引。同时提到了IK分词器的使用以及通过RestAPI进行基本操作。

5399

5399

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?