<think>好的,我需要回答用户关于如何使用Python实现三维卷积运算的问题。首先,我得理解什么是三维卷积。通常,在深度学习中,三维卷积用于处理三维数据,比如视频或医学图像中的体积数据。二维卷积处理的是二维图像,而三维卷积则增加了一个深度维度,比如时间或切片。

接下来,用户要求示例代码,并且可能希望了解具体的实现步骤。不过,根据提供的引用,用户之前的问题是关于卷积运算的实现,引用的资料提到了使用NumPy、TensorFlow或PyTorch。特别是引用[2]提到使用NumPy实现卷积,引用[4]和[5]提到了使用深度学习框架。因此,我需要结合这些信息来给出答案。

首先,手动实现三维卷积可能比较复杂,但用NumPy的话,可以通过滑动窗口的方式处理。不过,对于深度学习应用,直接使用框架会更高效。比如TensorFlow的Conv3D层或者PyTorch的Conv3d模块。

用户需要的是Python实现,示例代码,可能偏向于深度学习框架的应用,因为手动实现三维卷积的代码会比较长且效率不高。不过,考虑到引用的资料中有提到NumPy的实现,或许用户希望看到两种方法:手动实现和使用库函数。

不过,手动实现3D卷积需要考虑输入数据、卷积核的维度,以及步长、填充等参数,这可能比较复杂。而使用深度学习框架的话,代码会更简洁,也更实用。因此,我应该重点介绍使用TensorFlow或PyTorch的方法,并给出示例代码。

比如,使用TensorFlow的话,可以构建一个带有Conv3D层的模型,然后应用它。同样,PyTorch的Conv3d模块也可以实现。同时,可能需要生成示例数据,比如模拟一个3D输入和一个3D卷积核,然后进行运算。

另外,需要确保代码正确,符合语法,并且注释清晰。用户可能需要了解输入输出的形状,比如输入数据的维度通常是(batch_size, depth, height, width, channels),而卷积核的维度是(kernel_depth, kernel_height, kernel_width, in_channels, out_channels)在TensorFlow中。

同时,引用[5]提到了TensorFlow的代码示例,可能可以借鉴其中的结构。比如,定义一个Conv3D层,然后进行前向传播。

因此,总结回答的结构应该是:

1. 解释三维卷积的应用场景。

2. 使用NumPy手动实现的示例(可能较简单,但效率低)。

3. 使用深度学习框架(如TensorFlow或PyTorch)的实现,并提供示例代码。

4. 注意事项,如输入形状、参数设置等。

另外,需要检查引用是否正确。用户提供的引用中,引用[1]、[2]、[3]主要关于二维卷积,引用[4]、[5]关于CNN和TensorFlow实现。所以,在提到使用框架时,可以引用[4]和[5]。

不过,用户的问题是关于三维卷积,而提供的引用中没有直接提到3D卷积的具体实现,但可以合理推断使用框架中的3D卷积层,比如TensorFlow的tf.keras.layers.Conv3D,如引用[5]中的示例是2D的,但结构类似。

因此,在示例代码中,可以展示如何用TensorFlow的Conv3D层来实现,并解释参数。同时,可能也需要提到使用PyTorch的方法,但考虑到引用中没有PyTorch的具体引用,可能主要使用TensorFlow的示例。

另外,手动实现的话,可能需要三维的滑动窗口,用NumPy进行循环遍历,但这可能在计算上不够高效,但对于理解原理有帮助。因此,可能简要给出一个简单的示例,但强调实际应用中应使用框架的优化实现。

最后,生成相关问题,如三维卷积的应用场景,与二维的区别,如何选择参数等。</think>### 使用Python实现三维卷积运算

三维卷积运算常用于处理具有空间-时间维度或立体结构的数据,例如视频分析(时间+空间)、医学影像(如MRI体积数据)等。实现方式可分为 **手动实现(基于NumPy)** 和 **深度学习框架实现(TensorFlow/PyTorch)**。

---

#### 一、基于NumPy的手动实现(原理演示)

```python

import numpy as np

def conv3d_numpy(input_3d, kernel_3d, stride=1):

# 输入形状: (depth, height, width, channels)

# 卷积核形状: (k_depth, k_height, k_width, in_channels)

d_in, h_in, w_in, c_in = input_3d.shape

k_d, k_h, k_w, c_k = kernel_3d.shape

assert c_in == c_k, "输入与卷积核通道数需一致"

# 计算输出尺寸

d_out = (d_in - k_d) // stride + 1

h_out = (h_in - k_h) // stride + 1

w_out = (w_in - k_w) // stride + 1

output = np.zeros((d_out, h_out, w_out))

# 滑动窗口计算卷积

for d in range(d_out):

for h in range(h_out):

for w in range(w_out):

window = input_3d[d*stride:d*stride+k_d,

h*stride:h*stride+k_h,

w*stride:w*stride+k_w, :]

output[d, h, w] = np.sum(window * kernel_3d)

return output

# 示例输入(单通道)

input_data = np.random.randn(10, 10, 10, 1) # (depth, height, width, channels)

kernel = np.random.randn(3, 3, 3, 1) # 3x3x3卷积核

result = conv3d_numpy(input_data, kernel, stride=1)

print(result.shape) # 输出形状: (8, 8, 8)

```

**说明**:此方法通过三重循环实现滑动窗口,适合理解原理,但效率较低,实际应用中建议使用优化库[^2][^3]。

---

#### 二、基于TensorFlow的高效实现(推荐)

```python

import tensorflow as tf

# 定义输入和卷积层

input_3d = tf.keras.Input(shape=(10, 10, 10, 1)) # (depth, height, width, channels)

conv3d_layer = tf.keras.layers.Conv3D(

filters=1, # 输出通道数

kernel_size=(3, 3, 3), # 3x3x3卷积核

strides=1,

padding='valid', # 无填充

activation='linear'

)

output = conv3d_layer(input_3d)

# 构建模型并预测

model = tf.keras.Model(inputs=input_3d, outputs=output)

test_input = np.random.randn(1, 10, 10, 10, 1) # 添加batch维度

result = model.predict(test_input)

print(result.shape) # 输出形状: (1, 8, 8, 8, 1)

```

**说明**:`tf.keras.layers.Conv3D` 自动处理参数初始化和高效计算,支持GPU加速,适合深度学习场景[^4][^5]。

---

#### 三、关键参数与注意事项

1. **输入形状**:TensorFlow中需遵循 `(batch_size, depth, height, width, channels)` 格式。

2. **填充方式**:`padding='same'` 保持输出尺寸不变(需补零),`padding='valid'` 不补零。

3. **步长(stride)**:控制滑动窗口的步长,可为单个值或三元组(如 `(2, 2, 2)`)。

4. **多通道处理**:卷积核的最后一个维度需与输入通道数匹配。

---

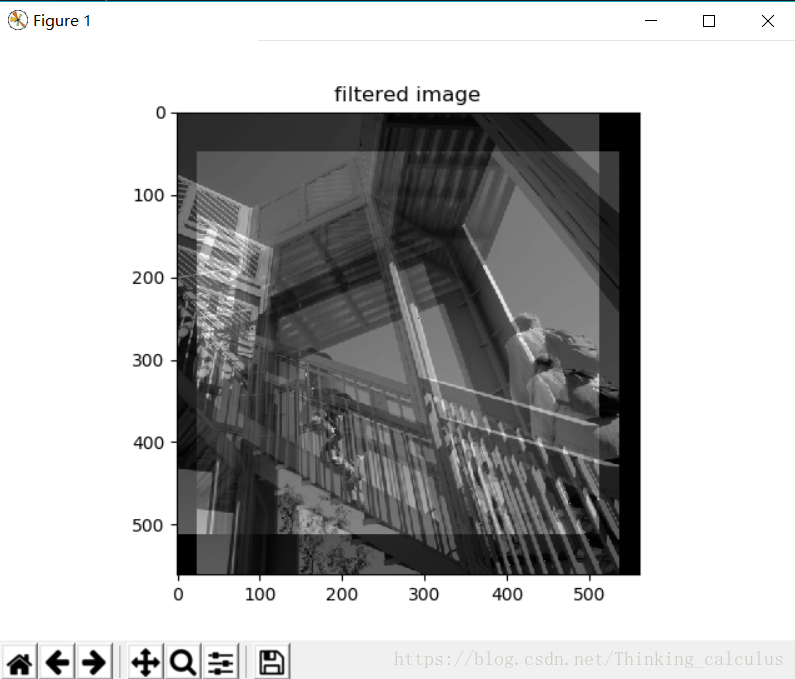

本文通过一个具体的Python代码示例,展示了如何使用卷积核处理图像,解释了卷积核在图像处理中的作用,尤其是如何通过特定的卷积核改变图像的特征,如创建图像的重影效果。

本文通过一个具体的Python代码示例,展示了如何使用卷积核处理图像,解释了卷积核在图像处理中的作用,尤其是如何通过特定的卷积核改变图像的特征,如创建图像的重影效果。

1209

1209

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?