👉️关注公众号Tensor实验室,,第一时间获取大厂算法校招、社招信息、最新论文工作(大模型、具身智能、CV、扩散模型、多模态、自动驾驶、医疗影像、AIGC、遥感等方向的论文解读)、最新AI发展趋势和学习资料等,赶快加入一起学习吧!

CVPR 2025 论文和开源项目合集请戳 CVPR2025-PapersWithCode

AI垂直方向交流群和论文投稿群已成立!

👨🔧👩🔧👨🔬👩🔬👨🚀👨🚒🕵️: 欢迎进群 | Welcome

目前已经开设的AI细分垂直方向交流群包括但不限于: 大模型、多模态、具身智能、CV、扩散模型、目标检测、图像分割、目标跟踪、医学影像、遥感、3DGS、Mamba、NeRF、Transformer、GAN、异常检测/缺陷检测、SLAM、人脸检测&识别、OCR、NAS、Re-ID、超分辨率、强化学习、3D重建、姿态估计、自动驾驶、活体检测、深度估计、去噪、显著性目标检测、车道线检测、模型剪枝&压缩、去雾、去雨、行为识别、视频理解、图像融合、图像检索等。

可以添加微信小助手微信:Tensor333或Tensor555,请备注:研究方向+地区+学校/公司名称+昵称!如:大模型+北京+北航+小北;一定要根据格式申请,可以拉你进对应的交流群。

如果目前方向未定的的同学,可以先加入大群(大群和垂直方向群可以同时加入)。可以添加微信小助手微信:Tensor333或Tensor555,请备注:方向未定+地区+学校/公司名称+昵称!如:方向未定+北京+北航+小北;

如果想进顶刊顶会论文投稿和交流群的同学。可以添加微信小助手微信:Tensor333或Tensor555,请备注:顶刊顶会名称+地区+学校/公司名称+昵称!如:CVPR+北京+北航+小北;

Authors: Jovana Videnovic, Alan Lukezic, Matej Kristan

Paper: https://arxiv.org/abs/2411.17576

Code:

Home: https://github.com/jovanavidenovic/DAM4SAM

目录

一、现存问题🌟

二、相关研究和难点📚

三、解决方法(创新点)🔥

四、实验结果分析📈

五、未来工作建议💡

六、总结🌳

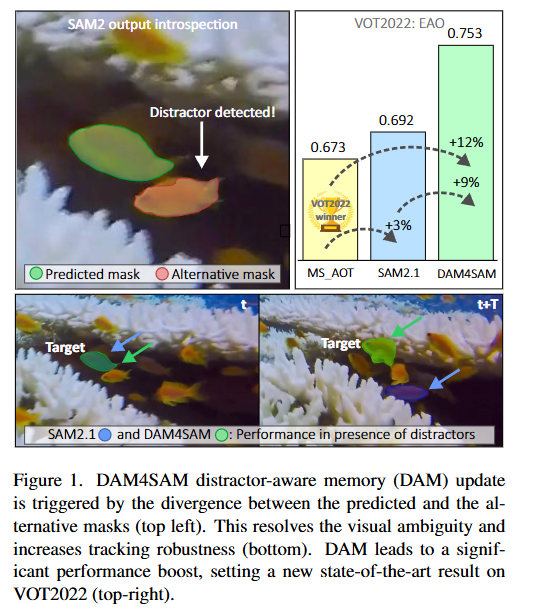

简介:基于内存的跟踪器是一种视频对象分割方法,它通过将最近跟踪的帧连接到内存缓冲区来形成目标模型,并通过关注当前图像与缓冲帧之间的关联来定位目标。尽管基于内存的跟踪器已在许多基准测试中取得了优异的性能,但最近发布的 SAM2 才使它成为视觉对象追踪社区关注的焦点。然而,现代跟踪器在干扰项存在的情况下仍然举步维艰。我们认为需要一个更复杂的内存模型,并提出了一种新的 SAM2 干扰项感知内存模型和一种基于自省的更新策略,以共同解决分割精度和追踪鲁棒性问题。最终的跟踪器被命名为 SAM2.1++。我们还提出了一个新的干扰项提取的 DiDi 数据集,以便更好地研究干扰项问题。SAM2.1++ 在七个基准测试中的表现优于 SAM2.1 及其相关的 SAM 内存扩展,并在其中六个基准测试中创下了新的最佳性能。

一、现存问题

这篇论文试图解决视觉目标跟踪(Visual Object Tracking)中由于干扰物(distractors)导致的跟踪失败问题。具体来说,论文指出,尽管基于记忆(memory-based)的跟踪器已经在多个基准测试中取得了优异的性能,但在面对干扰物时,现代跟踪器仍然会遇到困难。干扰物是指那些难以与跟踪目标区分的图像区域,包括与目标相似的外部干扰物(如附近的其他物体)以及内部干扰物(如目标自身某些部分的相似区域)。当目标离开并重新进入视野时,外部干扰物尤其具有挑战性。

为了解决这一问题,论文提出了一个新的干扰物感知记忆模型(Distractor-Aware Memory, DAM)以及一种基于内省(introspection-based)的更新策略,旨在同时提高分割精度和跟踪鲁棒性。

二、相关研究和难点

论文中提到了以下相关研究:

基于记忆的跟踪方法

- XMem [8]:提出了一种基于Atkinson-Shiffrin记忆模型的长期视频目标分割方法,使用多种记忆存储和高效的压缩方案来捕获不同的时间上下文,增强了在长期视频上的性能。

- RMEM [51]:提出限制记忆只包含最近的几帧,并使用时间戳来改进目标定位能力。这种方法被SAM2 [36]所采用。

- SAM2 [36]:将Segment Anything Model (SAM) [20]扩展到视频分割领域,通过将最近的几帧和初始帧存储在记忆中,使用交叉注意力机制将记忆帧的像素标签转移到当前图像上,从而实现目标的定位和分割。

- SAM2Long [14]:提出了一种无需训练的方法,通过确定多个分割路径中的最优轨迹来提高SAM2在长期序列上的性能。

干扰物处理方法

- KeepTrack [32]:将问题视为多目标跟踪设置,识别目标候选和潜在干扰物,并使用学习到的关联网络将它们与之前传播的身份相关联。但该方法依赖于准确的检测,且在实践中无法处理内部干扰物。

- Cutie [9]:通过将目标定位精度和鲁棒性视为两个不同的任务来处理干扰物,这在存在干扰物的情况下被证明是有益的。

- ODTrack [50]:提出了一种在线密集时间标记学习方法,用于视觉跟踪中的干扰物处理。

其他相关工作

- TransT [5]:提出了一种基于Transformer的跟踪方法,使用Transformer架构来处理视频目标跟踪任务。

- SeqTrack [6]:提出了一种序列到序列学习方法,用于视觉目标跟踪。

- AQATrack [40]:提出了一种自适应跟踪方法,使用时空Transformer来处理视觉目标跟踪任务。

- AOT [47]:提出了一种基于Transformer的视频目标分割方法,通过关联对象来实现视频目标分割。

这些研究为本文提出的干扰物感知记忆模型(DAM)和更新策略提供了理论基础和方法参考。

三、解决方法(创新点)

论文通过以下方式解决了视觉目标跟踪中的干扰物问题:

提出干扰物感知记忆模型(Distractor-Aware Memory, DAM)

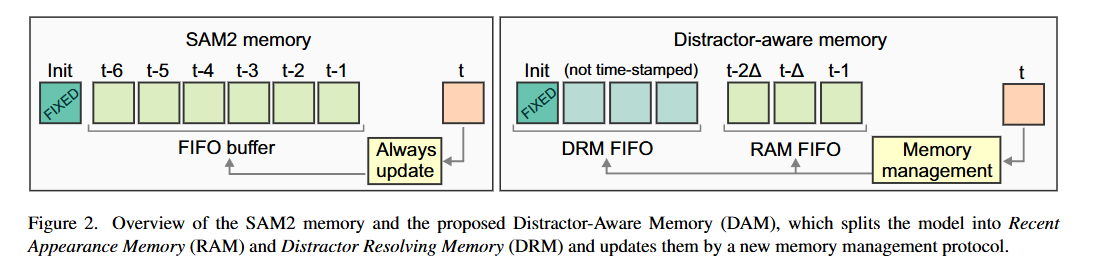

- 记忆模型的划分:将记忆模型划分为两部分:

- 近期外观记忆(Recent Appearance Memory, RAM):负责确保当前帧的分割精度,类似于SAM2 [36]中的记忆,是一个先进先出(FIFO)缓冲区,包含最近的目标外观,并使用时间编码来识别时间上更相关的帧。

- 干扰物解析记忆(Distractor Resolving Memory, DRM):负责确保跟踪的鲁棒性和目标的重新检测,包含准确分割的关键帧,这些关键帧有助于区分目标和重要的干扰物,包括初始帧。

- 记忆更新机制:

- RAM更新协议:RAM每5帧更新一次,并且只在目标存在时更新。如果预测的目标掩码为空,则不更新RAM,以避免因连续帧的高度相关性导致的视觉冗余,从而减少目标外观多样性的降低,提高目标重新出现时的分割精度。

- DRM更新协议:DRM继承了RAM的初始更新规则,并增加了一个规则来识别包含关键干扰物的锚定帧。通过检测SAM2输出掩码和替代掩码之间的假设发散来识别潜在的锚定帧。只有在跟踪稳定且可靠的情况下(即SAM2预测的IoU分数超过阈值,且掩码面积在一定范围内)才会触发DRM更新,以避免因错误分割的目标导致记忆损坏和最终的跟踪失败。

提出干扰物蒸馏数据集(DiDi)

- 数据集构建目的:现有的基准测试中包含许多不再被视为具有挑战性的序列,这些序列上的高表现会掩盖总分,使基准测试饱和,无法正确反映跟踪进展。为了更好地评估在干扰物存在时的跟踪性能,作者半自动地从多个基准测试中蒸馏出一个干扰物蒸馏跟踪数据集(DiDi)。

- 数据集构建方法:从GoT-10k [19]、LaSOT [15]、UTB180 [1]、VOT-ST2020和VOT-LT2020 [22]、VOT-ST2022和VOT-LT2022 [23]等主要跟踪基准的验证和测试序列中选择序列。如果至少有三分之一的帧满足干扰物存在标准,则将该序列选入DiDi数据集。通过DINO2 [34]对图像进行编码,并计算每个像素在特征空间中的干扰物分数,即该像素与目标区域内特征的平均余弦距离。然后计算目标区域内外像素分数超过目标区域内平均分数的像素数量之比,如果该比值超过0.5,则认为该帧包含非微不足道的干扰物。

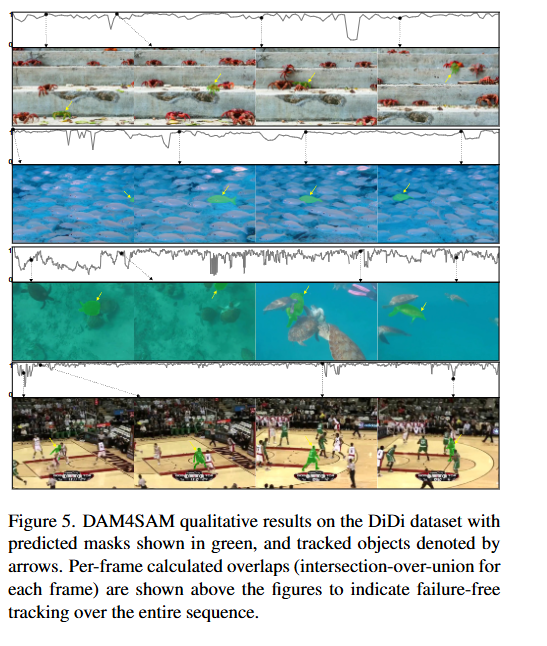

- 数据集特点:最终得到的DiDi数据集包含180个序列,平均序列长度为1.5k帧,总共274,882帧。每个序列包含一个由轴对齐边界框标注的单一目标,并且手动分割了初始帧以便初始化基于分割的跟踪器。

实验验证

- 架构设计决策验证:在DiDi数据集上进行一系列实验,验证了DAM的设计选择和管理协议的有效性。实验结果表明,仅在目标存在时更新记忆、降低更新频率以及在检测到干扰物且跟踪可靠时更新DRM等策略,都能显著提高跟踪质量,特别是在跟踪鲁棒性方面。

- 与现有方法比较:在DiDi数据集、VOT2020 [22]、VOT2022 [23]和VOTS2024 [25]等基准测试上,将DAM4SAM与现有的先进跟踪器进行比较。结果表明,DAM4SAM在处理干扰物方面优于现有的先进跟踪器,包括具有显式干扰物处理机制的跟踪器,如KeepTrack [32]、Cutie [9]和ODTrack [50],以及基于SAM2.1 [36]的其他改进方法,如SAMURAI [45]和SAM2.1Long [14]。DAM4SAM在多个基准测试上取得了新的最高水平,证明了其在视觉目标跟踪中的优越性能。

四、实验结果分析

论文中进行了以下实验:

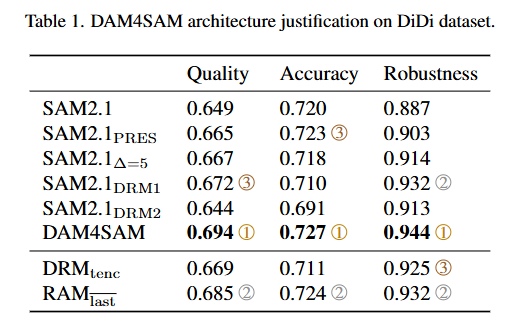

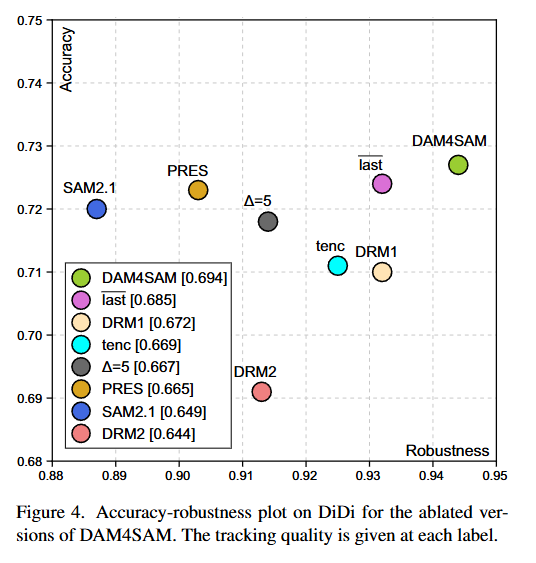

架构设计决策验证

- 实验目的:验证提出的干扰物感知记忆(DAM)和管理协议的设计选择。

- 实验方法:在干扰物蒸馏数据集(DiDi)上,计算视觉目标跟踪(VOTS)[24]指标,包括跟踪质量(Q)分数、鲁棒性(成功跟踪帧的比例)和准确性(成功跟踪期间预测掩码与真实掩码之间的平均IoU)。

- 实验结果:

- SAM2.1PRES:仅在预测掩码非空时更新SAM2.1,跟踪质量Q提高了2.5%,主要得益于鲁棒性的提升,验证了在目标不存在时不更新记忆可以避免记忆退化的观点。

- SAM2.1∆=5:将SAM2.1PRES的更新频率降低到每5帧一次,跟踪质量Q略有提高,鲁棒性增加了1.2%,支持了频繁更新会因记忆中存储的高度相关性信息而降低跟踪鲁棒性的观点。

- SAM2.1DRM1:在SAM2.1∆=5的基础上,仅在跟踪稳定可靠时更新DAM中的DRM部分,跟踪准确性略有提高,鲁棒性增加了2%,表明在可靠跟踪期间更新DRM有助于提高跟踪鲁棒性。

- SAM2.1DRM2:仅在检测到干扰物时更新DRM,鲁棒性与SAM2.1∆=5相当,但准确性下降,说明仅基于干扰物检测更新DRM可能会放大目标分割错误。

- DAM4SAM:同时应用上述两种DRM更新规则,与SAM2.1∆=5相比,跟踪质量Q大幅提高了4%,主要得益于鲁棒性提升了3.3%和准确性提升了1.3%,在准确性和鲁棒性的权衡图(AR图)中位于所有变体的右上角,验证了DRM更新规则的有效性。

- DRMtenc:在DAM4SAM中为DRM部分添加时间编码,跟踪质量下降了3.6%,证实了DRM不应使用时间编码的观点,即DRM中的帧对当前帧干扰物解析的影响不应受时间接近度的影响,而应作为时间无关的先验。

- RAMlast:修改DAM4SAM,使RAM的所有槽位每5帧更新一次,跟踪质量略有下降(1.3%),表明在RAM中包含最近帧确实有益,但并非至关重要。

与现有方法比较

- 实验目的:评估DAM4SAM在处理干扰物方面的性能,并与现有的先进跟踪器进行比较。

- 实验方法:

- DiDi数据集:与TransT [5]、SeqTrack [6]、AQATrack [40]、AOT [47]、KeepTrack [32]、Cutie [9]、ODTrack [50]以及未发表的SAMURAI [45]和SAM2.1Long [14]等跟踪器进行比较。

- VOT2020 [22]基准测试:与ODTrack [50]、MixViT-L+AR [11]、SeqTrack-L [6]、MixFormer-L [10]、RPT [31]等跟踪器进行比较。

- VOT2022 [23]基准测试:与MS AOT [47]、DiffusionTrack [30]、DAMTMask [23]、MixFormerM [10]、OSTrackSTS [48]等跟踪器进行比较。

- VOTS2024 [25]基准测试:与S3-Track [26]、DMAOT SAM [46]、HQ-DMAOT [46]、DMAOT [46]、LY-SAM [25]、Cutie-SAM [9]、AOT [47]、LORAT [27]等跟踪器进行比较。

- LaSoT [15]、LaSoText [16]和GoT10k [19]标准边界框跟踪数据集:与MixViT [11]、LORAT [27]、ODTrack [50]、DiffusionTrack [30]、DropTrack [38]、SeqTrack [6]、MixFormer [10]、GRM-256 [17]、ROMTrack [4]、OSTrack [48]、KeepTrack [32]、TOMP [33]等跟踪器进行比较。

- 实验结果:

- DiDi数据集:DAM4SAM在跟踪质量、准确性和鲁棒性方面均优于所有比较的跟踪器,包括具有显式干扰物处理机制的跟踪器,如ODTrack [50]和Cutie [9],以及基于SAM2.1 [36]的其他改进方法,如SAMURAI [45]和SAM2.1Long [14]。

- VOT2020基准测试:DAM4SAM在期望平均重叠(EAO)指标上优于所有比较的跟踪器,包括挑战冠军RPT [31]和最近发表的MixViT [11],与SAM2.1 [36]相比,EAO提高了7%,准确性提高了2.7%,鲁棒性提高了2.1%。

- VOT2022基准测试:DAM4SAM在EAO指标上优于挑战冠军MS AOT [47] 12%,这一性能提升是由于与MS AOT相比,准确性提高了2%,鲁棒性提高了3%。此外,DAM4SAM还优于SAM2.1 [36] 9%的EAO。

- VOTS2024基准测试:尽管挑战冠军S3-Track [26]是一个复杂的方法,结合了视觉和(单)深度特征,并使用了多个大型骨干网络,但DAM4SAM仍然取得了第二名的优异成绩,优于挑战调整版本的最近发表的跟踪器,如LORAT [27]、Cutie [9]和VOT2022冠军AOT [47]。与SAM2.1 [36]相比,DAM4SAM的跟踪质量提高了8%,主要是由于鲁棒性提高了9%。

- LaSoT、LaSoText和GoT10k数据集:DAM4SAM在LaSoT数据集上优于SAM2.1 [36] 7.3%,在LaSoText数据集上优于SAM2.1 [36] 7%,在GoT10k数据集上优于SAM2.1 [36] 3.7%。在LaSoT数据集上,DAM4SAM与经过LaSoT训练集调整的顶级跟踪器LORAT [27]相当,尽管LORAT [27]的训练参数大约比DAM4SAM多50%,使其模型复杂度显著更高。在LaSoText数据集上,DAM4SAM优于LORAT [27] 7.6%,表明DAM4SAM在不同目标类别上的泛化能力优于现有跟踪器,而现有跟踪器在性能上出现了更大的下降。在GoT10k数据集上,尽管顶级跟踪器在测试集上已经取得了超过78%的平均重叠,为现代跟踪器留下了很小的改进空间,但DAM4SAM仍然实现了3.7%的显著提升。

五、未来工作建议

论文中提出的干扰物感知记忆模型(Distractor-Aware Memory, DAM)和更新策略在视觉目标跟踪领域取得了显著的性能提升,但仍有一些可以进一步探索的方向:

1. 记忆管理策略的优化

- 自适应更新频率:当前的更新频率是固定的(每5帧更新一次),可以探索自适应更新频率的策略,例如根据目标的运动速度、场景的复杂性或跟踪的不确定性动态调整更新频率。

- 记忆容量的动态调整:记忆容量(RAM和DRM的大小)是固定的,可以研究根据跟踪任务的复杂性动态调整记忆容量的方法,以更好地平衡计算效率和跟踪性能。

2. 干扰物检测的改进

- 深度学习方法:当前的干扰物检测是基于SAM2的输出掩码和替代掩码之间的假设发散。可以探索使用深度学习方法来更准确地检测干扰物,例如训练一个专门的神经网络来识别和分类干扰物。

- 多模态信息融合:结合其他模态的信息(如深度信息、光流信息)来更准确地检测干扰物,特别是在复杂的场景中。

3. 记忆内容的优化

- 特征选择:当前的记忆内容是整个图像及其分割掩码,可以研究更有效的特征选择方法,以减少记忆的冗余,提高跟踪效率。

- 记忆压缩:探索更高效的记忆压缩方法,以减少存储和计算成本,同时保持或提高跟踪性能。

4. 长期跟踪能力的增强

- 长期记忆管理:虽然DAM4SAM在短期和中期跟踪中表现出色,但在长期跟踪中可能需要更复杂的记忆管理策略。可以研究如何更好地管理长期记忆,以应对目标长时间离开视野的情况。

- 目标重识别:在目标离开视野后重新进入时,如何更准确地重新识别目标是一个挑战。可以探索结合目标的外观特征和运动特征来进行更准确的目标重识别。

5. 多目标跟踪

- 扩展到多目标跟踪:当前的DAM4SAM主要针对单目标跟踪。可以研究如何将DAM4SAM扩展到多目标跟踪场景,特别是在存在多个相似目标的情况下。

- 目标间关联:在多目标跟踪中,目标之间的关联是一个关键问题。可以研究如何利用DAM4SAM的记忆模型来更好地处理目标间的关联和交互。

6. 实时性优化

- 计算效率提升:虽然DAM4SAM在性能上取得了显著提升,但速度上有所下降(从13.3 fps降低到11 fps)。可以探索优化算法和实现,以提高实时性,使其更适合实际应用。

- 硬件加速:研究如何利用专用硬件(如GPU、FPGA)来加速DAM4SAM的计算,以满足实时性要求。

7. 数据集和评估指标的改进

- 更复杂的数据集:虽然DiDi数据集已经很好地反映了干扰物问题,但可以进一步扩展和丰富数据集,包括更多类型的干扰物和更复杂的场景。

- 新的评估指标:开发新的评估指标,以更全面地评估跟踪器在不同场景下的性能,特别是对干扰物处理能力的评估。

8. 跨模态跟踪

- 跨模态记忆模型:研究如何将DAM4SAM扩展到跨模态跟踪任务,例如从RGB图像跟踪到红外图像或深度图像,以应对不同模态下的干扰物问题。

这些方向不仅有助于进一步提升DAM4SAM的性能,还可能为视觉目标跟踪领域带来新的突破和进展。

六、总结

本文的核心贡献是提出了一种新的干扰物感知记忆模型(Distractor-Aware Memory, DAM)和更新策略,用于提高基于记忆的视觉目标跟踪器在面对干扰物时的鲁棒性和准确性。该模型被集成到SAM2框架中,形成了DAM4SAM跟踪器,并在多个基准测试中取得了优异的性能。此外,作者还提出了一个新的干扰物蒸馏数据集(DiDi),用于更好地评估和研究干扰物问题。

背景知识

视觉目标跟踪是一个经典的计算机视觉问题,其目标是在视频中定位任意目标。跟踪失败的主要原因之一是所谓的干扰物,即难以与跟踪目标区分的图像区域。这些干扰物可以是与目标相似的外部物体,也可以是目标自身某些部分的相似区域。现有的基于记忆的跟踪器通过将最近跟踪的帧存储在记忆缓冲区中来构建目标模型,并通过将当前图像与缓冲帧对齐来定位目标。尽管这些方法在许多基准测试中取得了优异的性能,但在面对干扰物时仍然存在挑战。

研究方法

干扰物感知记忆模型(DAM)

DAM模型将记忆分为两部分:

- 近期外观记忆(RAM):包含最近的目标外观,用于确保当前帧的分割精度。RAM是一个先进先出(FIFO)缓冲区,包含最近的目标外观,并使用时间编码来识别时间上更相关的帧。

- 干扰物解析记忆(DRM):包含关键帧,用于区分目标和重要的干扰物。DRM不使用时间编码,以确保其对当前帧干扰物解析的影响不受时间接近度的影响。

记忆更新策略

- RAM更新:每5帧更新一次,仅在目标存在时更新。如果预测的目标掩码为空,则不更新RAM,以避免因连续帧的高度相关性导致的视觉冗余。

- DRM更新:在检测到干扰物且跟踪稳定可靠时更新。通过检测SAM2输出掩码和替代掩码之间的假设发散来识别潜在的锚定帧。只有在SAM2预测的IoU分数超过阈值,且掩码面积在一定范围内时,才会触发DRM更新。

干扰物蒸馏数据集(DiDi)

为了更好地评估在干扰物存在时的跟踪性能,作者从多个基准测试中半自动地蒸馏出一个干扰物蒸馏跟踪数据集(DiDi)。该数据集包含180个序列,平均序列长度为1.5k帧,总共274,882帧。每个序列包含一个由轴对齐边界框标注的单一目标,并且手动分割了初始帧以便初始化基于分割的跟踪器。

实验

架构设计决策验证

在DiDi数据集上进行的实验表明,DAM4SAM在跟踪质量、准确性和鲁棒性方面均优于SAM2.1和其他变体。具体结果如下:

- SAM2.1PRES:仅在目标存在时更新,跟踪质量Q提高了2.5%。

- SAM2.1∆=5:每5帧更新一次,鲁棒性提高了1.2%。

- SAM2.1DRM1:在可靠跟踪期间更新DRM,鲁棒性提高了2%。

- SAM2.1DRM2:仅在检测到干扰物时更新DRM,准确性下降。

- DAM4SAM:结合上述两种DRM更新规则,跟踪质量Q提高了4%,鲁棒性提高了3.3%,准确性提高了1.3%。

与现有方法比较

DAM4SAM在多个基准测试中取得了优异的性能:

- DiDi数据集:DAM4SAM在跟踪质量、准确性和鲁棒性方面均优于所有比较的跟踪器。

- VOT2020基准测试:DAM4SAM在期望平均重叠(EAO)指标上优于所有比较的跟踪器,与SAM2.1相比,EAO提高了7%。

- VOT2022基准测试:DAM4SAM在EAO指标上优于挑战冠军MS AOT 12%,与SAM2.1相比,EAO提高了9%。

- VOTS2024基准测试:DAM4SAM取得了第二名的优异成绩,与SAM2.1相比,跟踪质量提高了8%。

- LaSoT、LaSoText和GoT10k数据集:DAM4SAM在这些数据集上均优于SAM2.1,分别提高了7.3%、7%和3.7%。

关键结论

DAM4SAM通过引入干扰物感知记忆模型和更新策略,在多个基准测试中取得了显著的性能提升,特别是在处理干扰物方面表现优异。此外,DAM4SAM在没有额外训练的情况下,使用固定的参数设置,就能在多个标准边界框和分割跟踪基准测试中取得新的最高水平。这表明DAM4SAM在视觉目标跟踪领域具有很强的竞争力,并为未来的研究提供了新的方向。

👉️关注公众号Tensor实验室,,第一时间获取大厂算法校招、社招信息、最新论文工作(大模型、具身智能、CV、扩散模型、多模态、自动驾驶、医疗影像、AIGC、遥感等方向的论文解读)、最新AI发展趋势和学习资料等,赶快加入一起学习吧!

338

338

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?