最近项目需要使用到mmap,因此对mmap内核中的实现进行学习,该博客基于Linux-3.10,相近版本可以做参考,如果版本跨度大需结合对应版本来进行学习。

一个用户态程序可以通过调用libc中的mmap(),将一个已打开文件的内容映射到它的用户空间。

mmap用户态函数原型:mmap(void *start, size_t length, int prot, int flags, int fd, off_t offset)。

参数fd代表着一个已打开文件,offset为文件中的起点,而start为映射到用户空间中的起始地址,length则为长度。还有两个参数prot和flags,前者用于对所映射区间的访问模式,如可写、可执行等,后者则用于其他控制目的。

这里对用户态的mmap就不进行过多的讲解了,直接通过系统调用来进行内核态mmap的具体实现的学习。

用户态mmap通过系统调用sys_mmap2陷入内核,使用Source Insight打开Linux-3.10的内核源码(https://blog.youkuaiyun.com/SweeNeil/article/details/83684938)

unsigned long sys_mmap2(unsigned long addr, size_t len,

unsigned long prot, unsigned long flags,

unsigned long fd, unsigned long pgoff)

{

return do_mmap2(addr, len, prot, flags, fd, pgoff, PAGE_SHIFT-12);

}在sys_mmap2中直接返回了do_mmap2,然后我们跳转到do_mmap2来进行查看相关内容:

static inline unsigned long do_mmap2(unsigned long addr, size_t len,

unsigned long prot, unsigned long flags,

unsigned long fd, unsigned long off, int shift)

{

unsigned long ret = -EINVAL;

if (!arch_validate_prot(prot))

goto out;

if (shift) {

if (off & ((1 << shift) - 1))

goto out;

off >>= shift;

}

ret = sys_mmap_pgoff(addr, len, prot, flags, fd, off);

out:

return ret;

}do_mmap2是一个内联函数,其中主要调用了sys_mmap_pgoff函数,然后继续跳转到sys_mmap_pgoff函数,在使用Source Insight进行跳转查看时,发现该函数同样为一个系统调用,但是未找到函数体,其函数声明如下:

asmlinkage long sys_mmap_pgoff(unsigned long addr, unsigned long len,

unsigned long prot, unsigned long flags,

unsigned long fd, unsigned long pgoff);猜测在sys_mmap_pgoff中同样是调用的一个do_mmap_pgoff的函数(如果大家找到了欢迎评论说明),根据查找到的mmap内核代码的其他博客,可知应该是调用了do_mmap_pgoff。查看do_mmap_pgoff函数,找到了两个do_mmap_pgoff函数。一是在./mm/mmap.c中定义的函数do_mmap_pgoff,一个是在/mm/nommu.c中定义的do_mmap_pgoff函数。

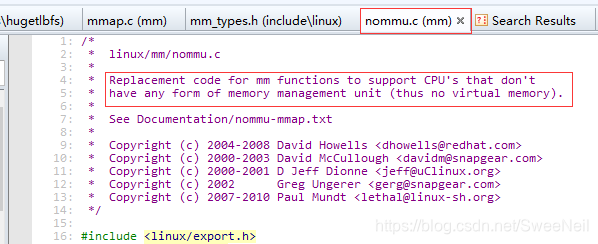

到底哪一个为在执行mmap时被调用的函数呢,我们先打开这两个文件进行分析,看一下这两个文件是否有相应的描述信息,首先打开/mm/mmap.c,发现文件并没有什么描述信息,只有一个作者的信息,然后再打开/mm/nommu.c文件,发现了如下内容:

通过上面的描述信息可知,nommu.c中的代码就是mm函数的替换代码,用于支持没有任何形式的内存管理单元的CPU,其实这一点我们也可以从文件名nommu.c猜测这里面的代码应该是在没有MMU时会被运行的。

因此我们可以先对/mm/mmap.c中的do_mmap_pgoff进行分析:

1、/mm/mmap.c——>do_mmap_pgoff函数

在mm/mmap.c中查找到了函数do_mmap_pgoff的函数代码如下:

unsigned long do_mmap_pgoff(struct file *file, unsigned long addr,

unsigned long len, unsigned lo Linux内核mmap实现解析

Linux内核mmap实现解析

本文基于Linux-3.10内核,探讨mmap的内核实现。从用户态mmap调用到内核态sys_mmap2,接着分析do_mmap2和sys_mmap_pgoff,重点解析do_mmap_pgoff函数,涉及get_unmapped_area及其后续的vm_unmapped_area函数,揭示内存映射的详细过程。

本文基于Linux-3.10内核,探讨mmap的内核实现。从用户态mmap调用到内核态sys_mmap2,接着分析do_mmap2和sys_mmap_pgoff,重点解析do_mmap_pgoff函数,涉及get_unmapped_area及其后续的vm_unmapped_area函数,揭示内存映射的详细过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1086

1086

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?