要了解内核socket需要先对内核socket的结构进行了解。

其中比较重要的就是struct socket和struct sock两个结构体。

每个socket数据结构都有一个sock数据结构成员,sock是对socket的扩充,两者一一对应,socket->sk指向对应的sock,sock->socket 指向对应的socket;

socket和sock是同一事物的两个侧面,为什么不把两个数据结构合并成一个呢?这是因为socket是inode结构中的一部分,即把inode结构内部的一个union用作socket结构。由于插口操作的特殊性,这个数据结构中需要有大量的结构成分,如果把这些成分全部放到socket结构中,则inode结构中的这个union就会变得很大,从而inode结构也会变得很大,而对于其他文件系统这个union是不需要这么大的,所以会造成巨大浪费,系统中使用inode结构的数量要远远超过使用socket的数量,故解决的办法就是把插口分成两部分,把与文件系统关系密切的放在socket结构中,把与通信关系密切的放在另一个单独结构sock中;

1、struct socket

struct socket定义在include/linux/net.h中,socket结构体的内容如下:

struct socket {

socket_state state;

kmemcheck_bitfield_begin(type);

short type;

kmemcheck_bitfield_end(type);

unsigned long flags;

struct socket_wq __rcu *wq;

struct file *file;

struct sock *sk;

const struct proto_ops *ops;

};

其中,state是socket的状态,比如CONNECTED;type是类型,比如TCP下使用的流式套接字SOCK_STREAM;flags是标志位,负责一些特殊的设置,比如SOCK_ASYNC_NOSPACE;ops则是采用了和超级块设备操作表一样的逻辑,专门设置了一个数据结构来记录其允许的操作。sk是非常重要的,也是非常大的,负责记录协议相关内容。这样的设置使得socket具有很好的协议无关性,可以通用。file是与socket相关的指针列表,wq是等待队列。

还有两个结构体sk_buff和tcp_sock,其中sk_buff与每一个数据包相关,负责描述每一个数据包的信息,而tcp_sock则是tcp相关的结构体。

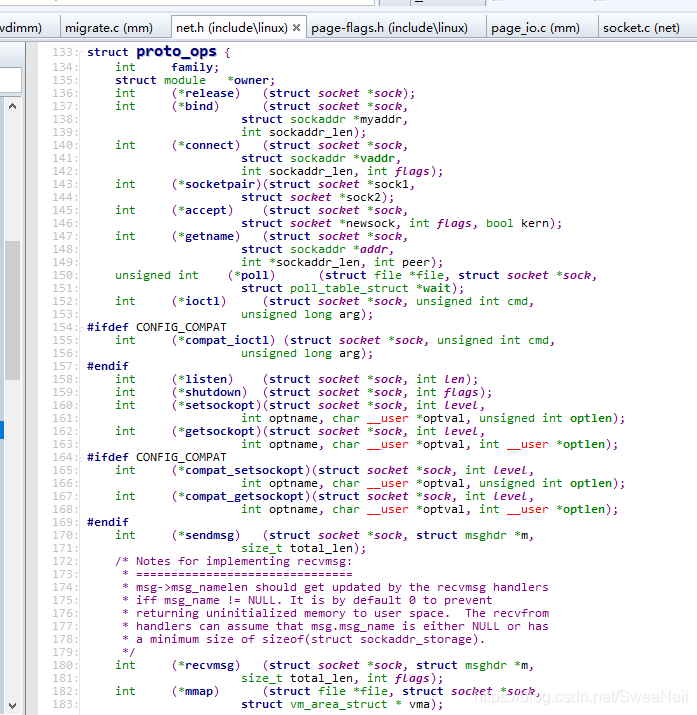

在struct socket结构体中,也定义了一些socket的操作函数:const struct proto_ops *ops;

struct proto_ops同样定义在include/linux/net.h中,其主要内容如下:

2、struct sock

struct sock定义在include/net/sock.h中,sock结构的内容如下所示:

struct sock {

/*

* Now struct inet_timewait_sock also uses sock_common, so please just

* don't add nothing before this first member (__sk_common) --acme

*/

struct sock_common __sk_common;

#define sk_node __sk_common.skc_node

#define sk_nulls_node __sk_common.skc_nulls_node

#define sk_refcnt __sk_common.skc_refcnt

#define sk_tx_queue_mapping __sk_common.skc_tx_queue_mapping

#define sk_dontcopy_begin __sk_common.skc_dontcopy_begin

#define sk_dontcopy_end __sk_common.skc_dontcopy_end

#define sk_hash __sk_common.skc_hash

#define sk_portpair __sk_common.skc_portpair

#define sk_num __sk_common.skc_num

#define sk_dport __sk_common.skc_dport

#define sk_addrpair __sk_common.skc_addrpair

#define sk_daddr __sk_common.skc_daddr

#define sk_rcv_saddr __sk_common.skc_rcv_saddr

#define sk_family __sk_common.skc_family

#define sk_state __sk_common.skc_state

#define sk_reuse __sk_common.skc_reuse

#define sk_reuseport __sk_common.skc_reuseport

#define sk_ipv6only __sk_common.skc_ipv6only

#define sk_net_refcnt __sk_common.skc_net_refcnt

#define sk_bound_dev_if __sk_common.skc_bound_dev_if

#define sk_bind_node __sk_common.skc_bind_node

#define sk_prot __sk_common.skc_prot

#define sk_net __sk_common.skc_net

#define sk_v6_daddr __sk_common.skc_v6_daddr

#define sk_v6_rcv_saddr __sk_common.skc_v6_rcv_saddr

#define sk_cookie __sk_common.skc_cookie

#define sk_incoming_cpu __sk_common.skc_incoming_cpu

#define sk_flags __sk_common.skc_flags

#define sk_rxhash __sk_common.skc_rxhash

socket_lock_t sk_lock;

struct sk_buff_head sk_receive_queue;

/*

* The backlog queue is special, it is always used with

* the per-socket spinlock held and requires low latency

* access. Therefore we special case it's implementation.

* Note : rmem_alloc is in this structure to fill a hole

* on 64bit arches, not because its logically part of

* backlog.

*/

struct {

atomic_t rmem_alloc;

int len;

struct sk_buff *head;

struct sk_buff *tail;

} sk_backlog;

#define sk_rmem_alloc sk_backlog.rmem_alloc

int sk_forward_alloc;

__u32 sk_txhash;

#ifdef CONFIG_NET_RX_BUSY_POLL

unsigned int sk_napi_id;

unsigned int sk_ll_usec;

#endif

atomic_t sk_drops;

int sk_rcvbuf;

struct sk_filter __rcu *sk_filter;

union {

struct socket_wq __rcu *sk_wq;

struct socket_wq *sk_wq_raw;

};

#ifdef CONFIG_XFRM

struct xfrm_policy __rcu *sk_policy[2];

#endif

struct dst_entry *sk_rx_dst;

struct dst_entry __rcu *sk_dst_cache;

/* Note: 32bit hole on 64bit arches */

atomic_t sk_wmem_alloc;

atomic_t sk_omem_alloc;

int sk_sndbuf;

struct sk_buff_head sk_write_queue;

kmemcheck_bitfield_begin(flags);

unsigned int sk_shutdown : 2,

sk_no_check_tx : 1,

sk_no_check_rx : 1,

sk_userlocks : 4,

sk_protocol : 8,

sk_type : 16;

#define SK_PROTOCOL_MAX U8_MAX

kmemcheck_bitfield_end(flags);

int sk_wmem_queued;

gfp_t sk_allocation;

u32 sk_pacing_rate; /* bytes per second */

u32 sk_max_pacing_rate;

netdev_features_t sk_route_caps;

netdev_features_t sk_route_nocaps;

int sk_gso_type;

unsigned int sk_gso_max_size;

u16 sk_gso_max_segs;

int sk_rcvlowat;

unsigned long sk_lingertime;

struct sk_buff_head sk_error_queue;

struct proto *sk_prot_creator;

rwlock_t sk_callback_lock;

int sk_err,

sk_err_soft;

u32 sk_ack_backlog;

u32 sk_max_ack_backlog;

__u32 sk_priority;

#if IS_ENABLED(CONFIG_CGROUP_NET_PRIO)

__u32 sk_cgrp_prioidx;

#endif

struct pid *sk_peer_pid;

const struct cred *sk_peer_cred;

long sk_rcvtimeo;

long sk_sndtimeo;

struct timer_list sk_timer;

ktime_t sk_stamp;

u16 sk_tsflags;

u32 sk_tskey;

struct socket *sk_socket;

void *sk_user_data;

struct page_frag sk_frag;

struct sk_buff *sk_send_head;

__s32 sk_peek_off;

int sk_write_pending;

#ifdef CONFIG_SECURITY

void *sk_security;

#endif

__u32 sk_mark;

#ifdef CONFIG_CGROUP_NET_CLASSID

u32 sk_classid;

#endif

struct cg_proto *sk_cgrp;

void (*sk_state_change)(struct sock *sk);

void (*sk_data_ready)(struct sock *sk);

void (*sk_write_space)(struct sock *sk);

void (*sk_error_report)(struct sock *sk);

int (*sk_backlog_rcv)(struct sock *sk,

struct sk_buff *skb);

void (*sk_destruct)(struct sock *sk);

};

__sk_common是套接口在网络层的最小表示,struct sock_common同样定义在include/net/sock.h中;

sk_shutdown是一组标志位,SEND_SHUTDOWN and/or RCV_SHUTDOWN。

sk_userlocks, SO_SNDBUF and SO_RCVBUF。

sk_rcvbuf表示接收缓冲区的字节长度。

sk_rmem_alloc表示接收队列已提交的字节数。

sk_receive_queue表示接收的数据包的队列。

sk_wmem_alloc表示发送队列已提交的字节数。

sk_write_queue表示发送数据包的队列。

sk_sndbuf表示发送缓冲区的字节长度。

sk_flags,SO_LINGER (l_onoff),SO_BROADCAST,SO_KEEPALIVE,SO_OOBINLINE。

sk_prot是指定的域内部的协议处理函数集,它是套接口层跟传输层之间的一个接口,提供诸如bind, accept, close等操作。

sk_ack_backlog表示当前的侦听队列。

sk_max_ack_backlog表示最大的侦听队列。

sk_type表示套接字的类型,如SOCK_STREAM。

sk_protocol表示在当前域中套接字所属的协议。

几个函数指针均属回调函数,分别在套接口状态变化,有数据到达需要处理,有发送空间可用,有错误等时候被回调。最后一个函数sk_destruct在套接口释放时被回调。

本文探讨了Linux内核中的socket结构,包括struct socket和struct sock。struct socket包含了socket的状态、类型、标志位和操作函数,而struct sock则详细记录了协议相关的内容,如接收和发送缓冲区、队列等。这种分离设计避免了inode结构的浪费,并实现了协议无关性。

本文探讨了Linux内核中的socket结构,包括struct socket和struct sock。struct socket包含了socket的状态、类型、标志位和操作函数,而struct sock则详细记录了协议相关的内容,如接收和发送缓冲区、队列等。这种分离设计避免了inode结构的浪费,并实现了协议无关性。

600

600

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?