召回率指的是检索出的相关样本和样本库(待测对象库)中所有的相关样本的比率,衡量的是分类器的查全率。

精确率是检索出的相关样本数与检索出的样本总数的比率,衡量的是分类器的查准率。

分类的训练过程和回归的训练过程一样,都是极为套路化的程序。

第一,输入样本和分类标签。

第二,建立映射假说的某个y=f{x) 的模型。

第三,求解出全局的损失函数 Loss 和待定系数 w 的映射关系, Loss=g(w)。

第四,通过迭代优化逐步降低 Loss,最终找到一个 w 能使召回率和精确率满足当前场 景需要。 注意,这里尤其指在验证数据集上的表现。

f(x)=wx+b ,其中 x 是一个 l x n 的矩阵,而 w 是一个 n x l 的权重矩阵, b 是偏置项。

Loss 函数是用来描述拟合与真实观测的差异之和,我们称之为残差。

常见的激励函数

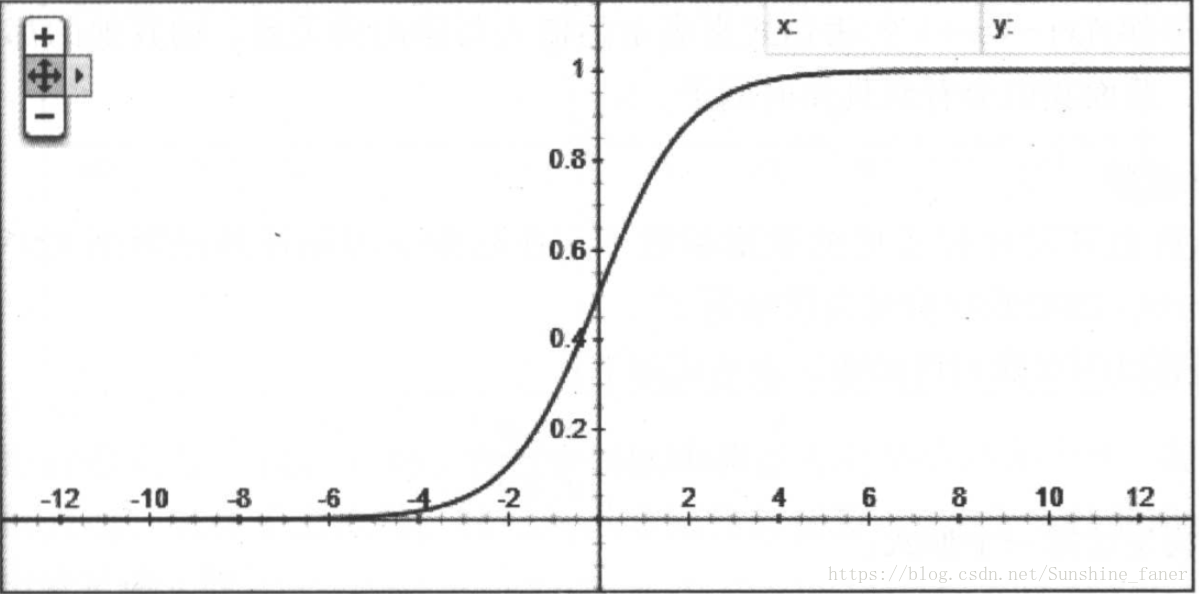

1. Sigmoid 函数

Sigmoid 函数基本上是我们所有学习神经网络的人第一个接触到的激励函数了。

f(x)=11+e−(wx+b)f(x)=11+e−(wx+b)

或者可以写成

z=wx+b,f(z)=11+e−zz=wx+b,f(z)=11+e−z

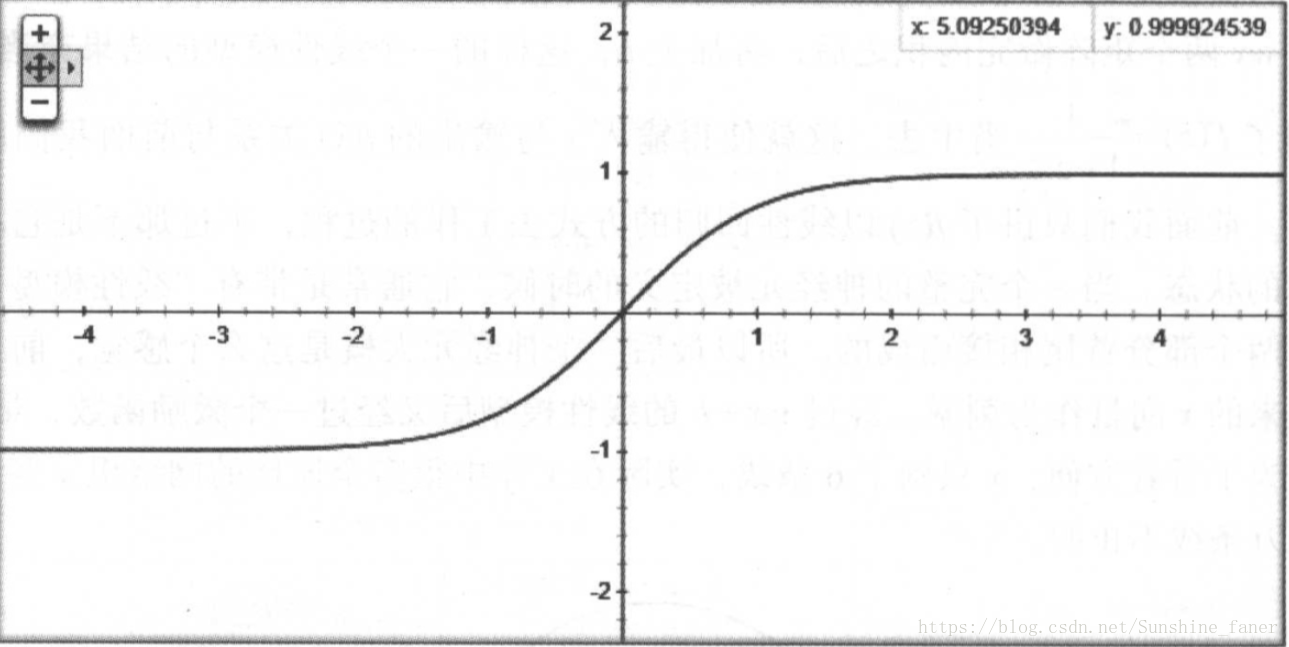

2.Tanh函数

Tanh 函数也叫双曲正切函数,在循环神经网络RNN(Recurrent neural networks)中比较多使用。表达式如下:

tanh(x)=ex−e−xex+e−xtanh(x)=ex−e−xex+e−x

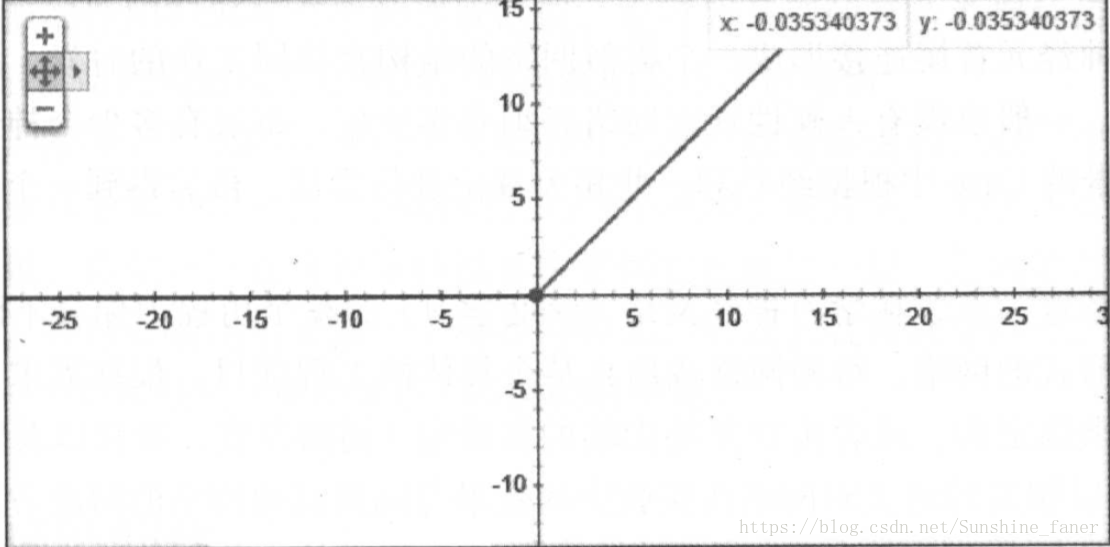

3.ReLU函数

ReLu函数是目前大部分卷积神经网络CNN(Convolutional neural networks)中常用的激励函数。函数的形式是

y=max(x,0)y=max(x,0)

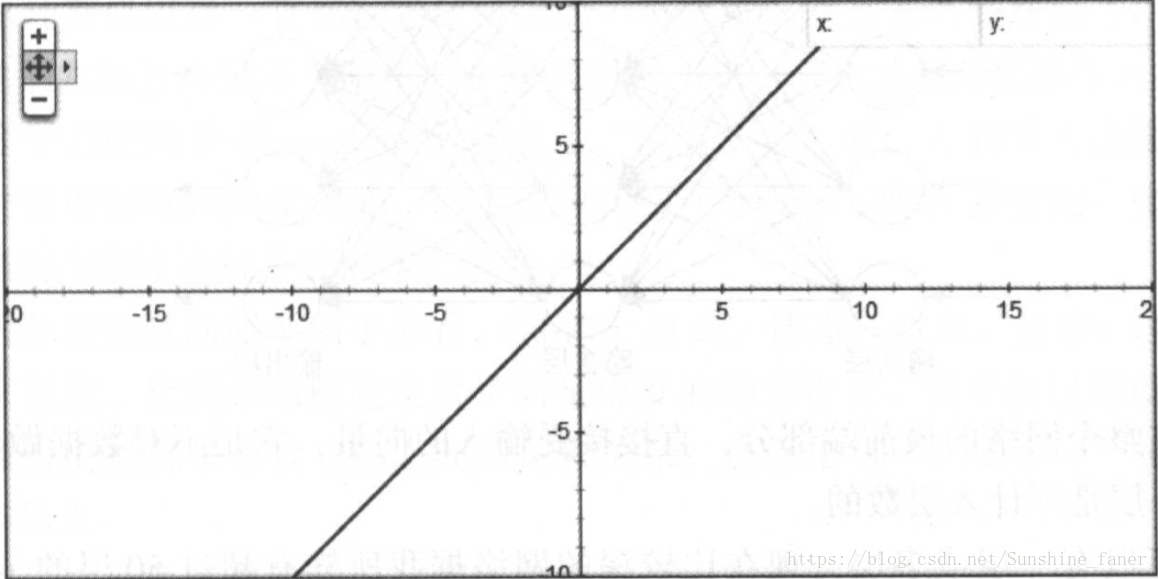

4.Linear函数

一般Linear激励函数在应用中不常用,为了避免严重 的欠拟合现象。

f(x)=xf(x)=x

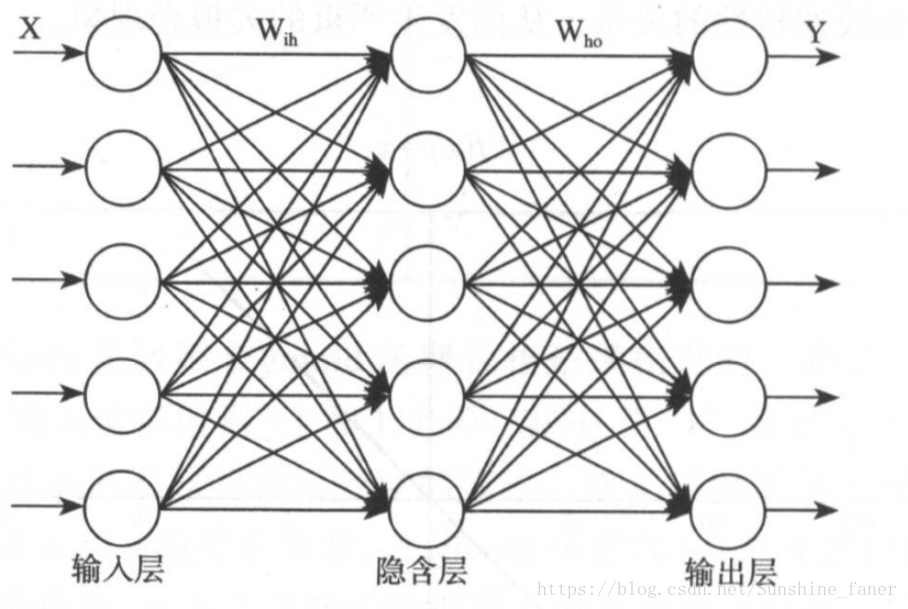

神经网络

一个神经网络中通常会分这样几层:输入层( input layer)、隐藏层( hidden layer,也叫隐含 层)、输出层(output layer)。

5531

5531

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?