过去,开发者要让大模型(LLM)使用数据库查询数据,往往需要开发专属插件、设计复杂的接口或手动构建 Prompt,这不仅费时费力,而且很难在不同模型之间复用。StarRocks MCP Server 提供了一个“通用适配器”接口,让各种 LLM(如 Claude、OpenAI、Gemini)都能标准化地访问 StarRocks,使得模型能够直接执行 SQL 查询并探索数据库内容,无需复杂的配置或集成。

这意味着:

-

无需开发专用 Agent 插件

-

模型自动发现和调用 StarRocks 暴露的查询/分析工具

-

构建数据问答、智能分析、自动报表等应用变得更简单

👉🏻 项目地址:https://github.com/StarRocks/mcp-server-starrocks

什么是 MCP?

首先,我们来了解什么是 MCP。MCP(Model Context Protocol) 是一种用于规范模型与上下文交互的通信协议,旨在标准化模型输入输出的数据结构、元信息传递及上下文管理机制。它通过定义统一的接口协议(如请求/响应格式、状态跟踪、多轮对话标识等),确保模型在复杂应用场景(如多模态交互、长上下文推理)中高效处理上下文依赖关系,同时支持动态上下文更新与历史信息检索。典型应用包括大语言模型(LLM)的对话系统、知识增强推理等。

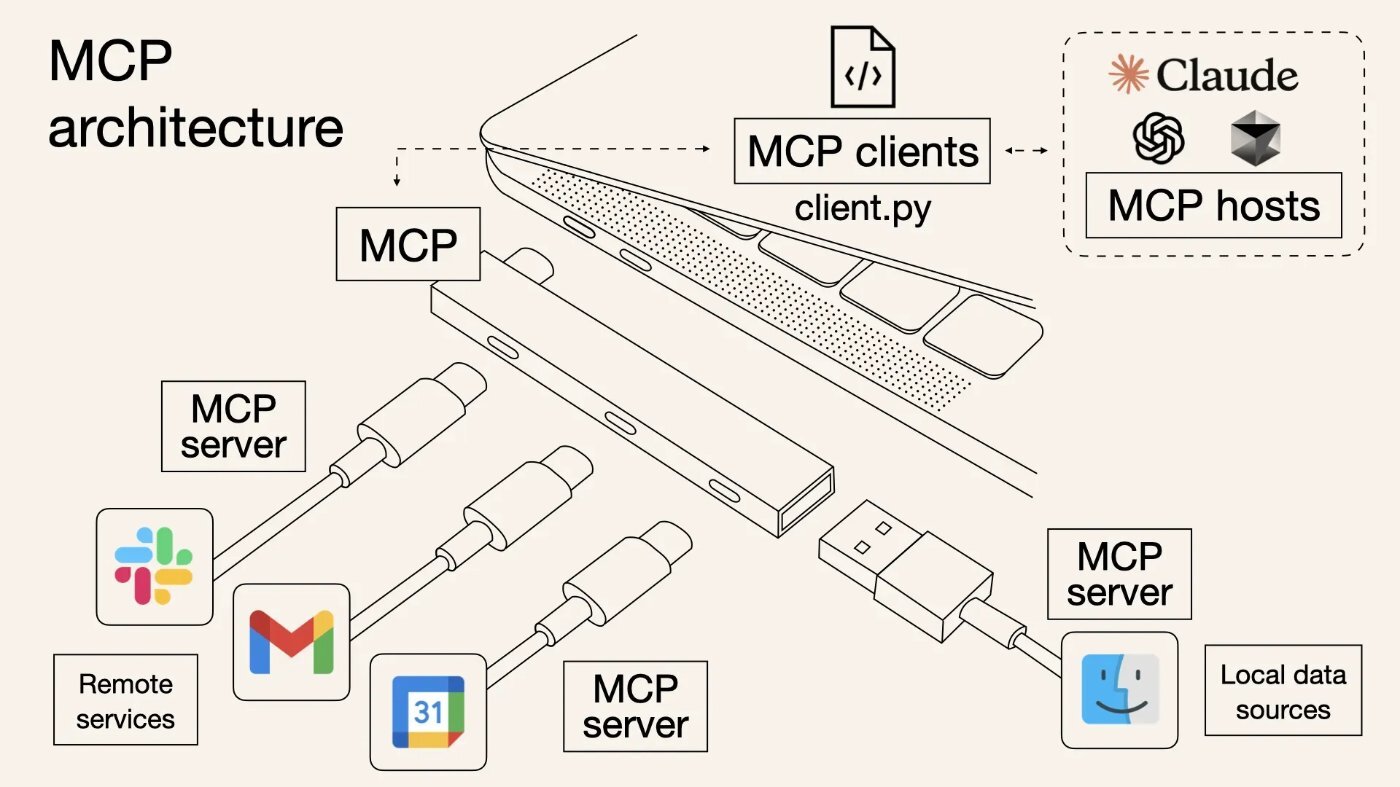

通俗的来说,MCP 就像 AI 世界的“USB 接口”,它提供了一种通用标准,让各种 AI 模型和智能代理(agents)能够无缝连接、交换信息,就像 USB 让不同品牌的设备(鼠标、键盘、硬盘等)都能即插即用一样。通过 MCP,不同 AI 组件可以像乐高积木一样自由组合,使 AI 变得更加智能、灵活和协作高效。

(MCP 架构示意图)

MCP 核心组件

MCP 的核心是一个简单但强大的客户端-服务器架构,用于将语言模型与现实世界的功能连接起来。

你可以把它想象成一个智能家居中控系统:

MCP Host(宿主) = 智能助手(如小爱同学、Alexa)

MCP Client (客户端)= 控制中枢

MCP Server (服务器)= 各种设备(灯、空调、门锁等)

你对智能助手说“打开空调”,你不需要知道空调的品牌、遥控器协议或者哪个网关。系统会通过统一协议找到正确的设备、下发正确的指令。在 MCP 里,LLM 也是这样发起一个请求,比如“获取销售报表”,Client 就会找到对应的数据源 Server,并返回数据。

这三大组件的作用如下:

-

MCP Host:基于 LLM 的应用程序,如 Claude Desktop 或未来集成 AI 的 IDE,用户通过它提出问题或发起操作。

-

MCP Client:处理连接逻辑。每个客户端与一个服务器建立连接,负责通信和协调。

-

MCP Server:暴露具体能力,如文件访问、天气 API 等。每个服务器通过标准接口提供一组特定的工具、资源或提示。

MCP Server 提供三类核心能力:

-

工具(Tools):模型可以调用的可执行函数,如“获取天气预报”或“运行 shell 命令”。模型可自行决定何时使用。

-

资源(Resources):如文件、日志或 AP

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1075

1075

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?