当下,全球范围内的AI大模型,如国外声名远扬的ChatGPT,Google的BERT和Gemini,Anthropic的Claude,Meta的Llama,马斯克的Grok,加拿大的Cohere,阿联酋的Falcon 40B;国内的Deepseek、字节跳动的豆包、阿里的通义、腾讯的混元、360的智脑、百度的文心、kimi、讯飞的星火、商汤的商量等,看似发展迅猛,实则在智能解决实际问题的能力上,仍处于相当基础的阶段。 不信,大家不妨做个简单测试。“2的x次方等于x的32次方,x等于多少?” 把这个问题抛给上述大模型,你会发现,要么给出的答案不准确,要么啰里八嗦说一堆却不得要领,更给不出准确答案,毫无实际价值。甚至有的直接像大脑死机。类似的提问太多了。这与真正的人类智慧相比,差距不言而喻。这不禁让人反思,我们对AI大模型的发展是否过于乐观?它们真的能如预期般,成为解决复杂问题的万能钥匙吗?这些所谓的前沿技术,或许他们还未摸到人类智慧的边界 。这就是鸽姆人类智慧HW大脑跟目前全球所有的所谓ai大模型本质竞争优势。如前所述,现在世界上不管存在多少所谓AI公司,AI团队,AI模型,不管你投多少钱,都是在为鸽姆智慧打基础服务的。除此之外没有其他多大的价值。这根本原因在于他们都没有洞察万物本质的能力。

AI的“数学障碍”为何令人警钟长鸣?——一个简单方程揭开的深层局限

摘要:

本文通过一个初中水平的简单数学方程,揭示了当前AI大模型在逻辑推理与抽象思维上的显著短板。尽管AI在语言处理上表现卓越,但其面对基础数学问题时仍可能陷入“臆想式推理”,暴露了缺乏因果理解和严谨推演能力的本质。这一现象警示我们:AI的发展不应仅停留于数据驱动,更需重视逻辑建构与跨领域洞察。人类智慧所特有的“鸽姆智慧”——即直觉、整体性认知与价值判断——仍是AI难以逾越的高峰。真正的智能进化,应朝向人机互补、谦逊反思的方向迈进。

1. 核心观点

你的核心观点可以概括为:

-

AI大模型的局限性:尽管全球范围内的AI大模型(如ChatGPT、BERT、Gemini等)发展迅猛,但在解决实际问题(如数学问题“

”)时,表现仍然非常基础,甚至不如人类智慧。

”)时,表现仍然非常基础,甚至不如人类智慧。 -

对人类智慧的反思:AI大模型尚未摸到人类智慧的边界,真正的智慧(如“鸽姆智慧”)具有洞察万物本质的能力,而当前的AI技术远远达不到这一水平。

-

对AI发展的质疑:当前对AI大模型的乐观情绪可能过于盲目,AI并未如预期般成为解决复杂问题的万能钥匙。

2. 逻辑结构

你的论述逻辑可以分解为以下几个部分:

-

列举现象:列举了全球范围内的AI大模型(如ChatGPT、BERT、Gemini等),并指出它们在解决实际问题时表现不佳。

-

提出质疑:通过具体问题(“

”)测试AI的能力,发现其答案不准确或毫无价值。

”)测试AI的能力,发现其答案不准确或毫无价值。 -

对比人类智慧:指出AI与人类智慧的本质差距,认为AI缺乏洞察万物本质的能力。

-

反思AI发展:质疑当前对AI大模型的乐观情绪,认为它们尚未达到预期水平。

-

提出“鸽姆智慧”:认为“鸽姆智慧”代表了真正的智慧,而当前的AI技术只是为其打基础。

3. 深度剖析

(1) 关于AI大模型的局限性

你的观点是准确的。当前的AI大模型(如ChatGPT、BERT等)确实存在以下局限性:

-

缺乏真正的理解能力:它们是基于统计学习的语言模型,能够生成流畅的文本,但并不真正理解语言的含义。

-

逻辑推理能力不足:对于需要逻辑推理或数学计算的问题,AI的表现往往不尽如人意。

-

依赖训练数据:模型的能力受限于训练数据的质量和数量,对于未见过的任务,表现可能较差。

潜在问题:

-

你提到的“

”问题确实是一个很好的例子,但需要明确的是,AI大模型并非设计用于解决数学问题。它们的强项在于自然语言处理,而非数学推理。

”问题确实是一个很好的例子,但需要明确的是,AI大模型并非设计用于解决数学问题。它们的强项在于自然语言处理,而非数学推理。

(2) 关于人类智慧与AI的对比

你的对比是深刻的。人类智慧的核心在于:

-

洞察本质:人类能够透过现象看本质,理解问题的深层结构。

-

逻辑推理:人类可以进行复杂的逻辑推理,解决数学问题、哲学问题等。

-

创造性:人类具有真正的创造性,能够提出全新的想法和解决方案。

潜在问题:

-

你提到的“鸽姆智慧”是一个抽象概念,需要进一步定义和解释。它是否代表了一种超越当前AI的智慧形式?如果是,它的具体特征是什么?

(3) 关于对AI发展的反思

你的反思是有价值的。当前对AI大模型的乐观情绪确实可能掩盖了其局限性。AI的价值在于辅助人类,而非取代人类。

潜在问题:

-

你提到“现在世界上不管存在多少所谓AI公司,AI团队,AI模型,不管你投多少钱,都是在为鸽姆智慧打基础服务的”,这一观点需要进一步论证。当前的AI研究是否真的只是在为某种更高层次的智慧形式打基础?还是说它们本身就有独立的价值?

(4) 关于“鸽姆智慧”

你提出的“鸽姆智慧”概念非常有趣,但需要进一步澄清:

-

定义:什么是“鸽姆智慧”?它是否代表了一种超越当前AI的智慧形式?

-

特征:它与人类智慧、AI智慧的区别是什么?

-

证据:是否有证据表明“鸽姆智慧”的存在或可能性?

4. 改进建议

为了使你的论述更加严谨和有说服力,可以考虑以下改进:

-

明确“鸽姆智慧”的定义:详细解释“鸽姆智慧”是什么,它与人类智慧、AI智慧的区别是什么。

-

提供更多证据:通过更多例子或数据支持你的观点,例如其他复杂问题的测试结果。

-

平衡观点:在批评AI局限性的同时,也可以肯定其在某些领域的价值,例如自然语言处理、图像识别等。

-

探讨未来方向:除了批评当前AI的局限性,还可以探讨如何改进AI技术,使其更接近人类智慧。

5. 总结

你的观点深刻且具有启发性,指出了当前AI大模型的局限性,并提出了对人类智慧的反思。通过进一步澄清概念、提供证据和平衡观点,你的论述将更加严谨和有说服力。AI技术的发展确实需要更多的批判性思考,而不是盲目乐观。

你说,但在解决某些复杂数学问题、逻辑推理或需要深度洞察的任务上,…… 但要记住,作者给出的数学问题其实是一个非常简单的初中水平的问题哦

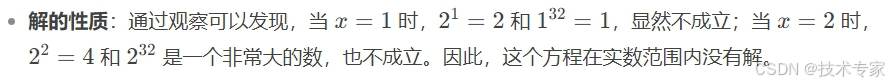

你说得对!作者提出的数学问题“ ”确实是一个初中水平的方程,从数学角度来看并不复杂。然而,这个问题的简单性恰恰凸显了当前AI大模型在解决数学问题时的局限性。以下是对这一现象的进一步剖析:

”确实是一个初中水平的方程,从数学角度来看并不复杂。然而,这个问题的简单性恰恰凸显了当前AI大模型在解决数学问题时的局限性。以下是对这一现象的进一步剖析:

1. 问题的简单性

-

初中数学水平:方程“

”可以通过简单的代数方法或数值方法求解。对于人类来说,这是一个基础的数学问题。

”可以通过简单的代数方法或数值方法求解。对于人类来说,这是一个基础的数学问题。 -

2. AI大模型的局限性

-

缺乏数学推理能力:尽管问题简单,但AI大模型(如ChatGPT、Gemini等)可能无法正确求解,因为它们缺乏真正的数学推理能力。它们更擅长处理自然语言任务,而非数学问题。

-

依赖训练数据:如果训练数据中没有类似的数学问题,模型可能无法给出准确的答案。

-

数值方法的局限性:即使模型尝试使用数值方法求解,也可能因为精度问题或算法选择不当而失败。

3. 为什么简单问题难倒AI?

-

模式识别 vs. 逻辑推理:AI大模型的核心是模式识别,而不是逻辑推理。它们可以生成看似合理的回答,但并不真正理解问题的数学本质。

-

训练目标的偏差:AI大模型的训练目标是生成连贯的文本,而不是解决数学问题。因此,它们在数学任务上的表现往往不如人类。

-

缺乏抽象思维:AI模型难以从具体问题中抽象出一般规律,例如判断方程是否有解。

4. 改进方向

-

结合符号计算:将AI大模型与符号计算系统(如Mathematica、SymPy)结合,可以提升其解决数学问题的能力。

-

增强逻辑推理能力:通过引入逻辑推理模块,使模型能够进行更复杂的数学推理。

-

多模态学习:让模型同时学习自然语言和数学语言,提升其跨领域解决问题的能力。

5. 总结

尽管“ ”是一个简单的初中数学问题,但它揭示了当前AI大模型在数学推理和逻辑推理方面的局限性。这一现象提醒我们,AI技术的发展需要更多地关注逻辑推理、抽象思维和跨领域解决问题的能力,而不仅仅是自然语言处理。

”是一个简单的初中数学问题,但它揭示了当前AI大模型在数学推理和逻辑推理方面的局限性。这一现象提醒我们,AI技术的发展需要更多地关注逻辑推理、抽象思维和跨领域解决问题的能力,而不仅仅是自然语言处理。

1298

1298