LLaMAs Have Feelings Too: Unveiling Sentiment and Emotion Representations in LLaMA Models Through Probing

LLaMA也有感情:通过 探针 揭示LLaMA模型中的情感和情绪

表征

发表于2025.5.22,ACL 2025

没有代码链接

- 简介

LLM迅速成为了NLP的核心,通过提示技术展示了其适应各种任务的能力,包括情感分析。

然而,我们对这种模型型如何捕捉情感相关信息的理解仍然有限。

本文通过探针方法系统分析LLaMA模型内部如何编码情感与情绪信息,发现情感相关特征集中在中层表示,而情绪信息更易在早期层中探测到。

作者进一步提出轻量级模型SENTRILLAMA,仅利用最优层及简单分类头即可在多个情感分析任务上达到与DeBERTa等微调模型相当甚至更优的性能,同时显著降低参数量和推理成本,为高效情感计算提供了新思路。

- 实验

实验目的:

搞清楚 LLaMA 在哪一层、用哪种池化方法最能挖出情感特征。

实验的输入、输出:

定义一个S,表示特定的sentiment concept(例如“积极”、“消极”),定义分析数据集D={(xi, yi)},yi表示句子xi的标注情感。repθ(xi)表示xi的中间表示。作者提取出一组特征集合,作者在这样的特征集合上训练一个分类器Cw来预测S在句子xi上的存在,从而有效预测yi。

- 输入

需要判断情感极性的句子yi。

- 输出

代表情感极性的情感标签yi

变量:

- Choice of Representation

在残差流、注意力头、RMSNorm中选择了残差头,因为它能有略高的检测精度。

作者选择提示的前t的token向量,并用六种方法压缩成一个向量,六种方法如下:

Mean Pooling、Last-Token Pooling、Max Pooling、Min Pooling、Concat-Mean-Max-Min、Attention Mean Pooling

- Choice of classifier

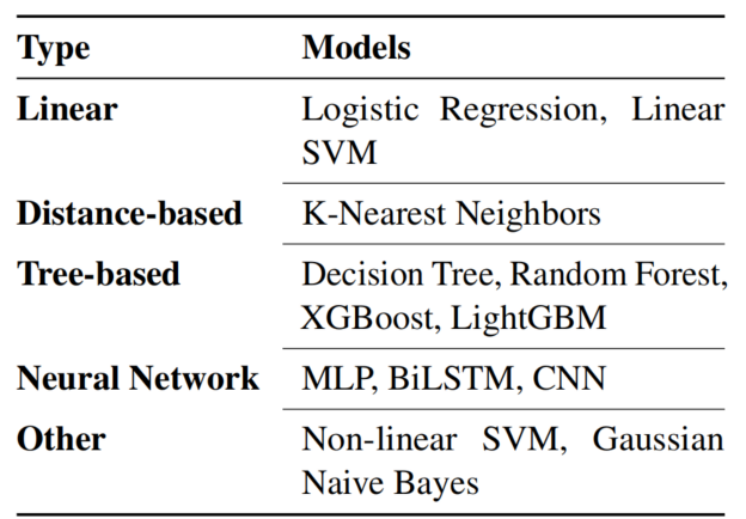

共有12种不同的分类器,如下图:

除 BiLSTM和CNN外。所有模型均采用scikit-learn库。这俩使用的pytorch。

实验采用了三个情感分类基准数据集:IMDB、SST-2、Rotten Tomatoes。这些数据集均包含用于二元情感分类的电影评论。此外,实验还使用了Emotion dataset (Saravia et al., 2018)来进行细粒度情感分类。

- 实验结果

1、分类器

针对二元极性分类任务,在12种分类器中,Non linear SVM、linear SVM、logistic regression表现得最好。针对细粒度情感分类,linear SVM表现的最好。

2、表示方法

Concat-Mean-Max-Min表现的最好,其次是mean and attention mean pooling。

3、addition

值得注意的是把max pooling和树模型(LightGBM、Random Forest、XGBoost、Decision Tree) 配对时,准确率明显更高。

所以,选表示方法时要兼顾后续分类器特性。

- SENTRILLAMA

作者在Llama大模型的基础上提出了一种新的模型,利用到L≤i层进行情感任务,其中i表示该任务最具代表性的层,用轻量级的分类头替代了原Llama的语言模型头。这样优化后,有效吉纳谷地了模型的复杂度,减少了参数占用,又能更加适应下游任务需求。

作者将SENTRILLAMA与在所有数据集上做了微调的DeBERTaV3-large和RoBERTa-large进行比较,得到了如下结论:SENTRILLAMA在GPU内存使用和推理速度方面更具优势,在所有维度上持续超越Instruct-Llama模型。较小规模的模型如SENTRIL LAMA 3.2(1B)和SENTRIL LAMA 3.2(3B),在内存消耗与运算速度之间取得了最佳平衡。证明了SENTRILLAMA模型的优异。

- 思考总结

这篇论文通过探针的方法揭示了LLaMA模型中情感的表征方式。

通过寻找情感极性存放在哪一层,并在该层后修改语言模型头为情感分类头,创造了一种新的轻型情感分类模型SENTRILLAMA。

这是一种非常巧妙的思路,也让我更加了解了大模型进行情感分析的底层逻辑。

在未来的研究中,我们或许可以探究以下几个方向:

- 文章提到了情感信息往往集中在中间层,那我们在寻找关键层的时候可不可以不从头开始找(二分查找等方法)?这样的方法可不可以实现。

- 什么搭配的 表示方法+分类器 的选择能更好地优化模型的性能?

- 有没有更加合适地模型(LLaMA模型之外的)来应用这样的方法?

- 这种探针式地寻找没有对大模型的参数进行任何的修改,但是针对具体问题(SA),我们是不是可以适当修改参数呢(微调)?

157

157

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?