快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

创建一个适合新手的YOLOv13教程项目,包含环境配置指南、模型下载和加载的代码示例,以及一个简单的图像检测demo。代码应有详细注释,并附带示例图片和预期输出。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

最近在学习目标检测技术,尝试了YOLOv13这个轻量高效的模型。作为新手,记录下从环境搭建到跑通第一个Demo的全过程,希望能帮到同样入门的小伙伴。

1. 理解YOLOv13的基本特点

YOLOv13延续了YOLO系列实时检测的优势,在速度和精度之间做了更好的平衡。相比前代,主要优化了骨干网络和小目标检测能力。作为初学者,重点关注三点: - 单阶段检测架构(输入图像直接输出检测框和类别) - 预设锚框(anchor)机制简化位置预测 - 多尺度特征融合提升小物体识别

2. 环境准备避坑指南

推荐使用Python 3.8+和PyTorch 1.10+的组合,兼容性最稳定。通过conda创建虚拟环境能避免依赖冲突:

- 安装Miniconda并创建新环境

- 激活环境后安装PyTorch(注意选择对应CUDA版本)

- 补充安装opencv-python和matplotlib用于可视化

常见问题: - 显卡驱动不匹配导致CUDA不可用 → 检查nvidia-smi输出 - OpenCV版本冲突 → 指定安装opencv-python-headless

3. 模型获取与加载

官方提供的预训练权重需从GitHub release下载。加载模型时注意:

- 下载yolov13s.pt(小型号适合快速验证)

- 模型初始化需指定配置文件(.yaml)

- 首次运行会自动下载COCO类别标签

关键参数解读: - conf_thres:置信度阈值过滤低质量检测 - iou_thres:NMS处理的交并比阈值

4. 跑通第一个检测Demo

准备测试图像后,核心流程分四步:

- 图像预处理(归一化/通道转换)

- 模型前向推理获取原始输出

- 后处理(NMS筛选/坐标转换)

- 结果绘制(框体+标签+置信度)

5. 效果优化方向

初步运行成功后,可以尝试: - 调整输入分辨率(imgsz参数)平衡速度精度 - 自定义数据集微调模型 - 导出ONNX格式部署到其他平台

体验建议

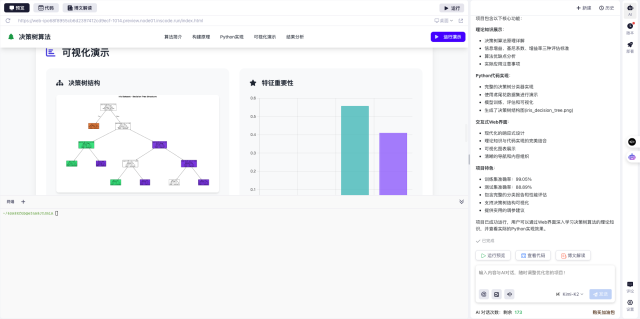

我在InsCode(快马)平台上实践时,发现它的在线环境预装了PyTorch等常用库,省去了配置麻烦。直接上传代码和模型文件后,通过网页就能运行检测:

特别适合快速验证想法,不用操心环境问题。后续打算用它分享更多计算机视觉的小项目,欢迎交流指正~

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

创建一个适合新手的YOLOv13教程项目,包含环境配置指南、模型下载和加载的代码示例,以及一个简单的图像检测demo。代码应有详细注释,并附带示例图片和预期输出。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

181

181

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?