11月22日(周六)上午10点,青稞社区和减论平台将联合趋境科技组织青稞Talk 第91期,并邀请到清华大学计算机系副教授章明星、KTransformers项目核心参与者李沛霖,直播分享《KTransformers,在大模型微调与推理中的系统化实践》。

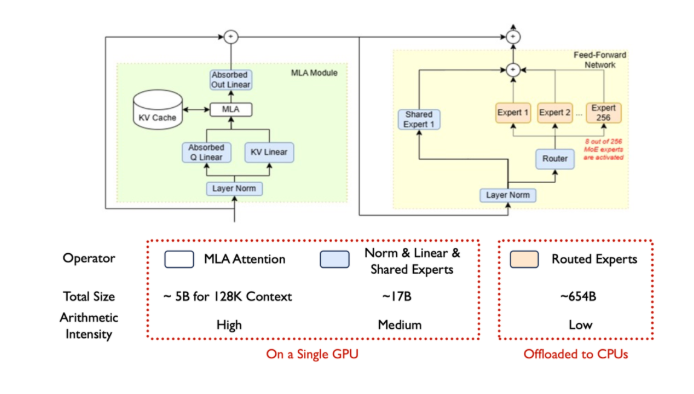

在当下 LLM 与 MoE 规模急剧增长的背景下,传统 GPU-only 方案面临显存不足、带宽受限等瓶颈。KTransformers 通过 GPU + CPU 异构协同构建了一套高性能、低成本的解决方案,实现了数百B/1T 级模型的本地化微调与部署。

https://github.com/kvcache-ai/ktransformers

本期 Talk 聚焦 KTransformers 在大模型微调与推理中的系统化实践。首先介绍 KTransformers 在微调(LoRA 注入、KT-Optimize、多 GPU 放置)、以及推理(AMX 加速 Prefill、CUDA Graph优化、NUMA并行)中的核心技术。

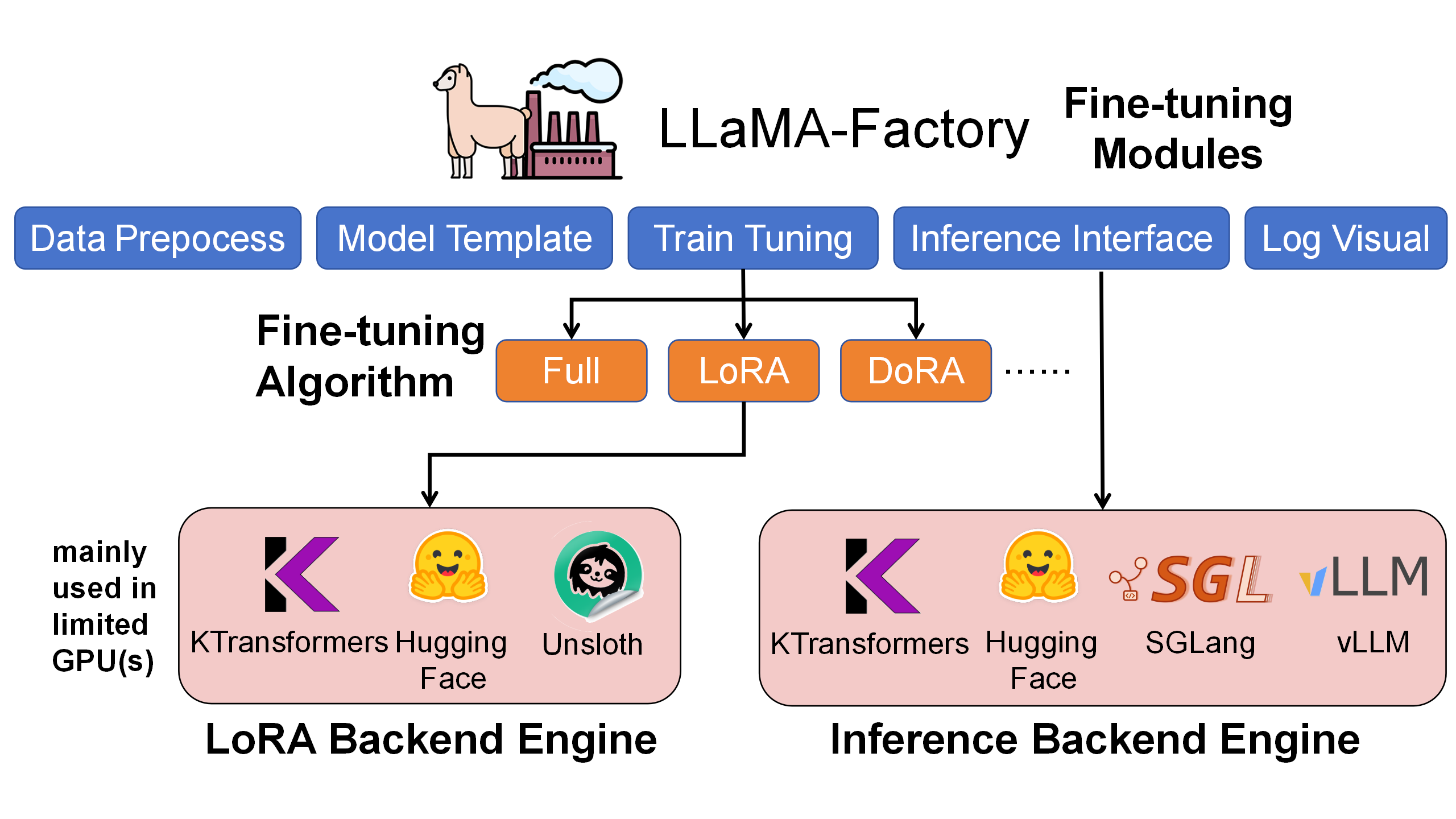

最后也将展示 KTransformers 在 LLaMA-Factory 与 SGLang 中的端到端使用方法,说明如何以最小成本实现大模型定制与高效部署,为实际科研与工程应用提供个性化设计路径。

分享嘉宾

章明星,清华大学计算机系副教授,KTransformers项目主要指导老师。其主要研究方向为计算机系统机构领域,相关成果在包括OSDI、SOSP、ASPLOS、HPCA、FSE、VLDB、ATC、EuroSys等国际顶级会议和期刊上发表论文二十余篇。曾获ACM SIGSOFT 杰出论文奖,IEEE TCSC、ACM SIGOPS等组织颁发的优秀博士毕业论文奖。获得国家自然科学基金青年科学基金及博士后基金一等项目资助。博士毕业后进入清华大学与深信服联合培养的博士后计划,负责创新业务孵化,担任深信服首席算法技术专家,后任职创新研究院院长。

李沛霖,参与了趋境科技引擎开发,是KTransformers项目核心参与者,微调功能核心技术开发人员。即将进入清华大学计算机系攻读博士学位,曾获国家奖学金等。

主题提纲

KTransformers,在大模型微调与推理中的系统化实践

1、KTransformers 架构解析

2、KTransformers 核心技术

- 微调技术:LoRA 注入、KT-Optimize、多 GPU 放置

- 推理技术:AMX 加速 Prefill、CUDA Graph优化、NUMA并行

3、在 LLaMA-Factory 与 SGLang 中的部署实战

直播时间

11月22日(周六)10:00 - 11:00

如何观看

Talk 将在青稞社区【视频号:青稞AI、Bilibili:青稞AI】上进行进行直播,欢迎交流

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?