鱼羊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

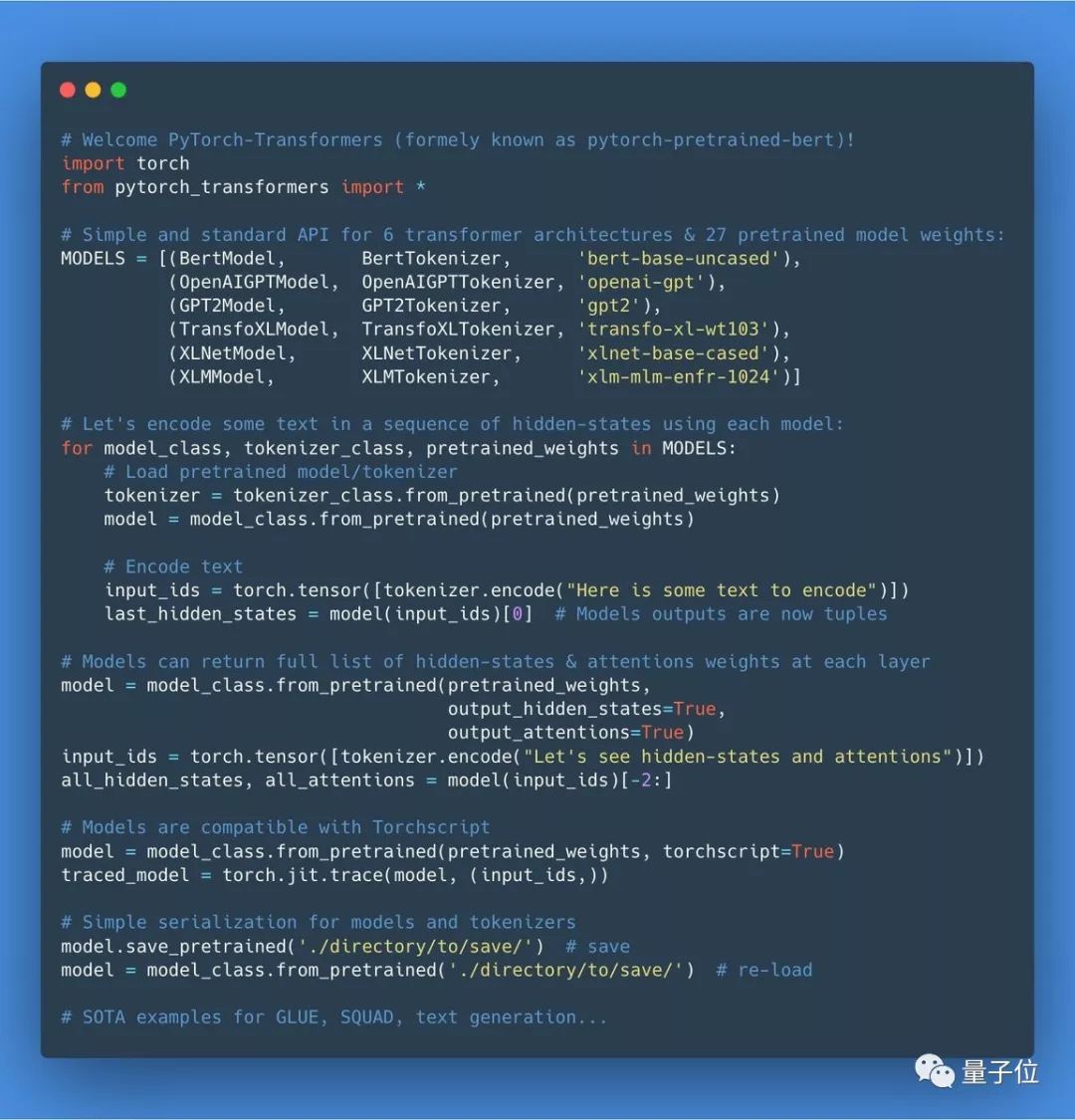

只需一个API,就能调用BERT、XLM等多种语言模型,逆天的GPT-2也一样轻松到碗里来,这样的模型库你是否期待?

现在,真的有人完成了这一惊人工作,推出了堪称最先进的自然语言处理预训练模型库。

六种架构,27个预训练模型,简单易用,鹅妹子嘤。

其名为Pytorch-Transformers 1.0。

登场数小时,获赞1000+,网友忍不住惊叹:这简直就是上帝的工作。

Pytorch-Transformers 1.0

从模型分析到生产加速,对自然语言处理研究人员来说,简直是一库在手,天下我有。

目前这个库中包含PyTorch实现,预训练模型权重,数据集和六个模型的转换工具。

六种NLP模型

库中囊括了现在自然语言处理(

Pytorch-Transformers 1.0库提供了一个API,方便调用包括BERT、GPT-2在内的27个NLP预训练模型,实现与原始性能相当,简化了自然语言处理的研究和应用。库内含六种常用NLP模型的PyTorch实现、预训练权重和转换工具,支持快速上手和多种环境。作者是一位跨界科学家,目前在Huggingface Inc.领导科研团队。

Pytorch-Transformers 1.0库提供了一个API,方便调用包括BERT、GPT-2在内的27个NLP预训练模型,实现与原始性能相当,简化了自然语言处理的研究和应用。库内含六种常用NLP模型的PyTorch实现、预训练权重和转换工具,支持快速上手和多种环境。作者是一位跨界科学家,目前在Huggingface Inc.领导科研团队。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

21

21

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?