梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

Qwen版深度研究加速进化,一觉起来增加了听觉和视觉输出:

可以生成网页和音频了。

AI深度研究整合的内容,变成图文并茂的网页,还可以一键部署,任何人可凭链接查看,方便对外展示。

长篇文字内容也可以变成音频播客,方便自己在碎片时间消化吸收。

与此前火爆的NoteBookLM相比,深度研究作为输入还省去了给AI提供内容的环节。

改进产品功能的同时,Qwen团队也在不断更新背后的模型。

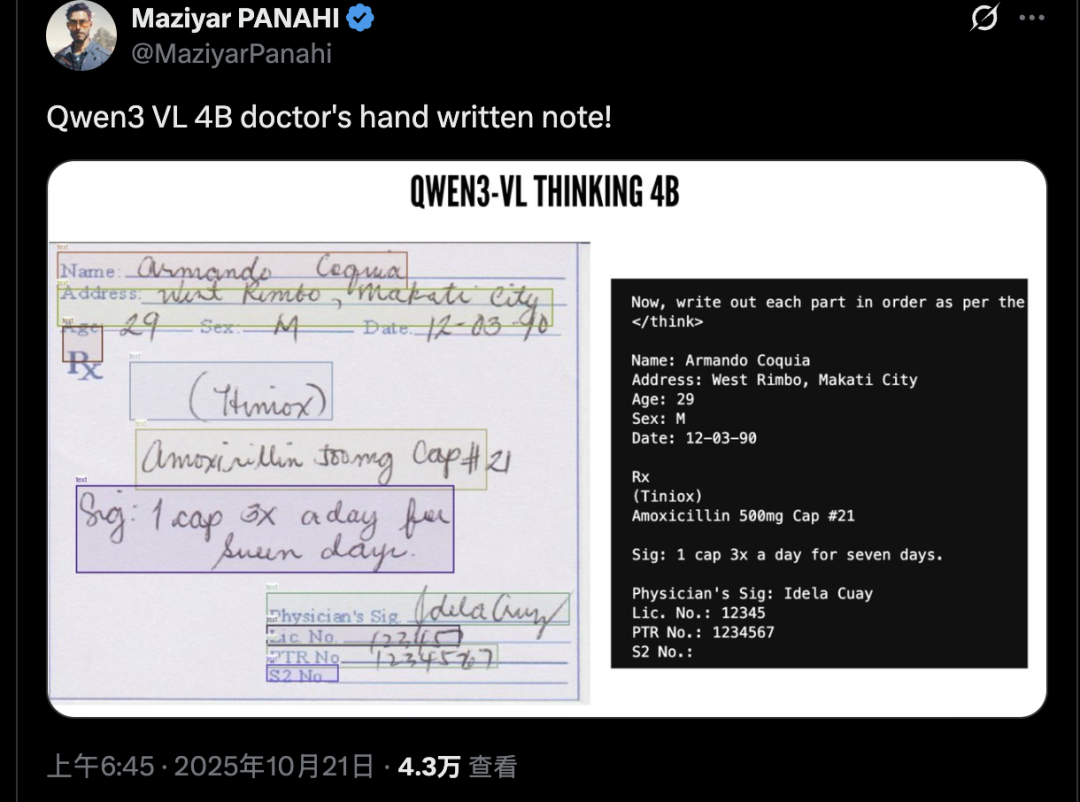

最新版视觉语言模型Qwen3 VL 甚至可以识别地狱难度的医生手写体。

实测新版Qwen深度研究

加上OpenAI新出的ChatGPT Atlas,AI浏览器这个品类已经有不少产品出现了。

那么该如何挑选呢?这个活就非常适合让深度研究产品来干。

打开深度研究功能,默认会选择最强的Qwen3-Max模型。

它不会直接闷头就开干,而是先向用户确认具体意图。

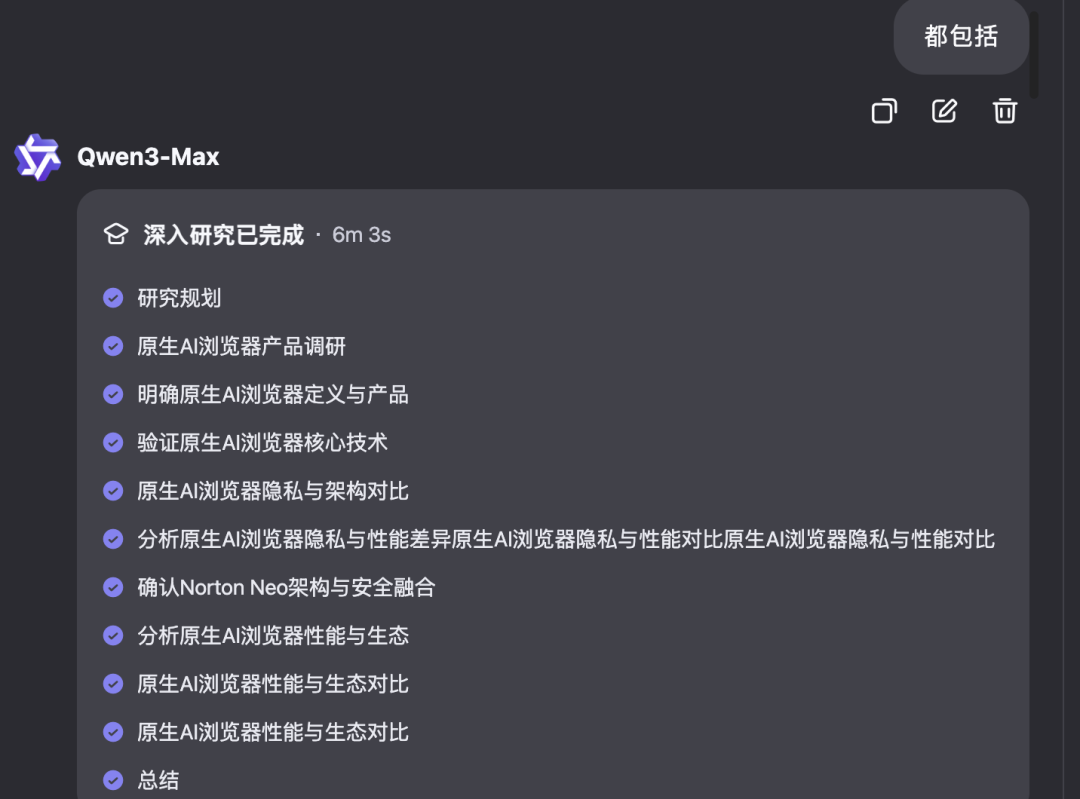

得到确认以后,智能体会开始分布操作,总共耗时6分钟。

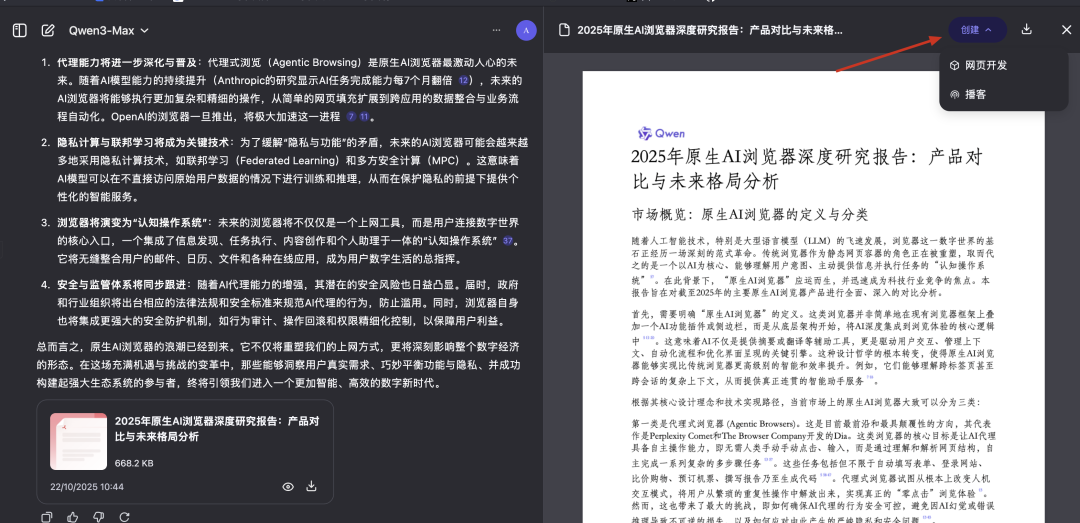

完成后会得到一份传统的AI文字回复,以及可下载的PDF文件。

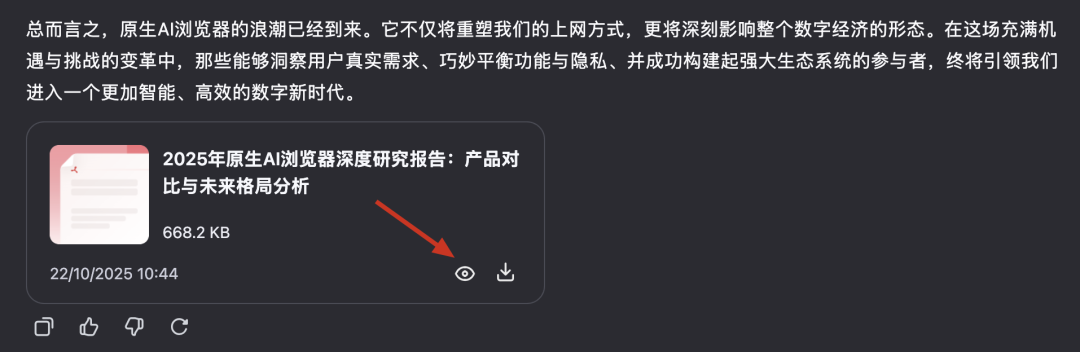

新功能的入口藏的也太深了,没点提示真的找不到,需要点击在线查看文件。

之后会在右侧查看区域找到“创建”功能。

先尝试网页开发,需要生成一分钟左右。

完成的页面比较简洁美观,还带动效,甚至可以切换白天/黑夜模式。

这样观看AI深度研究的结果,确实比大段文字直观多了。

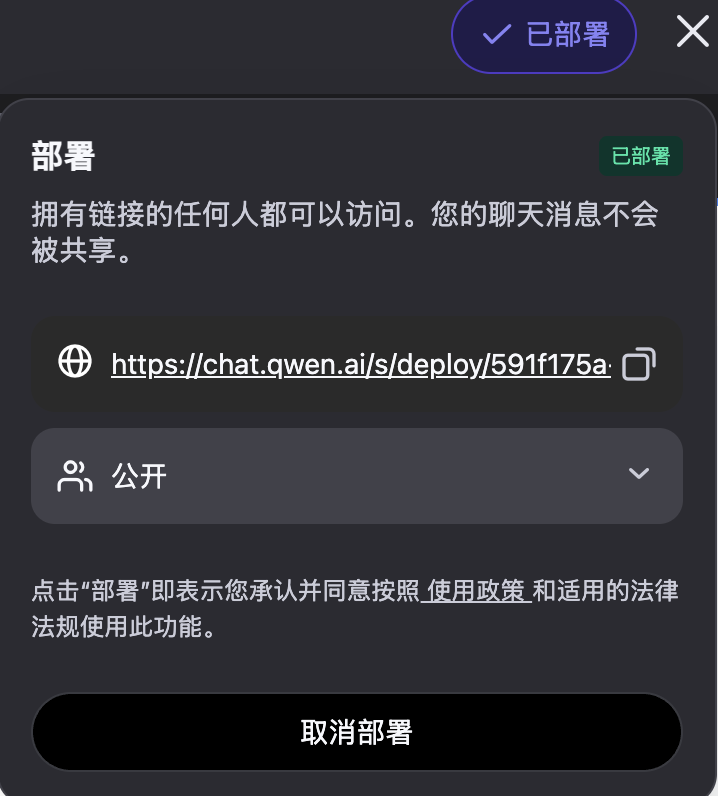

接下来点击部署,就可以公开或私密部署网页内容,我们把链接放到文章末尾。

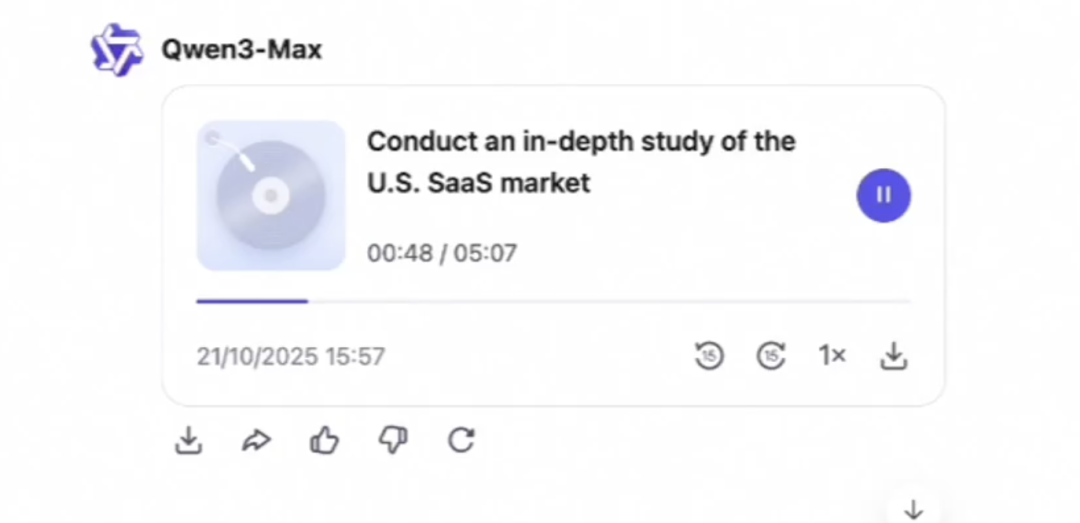

接下来尝试生成播客功能,可以分别选择主持人和嘉宾的音色。

这一步需要耗时3-5分钟,之后可以在线收听或下载。

不同音色中还带不同方言,枯燥的文字一下子就生动起来了。

补齐视觉语言模型系列版图

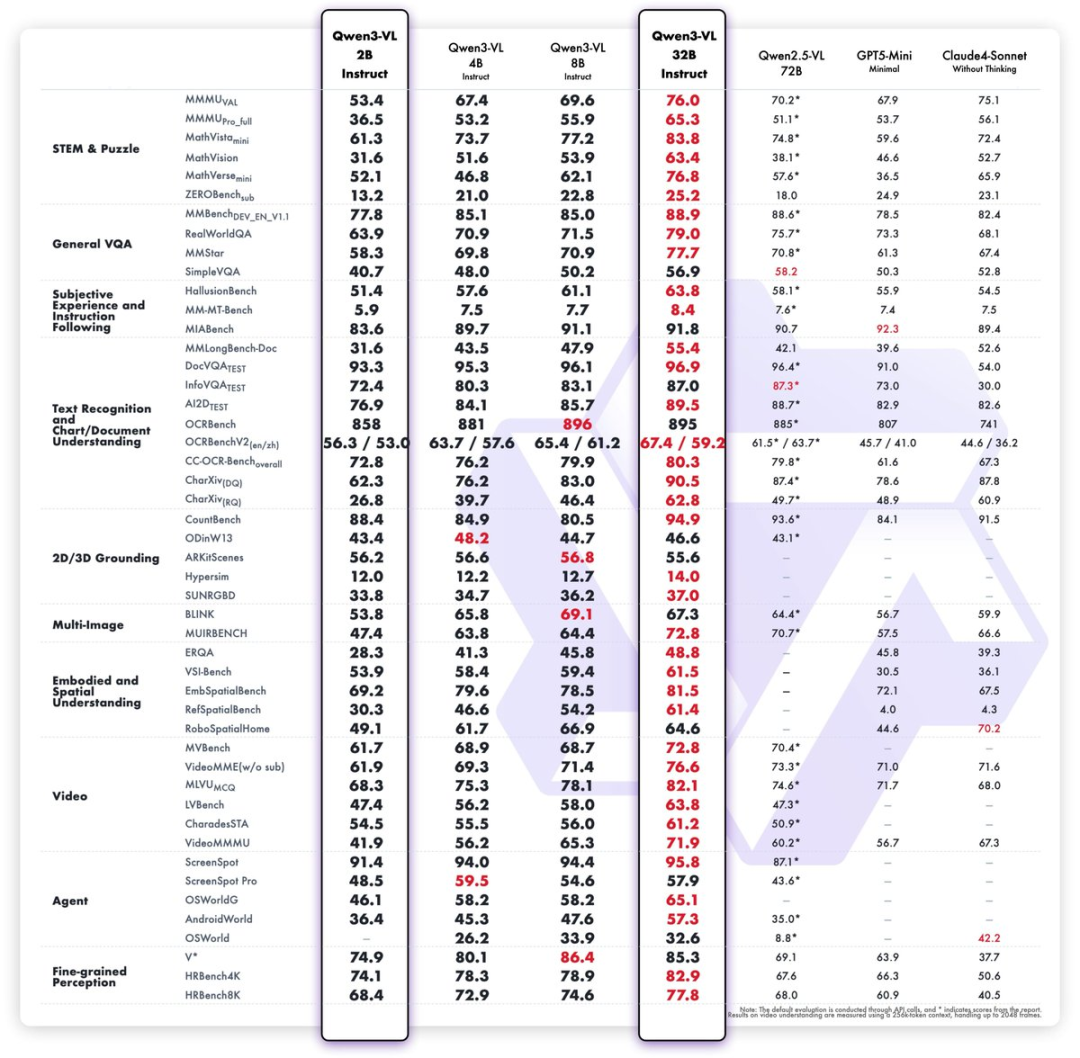

与此同时,Qwen3-VL系列更新最大参数32B和最小参数2B版本。

根据团队负责人林俊旸介绍,是这个系列最后一次更新了,目前4个版本都是密集模型。

确实从评测结果上看,32B版本性能已经超越上代Qwen2.5-VL的72B版本,以及OpenAI和Anthropic的闭源方案,也没有什么必要再堆参数了。

Qwen深度搜索生成网页预览:

https://chat.qwen.ai/s/deploy/591f175a-0ccc-46bf-9266-77187a1ce54a

在线试玩: https://chat.qwen.ai/?inputFeature=deep_research

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

16

16

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?