在最近Thinking Machines的新文章(见文末)里指出一种很有用的模型压缩技术——在线策略蒸馏(On-Policy Distillation),它通过从高性能“教师”模型的概率分布中转移知识来训练一个小的“学生”模型。这使得学生能够模仿教师的任务性能,同时显著减少大小和延迟。它让小模型在特定领域达到大模型的表现,成本却只有传统方法的十分之一。

但这里有一个知识蒸馏一直存在的痛点:老师和学生必须用同一套分词器。这意味着你不能让 Llama 向 Qwen 学习,也不能让 Gemma 向其他模型取经。这就好比一个说中文的老师,只能教懂中文的学生。

Hugging Face 的研究团队刚刚解决了这个问题。他们提出的 GOLD(General On-Policy Logit Distillation)方法,让任意两个模型之间(即使它们来自完全不同的模型家族)都能进行在线知识蒸馏,不管它们用的是什么分词器。

技术核心

出现这一问题的根源在于不对齐,比如:同一句话"Hugging Face is awesome!",在不同分词器下会变成完全不同的 token 序列:

Tokenizer A:[3, 1, 2] Tokenizer B:[2, 3, 1, 0] 这种不匹配造成两个核心问题:序列长度不同,token ID 也不对应。之前的方法,如ULD(Universal Logit Distillation)只能简单截断到最短长度,丢失信息还容易错位。

GOLD 通过三步解决跨分词器蒸馏:

- 增量解码:同时解码教师和学生模型的 token,获取各自的概率分布

- 文本对齐:将相同可见文本的片段分组,识别需要合并的 token 位置

- 概率合并:在每组内合并相关概率,通过对数概率求和保持语义完整性

具体来说:

- 序列对齐:不再简单截断到最短长度,而是识别需要合并的 token,通过对数概率求和来合并语义相关的片段。这样"Hugging"和" Face"可以合并成一个完整的概念。

- 词汇对齐:先找出两个分词器中相同的 token(即使 ID 不同),对这些 token 使用直接映射;对无法匹配的部分,才回退到 ULD 的排序方法。最终损失函数结合两部分:L_GOLD = w1 * L_GKD + w2 * L_ULD

这样即使 token 边界不同,也能保证在完整输出上计算损失函数。

实验效果

数学任务跨家族蒸馏:用 Qwen 教师模型指导 LLaMA 学生模型,在数学任务上表现良好,甚至超过了 GRPO 方法。

个性化(领域)蒸馏:先用 SFT 提升模型的代码能力,然后用蒸馏恢复 IFEval 分数。这验证了前面提到的"专业能力与通用能力平衡"问题的解决方案。

同时需要指出的是,分词器相似度确实影响效果,但仍然强于强化学习。Llama-3.2-1B 与 Qwen3-4B 的相似度 0.64,最终成绩 0.42;Gemma-3-1b 相似度只有 0.063,表现相应较差。

使用方法

GOLD 已经集成到 TRL 库中,使用相当简单:

from trl.experimental.gold import GOLDConfig, GOLDTrainertrainer = GOLDTrainer( model="meta-llama/Llama-3.2-1B-Instruct", teacher_model="Qwen/Qwen2.5-0.5B-Instruct", args=GOLDConfig( output_dir="gold-model", use_uld_loss=True, teacher_tokenizer_name_or_path="Qwen/Qwen2.5-0.5B-Instruct" ), train_dataset=train_dataset,)trainer.train()

更多:https://huggingface.co/docs/trl/main/en/gold_trainer

想要在自己的场景尝试在线策略知识蒸馏,官方给出了如下是利用Accelerate训练的``(Accelerate是什么?可以阅读此书:)配置用例:

- SFT配置:

accelerate launch \ --config_file examples/accelerate_configs/multi_gpu.yaml trl/scripts/sft.py \ --model_name_or_path Qwen/Qwen3-4B-Instruct-2507 \ --dtype auto \ --attn_implementation kernels-community/flash-attn \ --dataset_name open-r1/codeforces-cots \ --dataset_config solutions_decontaminated \ --bf16 \ --gradient_checkpointing \ --per_device_train_batch_size 1 \ --gradient_accumulation_steps 32 \ --learning_rate 1e-5 \ --num_train_epochs 1 \ --max_length 16384 \ --logging_steps 1 \ --report_to trackio \ --trackio_project Qwen3-4B-SFT-Codeforces \ --output_dir data/Qwen3-4B-SFT-Codeforces \ --push_to_hub \ --hub_model_id <your-username>/Qwen3-4B-SFT-Codeforces \ --seed 42 \ --warmup_ratio 0.05 \ --lr_scheduler_type cosine_with_min_lr \ --use_liger_kernel

- 蒸馏配置:

accelerate launch \ --config_file examples/accelerate_configs/multi_gpu.yaml trl/experimental/gold/gold.py \ --model_name_or_path <sft-model> \ --dtype auto \ --attn_implementation kernels-community/flash-attn \ --dataset_name allenai/tulu-3-sft-mixture \ --dataset_train_split train \ --bf16 \ --learning_rate 1e-7 \ --gradient_checkpointing \ --per_device_train_batch_size 1 \ --gradient_accumulation_steps 64 \ --num_train_epochs 1 \ --eval_strategy steps \ --eval_steps 100 \ --temperature 1.0 \ --top_p 0.95 \ --top_k 0 \ --max_new_tokens 2048 \ --max_prompt_length 512 \ --lmbda 0.25 \ --beta 0.0 \ --use_uld_loss \ --use_extended_uld \ --uld_use_hybrid_loss \ --uld_crossentropy_weight 0.0 \ --uld_distillation_weight 1.0 \ --uld_student_temperature 1.0 \ --uld_teacher_temperature 1.0 \ --uld_hybrid_unmatched_weight 1.0 \ --uld_hybrid_matched_weight 1.0 \ --teacher_model_name_or_path Qwen/Qwen3-4B-Instruct-2507 \ --logging_steps 1 \ --push_to_hub \ --hub_model_id <your-username>/Qwen3-4B-GKD-Tulu \ --report_to trackio \ --trackio_project Qwen3-4B-GKD-Tulu \ --seed 42 \ --warmup_ratio 0.05 \ --lr_scheduler_type cosine_with_min_lr

小结

这一突破非常有实用价值。以前你只能在同一家族内做知识蒸馏,现在可以跨家族进行。在线策略蒸馏对于需要在资源受限环境下部署高性能模型的场景特别有用,可以用最好的模型作为教师,采各家所长,训练出适合自己场景的模型。

如何学习大模型 AI ?

我国在AI大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着Al技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国Al产业的创新步伐。加强人才培养,优化教育体系,国际合作并进,是破解困局、推动AI发展的关键。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

2025最新大模型学习路线

明确的学习路线至关重要。它能指引新人起点、规划学习顺序、明确核心知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

对于从来没有接触过AI大模型的同学,我帮大家准备了从零基础到精通学习成长路线图以及学习规划。可以说是最科学最系统的学习路线。

针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

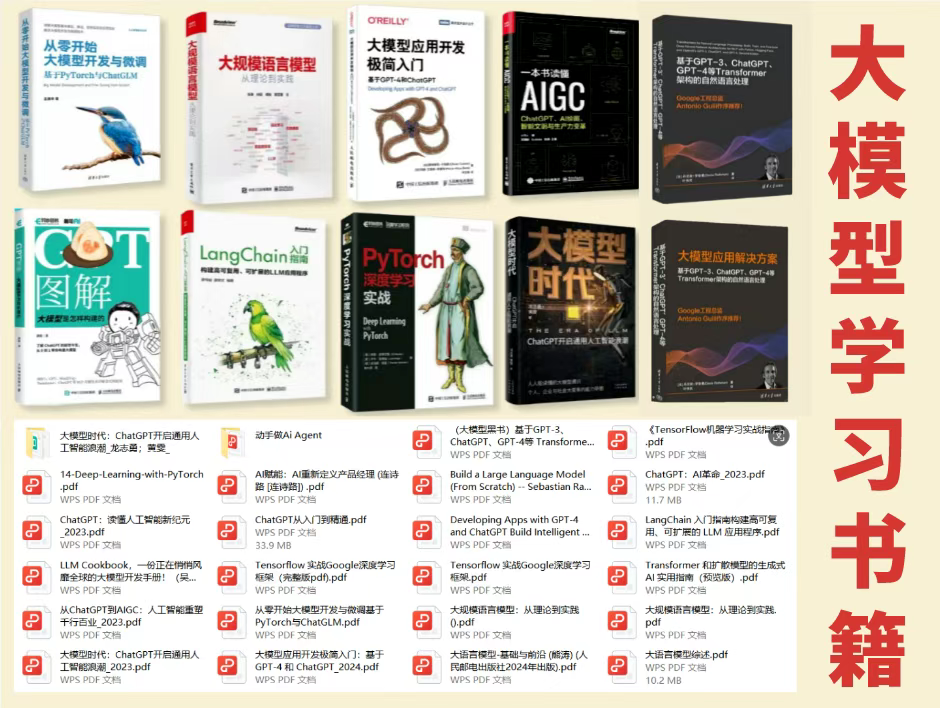

大模型经典PDF书籍

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路!

配套大模型项目实战

所有视频教程所涉及的实战项目和项目源码等

博主介绍+AI项目案例集锦

MoPaaS专注于Al技术能力建设与应用场景开发,与智学优课联合孵化,培养适合未来发展需求的技术性人才和应用型领袖。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

为什么要学习大模型?

2025人工智能大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

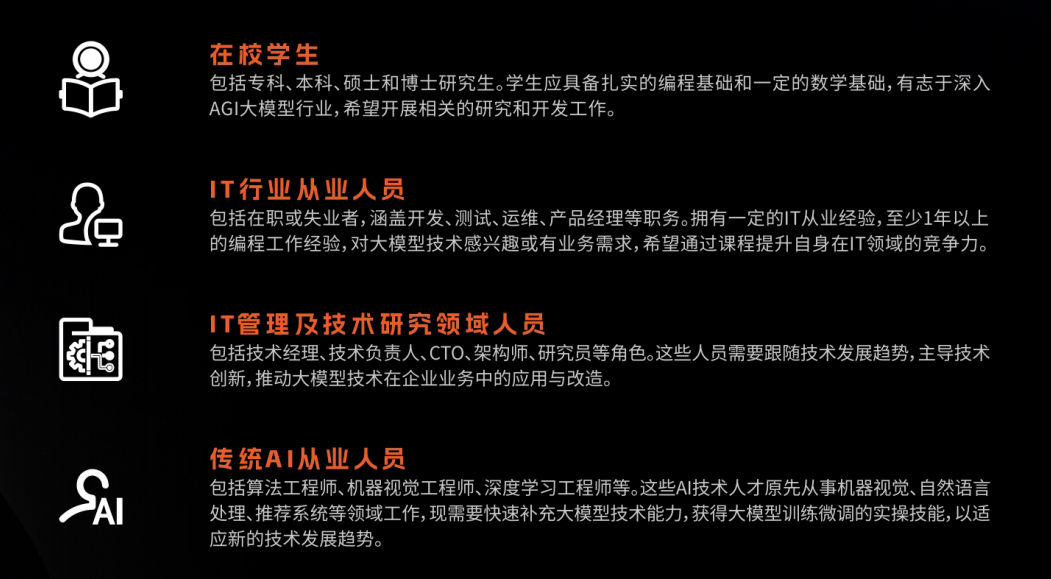

适合人群

- 在校学生:包括专科、本科、硕士和博士研究生。学生应具备扎实的编程基础和一定的数学基础,有志于深入AGI大模型行业,希望开展相关的研究和开发工作。

- IT行业从业人员:包括在职或失业者,涵盖开发、测试、运维、产品经理等职务。拥有一定的IT从业经验,至少1年以上的编程工作经验,对大模型技术感兴趣或有业务需求,希望通过课程提升自身在IT领域的竞争力。

- IT管理及技术研究领域人员:包括技术经理、技术负责人、CTO、架构师、研究员等角色。这些人员需要跟随技术发展趋势,主导技术创新,推动大模型技术在企业业务中的应用与改造。

- 传统AI从业人员:包括算法工程师、机器视觉工程师、深度学习工程师等。这些AI技术人才原先从事机器视觉、自然语言处理、推荐系统等领域工作,现需要快速补充大模型技术能力,获得大模型训练微调的实操技能,以适应新的技术发展趋势。

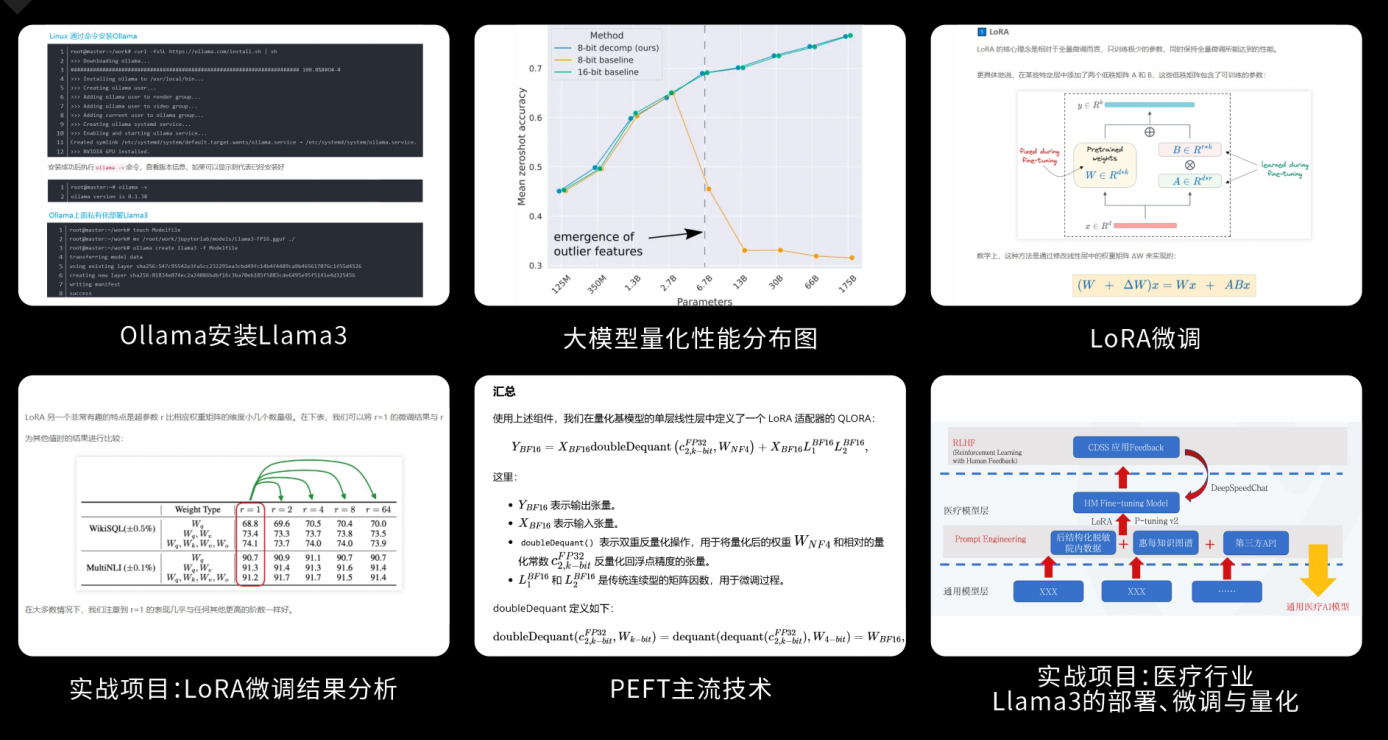

课程精彩瞬间

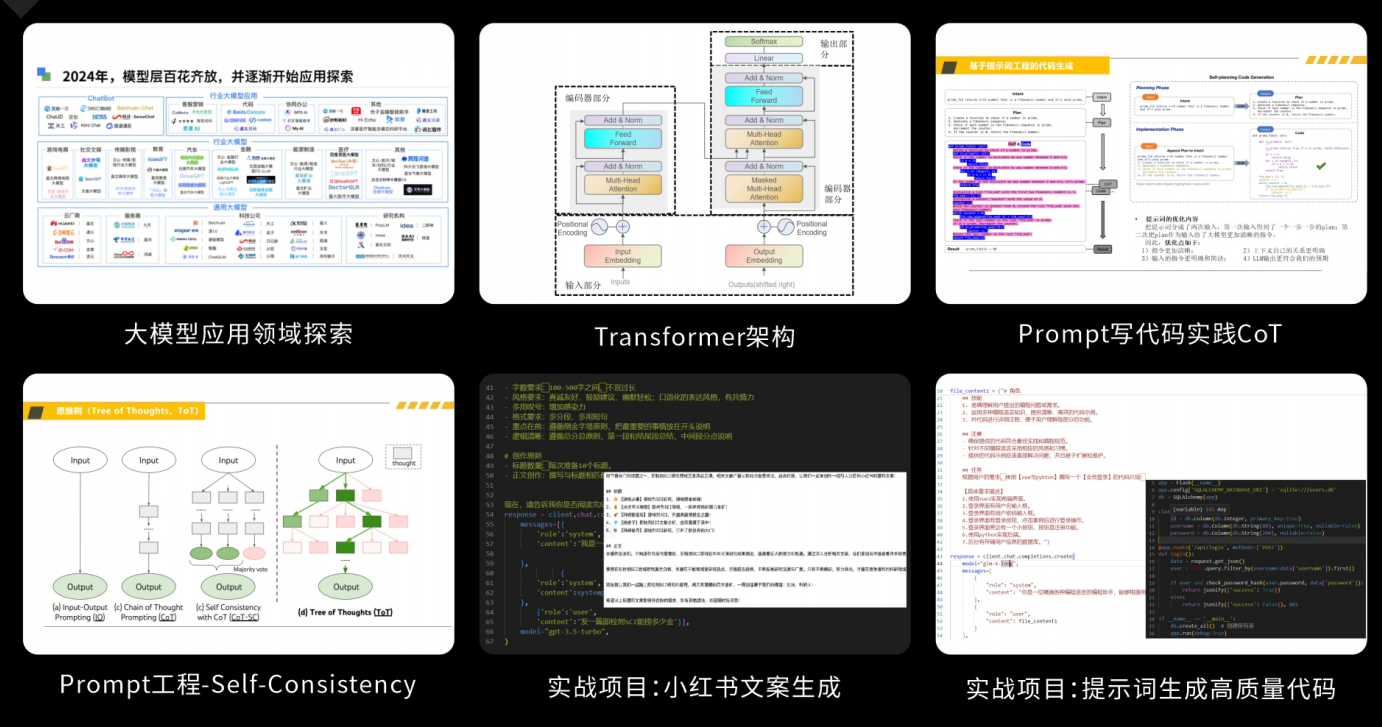

大模型核心原理与Prompt:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为Al应用开发打下坚实基础。

RAG应用开发工程:掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

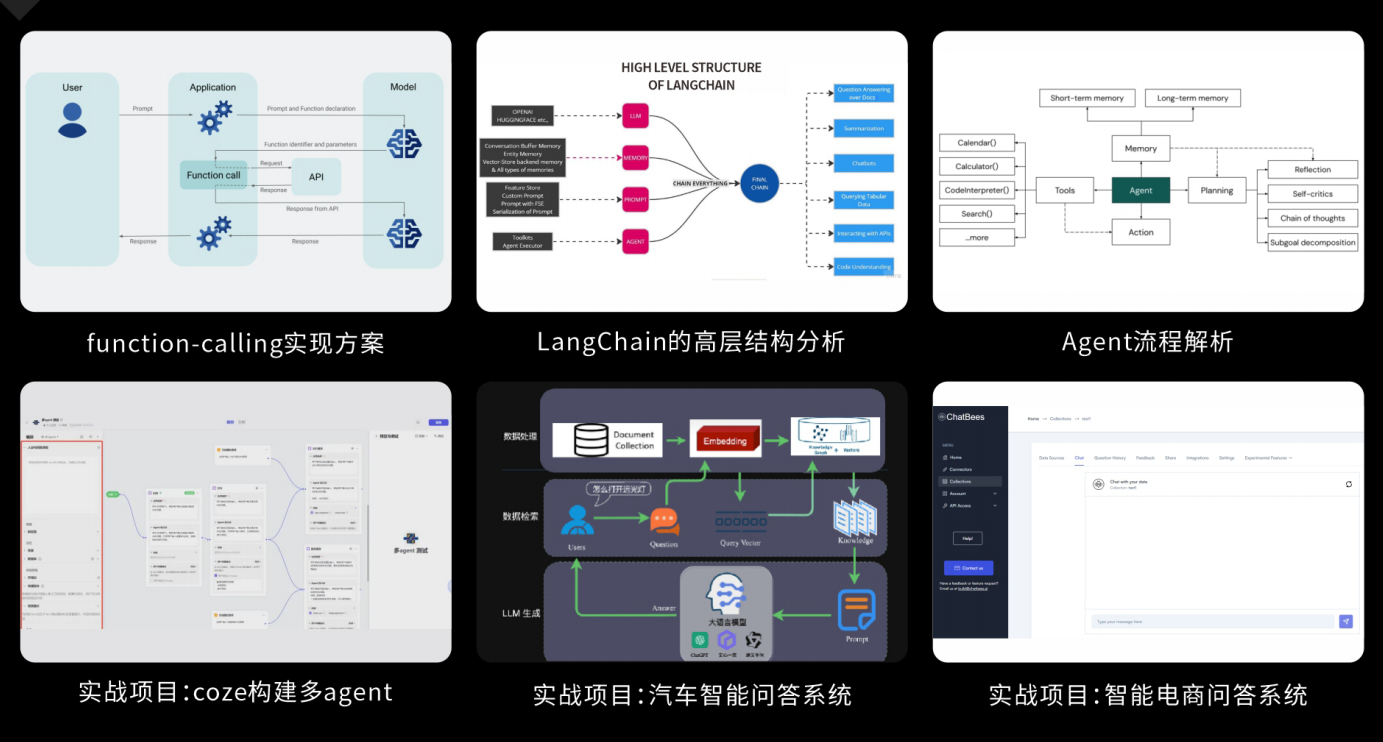

Agent应用架构进阶实践:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

模型微调与私有化大模型:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

顶尖师资,深耕AI大模型前沿技术

实战专家亲授,让你少走弯路

一对一学习规划,职业生涯指导

- 真实商业项目实训

- 大厂绿色直通车

人才库优秀学员参与真实商业项目实训

以商业交付标准作为学习标准,具备真实大模型项目实践操作经验可写入简历,支持项目背调

大厂绿色直通车,冲击行业高薪岗位

文中涉及到的完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

1126

1126

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?