一、FIO命令介绍

FIO(Flexible I/O Tester)是一个开源的、强大的I/O性能测试工具,可以用来对存储设备进行随机读写、顺序读写等负载测试。

FIO 功能包括多模式测试:支持顺序/随机读写、混合读写(可调比例如 70%读+30%写);参数灵活:可配置块大小(如 4K)、队列深度、线程数等;真实模拟:绕过系统缓存( direct=1),提供接近硬件的性能数据。

FIO文档地址:https://fio.readthedocs.io/en/latest/fio_doc.html

FIO下载地址:https://git.kernel.org/pub/scm/linux/kernel/git/axboe/fio.git

二、FIO 命令安装

1. 下载软件包

curl -O https://git.kernel.org/pub/scm/linux/kernel/git/axboe/fio.git/snapshot/fio-3.38.tar.gz

2. 编译安装

提前安装

libaio-dev后面使用libaio异步IO会使用到

./configure

make

make install

./fio --version

fio-3.38

3. 添加到系统环境

cp fio /usr/local/bin/

三、如何使用fio

fio [选项] [测试作业文件] ...

执行一个或多个作业文件,使用参数来决定如何执行作业文件,你也可以使用命令行来给出多个作业条目。

fio 不需要以 root 身份运行,除非作业部分指定的文件或设备有此要求。其他一些选项也可能受到限制,例如内存锁定、I/O 调度器切换以及降低 nice 值。

如果 测试作业文件 指定为 -,作业文件将从此标准输入中读取。

让 fio 模拟所需 I/O 工作负载的第一步是编写一个描述该特定设置的作业文件。作业文件可以包含任意数量的线程和/或文件——作业文件通常包含一个全局 部分定义共享参数,以及一个或多个作业部分描述涉及的 作业。运行时,fio 解析此文件并设置一切为 描述的。如果我们从上到下分解一个任务,它包含以下 基本参数:

I/O 类型:

定义向文件(夹)发出的 I/O 模式。我们可能只是从这个文件(夹)顺序读取,或者我们可能随机写入。甚至混合读取和写入,顺序或随机。我们应该进行缓冲 I/O,还是直接/原始 I/O?

块大小:

我们是以多大的数据块进行 I/O 操作?这可以是一个单一值,也可以描述一个块大小范围。

I/O 大小:

我们将读取/写入多少数据。

I/O 引擎:

我们如何发起 I/O?我们可以映射文件内存,使用常规的读写,使用 splice,异步 I/O,甚至 SG(SCSI 通用 sg)。

I/O 深度:

如果 I/O 引擎是异步的,我们希望维持多大的队列深度?

目标文件/设备:

我们要将工作负载分散到多少个文件上。

线程、进程和作业同步:

我们应该将这个工作负载分散到多少个线程或进程上。

四、命令行选项

fio [options] [job options] <job file(s)>

--debug=options 启用详细跟踪各种 fio 操作的 type。可以是 all 表示所有类型,或用逗号分隔的各个类型

--parse-only 仅解析选项,不启动任何 I/O。

--merge-blktrace-only 仅合并 blktraces,不启动任何 I/O

--output 将输出写入文件 filename。

--bandwidth-log 生成聚合带宽日志。

--minimal 以简洁的、分号分隔的格式打印统计信息。

--output-format=type 将报告的 格式 设置为 正常 、 简洁 、json 或 json+。可以选择多个格式,用逗号分隔。 简洁 是基于 CSV 的格式。json+ 类似于 json,但它会添加延迟桶的完整转储。

--terse-version=type 设置简洁的 版本 输出格式(默认为 3,或 2 或 4 或 5)。

--version 打印版本信息并退出。

--help 打印命令行选项的摘要并退出。

--cpuclock-test 执行内部 CPU 时钟的测试和验证。

--crctest=[type] 测试内置校验和函数的速度。如果没有提供参数,将测试所有函数。或者,可以传递一个逗号分隔的列表,此时将测试指定的函数。

--cmdhelp=cmd 打印 command 的帮助信息。可以是 all 以显示所有命令的帮助信息。

--enghelp=engine 列出由 ioengine 定义的命令,或打印 command 的帮助信息 由 ioengine 定义的命令。如果没有指定 ioengine,则列出所有可用的 ioengines。

--enghelp=engine,cmd 列出由 ioengine 定义的命令,或打印 command 的帮助信息 由 ioengine 定义的命令。如果没有指定 ioengine,则列出所有可用的 ioengines。

--showcmd 将给定的作业文件转换为一系列命令行选项。

--eta=when 指定实时 ETA 估计何时打印。when 可以是 always、never 或 auto。auto 是默认值,如果输出是 TTY,则在请求时打印 ETA。always 忽略输出类型,并在请求时打印 ETA。never 从不打印 ETA。

--eta-newline=t 强制在经过每个 time 时期后换行。当单位被省略时,值被解释为秒。

--status-interval=t 在 time 强制执行累计(从作业开始)值的完整状态转储 间隔。此选项不提供每周期测量。因此 诸如带宽之类的值是运行平均值。当省略时间单位时, time 以秒为单位解释。请注意,使用此选项时 --output-format=json 将生成技术上并非有效的 json 输出,因为输出将是有效 json 的集合。运行后需要将其拆分为有效的 json 集合。

--readonly 开启安全只读检查,防止写入和删除。 --readonly 选项是一个额外的安全防护措施,以防止用户 在不需要的时候意外启动写入或修剪工作负载。

--section=name 仅运行作业文件中指定的部分 namesections can be specified

--alloc-size=kb 分配额外的内部 smalloc 池,大小为 kb,单位为 KiB。 --alloc-size 选项会增加为 fio 预留的共享内存。如果运行启用 randommap 的大型任务,fio 可能会耗尽内存。Smalloc 是一个用于共享结构的内部分配器,它从固定大小的内存池中分配,最多可以扩展到 16 个池。池的大小默认为 16MiB。

--warnings-fatal 所有 fio 解析器警告都是致命的,会导致 fio 因错误而退出。

--max-jobs=nr 所有 fio 解析器警告都是致命的,会导致 fio 因错误而退出。

--server=args 启动一个后端服务器,使用 args 参数指定监听内容。参见 客户端/服务器 部分。

--daemonize=pidfile 在后台运行 fio 服务器,将进程 ID 写入指定的 pidfile 文件。

--client=hostname 与其在本地运行作业,请在给定的 hostname 上发送并运行它们 或者是一组 主机名

--remote-config=file 告诉 fio 服务器加载这个本地文件 。

--idle-prof=option 报告 CPU 空闲状态

--trigger-file=file 当 file 存在时执行触发命令

--trigger-timeout=t 在此时执行触发器。

--trigger=cmd 将此 命令 设置为本地触发器。

--trigger-remote=cmd 将此 command 设置为远程触发。

--aux-path=path 使用 path 指定的目录来生成状态文件,而不是当前工作目录。

五、作业文件格式

fio 接受一个或多个描述其预期操作的作业文件。作业文件格式是经典的 ini 文件,其中用[]括号括起来的名称定义作业名称。你可以自由使用任何 ASCII 名称,除了 global,它具有特殊含义。作业名称后面是一系列零个或多个参数,每行一个,定义作业的行为。如果一行中的第一个字符是‘;’或‘#’,则整行将被视为注释并丢弃。

一个 全局 部分为该文件中描述的任务设置默认值。任务可以覆盖 全局 部分参数,甚至任务文件中可以包含多个 如果需要,可以在全局部分中设置。一个作业只受其上方存在的全局部分的影响。

–cmdhelp 选项也会列出所有选项。如果与 命令 一起使用 参数,–cmdhelp 将详细说明给定的 命令 。

参考 examples/ 目录来获取编写作业文件的灵感。

那么让我们来看一个定义了两个进程的非常简单的作业文件,每个进程都随机从一个 128MiB 的文件中读取,没有指定输入文件,fio会自动创建job1和job2两个128m的文件:

; -- start job file --

[global]

rw=randread

size=128m

[job1]

[job2]

; -- end job file --

rw=randread: 随机读;更多选项:randwrite(随机写)、read(顺序读)、write(顺序写)、randrw(混合随机读写)size=128m:表示测试文件大小,FIO会将指定的文件大小全部读/写完成,然后才停止测试。

如您所见,作业文件部分本身是空的,因为所有描述的参数都是共享的。由于没有提供 filename 选项,fio 会根据其需要为每个作业生成 filename。在命令行中,该作业将如下所示:

fio --name=global --rw=randread --size=128m --name=job1 --name=job2

让我们看一个有多个进程随机写入文件到文件中的示例:

; -- start job file --

[random-writers]

ioengine=libaio

iodepth=4

rw=randwrite

bs=32k

direct=0

size=64m

numjobs=4

; -- end job file --

ioengine=libaio: FIO 测试时使用的 I/O 引擎为 libaio,这是一种异步 I/O 引擎。iodepth=4:表示测试时的 I/O 队列队深度为 4,即 FIO 控制的请求中的最大 I/O 个数为 4。rw=randwrite: 表示测试时的读写策略为随机写(random write)。bs=32k:表示 I/O 单元的块大小(block size)为 32KiB。块大小是 I/O 操作中数据传输的基本单位。direct=0:表示不使用 direct I/O,即数据会通过操作系统缓存进行写入。值为 1 时表示使用 direct I/O,忽略 I/O 缓存,数据直接写入磁盘。表示不使用 direct I/O,即数据会通过操作系统缓存进行写入。值为 1 时表示使用 direct I/O,忽略 I/O 缓存,数据直接写入磁盘。bs=32k:表示 I/O 单元的块大小(block size)为 32KiB。块大小是 I/O 操作中数据传输的基本单位。size=64m:表示测试文件大小为 64MB。FIO 会将指定的文件大小全部读/写完成,然后才停止测试。numjobs=4:表示测试的并发线程数为 4。默认值:1。

这里我们没有 全局 部分,因为我们只定义了一个作业。我们希望使用异步 I/O,每个文件深度为 4。我们还增加了缓冲区大小至 32KiB,并定义 numjobs 为 4 以创建 4 个相同的作业。结果是 4 个进程各自随机写入 64MiB 的文件。您可以选择使用上述作业文件,也可以在命令行上指定参数。对于这种情况,您需要指定:

没有指定文件,会生成4个

random-writers开头的文件,大小为64M

fio --name=random-writers --ioengine=libaio --iodepth=4 --rw=randwrite --bs=32k --direct=0 --size=64m --numjobs=4

六、五大核心场景(真实性能)

1. 随机读iops

作文文件:

[global]

filename=/dev/vdb # 指定文件

iodepth=32 # 队列深度

numjobs=4 # 并行进程个数

rw=randread # 随机读

bs=4k # 读大小

direct=1 # 直接IO

ioengine=libaio # 异步IO

runtime=60 # 测试时间为60s

time_based # 时间到自动结束

group_reporting # 将所有进程的输出汇总成一个输出

[randread]

命令格式:

fio -name=randread -filename=/dev/vdb -iodepth=32 -numjobs=4 -rw=randread -bs=4k -direct=1 -ioengine=libaio -runtime=60 -time_based -group_reporting

randread: (g=0): rw=randread, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=libaio, iodepth=32

...

fio-3.38

Starting 4 processes

Jobs: 4 (f=4): [r(4)][100.0%][r=171MiB/s][r=43.9k IOPS][eta 00m:00s]

randread: (groupid=0, jobs=4): err= 0: pid=24701: Mon Aug 4 02:20:18 2025

read: IOPS=40.0k, BW=156MiB/s (164MB/s)(9367MiB/60005msec)

slat (nsec): min=736, max=10119k, avg=7538.97, stdev=32931.58

clat (usec): min=33, max=132176, avg=3194.08, stdev=2182.35

lat (usec): min=181, max=132178, avg=3201.62, stdev=2182.61

clat percentiles (usec):

| 1.00th=[ 1172], 5.00th=[ 1565], 10.00th=[ 1795], 20.00th=[ 2114],

| 30.00th=[ 2343], 40.00th=[ 2606], 50.00th=[ 2835], 60.00th=[ 3130],

| 70.00th=[ 3458], 80.00th=[ 3884], 90.00th=[ 4686], 95.00th=[ 5538],

| 99.00th=[ 9503], 99.50th=[12780], 99.90th=[31851], 99.95th=[40633],

| 99.99th=[61604]

bw ( KiB/s): min=113332, max=205017, per=100.00%, avg=159865.60, stdev=5247.39, samples=476

iops : min=28331, max=51254, avg=39965.66, stdev=1311.88, samples=476

lat (usec) : 50=0.01%, 100=0.01%, 250=0.01%, 500=0.03%, 750=0.10%

lat (usec) : 1000=0.31%

lat (msec) : 2=16.10%, 4=65.29%, 10=17.30%, 20=0.62%, 50=0.23%

lat (msec) : 100=0.03%, 250=0.01%

cpu : usr=1.05%, sys=10.19%, ctx=349929, majf=0, minf=172

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued rwts: total=2398076,0,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=32

Run status group 0 (all jobs):

READ: bw=156MiB/s (164MB/s), 156MiB/s-156MiB/s (164MB/s-164MB/s), io=9367MiB (9823MB), run=60005-60005msec

Disk stats (read/write):

vdb: ios=2393770/0, sectors=19150160/0, merge=0/0, ticks=7329682/0, in_queue=7329682, util=100.00%

关键指标:

-

read: IOPS=40.0k, BW=156MiB/s (164MB/s)(9367MiB/60005msec)

iops为40.0k,带宽156MiB/s ,总共读了9367MiB,花了60005msec。

详细指标:

[global]

filename=/dev/vdb # 指定文件

iodepth=32 # 队列深度

numjobs=4 # 并行进程个数

rw=randread # 随机读

bs=4k # 读大小

direct=1 # 直接IO

ioengine=libaio # 异步IO

runtime=60 # 测试时间为60s

time_based # 时间到自动结束

group_reporting # 将所有进程的输出汇总成一个输出

[randread]

带宽

bw ( KiB/s): min=113332, max=205017, per=100.00%, avg=159865.60, stdev=5247.39, samples=476

最小:113332

最大:205017

平均:159865.60

IOPS

iops : min=28331, max=51254, avg=39965.66, stdev=1311.88, samples=476

最小:28331

最大:51254

平均:39965.66

延时:

usec:微秒

msec:毫秒

lat (usec) : 50=0.01%, 100=0.01%, 250=0.01%, 500=0.03%, 750=0.10%

lat (usec) : 1000=0.31%

lat (msec) : 2=16.10%, 4=65.29%, 10=17.30%, 20=0.62%, 50=0.23%

lat (msec) : 100=0.03%, 250=0.01%

如上可以看出在 2 毫秒的时候完成了 65.29%,大部分的io是在这个时间段处理完的。

2. 随机写 IOPS

作业文件:

[global]

filename=/dev/vdb # 指定文件

iodepth=32 # 队列深度

numjobs=4 # 并行进程个数

rw=randwrite # 随机写

bs=4k # 读大小

direct=1 # 直接IO

ioengine=libaio # 异步IO

runtime=60 # 测试时间为60s

time_based # 时间到自动结束

group_reporting # 将所有进程的输出汇总成一个输出

[randread]

命令行格式:

fio -name=randwrite -filename=/dev/vdb -iodepth=32 -numjobs=4 -rw=randwrite -bs=4k -direct=1 -ioengine=libaio -runtime=60 -time_based -group_reporting

randwrite: (g=0): rw=randwrite, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=libaio, iodepth=32

...

fio-3.38

Starting 4 processes

Jobs: 4 (f=4): [w(4)][16.7%][eta 07m:34s]

randwrite: (groupid=0, jobs=4): err= 0: pid=34117: Mon Aug 4 02:47:10 2025

write: IOPS=19.2k, BW=75.2MiB/s (78.8MB/s)(6781MiB/90210msec); 0 zone resets

slat (nsec): min=727, max=6430.5k, avg=9621.63, stdev=32487.91

clat (usec): min=78, max=30221k, avg=6570.56, stdev=255311.34

lat (usec): min=152, max=30221k, avg=6580.18, stdev=255311.36

clat percentiles (usec):

| 1.00th=[ 1418], 5.00th=[ 1909], 10.00th=[ 2212], 20.00th=[ 2704],

| 30.00th=[ 3097], 40.00th=[ 3490], 50.00th=[ 3851], 60.00th=[ 4228],

| 70.00th=[ 4686], 80.00th=[ 5276], 90.00th=[ 6194], 95.00th=[ 7570],

| 99.00th=[ 17433], 99.50th=[ 26608], 99.90th=[ 61604], 99.95th=[ 78119],

| 99.99th=[128451]

bw ( KiB/s): min=82529, max=186765, per=100.00%, avg=115623.57, stdev=5283.16, samples=480

iops : min=20630, max=46691, avg=28905.35, stdev=1320.81, samples=480

lat (usec) : 100=0.01%, 250=0.01%, 500=0.01%, 750=0.05%, 1000=0.11%

lat (msec) : 2=6.10%, 4=47.61%, 10=43.50%, 20=1.81%, 50=0.66%

lat (msec) : 100=0.14%, 250=0.02%, >=2000=0.01%

cpu : usr=0.65%, sys=6.35%, ctx=403662, majf=0, minf=42

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.1%, 32=100.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.1%, 64=0.0%, >=64=0.0%

issued rwts: total=0,1736030,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=32

Run status group 0 (all jobs):

WRITE: bw=75.2MiB/s (78.8MB/s), 75.2MiB/s-75.2MiB/s (78.8MB/s-78.8MB/s), io=6781MiB (7111MB), run=90210-90210msec

Disk stats (read/write):

vdb: ios=97/1736016, sectors=4264/13888128, merge=0/0, ticks=49/7593403, in_queue=7593452, util=76.87%

3. 顺序读

作业文件:

[global]

filename=/dev/vdb # 指定文件

iodepth=64 # 队列深度

numjobs=1 # 并行进程个数

rw=read # 顺序读

bs=4k # 读大小

direct=1 # 直接IO

ioengine=libaio # 异步IO

runtime=60 # 测试时间为60s

time_based # 时间到自动结束

group_reporting # 将所有进程的输出汇总成一个输出

[randread]

命令行:

fio -name=seqread -filename=/dev/vdb -iodepth=64 -numjobs=1 -rw=read -bs=1M -direct=1 -ioengine=libaio -runtime=60 -time_based -group_reporting

seqread: (g=0): rw=read, bs=(R) 1024KiB-1024KiB, (W) 1024KiB-1024KiB, (T) 1024KiB-1024KiB, ioengine=libaio, iodepth=64

fio-3.38

Starting 1 process

Jobs: 1 (f=1): [R(1)][100.0%][eta 00m:00s]

seqread: (groupid=0, jobs=1): err= 0: pid=35935: Mon Aug 4 02:51:58 2025

read: IOPS=273, BW=274MiB/s (287MB/s)(20.0GiB/74823msec)

slat (usec): min=9, max=7468, avg=62.72, stdev=184.46

clat (msec): min=4, max=30123, avg=230.67, stdev=2346.00

lat (msec): min=5, max=30123, avg=230.74, stdev=2346.00

clat percentiles (msec):

| 1.00th=[ 16], 5.00th=[ 21], 10.00th=[ 24], 20.00th=[ 28],

| 30.00th=[ 32], 40.00th=[ 35], 50.00th=[ 40], 60.00th=[ 45],

| 70.00th=[ 51], 80.00th=[ 59], 90.00th=[ 75], 95.00th=[ 97],

| 99.00th=[ 199], 99.50th=[17113], 99.90th=[17113], 99.95th=[17113],

| 99.99th=[17113]

bw ( MiB/s): min= 590, max= 1539, per=100.00%, avg=1315.56, stdev=215.26, samples=31

iops : min= 590, max= 1539, avg=1315.35, stdev=215.38, samples=31

lat (msec) : 10=0.13%, 20=3.72%, 50=64.94%, 100=26.60%, 250=3.77%

lat (msec) : 500=0.23%, 750=0.01%, >=2000=0.62%

cpu : usr=0.08%, sys=2.18%, ctx=4923, majf=0, minf=16394

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.2%, 32=0.3%, >=64=99.4%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.1%, >=64=0.0%

issued rwts: total=20482,0,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=64

Run status group 0 (all jobs):

READ: bw=274MiB/s (287MB/s), 274MiB/s-274MiB/s (287MB/s-287MB/s), io=20.0GiB (21.5GB), run=74823-74823msec

Disk stats (read/write):

vdb: ios=37178/0, sectors=41930752/0, merge=0/0, ticks=3244659/0, in_queue=3244659, util=91.17%

4. 循序写

文件作业:

[global]

filename=/dev/vdb # 指定文件

iodepth=64 # 队列深度

numjobs=1 # 并行进程个数

rw=write # 顺序写

bs=4k # 读大小

direct=1 # 直接IO

ioengine=libaio # 异步IO

runtime=60 # 测试时间为60s

time_based # 时间到自动结束

group_reporting # 将所有进程的输出汇总成一个输出

[randread]

命令行:

fio -name=seqwrite -filename=/dev/vdb -iodepth=64 -numjobs=1 -rw=write -bs=1M -direct=1 -ioengine=libaio -runtime=60 -time_based -group_reporting

eqwrite: (g=0): rw=write, bs=(R) 1024KiB-1024KiB, (W) 1024KiB-1024KiB, (T) 1024KiB-1024KiB, ioengine=libaio, iodepth=64

fio-3.38

Starting 1 process

Jobs: 1 (f=1): [W(1)][100.0%][w=1136MiB/s][w=1136 IOPS][eta 00m:00s]

seqwrite: (groupid=0, jobs=1): err= 0: pid=36904: Mon Aug 4 02:54:26 2025

write: IOPS=1054, BW=1054MiB/s (1105MB/s)(61.8GiB/60018msec); 0 zone resets

slat (usec): min=30, max=31050, avg=147.87, stdev=459.21

clat (msec): min=4, max=281, avg=60.54, stdev=12.37

lat (msec): min=4, max=281, avg=60.68, stdev=12.37

clat percentiles (msec):

| 1.00th=[ 31], 5.00th=[ 45], 10.00th=[ 48], 20.00th=[ 53],

| 30.00th=[ 55], 40.00th=[ 57], 50.00th=[ 60], 60.00th=[ 62],

| 70.00th=[ 65], 80.00th=[ 68], 90.00th=[ 75], 95.00th=[ 82],

| 99.00th=[ 102], 99.50th=[ 110], 99.90th=[ 126], 99.95th=[ 136],

| 99.99th=[ 264]

bw ( MiB/s): min= 822, max= 1316, per=100.00%, avg=1054.17, stdev=89.17, samples=119

iops : min= 822, max= 1316, avg=1053.80, stdev=89.17, samples=119

lat (msec) : 10=0.01%, 20=0.26%, 50=13.42%, 100=85.26%, 250=1.05%

lat (msec) : 500=0.01%

cpu : usr=4.49%, sys=12.97%, ctx=14256, majf=0, minf=9

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=0.2%, 32=0.4%, >=64=99.3%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.1%, >=64=0.0%

issued rwts: total=0,63260,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=64

Run status group 0 (all jobs):

WRITE: bw=1054MiB/s (1105MB/s), 1054MiB/s-1054MiB/s (1105MB/s-1105MB/s), io=61.8GiB (66.3GB), run=60018-60018msec

Disk stats (read/write):

vdb: ios=320/88450, sectors=13016/129193984, merge=0/0, ticks=14620/5303316, in_queue=5317936, util=99.92%

5. 随机读写

文件作业:

[global]

filename=/dev/vdb # 指定文件

iodepth=16 # 作业深度

numjobs=4 # 并发进程数

rw=randrw # 随机读写

rwmixread=70 # 读比例(写比例自动计算)

bs=16k # 块大小

direct=1 # 直接IO

ioengine=libaio # 异步IO模式

runtime=120 # 运行时间

time_based # 到时间自动结束

group_reporting # 所有进程输出汇总

[oltp]

命令行:

sudo fio -name=oltp -filename=/dev/vdb -iodepth=16 -numjobs=4 \

-rw=randrw -rwmixread=70 -bs=16k -direct=1 -ioengine=libaio \

-runtime=120 -time_based -group_reporting

oltp: (g=0): rw=randrw, bs=(R) 16.0KiB-16.0KiB, (W) 16.0KiB-16.0KiB, (T) 16.0KiB-16.0KiB, ioengine=libaio, iodepth=16

...

fio-3.38

Starting 4 processes

Jobs: 1 (f=1): [m(1),_(3)][93.8%][eta 00m:10s]

oltp: (groupid=0, jobs=4): err= 0: pid=37994: Mon Aug 4 02:58:56 2025

read: IOPS=11.4k, BW=178MiB/s (186MB/s)(26.1GiB/150489msec)

slat (nsec): min=839, max=9580.7k, avg=10602.32, stdev=40612.93

clat (usec): min=6, max=30489k, avg=3375.59, stdev=84037.42

lat (usec): min=147, max=30489k, avg=3386.20, stdev=84037.38

clat percentiles (usec):

| 1.00th=[ 848], 5.00th=[ 1319], 10.00th=[ 1631], 20.00th=[ 2024],

| 30.00th=[ 2311], 40.00th=[ 2573], 50.00th=[ 2802], 60.00th=[ 3064],

| 70.00th=[ 3359], 80.00th=[ 3818], 90.00th=[ 4621], 95.00th=[ 5669],

| 99.00th=[10552], 99.50th=[14484], 99.90th=[30278], 99.95th=[39060],

| 99.99th=[57410]

bw ( KiB/s): min=118391, max=307371, per=100.00%, avg=228255.61, stdev=7974.86, samples=957

iops : min= 7399, max=19210, avg=14265.23, stdev=498.40, samples=957

write: IOPS=4890, BW=76.4MiB/s (80.1MB/s)(11.2GiB/150489msec); 0 zone resets

slat (nsec): min=869, max=5083.1k, avg=11754.93, stdev=42017.03

clat (usec): min=15, max=30489k, avg=3163.08, stdev=50299.53

lat (usec): min=153, max=30489k, avg=3174.84, stdev=50299.48

clat percentiles (usec):

| 1.00th=[ 807], 5.00th=[ 1287], 10.00th=[ 1598], 20.00th=[ 1991],

| 30.00th=[ 2278], 40.00th=[ 2507], 50.00th=[ 2769], 60.00th=[ 2999],

| 70.00th=[ 3326], 80.00th=[ 3752], 90.00th=[ 4555], 95.00th=[ 5473],

| 99.00th=[10159], 99.50th=[13960], 99.90th=[28967], 99.95th=[37487],

| 99.99th=[56361]

bw ( KiB/s): min=50749, max=137297, per=100.00%, avg=98134.11, stdev=3538.52, samples=957

iops : min= 3171, max= 8579, avg=6132.59, stdev=221.12, samples=957

lat (usec) : 10=0.01%, 20=0.01%, 50=0.01%, 100=0.01%, 250=0.01%

lat (usec) : 500=0.12%, 750=0.53%, 1000=1.28%

lat (msec) : 2=17.57%, 4=63.89%, 10=15.50%, 20=0.85%, 50=0.23%

lat (msec) : 100=0.02%, 250=0.01%, >=2000=0.01%

cpu : usr=1.03%, sys=7.12%, ctx=495320, majf=0, minf=52

IO depths : 1=0.1%, 2=0.1%, 4=0.1%, 8=0.1%, 16=100.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.1%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwts: total=1711959,736026,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=16

Run status group 0 (all jobs):

READ: bw=178MiB/s (186MB/s), 178MiB/s-178MiB/s (186MB/s-186MB/s), io=26.1GiB (28.0GB), run=150489-150489msec

WRITE: bw=76.4MiB/s (80.1MB/s), 76.4MiB/s-76.4MiB/s (80.1MB/s-80.1MB/s), io=11.2GiB (12.1GB), run=150489-150489msec

Disk stats (read/write):

vdb: ios=1712050/736026, sectors=54786408/23552832, merge=0/0, ticks=5183418/2182049, in_queue=7365467, util=79.89%

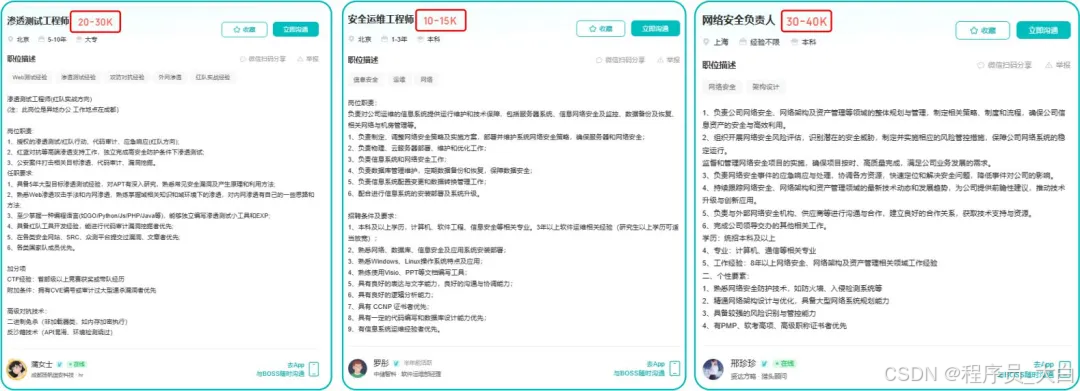

这两年,IT行业面临经济周期波动与AI产业结构调整的双重压力,确实有很多运维与网络工程师因企业缩编或技术迭代而暂时失业。

很多人都在提运维网工失业后就只能去跑滴滴送外卖了,但我想分享的是,对于运维人员来说,即便失业以后仍然有很多副业可以尝试。

网工/运维/测试副业方向

运维网工,千万不要再错过这些副业机会!

第一个是知识付费类副业:输出经验打造个人IP

在线教育平台讲师

操作路径:在慕课网、极客时间等平台开设《CCNA实战》《Linux运维从入门到精通》等课程,或与培训机构合作录制专题课。

收益模式:课程销售分成、企业内训。

技术博客与公众号运营

操作路径:撰写网络协议解析、故障排查案例、设备评测等深度文章,通过公众号广告、付费专栏及企业合作变现。

收益关键:每周更新2-3篇原创,结合SEO优化与社群运营。

第二个是技术类副业:深耕专业领域变现

企业网络设备配置与优化服务

操作路径:为中小型企业提供路由器、交换机、防火墙等设备的配置调试、性能优化及故障排查服务。可通过本地IT服务公司合作或自建线上接单平台获客。

收益模式:按项目收费或签订年度维护合同。

远程IT基础设施代维

操作路径:通过承接服务器监控、日志分析、备份恢复等远程代维任务。适合熟悉Zabbix、ELK等技术栈的工程师。

收益模式:按工时计费或包月服务。

网络安全顾问与渗透测试

操作路径:利用OWASP Top 10漏洞分析、Nmap/BurpSuite等工具,为企业提供漏洞扫描、渗透测试及安全加固方案。需考取CISP等认证提升资质。

收益模式:单次渗透测试报告收费;长期安全顾问年费。

比如不久前跟我一起聊天的一个粉丝,他自己之前是大四实习的时候做的运维,发现运维7*24小时待命受不了,就准备转网安,学了差不多2个月,然后开始挖漏洞,光是补天的漏洞奖励也有个四五千,他说自己每个月的房租和饭钱就够了。

为什么我会推荐你网安是运维和网工测试人员的绝佳副业&转型方向?

1.你的经验是巨大优势: 你比任何人都懂系统、网络和架构。漏洞挖掘、内网渗透、应急响应,这些核心安全能力本质上是“攻击视角下的运维”。你的运维背景不是从零开始,而是降维打击。

2.越老越吃香,规避年龄危机: 安全行业极度依赖经验。你的排查思路、风险意识和对复杂系统的理解能力,会随着项目积累而愈发珍贵,真正做到“姜还是老的辣”。

3.职业选择极其灵活: 你可以加入企业成为安全专家,可以兼职“挖洞“获取丰厚奖金,甚至可以成为自由顾问。这种多样性为你提供了前所未有的抗风险能力。

4.市场需求爆发,前景广阔: 在国家级政策的推动下,从一线城市到二三线地区,安全人才缺口正在急剧扩大。现在布局,正是抢占未来先机的黄金时刻。

网工运维测试转行学习网络安全路线

(一)第一阶段:网络安全筑基

1. 阶段目标

你已经有运维经验了,所以操作系统、网络协议这些你不是零基础。但要学安全,得重新过一遍——只不过这次我们是带着“安全视角”去学。

2. 学习内容

**操作系统强化:**你需要重点学习 Windows、Linux 操作系统安全配置,对比运维工作中常规配置与安全配置的差异,深化系统安全认知(比如说日志审计配置,为应急响应日志分析打基础)。

**网络协议深化:**结合过往网络协议应用经验,聚焦 TCP/IP 协议簇中的安全漏洞及防护机制,如 ARP 欺骗、TCP 三次握手漏洞等(为 SRC 漏扫中协议层漏洞识别铺垫)。

**Web 与数据库基础:**补充 Web 架构、HTTP 协议及 MySQL、SQL Server 等数据库安全相关知识,了解 Web 应用与数据库在网安中的作用。

**编程语言入门:**学习 Python 基础语法,掌握简单脚本编写,为后续 SRC 漏扫自动化脚本开发及应急响应工具使用打基础。

**工具实战:**集中训练抓包工具(Wireshark)、渗透测试工具(Nmap)、漏洞扫描工具(Nessus 基础版)的使用,结合模拟场景练习工具应用(掌握基础扫描逻辑,为 SRC 漏扫工具进阶做准备)。

(二)第二阶段:漏洞挖掘与 SRC 漏扫实战

1. 阶段目标

这阶段是真正开始“动手”了。信息收集、漏洞分析、工具联动,一样不能少。

熟练运用漏洞挖掘及 SRC 漏扫工具,具备独立挖掘常见漏洞及 SRC 平台漏扫实战能力,尝试通过 SRC 挖洞搞钱,不管是低危漏洞还是高危漏洞,先挖到一个。

2. 学习内容

信息收集实战:结合运维中对网络拓扑、设备信息的了解,强化基本信息收集、网络空间搜索引擎(Shodan、ZoomEye)、域名及端口信息收集技巧,针对企业级网络场景开展信息收集练习(为 SRC 漏扫目标筛选提供支撑)。

漏洞原理与分析:深入学习 SQL 注入、CSRF、文件上传等常见漏洞的原理、危害及利用方法,结合运维工作中遇到的类似问题进行关联分析(明确 SRC 漏扫重点漏洞类型)。

工具进阶与 SRC 漏扫应用:

-

系统学习 SQLMap、BurpSuite、AWVS 等工具的高级功能,开展工具联用实战训练;

-

专项学习 SRC 漏扫流程:包括 SRC 平台规则解读(如漏洞提交规范、奖励机制)、漏扫目标范围界定、漏扫策略制定(全量扫描 vs 定向扫描)、漏扫结果验证与复现;

-

实战训练:使用 AWVS+BurpSuite 组合开展 SRC 平台目标漏扫,练习 “扫描 - 验证 - 漏洞报告撰写 - 平台提交” 全流程。

SRC 实战演练:选择合适的 SRC 平台(如补天、CNVD)进行漏洞挖掘与漏扫实战,积累实战经验,尝试获取挖洞收益。

恭喜你,如果学到这里,你基本可以下班搞搞副业创收了,并且具备渗透测试工程师必备的「渗透技巧」、「溯源能力」,让你在黑客盛行的年代别背锅,工作实现升职加薪的同时也能开创副业创收!

如果你想要入坑黑客&网络安全,笔者给大家准备了一份:全网最全的网络安全资料包需要保存下方图片,微信扫码即可前往获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

优快云大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

(三)第三阶段:渗透测试技能学习

1. 阶段目标

全面掌握渗透测试理论与实战技能,能够独立完成渗透测试项目,编写规范的渗透测试报告,具备渗透测试工程师岗位能力,为护网红蓝对抗及应急响应提供技术支撑。

2. 学习内容

渗透测试核心理论:系统学习渗透测试流程、方法论及法律法规知识,明确渗透测试边界与规范(与红蓝对抗攻击边界要求一致)。

实战技能训练:开展漏洞扫描、漏洞利用、电商系统渗透测试、内网渗透、权限提升(Windows、Linux)、代码审计等实战训练,结合运维中熟悉的系统环境设计测试场景(强化红蓝对抗攻击端技术能力)。

工具开发实践:基于 Python 编程基础,学习渗透测试工具开发技巧,开发简单的自动化测试脚本(可拓展用于 SRC 漏扫自动化及应急响应辅助工具)。

报告编写指导:学习渗透测试报告的结构与编写规范,完成多个不同场景的渗透测试报告撰写练习(与 SRC 漏洞报告、应急响应报告撰写逻辑互通)。

(四)第四阶段:企业级安全攻防(含红蓝对抗)、应急响应

1. 阶段目标

掌握企业级安全攻防、护网红蓝对抗及应急响应核心技能,考取网安行业相关证书。

2. 学习内容

护网红蓝对抗专项:

-

红蓝对抗基础:学习护网行动背景、红蓝对抗规则(攻击范围、禁止行为)、红蓝双方角色职责(红队:模拟攻击;蓝队:防御检测与应急处置);

-

红队实战技能:强化内网渗透、横向移动、权限维持、免杀攻击等高级技巧,模拟护网中常见攻击场景;

-

蓝队实战技能:学习安全设备(防火墙、IDS/IPS、WAF)联动防御配置、安全监控平台(SOC)使用、攻击行为研判与溯源方法;

-

模拟护网演练:参与团队式红蓝对抗演练,完整体验 “攻击 - 检测 - 防御 - 处置” 全流程。

应急响应专项: -

应急响应流程:学习应急响应 6 步流程(准备 - 检测 - 遏制 - 根除 - 恢复 - 总结),掌握各环节核心任务;

-

实战技能:开展操作系统入侵响应(如病毒木马清除、异常进程终止)、数据泄露应急处置、漏洞应急修补等实战训练;

-

工具应用:学习应急响应工具(如 Autoruns、Process Monitor、病毒分析工具)的使用,提升处置效率;

-

案例复盘:分析真实网络安全事件应急响应案例(如勒索病毒事件),总结处置经验。

其他企业级攻防技能:学习社工与钓鱼、CTF 夺旗赛解析等内容,结合运维中企业安全防护需求深化理解。

证书备考:针对网安行业相关证书考试内容(含红蓝对抗、应急响应考点)进行专项复习,参加模拟考试,查漏补缺。

运维网工测试转行网络攻防知识库分享

网络安全这行,不是会几个工具就能搞定的。你得有体系,懂原理,能实战。尤其是从运维转过来的,别浪费你原来的经验——你比纯新人强多了。

但也要沉得住气,别学了两天Web安全就觉得自己是黑客了。内网、域渗透、代码审计、应急响应,要学的还多着呢。

如果你真的想转,按这个路子一步步走,没问题。如果你只是好奇,我劝你再想想——这行要持续学习,挺累的,但也是真有意思。

关于如何学习网络安全,笔者也给大家整理好了全套网络安全知识库,需要的可以扫码获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

优快云大礼包:《黑客&网络安全入门&进阶学习资源包》免费分享

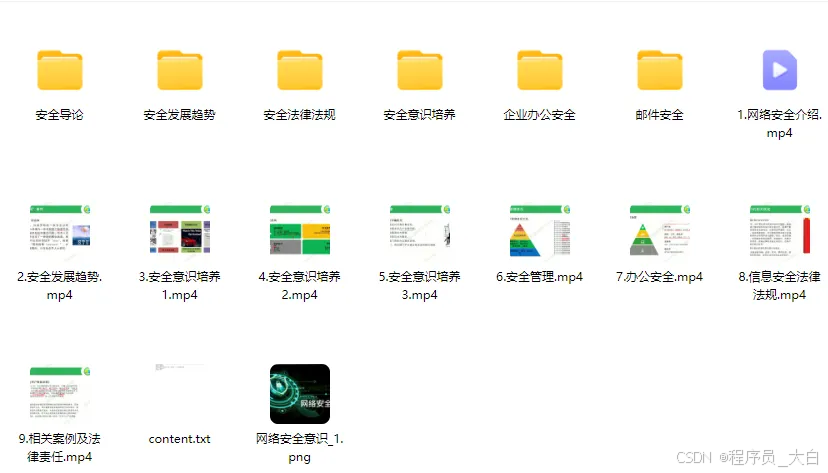

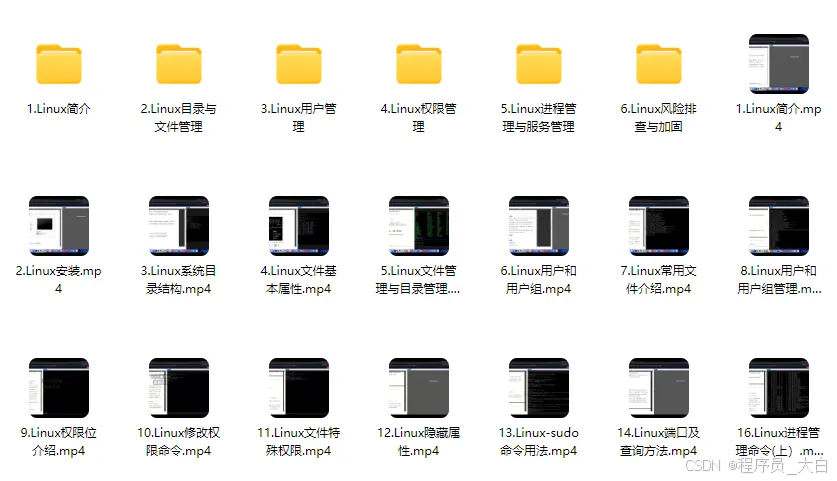

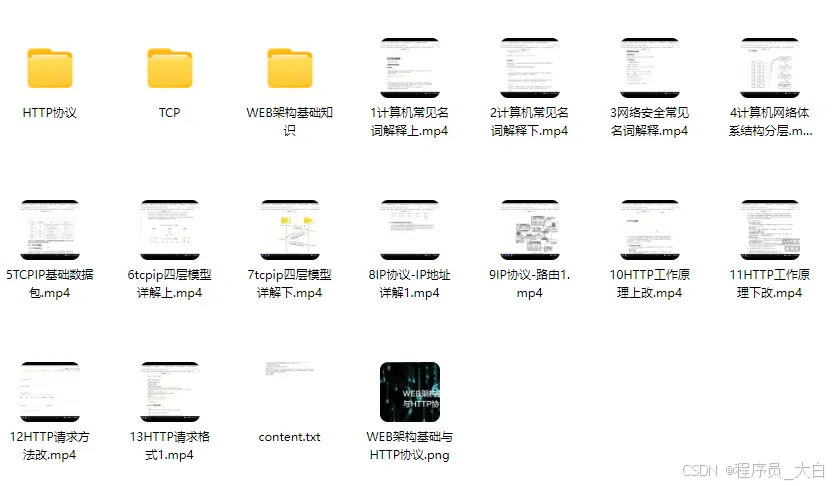

1、网络安全意识

2、Linux操作系统

3、WEB架构基础与HTTP协议

4、Web渗透测试

5、渗透测试案例分享

6、渗透测试实战技巧

7、攻防对战实战

8、CTF之MISC实战讲解

关于如何学习网络安全,笔者也给大家整理好了全套网络安全知识库,需要的可以扫码获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取

995

995

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?