PAL(Program-Aided Language models) 思想成为大模型 Agent 领域的重要范式。核心思路是 LLM 只负责语言任务,复杂的逻辑/计算交由程序执行。

通过合理设计 prompt,模型生成代码/SQL/逻辑描述,外部程序再执行,得到结果后反馈给 LLM,LLM 再生成最终答案。

本文将通过一个 LangChain + MySQL + Postgres Checkpoint 实例,完整演示 PAL 的设计流程,帮助大家理解和复现。

项目结构

.

├── llm_env.py # 初始化 LLM

└── main.py # PAL 交互主流程

llm_env.py:初始化 LLM

from langchain.chat_models import init_chat_model

llm = init_chat_model("gpt-4o-mini", model_provider="openai")

简单封装一个 LLM 对象,这里用 gpt-4o-mini,通过 llm_env.llm 调用。

main.py:PAL 主流程

导入库 & 初始化

import os

import sys

sys.path.append(os.getcwd())

from langchain_community.utilities import SQLDatabase

from langchain_core.prompts import ChatPromptTemplate

from langchain_community.tools.sql_database.tool import QuerySQLDatabaseTool

from langgraph.graph import START, StateGraph

from langgraph.checkpoint.postgres import PostgresSaver

import time

from typing import TypedDict, Annotated

from llm_set import llm_env

llm = llm_env.llm

亮点:

-

用

StateGraph组织整个流程 -

用

PostgresSaver持久化 checkpoint,方便中断恢复

初始化 MySQL 数据库

db = SQLDatabase.from_uri(

"mysql+pymysql://root:123456@localhost:3306/javademo",

engine_args={"pool_size": 5, "max_overflow": 10},

)

数据库连接,示例用 javademo 库,用户可根据实际修改。

State 定义

class State(TypedDict):

"""State for the demo."""

question: str

query: str

result: str

answer: str

approved: bool

定义流程中的共享变量,典型 PAL 模式的中间态。

Prompt 设计

system_message = """

Given an input question, create a syntactically correct {dialect} query to

run to help find the answer. Unless the user specifies in his question a

specific number of examples they wish to obtain, always limit your query to

at most {top_k} results. You can order the results by a relevant column to

return the most interesting examples in the database.

Never query for all the columns from a specific table, only ask for a the

few relevant columns given the question.

Pay attention to use only the column names that you can see in the schema

description. Be careful to not query for columns that do not exist. Also,

pay attention to which column is in which table.

Only use the following tables:

{table_info}

"""

user_prompt = "Question:{input}"

query_prompt_template = ChatPromptTemplate(

[("system", system_message), ("human", user_prompt)],

)

亮点:

-

系统提示明确要求 安全、规范 的 SQL

-

限定

top_k结果 -

避免

SELECT *

LLM 生成 SQL

class QueryOutput(TypedDict):

"""Generated the SQL query."""

query: Annotated[str, "Syntactically valid SQL query."]

def write_query(state: State):

"""Generate SQL query to fetch information."""

prompt = query_prompt_template.invoke(

{

"dialect": db.dialect,

"top_k": 5,

"table_info": db.get_table_info(),

"input": state["question"],

}

)

structured_llm = llm.with_structured_output(QueryOutput)

result = structured_llm.invoke(prompt)

return {"query": result["query"]}

PAL 核心步骤 1

LLM 不直接回答问题,而是生成 SQL 查询。

用户确认

def wait_for_user_approve(state: State):

"""Pause here and wait for user approval before executing query."""

try:

user_approval = input("Do you want to go to execute query? (yes/no): ")

except Exception:

user_approval = "no"

if user_approval.lower() == "yes":

return {

"query": state["query"],

"approved": True,

}

else:

return {

"query": state["query"],

"approved": False,

}

用户确认 SQL 是否执行,保证安全性 —— 很关键。

执行 SQL

def excute_query(state: State):

"""Execute the SQL query and return the result."""

if state["approved"]:

execute_query_tool = QuerySQLDatabaseTool(db=db)

return {"result": execute_query_tool.invoke(state["query"])}

else:

return {"result": "excute denied."}

PAL 核心步骤 2

SQL 执行交给程序完成,LLM 不直接操作数据库。

回答用户

def generate_answer(state: State):

"""Answer question using retrieved information as context."""

if state["approved"]:

prompt = (

"Given the following user question, corresponding SQL query, "

"and SQL result, answer the user question.\n\n"

f'Question: {state["question"]}\n'

f'SQL Query: {state["query"]}\n'

f'SQL Result: {state["result"]}'

)

response = llm.invoke(prompt)

return {"answer": response.content}

else:

prompt = f'{"同意" if state["approved"] else "拒绝"} 用户拒绝当前执行'

response = llm.invoke(prompt)

return {"answer": response.content}

PAL 核心步骤 3

LLM 根据 SQL 结果生成最终自然语言答案。

流程图

graph_builder = StateGraph(State).add_sequence(

[write_query, wait_for_user_approve, excute_query, generate_answer]

)

graph_builder.add_edge(START, "write_query")

用 LangGraph 编排整个 PAL 流程。

持久化 checkpoint + 启动循环

DB_URI = "postgresql://postgres:123456@localhost:5432/langchaindemo?sslmode=disable"

with PostgresSaver.from_conn_string(DB_URI) as checkpointer:

checkpointer.setup()

input_thread_id = input("输入thread_id:")

time_str = time.strftime("%Y%m%d", time.localtime())

config = {"configurable": {"thread_id": f"{time_str}-{input_thread_id}-agent-demo"}}

graph = graph_builder.compile(checkpointer=checkpointer)

print("输入问题,输入 exit 退出。")

while True:

query = input("你: ")

if query.strip().lower() == "exit":

break

response = graph.invoke(

{"question": query},

config,

)

print(response)

-

Checkpoint 存入 Postgres

-

用户可断点续跑

-

CLI 交互友好

总结:PAL 模式的好处

1.LLM 不做逻辑执行,只负责「写程序」

2.复杂逻辑交给程序完成,结果回传给 LLM

3.SQL 查询避免安全风险

4.有明确「用户确认」步骤

5.checkpoint 持久化,支持中断恢复

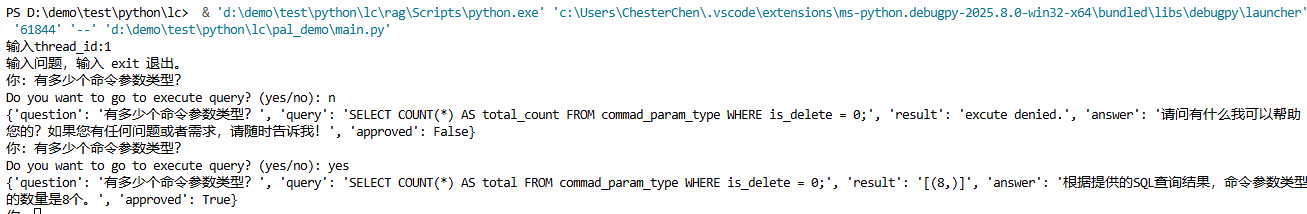

运行效果示例

2024最新版优快云大礼包:《AGI大模型学习资源包》免费分享**

一、2025最新大模型学习路线

一个明确的学习路线可以帮助新人了解从哪里开始,按照什么顺序学习,以及需要掌握哪些知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1级别:AI大模型时代的华丽登场

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理,关键技术,以及大模型应用场景;通过理论原理结合多个项目实战,从提示工程基础到提示工程进阶,掌握Prompt提示工程。

L2级别:AI大模型RAG应用开发工程

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3级别:大模型Agent应用架构进阶实践

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体;同时还可以学习到包括Coze、Dify在内的可视化工具的使用。

L4级别:大模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

整个大模型学习路线L1主要是对大模型的理论基础、生态以及提示词他的一个学习掌握;而L3 L4更多的是通过项目实战来掌握大模型的应用开发,针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

二、大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

三、大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

四、大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

五、大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取