论文名称:An Attention-based Graph Neural Network for Heterogeneous Structural Learning

论文ArXiv下载地址:https://arxiv.org/abs/1912.10832

论文AAAI官方下载地址:https://ojs.aaai.org/index.php/AAAI/article/view/5833/5689

官方GitHub项目:didi/hetsann: Source Codes of HetSANN in the AAAI’20 paper: An Attention-based Graph Nerual Network for Heterogeneous Structural Learning.

本文是2020年AAAI论文,作者来自滴滴和北大。

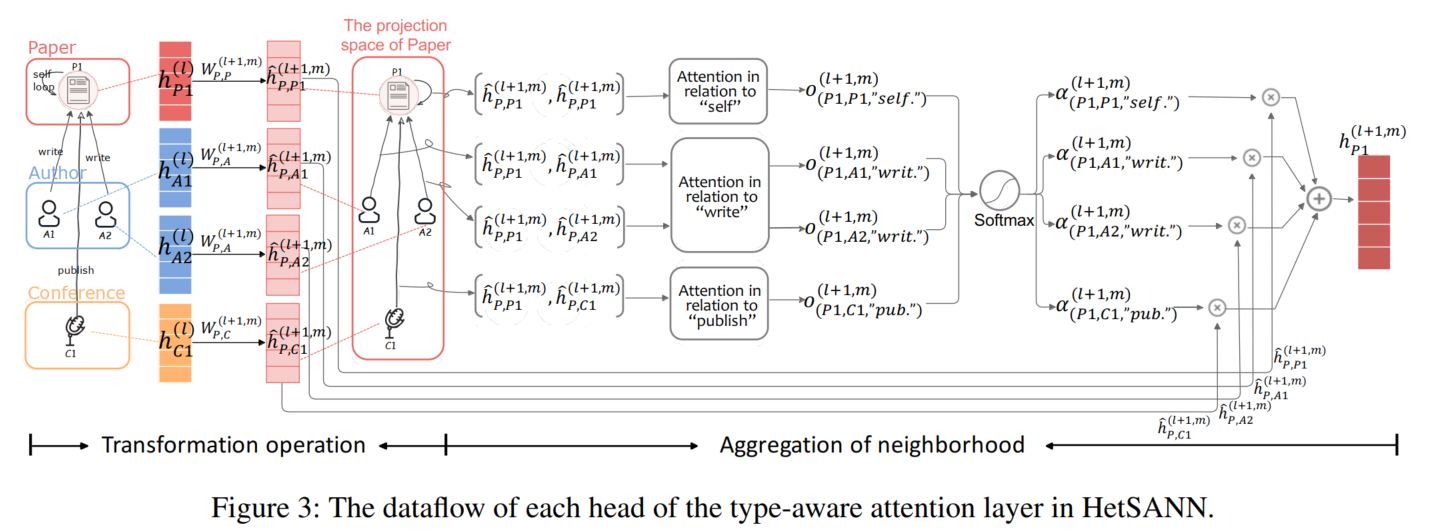

本文提出的模型 Heterogeneous Graph Structural Attention Neural Network (HetSANN) 使用基于关系类型的attention机制(差不多就是一个关系一个attention这种感觉)来实现多关系信息的聚合,这样就不用metapath信息了。

但问题是看Simple-HGN论文1,HetSANN这个模型的真实表现差得离谱啊……

文章目录

1. Background & Motivation

现存的异质图神经网络往往都是通过meta-paths将异质图做成同质图:

使用meta-path的方法有2个缺点:

- meta-path的scheme需要专家定义,而且很难手工遍历和选择所有有价值的meta-path schemes

(第二点我没搞懂啊,你这啥意思啊)

(第二点我没搞懂啊,你这啥意思啊)

2. HetSANN

transformation + attention-based aggregation

2.1 Type-aware Attention Layer (TAL)

an adaptation layer of GNNs

在局部图邻居上做convolution operation

先在每个节点上加个自环(该节点类别)

每个节点有一个cold start state h i ( 0 ) \mathbf{h}_i^{(0)} hi(0)(可以是attributes或者 dummy features(零向量或者独热编码向量))

multi-head attention mechanism

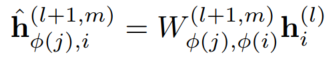

Transformation Operation (C1)

对目标节点所有邻居做线性转换:

Aggregation of Neighborhood (C2)

每条边的注意力系数:

σ

\sigma

σ是LeadkyReLU

concat product:

多头机制:

残差机制:

2.2 Model Training and Three Extensions

用节点表征做节点分类任务,交叉熵:

2.2.1 E1: Multi-task Learning

2.2.2 E2: Voices-sharing Product

大致来说是强制关系和反关系的attention系数相反、机制满足特定要求。

2.2.3 E3: Cycle-consistency Loss

灵感来源于翻译领域的trick back translation and reconciliation

就是说这个节点它transform一圈转回来还应该是它自己

实现细节略

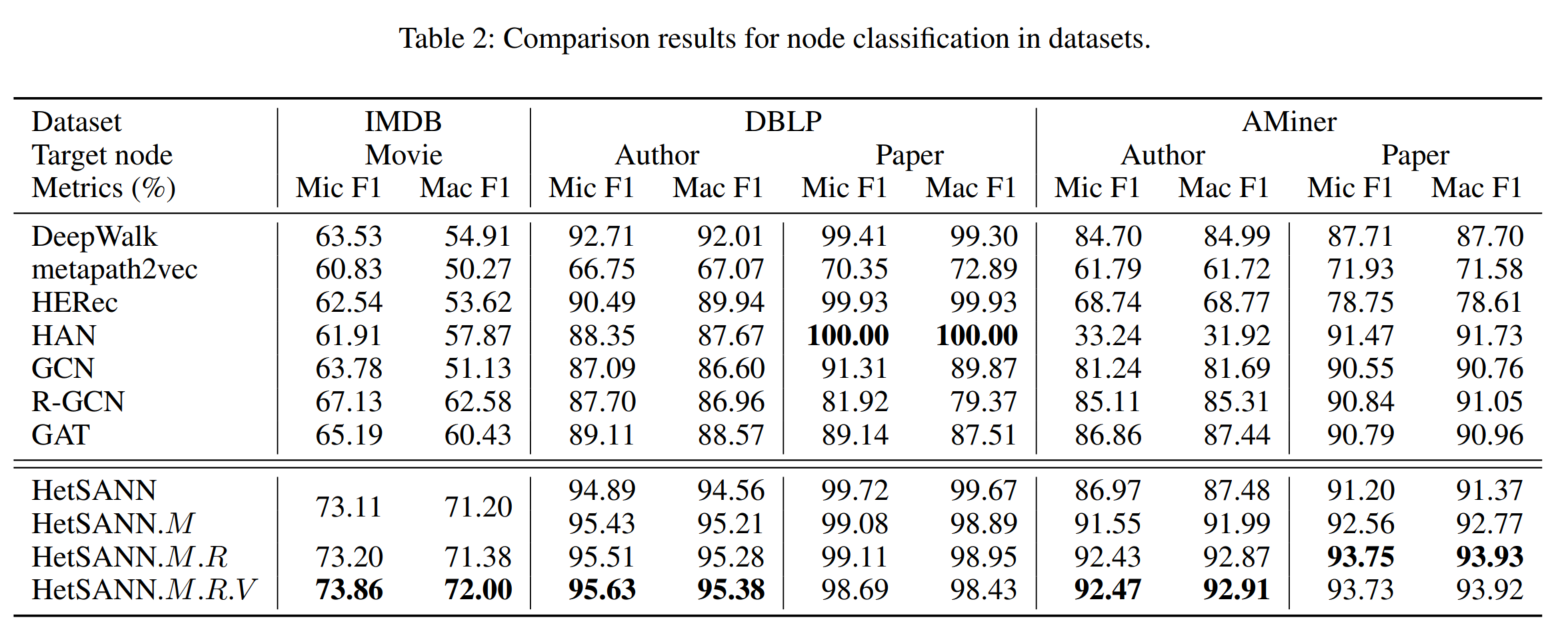

3. 实验

细节略,待补。

3.1 数据集

3.2 baseline

3.3 实验设置

3.4 主实验结果和Ablation Study

3.5 其他模型分析

4. 代码复现

等我服务器好了再说。

1197

1197

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?