从硬件普惠化、智能算法突破、数据基建支撑、开源生态协同四大核心维度,解析迭代加速的底层逻辑。

1.技术架构总览

采用 “大小脑融合” 核心架构,整合多传感融合感知、深度学习决策、实时运动控制三大核心模块,硬件层面实现算力一体化,软件层面构建 “感知算法 - 模型推理 - 运动执行” 闭环,开源技术贯穿全开发流程以降低落地门槛。

2. 硬件系统实现

2.1 核心算力单元(大小脑融合方案)

2.1.1 架构选型

采用单 SoC 融合架构(替代传统双系统方案),解决算力传输延迟、体积过大等痛点,推荐两种技术路线:

-

高端路线:英特尔酷睿 Ultra 处理器(CPU+GPU+NPU 异构集成),提供 90TOPS NPU 算力 + 203TOPS GPU 算力,支持共享内存架构,延迟降低 40% 以上,功耗覆盖 28W-65W,适配复杂场景深度学习推理与实时控制。

-

国产方案:地平线 RDK S100 开发套件,搭载 6 核 Arm Cortex-A78AE CPU(100K DMIPS)+80TOPS BPU,搭配 4 核 Cortex-R52 实时控制核,支持大小模型动态融合,满足决策与运动控制双重需求。

2.1.2 辅助算力扩展

-

边缘加速:瑞芯微 RK3588 SoC(6TOPS NPU),负责多传感器数据预处理(如 RGBD 图像降噪、激光雷达点云压缩),适配优必选 Walker X 等机器人的动态运动规划需求。

-

接口扩展:通过 PCIe 4.0 扩展 GPU(如 NVIDIA Jetson AGX Orin),用于大模型(VLA 模型)离线训练与复杂场景推理加速。

2.2 感知硬件模组

2.2.1 多传感融合配置

| 传感器类型 | 核心组件 | 技术参数 | 深度学习应用场景 |

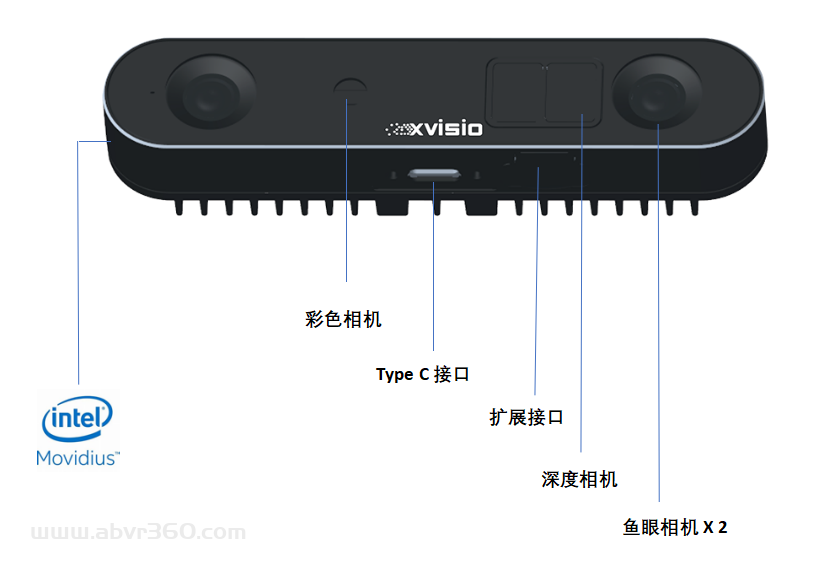

| 视觉传感器 | 诠视 SeerSense® DS80 模组 | 双目视觉(110° 视场角,640*480@60fps)+iTOF(940nm 波长,0.2-4m 误差 < 1%) | 三维重建、语义分割、手势识别 |

| 激光雷达 | 3D 固态激光雷达 | 测距范围 0.1-50m,角分辨率 0.1° | 环境建模、避障路径规划 |

| 触觉传感器 | 自研多维触觉单元 | 压力分辨率 0.1N,采样率 100Hz | 柔性抓取、人机交互力控 |

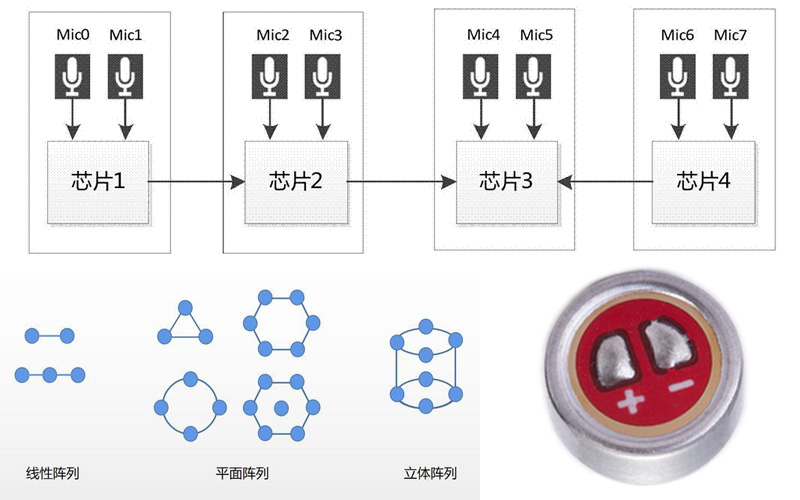

| 音频传感器 | 麦克风阵列 | 8 通道,降噪信噪比≥40dB | 语音指令识别、声源定位 |

诠视 SeerSense® DS80 模组:

激光雷达

触觉传感器:

麦克风阵列:

2.2.2 传感器接口设计

-

视觉接口:GMSL 车载级传输接口,支持低延迟(ms)图像传输,兼容鱼眼相机、红外相机等多路视频源。

-

数据同步:采用 PTP 精确时间协议,实现视觉、触觉、激光雷达数据的时间戳对齐(同步误差 00μs)。

2.3 运动控制硬件

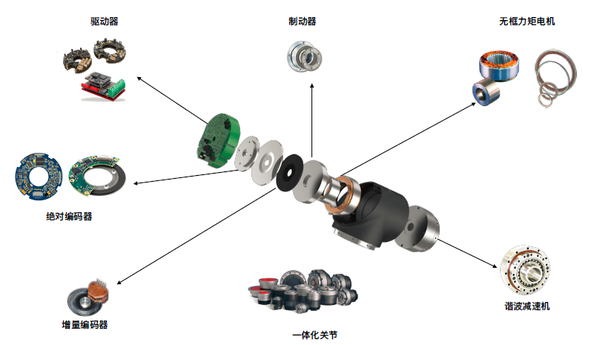

2.3.1 关节驱动系统

-

电机选型:无刷直流伺服电机(扭矩范围 5-20N・m),配备 16 位编码器,位置精度 ±0.01°。

-

驱动芯片:TI DRV8313 三相半桥驱动器,支持电流闭环控制,峰值电流 20A,适配电机启动大电流需求。

2.3.2 电源管理系统

2.3.2.1 拓扑设计

采用 “Boost+Buck+LDO” 混合拓扑,满足多电压轨需求:

-

电池输入:3.7V 锂电池组(容量≥10Ah,支持快充)。

-

电压转换:

-

Boost 变换器:3.7V→12V/24V(电机供电,峰值电流 20A,效率≥92%)。

-

Buck 变换器:12V→5V(传感器供电,电流 5A,纹波≤50mV)。

-

LDO:5V→3.3V/1.8V(主控芯片供电,噪声≤10μV,稳定性优先)。

-

2.3.2.2 保护机制

-

过流保护:采用自恢复保险丝(额定电流 1.2 倍于最大工作电流)。

-

过压保护:TVS 瞬态抑制二极管(响应时间),防止电池插拔浪涌。

-

热保护:NTC 热敏电阻监测电池温度,超过 60℃自动降功率运行。

2.4 PCB 设计规范

2.4.1 布局原则

-

核心区域:CPU/SoC 芯片居中布局,周围预留散热铜皮(面积≥芯片面积 3 倍),电源芯片靠近 CPU 供电引脚,缩短大电流路径。

-

分区设计:将模拟电路(传感器接口)与数字电路(CPU / 内存)分离布局,地平面分割隔离,减少电磁干扰。

-

连接器布局:电源接口、传感器接口集中布置在 PCB 边缘,预留防呆设计,便于装配维护。

2.4.2 关键设计细节

-

电源布线:12V 电机供电线宽≥2mm(铜厚 1oz),3.3V 信号线宽≥0.3mm,大电流路径避免过孔(必要时采用镀银过孔,数量≥2 个并联)。

-

地平面处理:采用双层地平面(顶层数字地 + 底层模拟地),单点接地连接,减少地弹噪声。

-

热设计:电源芯片(如 Buck 变换器)下方铺散热铜皮,通过过孔与底层地平面连接,大功率器件(如电机驱动器)预留散热片焊接位。

2.4.3 信号完整性优化

-

高速信号:DDR5 内存线阻抗控制为 50Ω,长度匹配误差≤5mm,采用差分对布线(间距 2 倍线宽)。

-

去耦电容:每个芯片电源引脚旁并联 0.1μF 陶瓷电容 + 10μF 钽电容,电容距离引脚≤5mm,实现电源纹波抑制。

3. 软件系统实现

3.1 操作系统与开发环境

-

主系统:Ubuntu 22.04 LTS(兼容 ROS 2 Humble),支持多线程调度与硬件抽象。

-

实时内核:基于 PREEMPT_RT 补丁(内核版本 5.15),运动控制线程调度优先级设置为 99,调度延迟≤1ms。

-

开发工具链:GCC 11.4+、CMake 3.22+、Python 3.10+,支持 C/C++(底层控制)与 Python(深度学习推理)混合开发。

3.2 感知层软件实现

3.2.1 多传感器数据融合

-

数据预处理:基于 OpenCV 实现图像畸变校正、激光雷达点云去噪,通过诠视科技 SDK 实现双目视觉与 iTOF 数据融合,生成高精度深度图(误差)。

-

融合算法:采用基于深度学习的传感器融合模型(如 PointPillars+CNN 融合架构),输入 RGB 图像、深度图、激光雷达点云,输出 3D 环境语义地图。

3.2.2 深度学习感知模型

-

目标检测:部署 YOLOv8-Lite 模型,基于 TensorRT 加速,推理速度≥30fps,支持人体、物体、障碍物等 100 + 类目标识别。

-

姿态估计:采用 MediaPipe+HRNet 混合模型,实时提取人体骨骼关键点(17 个关节点),用于人机交互意图识别。

-

空间定位:基于 DS80 模组的 VSLAM 引擎,实现自主定位与建图(SLAM),支持回环检测与空间锚点定位,定位精度 ±5cm。

3.3 决策层软件实现

3.3.1 深度学习决策模型

-

任务规划:采用轻量化 Transformer 模型(如 MiniGPT-4),输入自然语言指令与环境语义地图,生成结构化任务序列(如 “打开冰箱→取出牛奶”)。

-

路径规划:融合 A * 算法与深度学习避障模型,基于实时环境感知结果动态调整路径,避免静态与动态障碍物。

-

意图理解:基于 BERT 微调模型,处理自然语言指令(如 “帮我拿高处的书本”),准确率≥92%,支持上下文语义关联。

3.3.2 模型优化部署

-

模型压缩:采用 INT8 量化(TensorRT 工具),将大模型体积压缩 75%,推理速度提升 3 倍。

-

推理引擎:优先使用硬件集成 NPU/GPU 加速,英特尔平台适配 OpenVINO,地平线平台使用 Horizon AI Toolchain,端侧推理延迟≤50ms。

3.4 控制层软件实现

3.4.1 运动控制算法

-

关节控制:采用 PID + 前馈补偿算法,结合深度学习预测模型(LSTM),补偿关节摩擦与负载变化,位置跟踪误差≤0.1°。

-

步态规划:基于强化学习的动态步态生成模型(PPO 算法),适配平地行走、上下楼梯、转弯等场景,支持步态实时调整。

-

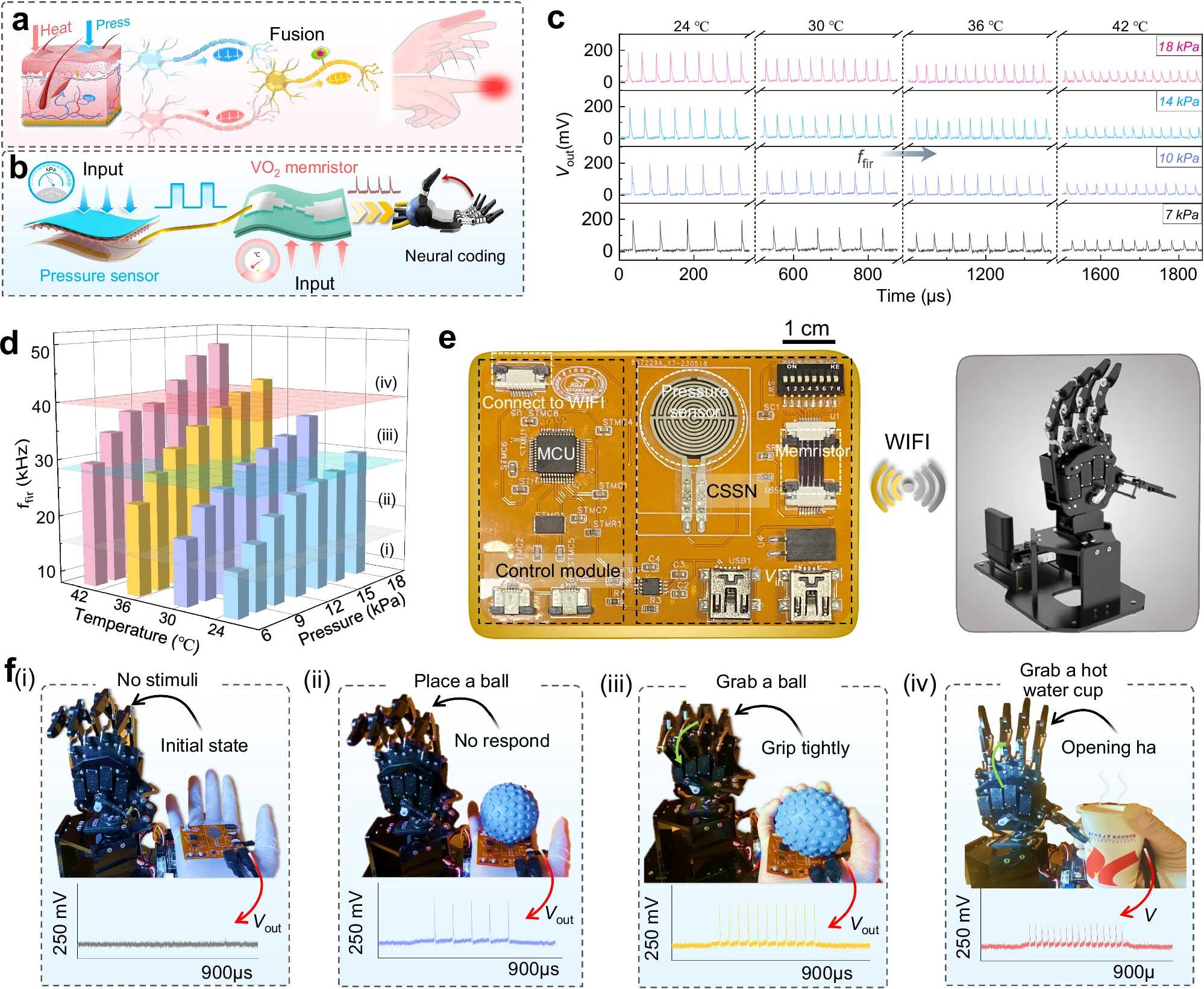

力控调节:融合触觉传感器数据,采用阻抗控制算法,实现柔性抓取(如鸡蛋抓取不破损),力控精度 ±0.5N。

3.4.2 软硬件协同接口

-

控制协议:采用 CANopen 总线通信(波特率 1Mbps),连接主控与关节驱动器,支持多电机同步控制。

-

数据交互:通过 ROS 2 话题 / 服务机制,实现感知、决策、控制模块的数据传输,话题队列大小设置为 10,缓存时间≤200ms。

4. 开源技术集成

4.1 开源硬件平台

| 平台名称 | 核心优势 | 适用场景 |

| 宇树 H1 开源人形机器人 | 提供完整机械结构图纸、电机驱动代码,支持 ROS 2 适配 | 高校科研、入门开发 |

| 地瓜机器人 RDK S100 | 开源大小脑融合架构代码,兼容多种传感器 | 工业协作机器人开发 |

| 诠视 DS80 开源 SDK | 提供 VSLAM、多传感融合开源接口,支持二次开发 | 视觉感知模块快速集成 |

传送门github.com/unitreerobotics/unitree_rl_gym

4.2 开源软件框架

4.2.1 核心框架

-

机器人操作系统:ROS 2 Humble Hawksbill,提供感知、决策、控制模块的标准化接口,支持多机器人协同。

-

深度学习框架:PyTorch(模型训练)、TensorFlow Lite(端侧推理)、ONNX Runtime(跨平台模型部署)。

-

运动控制库:Robotics Library(RL),支持运动学正逆解、轨迹规划,兼容多种机器人构型。

4.2.2 开源算法库

-

感知算法:Open3D(点云处理)、DDS-SLAM(动态环境 SLAM)、YOLOv8 开源库(目标检测)。

-

决策算法:FastChat(大模型对话)、ROS 2 Navigation2(路径规划)。

-

控制算法:PyDMP(动态运动原语)、RoboPy(机器人学计算)。

4.3 开源项目案例参考

-

项目名称:Humanoid Robot Control Framework(GitHub 星标 5k+) https://github.com/HorizonRobotics/HoloMotion

-

核心功能:开源深度学习步态规划、运动控制代码,支持英特尔 / 瑞芯微平台适配。

-

-

项目名称:OpenHumanoid(开源社区驱动)

-

核心功能:提供从硬件设计到软件部署的完整开源方案,包含多传感器融合深度学习模型。

-

5. 测试与验证

5.1 硬件测试

-

性能测试:算力单元满载运行时,CPU 温度≤85℃,电源效率≥85%,连续工作 8 小时无故障。

-

可靠性测试:模拟振动(5-50Hz)、高低温(-10℃-50℃)环境,传感器数据传输稳定,无丢包现象。

5.2 软件测试

-

感知测试:目标检测准确率≥90%,SLAM 建图误差≤3%,环境适应性覆盖强光、暗光、烟雾等场景。

-

决策测试:自然语言指令响应时间≤1s,任务规划成功率≥85%(复杂场景)。

-

控制测试:平地行走速度 0.3-1.0m/s,步态稳定性≥98%(连续行走 1km 无跌倒)。

5.3 系统集成测试

-

场景测试:家庭场景(物品抓取、人机交互)、工业场景(零件分拣、协作装配),综合任务完成率≥80%。

-

安全测试:碰撞检测响应时间≤50ms,过载时自动断电保护,符合 IEC 61508 安全标准。

6. 类人应用研究

6.1 核心应用场景分类与技术适配

6.1.1 工业协作场景

-

应用场景:汽车零部件组装、3C 电子产品质检、医药物流分拣、精密元件插装

-

技术适配方案:

-

硬件强化:采用防水防尘封装设计(参考 “探索 D1” 机器人),关节扭矩提升至 15-20N・m,适配工业环境物理防护需求;搭载 2000 万像素 3D 视觉传感器,实现 ±0.02mm 级定位精度,满足精密装配需求。

-

软件优化:集成 Force Sensor 力控模块,力控误差≤0.5N,兼容 12 种以上材质工件抓取;采用艾利特 iTRAK 智能调度算法,实时优化任务路径,设备综合利用率提升至 92% 以上。

-

-

典型案例:某新能源电池厂导入类人协作机器人后,质检不良品漏检率从 0.8% 降至 0.05%,检测成本降低 80%;汽车零部件组装线单件耗时从 126 秒压缩至 89 秒,ROI 周期缩短至 11.2 个月。

6.1.2 公共服务场景

-

应用场景:大型活动人流疏导(拉链式人墙)、安防巡检、户外应急救援

-

技术适配方案:

-

硬件强化:身高适配 170cm 人体工学设计,体重控制在 75kg 左右,运动速度提升至 10km/h,支持 20 度陡坡行走、20cm 台阶跨越及 0.5m 跳跃动作;配备多模态应急传感器,支持倒地自主爬起功能。

-

软件优化:基于物理规律建模的运动控制算法(替代纯数据驱动方案),提升复杂地形适应性;融合激光雷达与视觉传感器,实现动态人群行为预测,碰撞预警响应时间≤0.3 秒。

-

-

典型案例:电科机器人 “探索 D1” 已完成上海重大节假日人流疏导试点验证,通过队列协同算法实现模拟 “拉链式人墙” 分隔密集人群,自主规避率达 99.2%。

6.1.3 家庭与养老服务场景

-

应用场景:日常起居辅助、康复理疗、情感陪伴、突发状况响应

-

技术适配方案:

-

硬件轻量化:采用航天级碳纤维复合材料,整机重量≤5kg(参考白虹外骨骼机器人),关节驱动噪声≤45dB;触觉传感器灵敏度提升至 0.1N,支持细腻交互动作(如搀扶、按摩)。

-

软件升级:开发情感交互大模型,融合语音语调、面部微表情识别,提升隐喻表达理解能力;优化突发状况决策机制,将打翻水杯、老人跌倒等场景响应延迟压缩至 1 秒内。

-

-

现存挑战:情感交互深度不足(当前仅相当于 3 岁儿童水平),隐私数据保护体系待完善,非结构化家庭环境适应能力需强化。

6.2 关键技术研究方向

6.2.1 类人运动能力强化

-

动态平衡控制:融合强化学习与物理建模,开发自适应地形的步态生成算法,实现从平地到崎岖路面的无缝切换。

-

灵巧操作升级:基于 10 指触觉传感器阵列,训练多自由度协同操作模型,支持系纽扣、使用餐具等精细动作。

6.2.2 类人智能交互优化

-

情感认知建模:构建多模态情感数据集(语音、表情、动作),训练情感识别 Transformer 模型,提升 “言外之意” 理解能力。

-

隐私安全防护:采用联邦学习框架训练模型,本地数据不上云;设置隐私模式触发机制,敏感场景自动关闭图像采集功能。

6.2.3 场景自适应能力提升

-

跨场景迁移学习:基于元学习算法,实现机器人在工业、家庭、公共环境中的快速适配,降低场景切换部署成本。

-

极端环境适配:研发耐高温(-40℃-85℃)、抗电磁干扰的传感器模组,拓展在特种作业场景的应用边界。

6.3 应用落地实施路径

-

场景需求建模:通过数字孪生平台构建目标场景 3D 模型,模拟 2000+ 种工况下的机器人运行状态,明确硬件升级与软件优化优先级。

-

分阶段部署验证:先在结构化环境(如标准化工厂、封闭社区)完成试点应用,再逐步拓展至非结构化复杂环境。

-

持续迭代优化:基于边缘计算收集场景数据,通过端云协同推理优化模型参数,每季度完成一次算法迭代升级。

7. 人形机器人快速迭代的技术驱动力

7.1 硬件普惠化:核心部件国产化与成本革命

7.1.1 关键零部件突破降本

-

核心部件国产化替代:谐波减速器、力矩电机等 “卡脖子” 部件实现技术突破,某国产厂商通过纳米级渗碳钢材料将谐波减速器成本从 8000 元降至 3500 元,精度逼近国际顶级水平,打破进口依赖导致的成本壁垒。

-

模块化与规模化生产:采用标准化模块设计(如算力单元、关节驱动模块),组装周期从数月压缩至一周;中国制造业集群效应显著,碳纤维机身、3D 打印部件等供应链成熟,推动高端机型价格从百万级降至 50 万内,甚至出现万元级入门产品。

-

异构算力集成优化:单 SoC 融合架构(如英特尔酷睿 Ultra、地平线 RDK S100)替代传统双系统,算力密度提升 3 倍,功耗降低 40%,既满足深度学习推理需求,又适配实时运动控制,避免硬件冗余导致的迭代滞后。

7.1.2 感知硬件性能跃升

-

多传感融合成本下降:双目视觉 + iTOF 模组(如诠视 DS80)、3D 固态激光雷达等核心感知部件,通过技术迭代实现性能提升与价格下降,例如激光雷达测距精度从 ±1cm 优化至 ±0.5cm,成本降低 60%,推动多模态感知方案普及。

-

工业级防护与轻量化平衡:采用航天级碳纤维等轻量化材料,在保证 15-20N・m 关节扭矩的同时,将整机重量控制在 75kg 以内,兼顾工业环境防护(防水防尘)与家庭场景便携性,拓展迭代场景覆盖范围。

7.2 智能算法突破:从 “指令执行” 到 “具身智能”

7.2.3 VLA 模型赋能决策进化

-

多模态交互能力跃迁:视觉 - 语言 - 动作(VLA)模型的应用,让机器人从 “按指令执行” 升级为 “理解环境 + 意图交互”,例如特斯拉 Optimus、优必选 Walker S1 可听懂自然语言指令并动态调整动作轨迹,甚至通过多模态大模型实现 “猜拳游戏” 等类人交互。

-

模型轻量化与端侧部署:通过 INT8 量化、剪枝等技术(如 TensorRT 工具),将大模型体积压缩 75%,推理速度提升 3 倍,适配端侧 NPU/GPU 算力(如英特尔 NPU、地平线 BPU),端侧推理延迟≤50ms,满足实时决策需求。

7.2.4 运动控制算法革新

- 物理建模与数据驱动融合:摒弃纯预设程序,采用 “强化学习 + 物理规律建模” 方案,机器人可在湿滑地面稳定行走、被推搡后快速恢复平衡,动作泛化能力从 10 余种场景扩展至百余种,无需针对单一场景重复迭代。

- 力控与精度优化:融合 Force Sensor 力控模块与深度学习预测模型,力控误差≤0.5N,适配 12 种以上材质工件抓取,精密装配定位精度达 ±0.02mm,从 “实验室演示” 走向 “工业实用”,加速迭代验证周期。

7.3 数据基建支撑:从 “单点训练” 到 “集体进化”

7.3.1 多模态数据积累加速

-

共享训练场与数据开源:异构机器人训练场接入 11 家以上品牌的百余台机器人,模拟电网巡检、工厂装配等场景,每天生成数万条实操数据,避免企业 “单打独斗” 式数据积累;行业通用数据集标准体系推进,部分数据即将开源,打破数据孤岛。

-

虚实融合数据生成:通过虚拟环境生成亿级物体摆放组合等合成数据,结合少量真实数据微调,解决物理世界数据匮乏难题,例如机器人抓取能力通过 “虚拟亿级样本 + 真实千级样本” 训练,实现 “零样本” 抓取未见过的物品,训练周期缩短 80%。

7.3.2 端云协同迭代机制

-

边缘计算与云端优化闭环:机器人在端侧收集实时场景数据(如工业装配误差、家庭环境交互反馈),通过边缘计算预处理后上传云端,云端基于海量数据优化模型参数,再将更新后的算法下发端侧,形成 “数据采集 - 模型优化 - 算法迭代” 的快速闭环,季度级迭代升级成为常态。

-

仿真测试替代部分实机验证:数字孪生平台构建 3D 场景模型,模拟 2000+ 种工况下的机器人运行状态,提前发现硬件兼容、算法逻辑等问题,实机测试成本降低 70%,迭代周期从 6 个月压缩至 2-3 个月。

7.4 开源生态协同:降低创新门槛与加速技术扩散

7.4.5 软硬件开源平台普及

-

硬件开源降低研发成本:宇树 H1、地瓜机器人 RDK S100 等开源平台提供完整机械结构图纸、电机驱动代码、PCB 设计规范,开发者无需从零搭建硬件架构,可聚焦算法迭代与场景适配,研发周期缩短 50%。

-

软件框架标准化:ROS 2 Humble、PyTorch/TensorFlow Lite 等开源框架提供标准化接口,感知、决策、控制模块可快速集成;Open3D、YOLOv8 等开源算法库覆盖点云处理、目标检测等核心需求,避免重复造轮子,加速技术复用与迭代。

7.4.6 行业协同与标准推进

-

跨企业技术共享:多家企业联合推出通用数据集标准、硬件接口规范,推动算力单元、传感器、算法模型的兼容性提升,例如 ROS 2 生态支持多品牌机器人协同,降低迭代过程中的适配成本。

-

产学研协同创新:高校科研机构聚焦基础算法(如动态平衡、情感认知),企业侧重工程化落地与场景验证,开源社区提供技术交流与二次开发平台,形成 “基础研究 - 技术转化 - 场景迭代” 的良性循环,加速创新技术落地。

7.5 场景需求牵引:从 “技术展示” 到 “实用落地”

-

多场景需求倒逼迭代:工业协作(精密装配、质检)、公共服务(人流疏导、应急救援)、家庭养老(起居辅助、情感陪伴)等场景的明确需求,推动机器人在力控精度、环境适应性、交互友好度等方面定向迭代,例如工业场景要求 ±0.02mm 定位精度,家庭场景需要 ≤45dB 低噪声运行,需求导向让迭代更具针对性。

-

试点验证与快速迭代闭环:通过上海重大节假日人流疏导、新能源电池厂质检等试点应用,收集真实场景数据与反馈,快速优化算法(如队列协同、漏检率控制),例如某机器人通过试点验证将碰撞预警响应时间从 0.5 秒压缩至 0.3 秒,形成 “试点 - 反馈 - 迭代” 的快速循环。

4163

4163

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?