Transformer 是现代深度学习领域最具代表性的模型架构之一,被广泛应用于自然语言处理(NLP)、计算机视觉(CV)、语音识别等多个方向。许多热门模型如 BERT、GPT、T5、Vision Transformer(ViT)等,都是基于 Transformer 演化而来。

那么,想学会 Transformer,需要掌握哪些核心内容?以下是学习过程中应覆盖的关键模块、技术原理和工具体系。

一、数学与理论基础

Transformer 背后涉及到大量数学工具和理论概念,这是你理解其原理的地基:

-

线性代数

-

向量、矩阵运算(点乘、矩阵乘法)

-

特征向量与奇异值分解

-

-

概率与统计

-

概率分布、条件概率

-

softmax 函数与交叉熵损失

-

-

微积分

-

链式法则

-

导数、梯度概念(用于理解反向传播)

-

-

信息论(可选)

-

熵、互信息、KL 散度(理解模型训练目标)

-

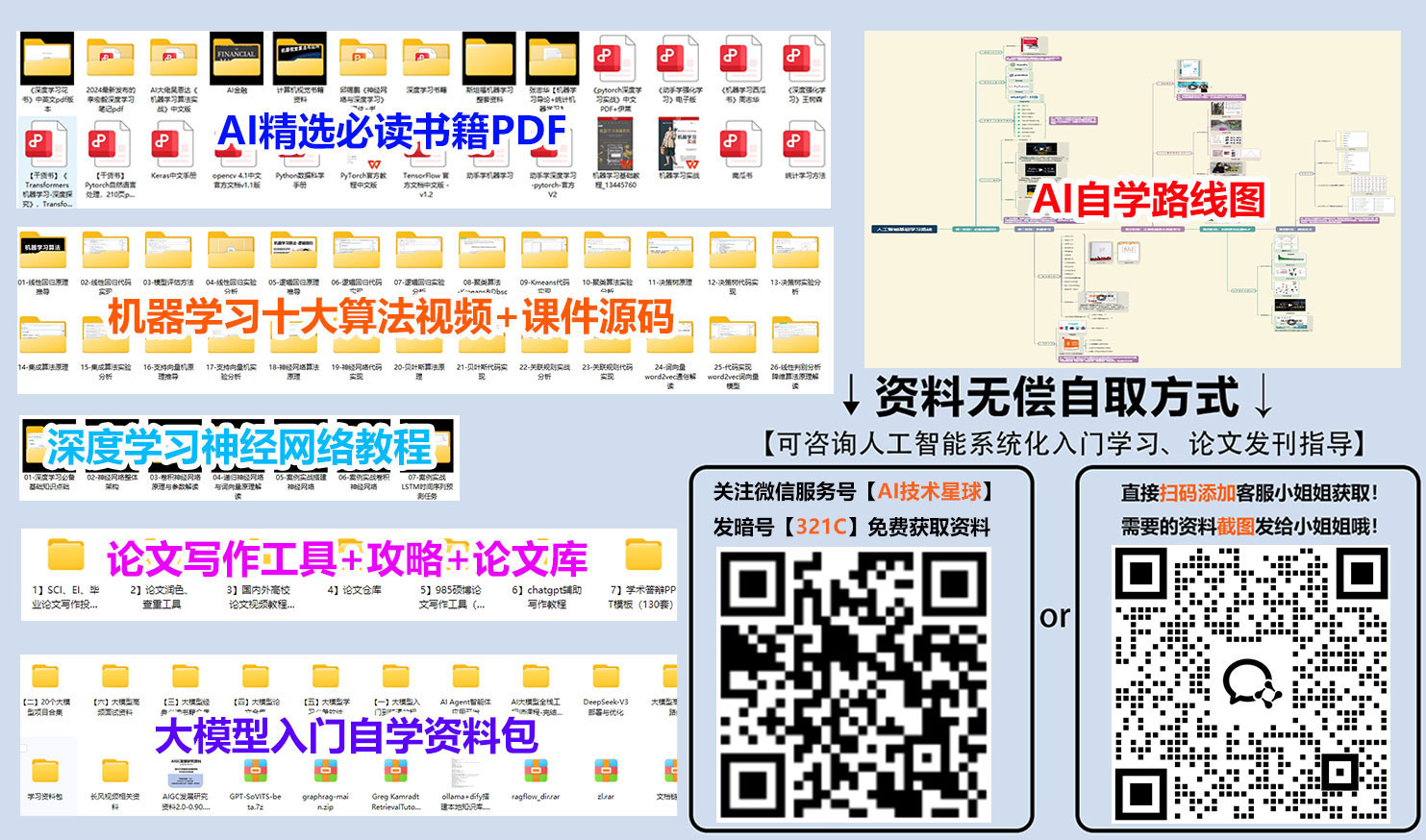

免费分享一套人工智能+大模型入门学习资料给大家,如果想自学,这套资料很全面!

关注公众号【AI技术星球】发暗号【321C】即可获取!

【人工智能自学路线图(图内推荐资源可点击内附链接直达学习)】

【AI入门必读书籍-花书、西瓜书、动手学深度学习等等...】

【机器学习经典算法视频教程+课件源码、机器学习实战项目】

【深度学习与神经网络入门教程】

【计算机视觉+NLP经典项目实战源码】

【大模型入门自学资料包】

【学术论文写作攻略工具】

二、深度学习基础

在学习 Transformer 前,你需要具备常规神经网络的知识:

-

神经网络基础:前向传播、反向传播、激活函数(如 ReLU)

-

常见网络结构:MLP、CNN、RNN、LSTM

-

优化算法:SGD、Adam、学习率衰减等

-

正则化技术:Dropout、BatchNorm

-

训练流程:数据预处理、损失函数、模型评估

三、Transformer 模型结构

这部分是学习的核心,需要深入理解每个组成部分的作用与交互:

✅ Attention 机制

-

什么是注意力机制

-

自注意力(Self-Attention)

-

Scaled Dot-Product Attention

-

多头注意力机制(Multi-Head Attention)

✅ 编码器与解码器结构

-

Encoder:自注意力 + 前馈网络 + 残差连接

-

Decoder:自注意力 + 编码器-解码器注意力 + 前馈网络

-

掩码(Masking):用于防止信息泄露(尤其在解码器中)

✅ 其他关键组件

-

位置编码(Positional Encoding)

-

残差连接 + Layer Normalization

-

Feed Forward Layer

-

权重共享机制

四、Transformer 进阶模型理解

掌握标准 Transformer 后,建议了解其演化与变体模型:

-

BERT:双向编码,适用于文本理解任务

-

GPT 系列:单向生成模型,适用于文本生成任务

-

T5:统一为文本到文本(Text-to-Text)格式

-

Vision Transformer (ViT):将图像切分为 patch,再用 Transformer 编码

-

Longformer / Performer / Linformer:处理长文本或高效 attention 的优化模型

五、框架与工具学习

掌握 Transformer 不只是理解结构,还要会用主流工具搭建和调试模型:

✅ 深度学习框架

-

PyTorch(推荐):语法灵活、生态成熟

-

TensorFlow/Keras:适合部署或已有 TensorFlow 项目

✅ 高级库

-

HuggingFace Transformers:快速调用数千种预训练模型

-

OpenNMT / Fairseq:研究级工具库,适合自定义结构和训练流程

-

Weights & Biases / TensorBoard:可视化与实验管理

六、实战与调优能力

学会 Transformer 的最终目标是落地应用,因此实战能力很关键:

-

数据加载与预处理(Tokenizer、Padding、Batching)

-

训练技巧(混合精度、梯度裁剪、学习率调度)

-

模型微调(Fine-tuning)、冻结与重训练

-

超参数选择与调优(hidden size、head 数、层数等)

-

模型部署与推理优化(ONNX、TorchScript、量化等)

七、建议的学习顺序与路径

-

学好深度学习基础(建议参考:吴恩达深度学习系列)

-

学习 Attention 原理与动手实现(可使用 PyTorch)

-

阅读并可视化解析《Attention is All You Need》论文

-

自己搭建一个简化版 Transformer(只含 Encoder)

-

使用 HuggingFace 库进行实战训练和微调

-

深入理解并使用 BERT/GPT 等模型

-

阅读先进变体论文,尝试修改或改进模型结构

结语

Transformer 不仅是一种模型结构,更是构建通用人工智能能力的技术基础。它融合了数学原理、深度学习思想与高效实现技巧,学习过程中既有挑战也充满成就感。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?