强化学习是一种让机器通过与环境交互,不断试错和优化行为策略的学习方法。它模仿人和动物通过奖惩机制学习新技能的过程,是人工智能中实现自主决策和智能控制的重要分支。

环境、状态与动作的互动

强化学习的核心概念包括环境(Environment)、状态(State)和动作(Action)。机器(智能体)处于某个状态,选择一个动作,环境根据动作反馈一个奖励(Reward),并转移到新的状态。这个循环不断进行,智能体通过观察奖励信号调整行为,力求获得最大长期回报。

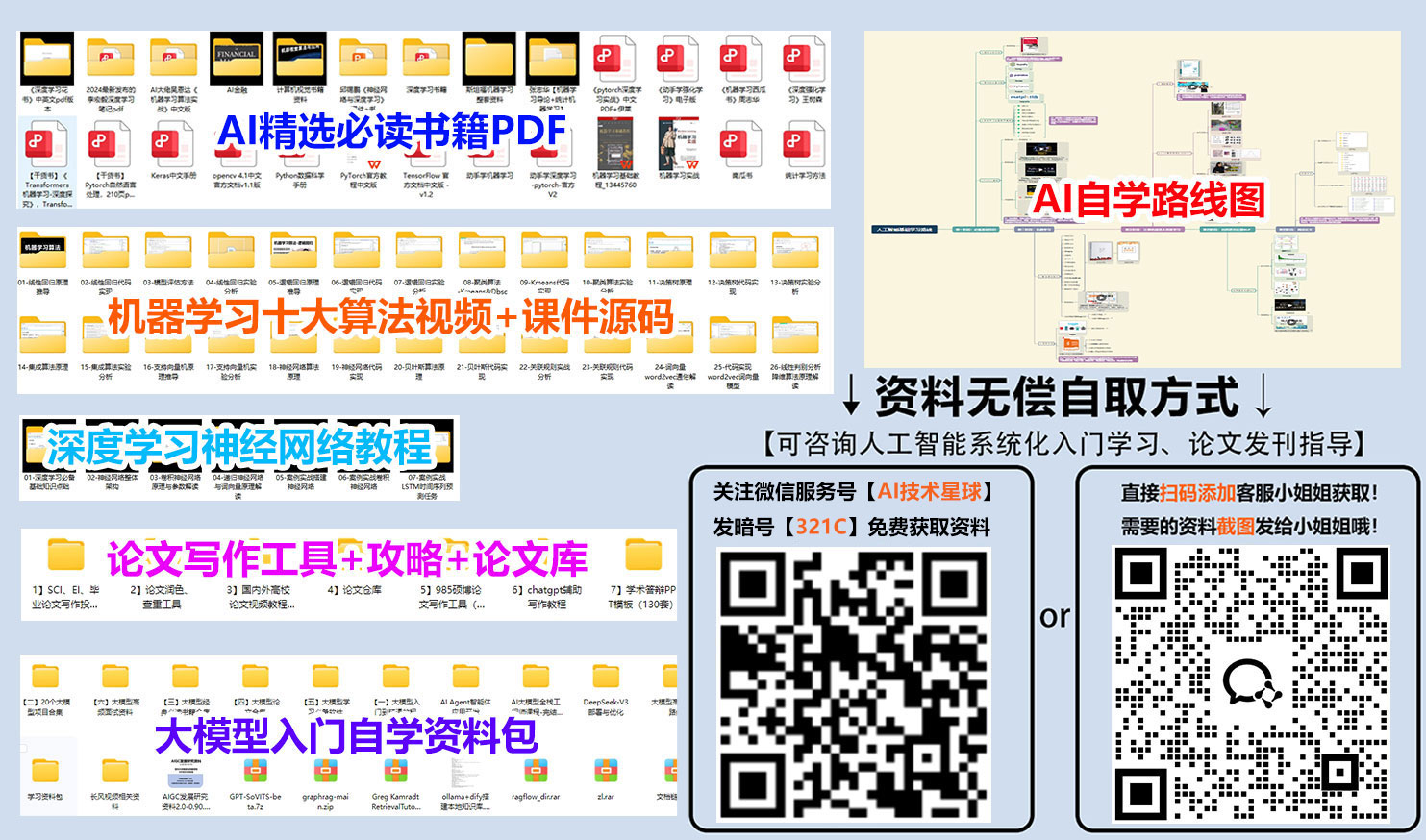

免费分享一套人工智能+大模型入门学习资料给大家,如果想自学,这套资料很全面!

关注公众号【AI技术星球】发暗号【321C】即可获取!

【人工智能自学路线图(图内推荐资源可点击内附链接直达学习)】

【AI入门必读书籍-花书、西瓜书、动手学深度学习等等...】

【机器学习经典算法视频教程+课件源码、机器学习实战项目】

【深度学习与神经网络入门教程】

【计算机视觉+NLP经典项目实战源码】

【大模型入门自学资料包】

【学术论文写作攻略工具】

奖励机制驱动学习

强化学习强调通过奖励信号指导学习。正奖励鼓励智能体采取某些行动,负奖励(惩罚)则让它避免错误行为。智能体的目标是学习一个策略,使得从当前状态出发,累积的未来奖励总和最大化。

策略与价值函数

策略是智能体在不同状态下选择动作的规则,可以是确定性的也可以是随机的。价值函数则用来评估某个状态或状态-动作对的“好坏”,即该状态下未来可能获得的累计奖励。智能体通过不断更新价值函数,优化策略以提升表现。

试错与探索—利用权衡

强化学习中的关键挑战之一是“探索-利用”平衡。智能体需要探索新的动作和策略以发现潜在更优方案,同时也要利用已有经验选择最佳动作。如何合理权衡,确保既不盲目尝试,也不陷入局部最优,是强化学习研究的重点。

经典算法与现代进展

早期的强化学习算法如Q学习和蒙特卡洛方法,通过表格存储状态-动作价值,适用于小规模问题。近年来,结合深度学习的深度强化学习(Deep Reinforcement Learning)突破了大规模、高维状态空间的限制,实现了从原始视觉输入直接学习复杂策略,成功应用于游戏、机器人控制和自动驾驶等领域。

强化学习通过模拟“试错”学习机制,让机器能够自主探索环境、制定行动策略,解决复杂决策问题。它正引领着自动驾驶、智能机器人、推荐系统等多个领域的革新。随着算法的不断优化和计算资源的提升,强化学习将在未来展现更广阔的应用前景,推动智能时代的发展。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?