4B参数吊打GPT-4.1-mini!MiniCPM-V 4.0开源:手机跑多模态不再是梦

2025年8月,人工智能赛道再度迎来重量级“新秀”——MiniCPM-V 4.0,由面壁智能携手 OpenBMB 团队联合打造,并选择全量开源的方式与全球开发者见面。不同于那些只能依赖云端算力运行的多模态大模型,MiniCPM-V 4.0从一开始就为手机、平板、个人电脑等端侧设备量身优化,让用户在本地即可享受媲美云端的多模态智能体验。

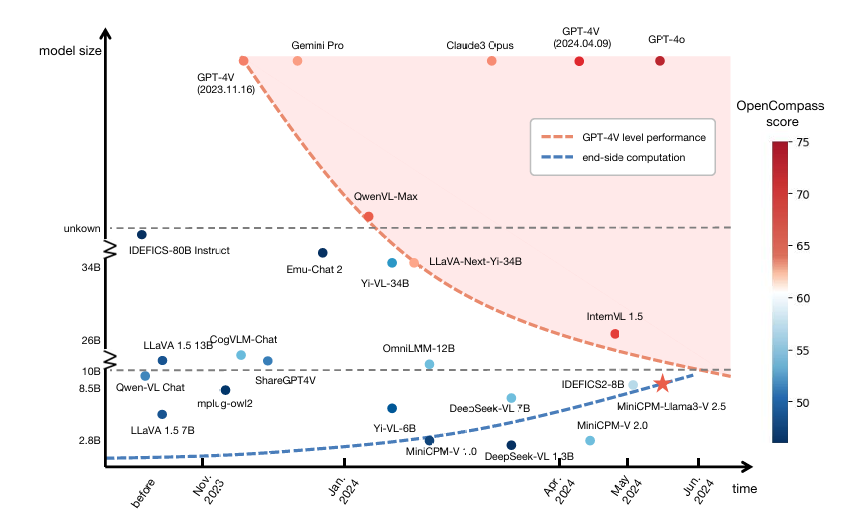

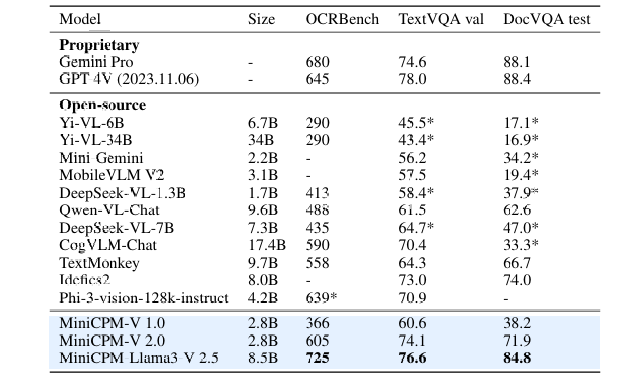

在综合评估图像理解能力的 OpenCompass 测试中,MiniCPM-V 4.0 的成绩不仅超越了 GPT-4.1-mini、Qwen2.5-VL-3B-Instruct、InternVL2.5-8B 等多个知名模型,还在 OCRBench、MathVista、MMVet 等专项评测中跻身同量级模型的第一梯队。更令人惊喜的是,尽管其参数量较前一代 MiniCPM-V 2.6 缩减了一半,但多模态能力却实现了跨越式提升。

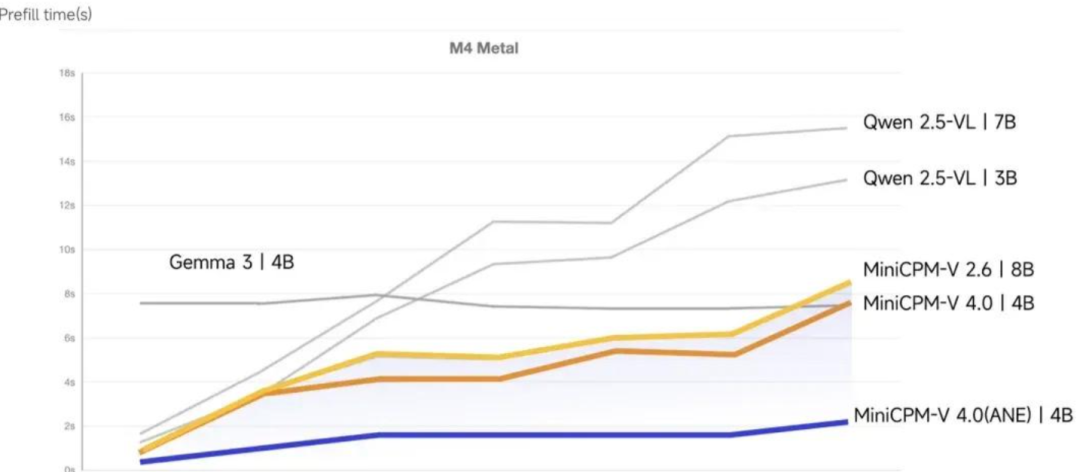

在真实设备上的表现同样惊艳:

-

推理速度快

——在 iPhone 16 Pro Max 上首次出词延迟低于 2 秒,解码速度可达每秒 17+ token; -

显存占用低

——Apple M4 芯片设备测试仅需 3.33GB 显存,告别发热与卡顿; -

并发性能强

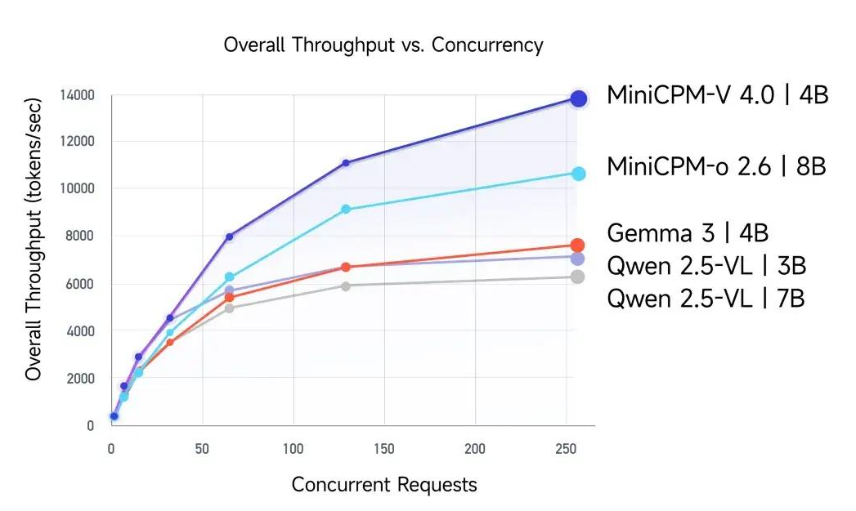

——256 并发用户请求下,吞吐量高达 13856 tokens/s,远超同类产品。

无论是处理单张图片、多图任务,还是视频理解与文本识别,MiniCPM-V 4.0都展现出强大的多模态处理能力,让“口袋里的 GPT-4V”真正成为现实。结合对 llama.cpp、Ollama、vLLM、SGLang 等主流框架的全面兼容,以及官方开源的 iOS 应用与详尽部署手册,MiniCPM-V 4.0为开发者打开了一条从实验室到终端的高速通道。

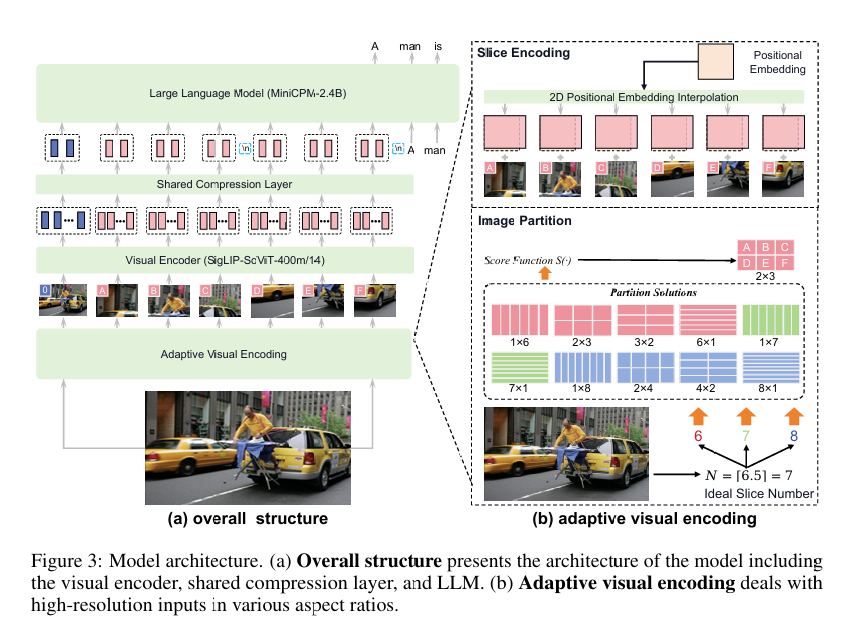

架构解析与开源生态

MiniCPM-V 4.0 的出色表现,离不开其先进的技术架构。该模型以 SigLIP2-400M 与 MiniCPM4-3B 为核心构建,通过创新的结构设计,在性能与效率之间找到了理想平衡。

为了让更多开发者能够快速上手,OpenBMB 团队为其打造了完善的生态支持。MiniCPM-V 4.0 不仅全面兼容 llama.cpp、Ollama、vLLM、SGLang 等主流框架,还同步推出了适用于 iPhone 和 iPad 的开源 iOS 应用。与此同时,官方提供了详尽的部署指南——《MiniCPM-V CookBook》,为开发者在不同设备和应用场景下的落地部署提供了清晰的路径与实践方案。

核心亮点

1. 专为端侧设备优化,实现流畅体验

与云端部署的大模型不同,MiniCPM-V 4.0开创性地实现了在移动端设备上的高性能本地化运行。这款专为智能手机和个人电脑设计的模型,在保持强大功能的同时,显著提升了运行效率和稳定性。

高效的推理速度

官方测试显示,在 iPhone 16 Pro Max 上,使用开源的 iOS 应用运行 MiniCPM-V 4.0 时,首次出词的延迟低于2秒,解码速度超过每秒17个词元(token),且不会出现设备过热问题。

强大的并发处理能力

在对并发量和吞吐量的测试中,MiniCPM-V 4.0表现出色。在256个并发用户请求下,其吞吐量高达13856 tokens/s,远超其他同类模型,展现了其强大的处理能力和广泛的应用潜力。

2. 强大的多模态能力

MiniCPM-V 4.0不仅在单张图像理解上表现出色,还具备强大的多图像和视频理解能力。此外,它还拥有强大的光学字符识别(OCR)功能,能够精准识别和处理图像中的文字信息。

本地部署

1. 模型推理

from PIL import Image

import torch

from transformers import AutoModel, AutoTokenizer

model_path = 'openbmb/MiniCPM-V-4'

model = AutoModel.from_pretrained(

model_path,

trust_remote_code=True,

attn_implementation='sdpa', # sdpa or flash_attention_2, no eager

torch_dtype=torch.bfloat16

)

model = model.eval().cuda()

tokenizer = AutoTokenizer.from_pretrained(

model_path, trust_remote_code=True

)

image = Image.open('./assets/single.png').convert('RGB')

# First round chat

question = "What is the landform in the picture?"

msgs = [{'role': 'user', 'content': [image, question]}]

answer = model.chat(

msgs=msgs,

image=image,

tokenizer=tokenizer

)

print(answer)

# Second round chat, pass history context of multi-turn conversation

msgs.append({"role": "assistant", "content": [answer]})

msgs.append({"role": "user", "content": [

"What should I pay attention to when traveling here?"]})

answer = model.chat(

msgs=msgs,

image=None,

tokenizer=tokenizer

)

print(answer)

社区地址

OpenCSG社区:

https://opencsg.com/models/OpenBMB/MiniCPM-V-4

HF社区:

https://huggingface.co/openbmb/MiniCPM-V-4

关于 OpenCSG

OpenCSG 是全球领先的开源大模型社区平台,致力于打造开放、协同、可持续的 AI 开发者生态。核心产品 CSGHub 提供模型、数据集、代码与 AI 应用的一站式托管、协作与共享服务,具备业界领先的模型资产管理能力,支持多角色协同和高效复用。

MiniCPM-V 4.0开源,手机跑多模态成现实

MiniCPM-V 4.0开源,手机跑多模态成现实

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?