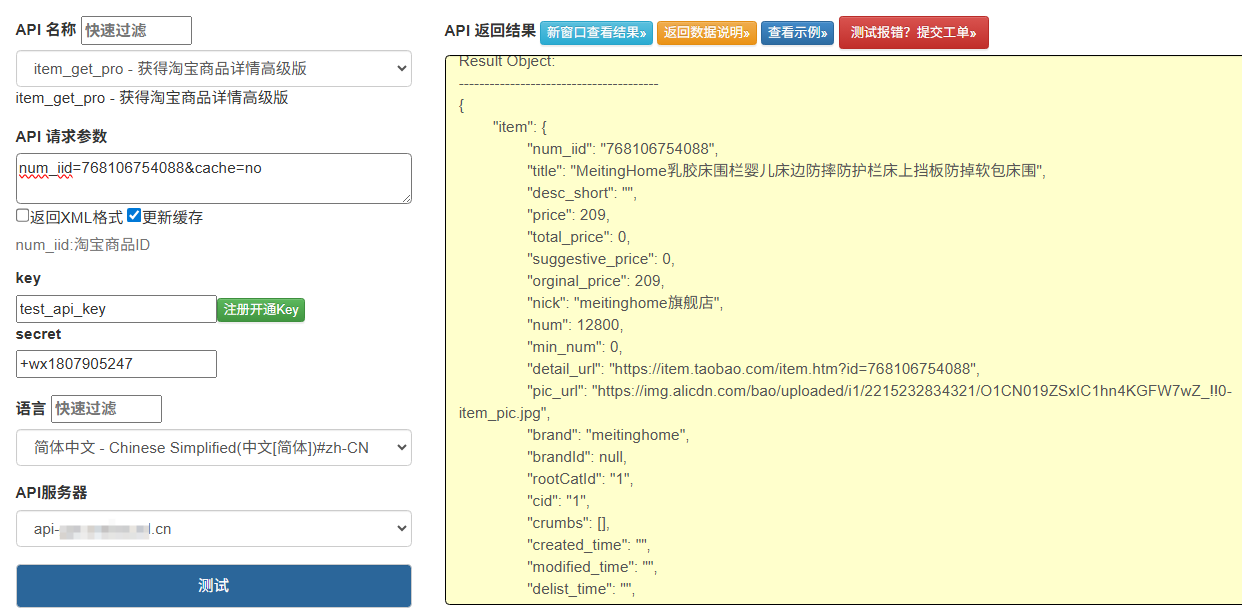

在电商数据分析、比价系统、选品工具等业务场景中,往往需要大规模调用淘宝商品详情 API 以获取商品标题、价格、销量、评价等核心数据。然而,面对淘宝开放平台的严格限流策略、海量商品 ID 的处理需求以及系统高可用要求,传统的单节点调用方式早已力不从心。本文将从实践角度出发,分享一套成熟的分布式请求调度方案,探讨如何在合规前提下实现高效、稳定、可扩展的 API 调用体系。

一、大规模调用的核心挑战

在着手设计分布式调度系统前,我们必须先明确淘宝商品详情 API 调用的核心约束与技术难点:

-

平台限流约束

淘宝开放平台对 API 调用实施多层次限制:单 AppKey 的 QPS 限制(通常为 10-100 次 / 秒)、IP 维度的并发限制、单日调用总量阈值,以及针对高频访问相同商品 ID 的特殊管控。任何单一节点都无法突破这些限制,反而容易触发临时封禁。 -

海量任务处理压力

当需要处理百万级甚至千万级商品 ID 时,单节点的网络 IO、连接池管理、任务队列都会成为瓶颈,导致任务积压、超时失败率上升。 -

分布式协调难题

多节点间如何分配任务以避免重复调用?如何动态调整各节点的请求频率以适应平台限流变化?如何在节点故障时实现任务自动迁移? -

数据一致性与可靠性

API 调用可能因网络波动、平台临时维护等原因失败,需要设计重试机制;同时,部分商品可能因下架、隐私设置等原因无法获取数据,需建立异常处理规范。

二、分布式调度系统架构设计

针对上述挑战,我们设计了一套 "四层架构" 的分布式请求调度系统,通过分层解耦实现高可用与可扩展

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1747

1747

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?