当我们在对话框中输入Prompt,看着ChatGPT或Claude如行云流水般吐露文字时,一种“它理解我”的错觉油然而生。但作为一个理性的技术观察者,我们需要剥离这种拟人化的滤镜,直面一个略显冰冷的现实:模型完全不知道自己刚刚说了什么,更不知道下一句要说什么。

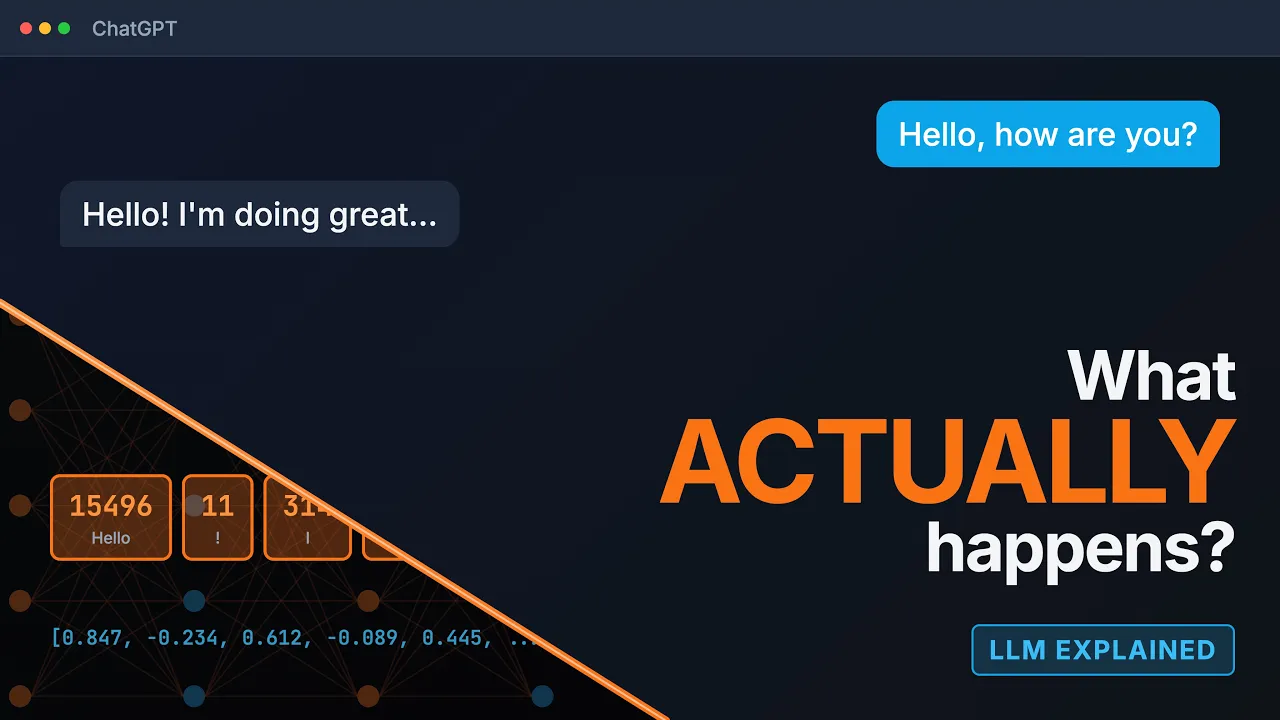

大语言模型(LLM)并非全知全能的智者,而是一个基于概率的预测机器。它生成的每一个字,都是在数万个选项中进行的一场即时赌博。本文将拆解从输入到输出的五个关键步骤,从底层的数学原理出发,为你揭示为什么模型会“一本正经地胡说八道”,以及所谓的“创造力”究竟源自何处。

祛魅:从输入到输出的五步机械运动

当我们点击发送按钮的那一刻,后台并没有一个名为“AI”的大脑在思考。实际上,发生的是一套严密的线性计算流程。

1. Tokenization:机器不读字,只读“码”

人类眼中的“我爱编程”,在模型眼中只是一串数字。这就是Tokenization(分词)。模型不会直接处理单词或汉字,而是将其拆解为更高效的模式——Token。

常见的误区是认为一个Token等于一个单词。实际上,常用词(如“the”)可能是一个Token,而生僻词会被拆解成多个碎片。例如,“indistinguishable”这个词会被拆成四个Token。这一机制解释了为什么API计费时强调Token数量而非字数:对于模型而言,处理的信息单位是Token,通常1000个Token约等于750个英文单词。最终,你的输入被转换成了一串毫无感情的整数序列(Token ID)。

2. Embeddings:构建语义的万物坐标系

一串数字ID本身没有意义,除非我们将它放入一个高维空间中。这就是Embeddings(嵌入)。

模型将每个Token转化为一个包含数千

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1103

1103

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?