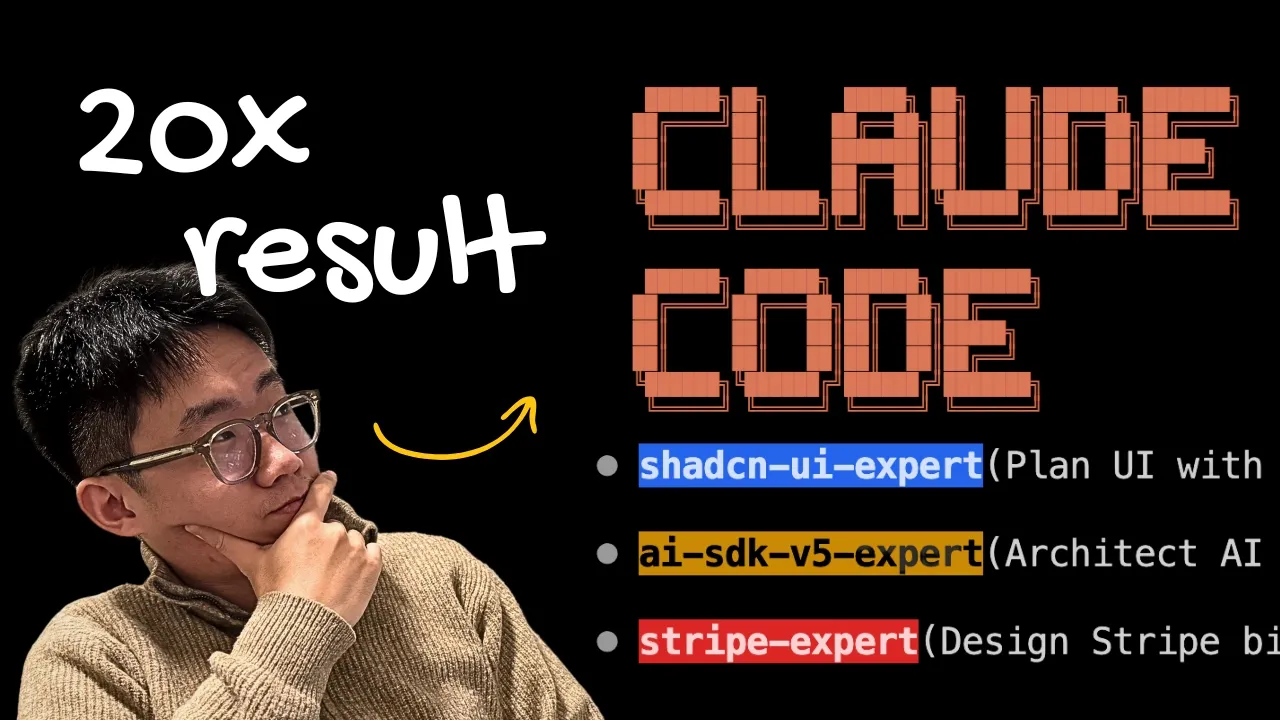

AI 编程助手,特别是如 Claude Code 这样的多智能体系统,正以前所未有的速度提升开发效率。然而,许多早期尝试使用子智能体(sub-agent)的用户遭遇了负面体验:性能缓慢、Token 消耗剧增,且结果并未得到显著改善。这并非技术概念的失败,而是设计范式的偏差。通过对超过 20 小时的测试和优化,我们可以看到,子智能体的价值核心不在于直接执行任务,而在于优化上下文管理和信息检索。

本文将深入分析 Claude Code 子智能体从低效到高效的转变历程,揭示“研究员优先”(researcher-first)模式如何成为提升 AI 编码工作流成功率的最佳实践,并探讨利用文件系统进行上下文持久化的先进技术。

智能体协同的痛点:上下文窗口的极限挑战

要理解子智能体的必要性,必须先理解大型语言模型(LLM)在编程任务中面临的“上下文窗口”(Context Window)限制。

在 Claude Code 引入子智能体功能之前,所有操作都由主智能体(Claude Code Agent)独立完成。当需要读取文件、搜索代码库时,整个文件内容会被纳入对话历史,这通常会消耗大量的 Token。

对话压缩的性能陷阱

当文件包含大量内容,上下文窗口即将被占满时(例如,在开始实施前就占用了 80% 的上下文容量),系统会触发“对话压缩”(compact conversation)命令。

每次对话被压缩,智能体的性能都会急剧下降,因为它开始丢失关于先前操作的关键上下文信息。子智能体的诞生正是为了解决这一核心的“上下文工程”(context engineering)挑战。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1676

1676

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?