前言

主要信息来自和Qwen对话时它给我的回答,我这里主要是想记录一下。

什么是张量并行

张量并行的定义

在深度学习中,模型的核心计算通常基于张量(如权重矩阵、激活值等)。当模型非常大时,单个张量可能无法完全存储在一个 GPU 的显存中。

Tensor 并行的核心思想是将一个张量切分成多个小块,并将这些小块分布到不同的设备(如多个 GPU)上进行计算 。

与数据并行的区别

数据并行(Data Parallelism) :每个设备保存完整的模型副本,但处理不同的输入数据子集。适合模型较小但数据量较大的场景。

Tensor 并行 :将模型本身的参数切分到多个设备上,适合模型过大而无法装入单个设备的情况。

张量并行的工作原理

分割张量

假设有一个权重矩阵 W,它的形状为 [M,N]。Tensor 并行会将这个矩阵按行或按列分割成多个子矩阵。

并行计算

在前向传播(Forward Pass)中,输入张量也会被分割,并分别发送到对应的设备上进行局部计算。

在反向传播(Backward Pass)中,梯度会被重新组合,以更新整个模型的参数。

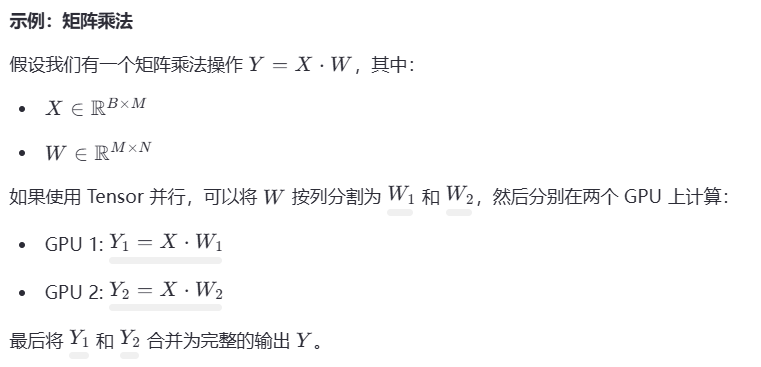

示例

张量并行的优缺点

优点

- 支持超大规模模型 :

Tensor 并行允许我们将模型参数分布在多个设备上,突破了单个设备显存的限制。 - 高效利用硬件资源 :

通过并行计算,可以充分利用多个 GPU 的计算能力。 - 灵活性高 :

可与其他并行策略(如数据并行、流水线并行)结合使用。

缺点

- 通信开销较大 :

在计算过程中,不同设备之间需要频繁交换中间结果(如分割后的张量或梯度),这会增加通信成本。 - 实现复杂 :

Tensor 并行的实现需要仔细设计张量的分割方式和通信逻辑,增加了开发难度。 - 扩展性有限 :

Tensor 并行的效率通常受限于张量的维度大小。如果张量本身较小,分割后可能会导致负载不均衡。

张量并行的应用场景

- 超大规模语言模型

- 多模态模型

对于多模态模型(如 CLIP、DALL-E),由于涉及大量的视觉和文本特征,模型参数也可能非常庞大,Tensor 并行可以帮助解决显存不足的问题。 - 高性能推理

在推理阶段,Tensor 并行可以加速超大规模模型的推理速度,同时降低单个设备的显存需求。

张量并行与其他并行策略的结合

在实际应用中,Tensor 并行通常与其他并行策略结合使用,以进一步提升性能。例如:

- 数据并行 + Tensor 并行 :

数据并行负责处理不同批次的数据,Tensor 并行负责处理单个批次内的张量分割。 - 流水线并行 + Tensor 并行 :

流水线并行将模型的不同层分布到不同的设备上,Tensor 并行则进一步分割每一层的张量。

总结

Tensor 并行是一种强大的技术,能够有效解决超大规模模型的显存瓶颈问题。然而,由于其较高的实现复杂性和通信开销,在实际应用中通常需要与其他并行策略结合使用,以达到最佳性能。如果你正在处理超大规模模型,建议使用成熟的分布式训练框架(如 Megatron-LM 或 DeepSpeed),它们已经内置了 Tensor 并行的支持,并经过了高度优化。

张量并行:解决超大规模模型显存难题

张量并行:解决超大规模模型显存难题

4659

4659

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?