文章目录

概述

名为“回归”的分类器

线性回归的任务,就是构造一个预测函数 来映射输入的特征矩阵x和标签值y的线性关系,而构造预测函数的核心就是找出模型的参数 和 ,著名的最小二乘法就是用来求解线性回归中参数的数学方法。

通过函数 ,线性回归使用输入的特征矩阵X来输出一组连续型的标签值y_pred,以完成各种预测连续型变量的任务

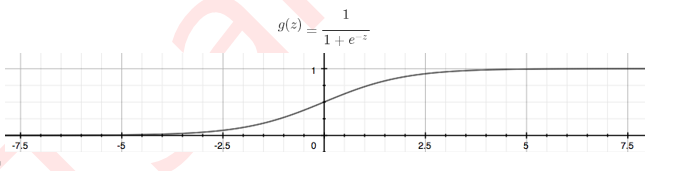

(比如预测产品销量,预测股价等等)。那如果我们的标签是离散型变量,尤其是,如果是满足0-1分布的离散型 变量,我们要怎么办呢?我们可以通过引入联系函数(link function),将线性回归方程z变换为g(z),并且令g(z)的值分布在(0,1)之间,且当g(z)接近0时样本的标签为类别0,当g(z)接近1时样本的标签为类别1,这样就得到了一个分 类模型。而这个联系函数对于逻辑回归来说,就是Sigmoid函数:

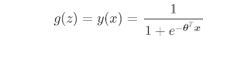

线性回归 ,于是我们将 带入,就得到了二元逻辑回归模型的一般形式:

而 就是我们逻辑回归返回的标签值。此时 的取值都在[0,1]之间,因 和 相加必然为1。如果我们令 除以 可以得到形似几率(odds) ,在此基础上取对数,可以很容易就得到:

不难发现,y(x)的形似几率取对数的本质其实就是我们的线性回归z,我们实际上是在对线性回归模型的预测结果取 对数几率来让其的结果无限逼近0和1。因此,其对应的模型被称为”对数几率回归“(logistic Regression),也就是我们的逻辑回归,这个名为“回归”却是用来做分类工作的分类器。

之前我们提到过,线性回归的核心任务是通过求解 构建 这个预测函数,并希望预测函数 能够尽量拟合数据,因此逻辑回归的核心任务也是类似的:求解 来构建一个能够尽量拟合数据的预测函 ,并通过向预测函数中输入特征矩阵来获取相应的标签值y。

本文介绍了如何将线性回归用于处理离散标签,通过Sigmoid函数实现二元逻辑回归,解释了模型如何通过对数几率回归逼近0和1,以及逻辑回归的核心任务——拟合数据并生成分类预测。

本文介绍了如何将线性回归用于处理离散标签,通过Sigmoid函数实现二元逻辑回归,解释了模型如何通过对数几率回归逼近0和1,以及逻辑回归的核心任务——拟合数据并生成分类预测。

982

982

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?