在 Linux 服务器运维体系中,日志文件是系统运行状态的 “晴雨表”,记录着服务启停、错误排查、用户操作等关键信息。但日志的持续生成与无序积累,往往会占用大量的磁盘空间。因此,建立一套 “预防为主、治理为辅” 的日志管理体系,是保障服务器稳定运行的核心任务之一。下面从 Linux 运维视角出发,聊下防止日志打满磁盘的方法。

一、前置基础:精准定位日志占用问题

在制定防御策略前,需先明确日志文件的分布与占用情况,避免盲目操作。Linux 系统提供了多个原生命令,可快速实现磁盘与日志的状态排查。

#磁盘空间全景扫描df -h # 显示整个磁盘使用信息日志文件精准定位#du -sh /var/log/*# 查找/var/log下超过100MB的日志文件find /var/log -type f -size +100M -name "*.log"

系统日志(如/var/log/messages)、应用日志(如 Nginx 的access.log)及服务日志(如/var/log/rsyslog)是最常见的大容量日志来源。

二、核心防御策略一:自动化清理,斩断日志积累根源

对于已生成的过期或超大日志,手动清理效率低下且易遗漏,通过脚本与定时任务实现自动化清理,是最直接的防御手段。利用find命令编写针对性清理脚本,可根据日志的存活时间、文件大小等维度筛选并删除冗余日志。例如,以下脚本可删除/var/log目录下超过 30 天的.log文件,并记录清理日志便于追溯:

#!/bin/bash# 日志存储目录LOG_DIR="/var/log"# 保留日志的最大天数MAX_DAYS=30# 清理日志文件find $LOG_DIR -type f -name "*.log" -mtime +$MAX_DAYS -exec rm {} \;# 记录清理操作到日志echo "$(date '+%Y-%m-%d %H:%M:%S'): 已删除所有超过$MAX_DAYS天的旧日志文件" >> $LOG_DIR/cleanup_history.logexit 0

保存为autodellog.sh后,先在测试环境验证脚本准确性,避免误删关键日志,防提桶跑路要养成的好习惯。验证没问题后,就可以借助cron定时任务,可让清理脚本按预设周期自动运行,无需人工干预。参考前面的文章:Linux Cron定时任务:让自动化成为你的得力助手,或者简单点的:别再死磕 cron 了!Linux 自带这2个轻量神器,临时任务 10 秒搞定

三、核心防御策略二:日志轮转,实现日志生命周期管控

自动化清理虽能删除旧日志,但无法解决 “单日志文件过大” 的问题 —— 超大日志文件不仅占用空间,还会影响日志查看与分析效率。日志轮转(Log Rotation)通过 “拆分、压缩、保留” 的机制,实现日志的精细化生命周期管理,是 Linux 系统的标准日志治理方案,它是 Linux 系统自带的日志轮转工具,通过读取配置文件自动完成日志的轮转、压缩、删除等操作,支持按时间、大小等多种触发条件,且可在轮转后重启相关服务确保日志正常生成。其核心配置文件分为两类:

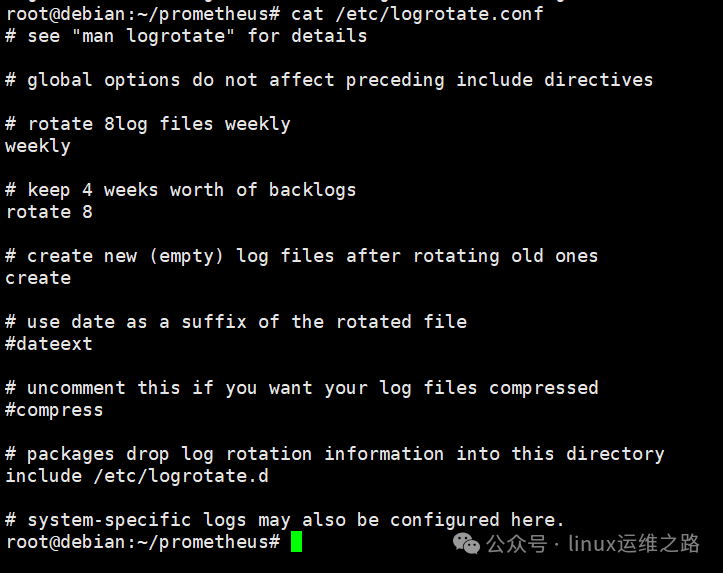

主配置文件:/etc/logrotate.conf,定义全局默认规则;

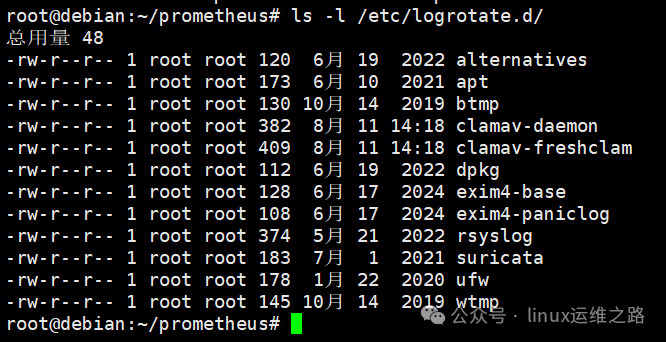

应用配置文件:/etc/logrotate.d/目录下的文件,针对特定服务(如 rsyslog、ufw)设置个性化规则,优先级高于主配置。

以/var/log目录下的系统日志为例,以下配置可实现 “每日轮转、保留 7 天、压缩存储” 的管理策略:

/var/log/*.log {daily # 轮转频率:每天一次rotate 7 # 保留最近7份轮转日志,超过则删除compress # 对旧日志进行gzip压缩,节省磁盘空间missingok # 若日志文件不存在,不报错继续执行notifempty # 若日志文件为空,不执行轮转create 640 root adm # 新建日志文件的权限为640,属主root,属组admpostrotate # 轮转后执行的脚本:重新加载rsyslog服务/etc/init.d/rsyslog reload > /dev/nullendscript}

对于生成速度极快的应用日志(如高并发场景下的 Nginx 访问日志),可添加size 100M参数,实现 “大小触发轮转”—— 当日志文件达到 100MB 时立即轮转,避免单个文件太大了。

四、核心防御策略三:源头优化,减少无效日志生成

无论是清理还是轮转,本质都是对已生成日志的 “事后处理”。从源头减少无效日志的产生,能从根本上降低磁盘占用压力,这需要结合日志级别调整与服务配置优化。例如,系统服务可以通过修改/etc/rsyslog.conf中的*.debug为*.info,减少调试日志;生产环境的具体应用,则需要问下开发同事,可以关闭哪些日志,我们运维就不要自做主张关了,免得后面有bug,开发需要你拿某个日志,你回答说:关了。

五、进阶防御策略:规模化场景下的日志管理方案

当运维环境从单台服务器扩展到多节点集群时,传统本地日志管理方式难以满足需求,需引入集中式管理与监控体系,实现日志的全局管控。集中式日志系统可将所有服务器的日志统一收集、存储、分析,彻底摆脱本地磁盘依赖。目前主流方案为 ELK Stack(Elasticsearch + Logstash + Kibana),通过集中式系统,本地服务器仅需保留短期的日志,其余日志全部同步至远端存储,从根本上避免本地磁盘被日志占满。另外现在的云主机可采用云厂商提供的日志服务(人民币玩家),这个功能我没用过,就不在这里献丑说了。

日志打满磁盘并非突发故障,而是长期管理缺失导致的必然结果。从 Linux 运维视角来看,防止此类问题需要构建 “精准定位 - 自动化清理 - 生命周期管控 - 源头优化 - 集中式监控” 的全链路体系。通过本文所述的策略与工具,运维人员可将日志从 “磁盘杀手” 转变为 “运维助手”,既保障服务器磁盘空间稳定,又充分发挥日志的故障排查与系统监控价值。不然只会发生这样的情况:出问题了老板觉得要你何用,没问题了老板也觉得要你何用。

这两年,IT行业面临经济周期波动与AI产业结构调整的双重压力,确实有很多运维与网络工程师因企业缩编或技术迭代而暂时失业。

很多人都在提运维网工失业后就只能去跑滴滴送外卖了,但我想分享的是,对于运维人员来说,即便失业以后仍然有很多副业可以尝试。

运维副业方向

运维,千万不要再错过这些副业机会!

第一个是知识付费类副业:输出经验打造个人IP

在线教育平台讲师

操作路径:在慕课网、极客时间等平台开设《CCNA实战》《Linux运维从入门到精通》等课程,或与培训机构合作录制专题课。

收益模式:课程销售分成、企业内训。

技术博客与公众号运营

操作路径:撰写网络协议解析、故障排查案例、设备评测等深度文章,通过公众号广告、付费专栏及企业合作变现。

收益关键:每周更新2-3篇原创,结合SEO优化与社群运营。

第二个是技术类副业:深耕专业领域变现

企业网络设备配置与优化服务

操作路径:为中小型企业提供路由器、交换机、防火墙等设备的配置调试、性能优化及故障排查服务。可通过本地IT服务公司合作或自建线上接单平台获客。

收益模式:按项目收费或签订年度维护合同。

远程IT基础设施代维

操作路径:通过承接服务器监控、日志分析、备份恢复等远程代维任务。适合熟悉Zabbix、ELK等技术栈的工程师。

收益模式:按工时计费或包月服务。

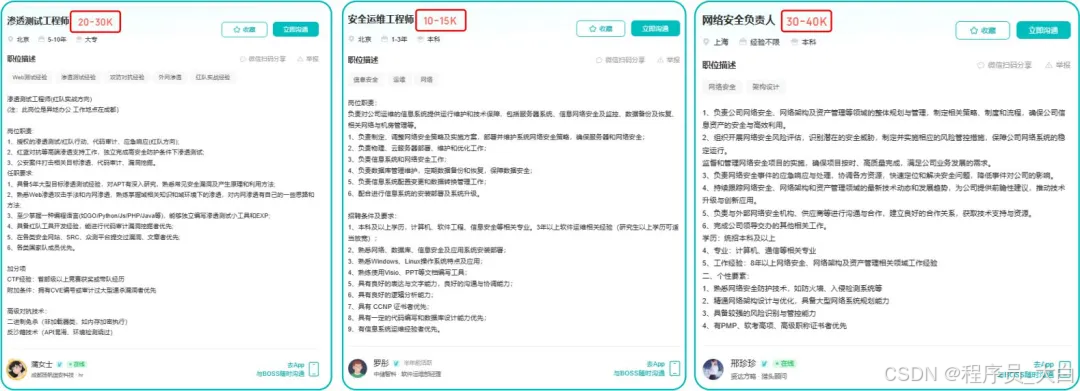

网络安全顾问与渗透测试

操作路径:利用OWASP Top 10漏洞分析、Nmap/BurpSuite等工具,为企业提供漏洞扫描、渗透测试及安全加固方案。需考取CISP等认证提升资质。

收益模式:单次渗透测试报告收费;长期安全顾问年费。

比如不久前跟我一起聊天的一个粉丝,他自己之前是大四实习的时候做的运维,发现运维7*24小时待命受不了,就准备转网安,学了差不多2个月,然后开始挖漏洞,光是补天的漏洞奖励也有个四五千,他说自己每个月的房租和饭钱就够了。

为什么我会推荐你网安是运维人员的绝佳副业&转型方向?

1.你的经验是巨大优势: 你比任何人都懂系统、网络和架构。漏洞挖掘、内网渗透、应急响应,这些核心安全能力本质上是“攻击视角下的运维”。你的运维背景不是从零开始,而是降维打击。

2.越老越吃香,规避年龄危机: 安全行业极度依赖经验。你的排查思路、风险意识和对复杂系统的理解能力,会随着项目积累而愈发珍贵,真正做到“姜还是老的辣”。

3.职业选择极其灵活: 你可以加入企业成为安全专家,可以兼职“挖洞“获取丰厚奖金,甚至可以成为自由顾问。这种多样性为你提供了前所未有的抗风险能力。

4.市场需求爆发,前景广阔: 在国家级政策的推动下,从一线城市到二三线地区,安全人才缺口正在急剧扩大。现在布局,正是抢占未来先机的黄金时刻。

运维转行学习路线

(一)第一阶段:网络安全筑基

1. 阶段目标

你已经有运维经验了,所以操作系统、网络协议这些你不是零基础。但要学安全,得重新过一遍——只不过这次我们是带着“安全视角”去学。

2. 学习内容

**操作系统强化:**你需要重点学习 Windows、Linux 操作系统安全配置,对比运维工作中常规配置与安全配置的差异,深化系统安全认知(比如说日志审计配置,为应急响应日志分析打基础)。

**网络协议深化:**结合过往网络协议应用经验,聚焦 TCP/IP 协议簇中的安全漏洞及防护机制,如 ARP 欺骗、TCP 三次握手漏洞等(为 SRC 漏扫中协议层漏洞识别铺垫)。

**Web 与数据库基础:**补充 Web 架构、HTTP 协议及 MySQL、SQL Server 等数据库安全相关知识,了解 Web 应用与数据库在网安中的作用。

**编程语言入门:**学习 Python 基础语法,掌握简单脚本编写,为后续 SRC 漏扫自动化脚本开发及应急响应工具使用打基础。

**工具实战:**集中训练抓包工具(Wireshark)、渗透测试工具(Nmap)、漏洞扫描工具(Nessus 基础版)的使用,结合模拟场景练习工具应用(掌握基础扫描逻辑,为 SRC 漏扫工具进阶做准备)。

(二)第二阶段:漏洞挖掘与 SRC 漏扫实战

1. 阶段目标

这阶段是真正开始“动手”了。信息收集、漏洞分析、工具联动,一样不能少。

熟练运用漏洞挖掘及 SRC 漏扫工具,具备独立挖掘常见漏洞及 SRC 平台漏扫实战能力,尝试通过 SRC 挖洞搞钱,不管是低危漏洞还是高危漏洞,先挖到一个。

2. 学习内容

信息收集实战:结合运维中对网络拓扑、设备信息的了解,强化基本信息收集、网络空间搜索引擎(Shodan、ZoomEye)、域名及端口信息收集技巧,针对企业级网络场景开展信息收集练习(为 SRC 漏扫目标筛选提供支撑)。

漏洞原理与分析:深入学习 SQL 注入、CSRF、文件上传等常见漏洞的原理、危害及利用方法,结合运维工作中遇到的类似问题进行关联分析(明确 SRC 漏扫重点漏洞类型)。

工具进阶与 SRC 漏扫应用:

-

系统学习 SQLMap、BurpSuite、AWVS 等工具的高级功能,开展工具联用实战训练;

-

专项学习 SRC 漏扫流程:包括 SRC 平台规则解读(如漏洞提交规范、奖励机制)、漏扫目标范围界定、漏扫策略制定(全量扫描 vs 定向扫描)、漏扫结果验证与复现;

-

实战训练:使用 AWVS+BurpSuite 组合开展 SRC 平台目标漏扫,练习 “扫描 - 验证 - 漏洞报告撰写 - 平台提交” 全流程。

SRC 实战演练:选择合适的 SRC 平台(如补天、CNVD)进行漏洞挖掘与漏扫实战,积累实战经验,尝试获取挖洞收益。

恭喜你,如果学到这里,你基本可以下班搞搞副业创收了,并且具备渗透测试工程师必备的「渗透技巧」、「溯源能力」,让你在黑客盛行的年代别背锅,工作实现升职加薪的同时也能开创副业创收!

如果你想要入坑黑客&网络安全,笔者给大家准备了一份:全网最全的网络安全资料包需要保存下方图片,微信扫码即可前往获取!

因篇幅有限,仅展示部分资料,需要点击下方链接即可前往获取