吴恩达发布论文自动审阅器,ICLR评审接近人类水平

AI正在改变学术论文评审的游戏规则。

斯坦福大学教授吴恩达近日发布了一款创新的Agentic Reviewer(智能体审稿人)工具,旨在解决学术圈长期存在的论文评审周期过长问题。这款工具在ICLR 2025审稿数据上的测试表现令人惊讶——AI与人类审稿人的相关性达到0.42,甚至超过了两位人类审稿人之间的0.41相关性。

六年被拒六次,催生评审革命

吴恩达创建这一工具的动机源于亲身经历。他的一位学生三年内论文被拒六次,每次都要等待约六个月的审稿结果。如此缓慢的反馈循环,在技术飞速迭代的今天显得格外不合时宜。 他想看看智能体工作流是否能帮助研究人员更快地迭代。这个项目最初只是他的周末兴趣项目,后在博士生Yixing Jiang的帮助下不断完善。

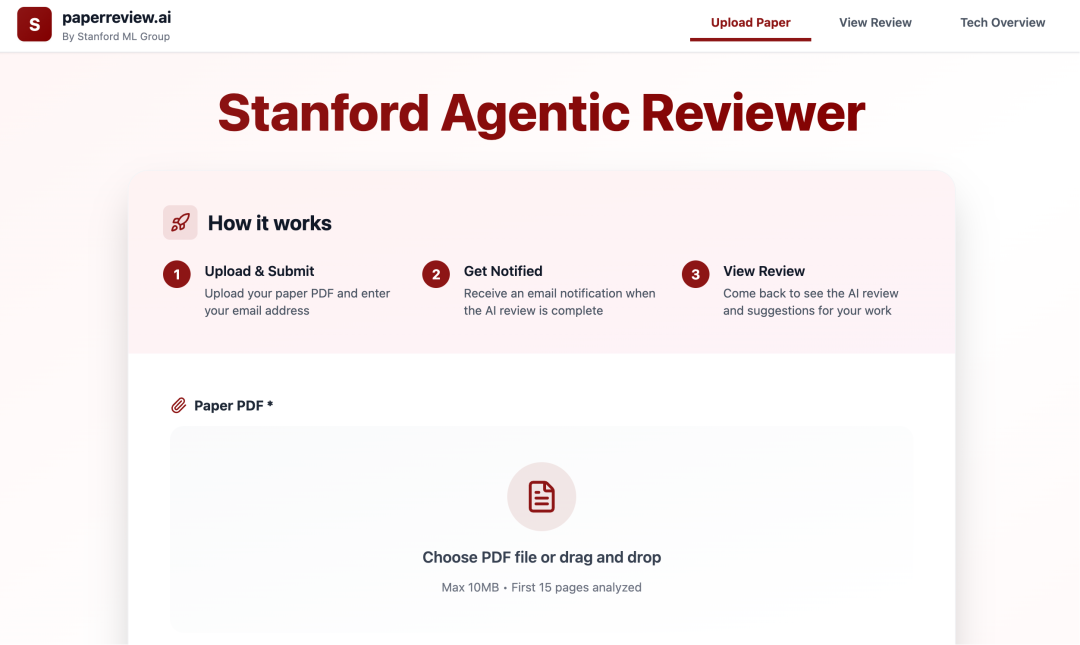

如何使用:三步获得专业评审

工具通过检索arXiv数据库来生成有依据的反馈,因此在人工智能等主要发表在arXiv上的领域表现最好。Agentic Reviewer目前仍处于实验阶段,访问地址。

学术圈反响:加速科研与多样性担忧并存

学术界对该工具普遍持积极态度。有网友指出,特定会议的定制化训练才是真正的突破点。当AI能给出你的论文在ICLR得分6.5,但在NeurIPS得分7.2这样的策略性建议时,peer review就从随机抽奖变成了数据驱动的精准定位。 6个月的反馈循环对研究人员非常残酷,使用AI代理加速同行评审可能具有变革性,一位网友评论道,真正价值在于将学习周期从数年缩短到数周。

然而也有担忧声音:这是否会导致提交到会议的论文类型趋于一致?当研究者在投稿前都使用同一AI工具预审,学术多样性是否会受影响?

未来展望:AI如何重塑学术生态

尽管ICLR等会议已出台严格的大模型使用规则——ICLR要求必须披露大模型使用情况,CVPR甚至禁止在任何阶段使用大模型撰写审稿意见——但现实是,在ICLR 2026会议上,仍有五分之一审稿意见疑似由大模型生成。

随着AI在学术评审中的渗透加深,传统的学术交流体系正面临深刻变革。当研究者与审稿人双双借助AI工具,学术评价体系将走向何方,仍需我们持续观察。 AI正在成为科研加速器,但如何平衡效率与学术多样性,将是智能时代学术圈必须面对的新课题。

Lab4AI.cn提供实验平台,提供一站式科研工具链!

👉一键直达

593

593

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?