1.安装Spark

参考网址:http://dblab.xmu.edu.cn/blog/1187-2/

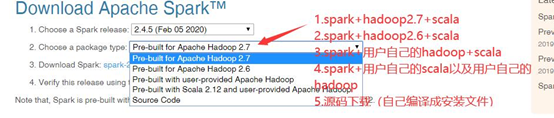

下载第一个

2.环境变量配置

命令:gedit /etc/profile (或者用vim)

export JAVA_HOME=/home/roger/jdk1.8.0_221

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

本文详细介绍了在Linux环境下安装和配置Apache Spark集群的过程,包括Spark的安装、环境变量配置、Spark配置修改、Hadoop及其它相关软件的环境变量设置、Spark集群的启动与关闭步骤。此外,还提供了将Spark和环境变量发送到各节点的方法。

本文详细介绍了在Linux环境下安装和配置Apache Spark集群的过程,包括Spark的安装、环境变量配置、Spark配置修改、Hadoop及其它相关软件的环境变量设置、Spark集群的启动与关闭步骤。此外,还提供了将Spark和环境变量发送到各节点的方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

866

866

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?