Claude是美国人工智能公司Anthropic研发的核心通用大语言模型系列,二者构建了“技术研发—产品落地”深度绑定的关系。Anthropic秉持“安全可控的AI系统”这一核心研发目标,借助Constitutional AI(宪法人工智能)等底层技术,赋予Claude低幻觉、强抗越狱能力以及长文档理解等特性,使其成为Anthropic前沿研究成果的核心商业化载体。随着Claude多版本迭代(像Opus、Sonnet、Haiku)以及生态的不断扩展(API、云平台合作),Anthropic在企业级AI市场的份额逐步增长。

然而2025年9月5日,Anthropic官方发布《关于特定地区服务调整的声明》,明确自即日起,不再向中国实体直接或间接控股比例≥50%的企业提供Claude系列服务,涵盖全版本模型及API接口,并且禁止通过海外子公司或者第三方云服务商(例如AWS、GCP)中转调用。

这一政策不仅直接冲击国内数万家依赖Claude的企业,更标志着全球AI服务格局在合规与技术壁垒的交织下,发生重大重构。本文将从政策背景、技术影响以及替代方案这三个关键维度,为企业提供全面且极具实操性的分析。

Claude限令的核心内容与时间线

要透彻理解此次限令所带来的冲击,有必要先梳理Anthropic近半年围绕Claude的产品动态与政策转向逻辑。此次限令并非毫无征兆,而是模型迭代、安全策略以及地缘合规这三重因素共同作用下的必然结果。

一、限令核心条款:明确“禁止范围”与“执行标准”

依据Anthropic官方声明以及补充说明文件,此次限令的核心约束可从三个层面进行解读:

1、主体界定:“中国控股企业”的范畴包括直接持股≥50%的中国内地企业,以及通过VIE架构、离岸公司(像开曼、BVI实体)间接控股≥50%的境外子公司;倘若企业股东中存在中国政府背景基金(持股≥10%),即便控股比例不足50%,同样被纳入限制范围。

2、服务范围:禁止提供的服务涵盖Claude Pro订阅、API接口调用(包含Opus、Sonnet、Haiku全系列模型)以及企业级定制服务(例如私有部署)。特别强调“禁止中转使用”,这意味着通过海外关联公司账户、第三方云服务商的“代理接口”调用Claude,均会被视作违规行为,一旦检测到,将面临永久封禁账号的处罚。

3、执行时间:2025年9月5日起立即生效,已付费的企业用户可在30天内申请退款,但需要提交“未使用服务证明”;个人用户目前未被全面禁止,但声明中提及“将根据后续监管要求调整”,这意味着个人用户未来也存在潜在风险。

二、政策转向时间线——从“功能扩张”到“合规收缩”

回顾2025年Anthropic围绕Claude的关键动作,能够清晰地看到其从技术优先向合规优先转变的路径:

-

5月23日:Claude 4系列发布,强化企业级能力

Anthropic推出Claude 4(包含Opus 4、Sonnet 4),核心升级亮点颇多,如“混合思考模式”(能够实现近即时响应与扩展推理的灵活切换)、并行工具调用(支持同时执行代码、分析文件、查询数据库)以及Code功能正式上线(在SWE - Bench基准测试中,代码生成准确率达到89.7%,超越GPT - 4 Turbo)。当时,Anthropic将重心放在抢占企业级AI市场上,国内的互联网、金融、制造业企业纷纷成为Claude的重要客户群体,在发布后的2个月内,其API调用量增长了300%。 -

8月16日:上线“主动结束对话”功能,强化安全管控

为了应对“有害指令注入”“模型蒸馏攻击”等风险,Anthropic为Opus 4、Sonnet 4新增了“主动结束对话”机制。当检测到持续性辱骂、试图绕过安全护栏(比如诱导生成恶意代码)或者大规模数据爬取等行为时,Claude会自动终止对话,并记录账号行为。这一功能的推出,被视为Anthropic“合规前置”的一个重要信号,也为后续地区性限令奠定了坚实的技术基础。 -

9月5日:发布中国控股企业限令,完成政策闭环

限令发布当天,Anthropic同步更新了《服务条款》第7.3条,明确将“遵守美国出口管制法规”列为首要义务,所提及的管制清单涵盖了美国商务部的《出口管理条例》(EAR)及《实体清单》,这间接表明此次限令与美国对AI技术地缘管控政策紧密相关,而Claude作为Anthropic的核心产品,自然成为政策执行的关键载体。

限令背后的深层逻辑——地缘政治、技术壁垒与合规风险

Anthropic此次针对中国控股企业出台限令,本质上是Claude作为“技术产品”与全球AI地缘格局、企业合规战略相互碰撞的结果。要深入理解其原因,我们需要从宏观地缘环境、中观企业战略以及微观技术风险这三个层面展开分析。

一、美国AI出口管制政策的持续升级

自2024年以来,美国对AI技术的出口管制呈现出“范围扩大化”“标准精细化”的趋势,这为Anthropic限制Claude服务提供了政策依据:

1、管制清单扩容:2024年10月,美国商务部工业与安全局(BIS)更新《出口管理条例》,将“参数规模≥1万亿token的基础模型”和“代码生成准确率≥85%的专用模型”纳入“军民两用物项”管制范围。而Claude 4(Opus 4参数规模约为1.2万亿token,代码准确率为89.7%)恰好落入这一管制区间,这使得Anthropic向中国企业提供Claude服务面临着“违反出口管制”的风险。

2、“间接转让”管控强化:2025年3月,BIS发布《关于AI技术间接转让的补充指引》,明确禁止“通过第三国实体、云服务中转提供受管制AI服务”,这正是此次Claude限令中“禁止海外中转使用”的直接政策来源。该指引特别提及“需防范中国企业通过离岸子公司规避管制”,这进一步压缩了Claude服务的合规空间。

二、Anthropic的“市场收缩”与“风险规避”

从企业战略角度来看,限令是Anthropic在融资、合规、市场竞争等多重压力下,对Claude商业化路径做出的一次调整:

1、融资与估值的合规绑定:2025年4月,Anthropic完成F轮130亿美元融资,投后估值高达1830亿美元,主要投资方包括谷歌、亚马逊等美国科技巨头。在融资协议中明确规定“需遵守美国所有出口管制法规,若因违规导致处罚,投资方有权要求回购股份”。这一约束使得Anthropic在Claude的地区性服务调整上缺乏弹性,必须将合规要求放在首位。

2、“民主利益”的政治站位:Anthropic在声明中提及“此举服务于民主国家的安全利益,防范AI技术被用于非和平目的”,这一表述与美国政府“将AI视为国家安全核心资产”的立场高度契合。从行业趋势来看,OpenAI、Google DeepMind等竞争对手已先后收紧对“高风险地区”的服务,Anthropic限制Claude对中资企业的服务,可视为行业合规的“跟随动作”,以避免独自面临监管压力。

3、财务影响的可控性评估:Anthropic在声明中承认,此次限令将导致年收入减少“数亿美元”,但这占其总营收的比例不足8%(2025年预计总营收约65亿美元)。相比之下,若因Claude服务违规面临BIS的罚款(最高可达企业年收入的20%)或技术禁运,损失将更为惨重。这一“两害相权取其轻”的财务测算,成为限令落地的重要推动因素。

三、Anthropic对Claude “技术外溢”与“数据安全”的担忧

除了宏观政策和企业战略层面的因素外,Claude自身的技术特性以及使用过程中潜藏的风险,也促使Anthropic采取激进的限令措施:

1、模型蒸馏风险:Claude 4的“扩展思考模式”支持长达100万字的上下文理解与多轮推理,这一特性使其成为“模型蒸馏”的重点目标。通过大规模投喂指令 - 响应数据,第三方有可能反向训练出性能接近Claude的“仿冒模型”。Anthropic在2025年Q2的内部报告中提到,“来自中国地区的异常API调用量增长400%,疑似存在蒸馏行为”,这成为限令的直接技术诱因。

2、数据跨境风险:企业用户在使用户户Claude时,需要上传代码、文档、业务数据等敏感信息,这些数据将存储于Anthropic的美国服务器。根据中国《数据安全法》《个人信息保护法》,关键信息基础设施运营者、处理重要数据的企业需遵守“数据出境安全评估”制度,而Anthropic未在中国境内设立数据处理机构,无法满足评估要求。若继续提供Claude服务,中国企业用户将面临“数据出境违规”风险,Anthropic也将间接违反中国法律,从而形成“双向合规冲突”。

3、“军事用途”的潜在担忧:美国政府一直对AI技术可能被用于军事领域忧心忡忡,例如自主武器系统开发、情报分析等。Anthropic在声明中特别提及“防范Claude被用于军事/情报用途”,尽管未提供具体证据,但结合美国对中国“军民融合”政策的认知,这一担忧成为限令的重要“安全背书”。

限令对国内企业的冲击:从业务中断到能力断层

对于长期依赖Claude的国内企业而言,此次限令绝非简单的“服务切换”,而是可能引发“业务中断 - 技术断层 - 成本上升”的连锁反应。需要从核心使用场景、技术依赖点以及替代难度这三个维度来评估冲击程度。

一、哪些企业受影响最严重?

根据Anthropic 2025年Q2的用户画像数据,国内使用Claude的企业主要集中在以下三个领域,受到的冲击程度各有不同:

1、软件与互联网行业(占比45%):核心使用场景包括代码生成(如复杂算法实现、多语言适配)、API文档自动生成、Bug修复与性能优化。以某头部互联网企业为例,其云原生团队借助Claude API实现了“需求文档→代码→测试用例”的全流程自动化,Claude的代码准确率在85%以上,能够减少60%的重复开发工作。限令之后,如果无法迅速找到替代模型,将直接导致开发周期延长、人力成本上升。

2、金融与咨询行业(占比30%):主要用于财报分析、风险模型构建、合规文档撰写。某股份制银行的风险管理部门利用Claude的“长上下文推理”能力,处理包含10万 + 数据点的信贷风险数据集,自动生成风险评估报告,原本需要3天的工作可缩短至4小时。若替代模型在金融领域的专业知识储备、数据准确性方面存在差距,可能会导致风险评估偏差,进而影响业务决策。

3、制造业与科研机构(占比25%):应用于工业设计优化、实验数据处理、学术论文撰写。某新能源企业借助Claude分析电池材料实验数据,辅助生成专利申请文件,其在材料科学领域的专业术语理解准确率高达92%。若替代模型的垂直领域知识不足,可能会导致专利文件撰写质量下降,影响知识产权保护。

二、国产模型需突破哪些“Claude式能力壁垒”?

国内企业对Claude的依赖,本质上是对Claude核心技术能力的认可。要实现有效的替代,国产模型需要在以下四个关键技术点上达到或接近Claude的水平:

1、长上下文理解能力:Claude 4支持100万字(约200万token)的上下文窗口,能够一次性处理完整的代码库、学术论文、行业报告等。而多数国产模型的上下文窗口仍集中在128k - 256k token(约6 - 12万字),在处理超大规模文档时往往需要进行“分段处理”,这极有可能导致上下文断裂、逻辑连贯性下降。例如,某企业在分析10万字的供应链数据报告时,Claude可以直接输出跨章节的关联分析结论,而部分国产模型则需要分5 - 6段处理,最终得出的结论完整性约下降30%。

2、代码生成与调试能力:在SWE - Bench(软件工程师基准测试)中,Claude 4(Opus)的代码修复准确率达到89.7%,并且支持Python、Java、C++等20 + 编程语言的复杂场景(如分布式系统开发、嵌入式代码编写)。虽然部分国产模型在通用代码生成方面表现出色,但在“低级别语言(如汇编)”“复杂算法(如分布式一致性协议)”“大型项目重构”等场景下,准确率仍然存在10% - 15%的差距。

3、多工具并行调用能力:Claude 4能够同时调用代码执行环境、数据库查询接口、文件解析工具(如PDF/Excel分析),并且可以自主判断工具调用顺序与参数。例如,在“分析Excel销售数据→生成可视化图表→撰写分析报告”的流程中,Claude可以自动完成工具调用与数据流转,无需人工干预。然而,多数国产模型目前仍需通过“分步调用 + 人工参数设置”来实现,流程的自动化程度较低,这在一定程度上影响了工作效率。

4、复杂推理与规划能力:在“数学推理(如微积分证明)”“逻辑链分析(如案件侦破模拟)”“多步骤任务规划(如项目管理流程设计)”等场景中,Claude 4的“扩展思考模式”能够输出清晰的推理步骤,错误率相对较低。某科研机构的测试结果显示,在数学建模竞赛题目中,Claude的解题准确率达到78%,而部分国产模型的准确率约为65% - 70%,主要差距体现在“多步骤推理的逻辑连贯性”以及“特殊场景的知识迁移能力”上。

三、业务中断风险与应对成本

限令的30天过渡期对企业而言极为紧张,短期冲击主要体现在以下两个方面:

1、业务中断风险:如果企业没有提前储备替代方案,30天后将面临Claude API调用失效、现有基于Claude的自动化流程停摆的局面。以某电商企业为例,其“用户评论情感分析→售后工单自动分类→客服响应建议生成”的全流程高度依赖Claude API,日均调用量达5万次,若无法及时切换,将导致客服响应效率下降40%,用户投诉率上升。

2、替代成本上升:企业需要投入大量人力进行“模型选型→API适配→功能测试→流程重构”,短期内成本显著增加。根据某咨询公司的测算,中型企业(500 - 1000人)完成Claude替代的平均成本约为30万 - 50万元,其中包括技术人员工时费(占比60%)、模型调用测试费用(占比25%)、流程调整成本(占比15%)。若替代模型的性能不足,企业还需额外投入“提示词优化”“微调训练”等成本,这将进一步推高支出。

国产大语言模型替代方案:从技术选型到落地路径

面对Claude限令,国内企业并非毫无应对之策。经过近3年的发展,国产大语言模型已在通用能力、垂直场景、工具链支持等方面取得了显著突破,完全有能力覆盖多数企业对Claude的使用需求。本节将从“技术选型标准”“核心替代模型对比”“落地实施路径”这三个层面,为企业提供切实可行的解决方案。

一、替代模型选型标准:四个核心评估维度

企业在选择替代模型时,应避免陷入“唯参数论”“唯基准测试论”的误区,而是要结合自身使用场景,从以下四个维度进行综合评估:

1、场景匹配度:优先选择在自身业务领域具有优势的模型。例如,软件企业应着重评估模型的“代码生成/调试能力”,金融企业应关注模型的“金融专业知识储备/合规文档撰写能力”,制造业企业则应考察模型的“工业领域知识/实验数据处理能力”。

2、技术指标达标率:核心指标包括上下文窗口大小(至少支持64k token,对于复杂场景需要达到128k +)、API响应时延(平均≤1秒,批量调用≤3秒)、准确率(通用任务≥85%,垂直任务≥80%)、并发支持量(能够满足企业峰值调用需求)。

3、工具链完整性:评估模型是否支持企业现有的工具生态,例如代码执行环境(Jupyter Notebook)、数据可视化工具(Matplotlib/Seaborn)、文档处理工具(PDF/Excel解析)以及企业内部系统(CRM/ERP)对接能力。工具链越完整,替代后的流程重构成本就越低。

4、合规与服务保障:选择在中国境内注册、具备《网络安全等级保护2.0》三级以上资质、可提供本地化部署(私有云/混合云)的厂商,以此避免数据跨境风险。同时,要评估厂商的技术支持响应速度(7×24小时优先)、故障恢复能力(SLA≥99.9%),确保服务的稳定性。

二、核心替代模型深度对比

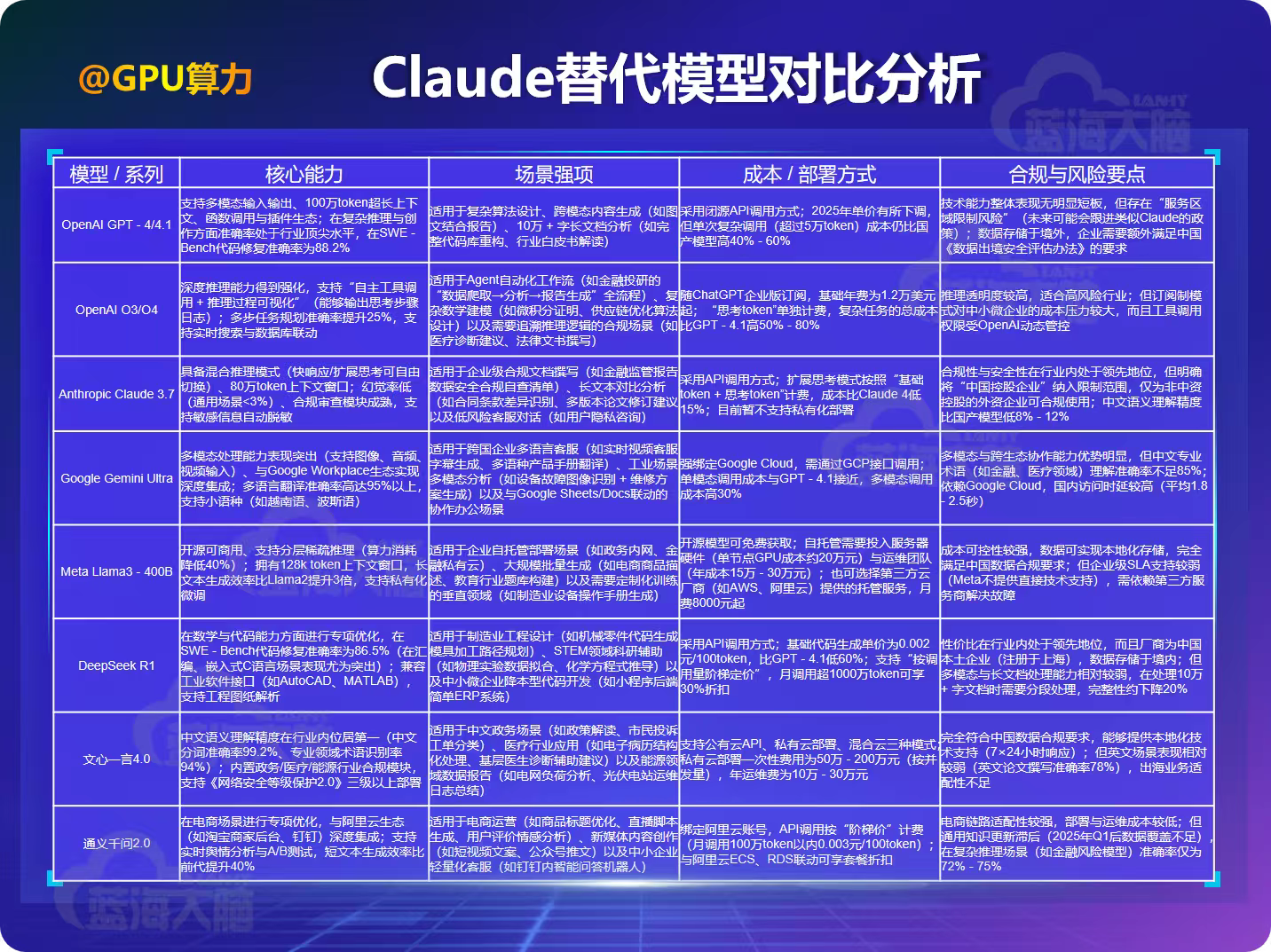

结合2025年第二季度国产大语言模型技术报告以及企业实际应用反馈,围绕“能力×场景×成本×合规”这四个关键维度,以下八款模型(包含国产主流与国际可选方案)在“Claude替代”场景中表现突出,各有侧重,能够满足不同企业的技术需求与合规要求:

1、场景 - 模型匹配优先级建议

基于上述对比分析,企业可以按照核心业务场景进行精准选型,避免采用“一刀切”的替代方式:

① 软件与互联网行业:

- 核心代码开发(如分布式系统、嵌入式软件):优先选择 DeepSeek R1(成本低、代码准确率高)或者 GPT - 4.1(在复杂算法场景表现更优);

- 长文档处理(如10万行代码库重构):可以选择 Claude 3.7(如果企业属于非中资控股),或者 GPT - 4.1(中资企业可短期过渡,同时同步测试国产模型分段处理方案);

- 中小微企业降本需求:优先考虑 Llama3 - 400B 自托管(一次性投入,长期无调用成本)。

② 金融与咨询行业:

- 合规文档与监管报告:优先选择 文心一言4.0(中文合规模块成熟)或者 Claude 3.7(如果是外资控股企业);

- 复杂投研分析(如多因子选股模型):选择 O3/O4(推理过程可追溯,便于合规审查);

- 跨境业务多语言需求:选择 Gemini Ultra(多语种翻译 + 实时搜索能力突出)。

③ 制造业与科研机构:

- 工业设计与工程开发:优先选择 DeepSeek R1(兼容工业软件接口);

- 中文科研论文撰写(如材料科学、生物医药):选择 文心一言4.0(专业术语理解精准);

- 大规模实验数据处理(如10万 + 组电池测试数据):选择 Llama3 - 400B 自托管(数据本地化存储,避免敏感信息出境)。

④ 政务与医疗行业:

- 政务服务与政策解读:唯一推荐 文心一言4.0(符合政务数据合规要求,支持本地化部署);

- 基层医疗辅助诊断:选择 文心一言4.0(内置医疗合规模块,数据不跨境)。

2、成本与风险平衡

- 总成本控制:采用“主模型 + 辅模型”组合方式,对于核心场景使用高价高性能模型(如GPT - 4.1/O3),对于长尾场景使用低价模型(如DeepSeek R1/Llama3)。例如,某金融企业“核心投研报告使用O3,日常客服用DeepSeek R1”,这样总成本可降低35% - 45%。

- 合规风险规避:中资控股企业坚决避免“海外子公司代订 + 中转调用”(例如通过香港公司订阅Claude 3.7),此类行为已被Anthropic明确列为违规,一旦检测到,将导致全球账号封禁;优先选择“境内注册厂商 + 境内数据存储”的模型(如文心一言、DeepSeek)。

- 服务连续性保障:对于关键业务(如电商大促客服、金融交易系统监控)采用“双模型冗余部署”,例如“文心一言4.0 + DeepSeek R1”,当其中一个模型服务中断时,系统能够自动切换至备用模型,确保业务中断时间控制在5分钟以内。

3、企业级视角关键差异补充

从“复杂推理、长上下文、成本、可解释性、安全稳健”这五大核心维度,进一步对比主流模型的企业级适配能力,为高风险行业(金融、政务、医疗)提供更精准的选型参考:

三、替代方案落地实施:从选型到上线的7天闭环

为了帮助企业在30天过渡期内迅速完成Claude替代,避免业务中断,精心设计了“场景定义 - 模型部署 - 测试验证 - 上线放量”的7天落地闭环方案,同时嵌入可观测、可控制、可审计能力:

1、第1 - 2天:场景分级与模型基线搭建

① 场景分级

- 核心场景(对业务连续性产生影响,如金融交易风险监控):明确SLA要求,包括响应时延≤1秒,准确率≥95%,并发支持≥1000 QPS;

- 非核心场景(如内部员工问答):SLA要求可适当放宽,响应时延≤3秒,准确率≥85%,并发支持≥100 QPS;

- 长尾场景(如用户评论自动回复):以实现降本为主要目标,SLA要求最低,响应时延≤5秒,准确率≥80%。

② 双模型基线搭建:

- 核心场景:主模型选择GPT - 4.1/文心一言4.0,辅模型选择Claude 3.7(非中资)/DeepSeek R1(中资),实现双活冗余;

- 非核心场景:主模型选择DeepSeek R1,辅模型选择Llama3 - 400B(自托管),平衡成本与性能;

- 长尾场景:单一模型选择通义千问2.0(电商)/Llama3 - 400B(其他),实现成本最大化降低。

③ 配额与权限设置:

- 对于O3/O4、GPT - 4.1等高价模型,设置“单账号日调用量 + 单任务token上限”;对于Llama3 - 400B等自托管模型,设置“GPU资源使用配额”;

- 按照岗位进行分级授权:技术岗位人员可调用所有模型,运营岗位人员仅可调用长尾场景模型,审计岗位人员仅可查看日志,不具备调用权限。

2、第3 - 5天:部署与全链路埋点

① 模型部署:

- 对于API调用模型(如GPT - 4.1、DeepSeek R1),通过企业API网关进行对接,实现统一鉴权与流量控制,避免直接暴露密钥;

- 对于私有云部署模型(如文心一言4.0、Llama3 - 400B),部署在企业内网,配置防火墙与VPN访问,仅允许指定IP段接入。

② 全链路埋点:

- 核心指标埋点:密切关注请求量、输入/输出/思考token数、工具调用次数、响应时延(P50/P90/P99)、错误率(按错误类型分类:token超限、权限不足、模型故障);

- 业务指标埋点:记录人工介入率(需要人工修改的输出占比)、结果准确率(通过抽样进行核验)、任务完成时长(从调用到输出的全流程时间);

- 审计指标埋点:记录调用账号、调用时间、输入输出内容哈希值、工具调用轨迹(如访问的数据库表名、搜索关键词)。

③ 安全与合规配置:

- 对敏感数据(如身份证号、银行卡号等信息)进行自动脱敏处理,确保输出结果中不包含原始敏感数据;

- 在数据存储方面,API调用模型的日志存储于境内服务器,保存期限不少于6个月;对于私有云模型的训练数据,仅保存在企业内网,不向第三方传输;

- 制定完善的应急响应预案,例如当主模型发生故障时,能够在5分钟内自动切换至辅模型,从而恢复业务调用。

3、第6 - 7天:小流量AB测试与决策

①小流量AB测试:

- 流量分配:抽取5% - 10%的真实业务流量,分别导入主模型与辅模型,确保输入条件保持一致(如相同的需求文档、工具调用权限)。例如,某金融企业的投研部门,将每日100份研报分析需求中的5份,同步分配给GPT - 4.1(主模型)与DeepSeek R1(辅模型),保证测试场景与实际业务完全匹配;

- 数据采集:持续监控埋点指标,详细记录两组模型的“token成本 - 响应时延 - 错误率 - 人工介入率”,形成对比数据表。以代码生成场景为例,需要重点跟踪SWE - Bench基准下的代码修复准确率(如GPT - 4.1达到88.2%,DeepSeek R1达到86.5%)、单次调用token消耗(GPT - 4.1平均8000 token,DeepSeek R1平均6500 token)、人工修改时长(GPT - 4.1需要15分钟/份,DeepSeek R1需要20分钟/份);

- 成本测算:按照“单价×token数 + 工具调用费 + 运维成本”计算单任务平均成本。以2025年市场报价为例,GPT - 4.1的token单价为0.005元/100 token,单次复杂代码生成(8000 token)成本约0.4元;DeepSeek R1单价为0.002元/100 token,相同任务成本仅为0.13元,成本差距达到3倍。若涉及工具调用(如数据库查询),需额外叠加工具使用费用,例如GPT - 4.1调用实时行情接口单次0.2元,DeepSeek R1因与国内金融数据服务商合作,调用成本可低至0.05元。

② 决策与放量:

- 达标标准:如果主模型满足SLA要求(如响应时延≤1秒、准确率≥95%、人工介入率≤5%)且成本在预算范围内,那么可以确定其为主力模型;如果辅模型性能接近主模型(如准确率差距≤3%、时延差距≤0.5秒)但成本低30%以上,那么可以替换为主力模型。例如,某政务单位选用文心一言4.0(主模型)与Llama3 - 400B(辅模型)进行测试,文心一言4.0的政策解读准确率达到94%,时延为0.8秒,虽然成本比Llama3 - 400B高40%,但满足“数据本地化 + 审计可追溯”的合规要求,最终确定为主力模型;

- 灰度放量:先将20%流量切换至目标模型,运行24小时无异常后,再逐步提升至50%、80%,最终实现100%切换。在此期间,需要设置“熔断阈值”,若某一阶段出现错误率骤升(如超过10%)、时延超标(如P99时延>3秒)或人工介入率突破15%等情况,应立即暂停放量并回滚至前一阶段。例如,某电商企业在将20%商品文案生成流量切换至通义千问2.0时,发现直播脚本生成准确率从测试期的85%降至72%,立即暂停放量,排查后发现是模型对“促销活动专属术语”理解不足,通过补充500条电商促销语微调后,再重新启动放量;

- 回滚机制:若在放量过程中出现模型服务中断、核心功能失效(如代码生成报错率超20%)等严重问题,需在5分钟内触发自动回滚机制,切换回原Claude服务(对于未到期用户)或备用模型。同时,技术团队需在1小时内出具故障分析报告,明确问题原因(如API接口超时、模型参数配置错误),并制定修复方案,防止类似问题再次发生。例如,某制造业企业在切换DeepSeek R1时,由于API网关配置错误,导致30分钟内无法调用,触发回滚机制后,通过临时启用Llama3 - 400B自托管模型,确保了生产端的设备代码生成任务未中断。

③ 决策输出与文档沉淀:

- 形成《模型选型决策报告》,在该报告中明确最终选定的主/辅模型、选型依据(包括性能、成本、合规性评分)、放量节奏以及风险应对预案。报告需经技术、业务、合规部门联合签字确认,例如某互联网企业的报告中,需注明“选定GPT - 4.1为主模型(用于核心代码场景)、DeepSeek R1为辅模型(用于长尾文案场景),因前者在分布式系统代码生成准确率高10%,后者在成本上低60%,且均通过数据出境安全评估”;

- 沉淀《AB测试数据集》,将测试过程中的输入案例、模型输出结果、人工评分记录等内容进行整理,用于后续模型优化与版本迭代。例如,将测试中发现的“Claude擅长但替代模型薄弱的场景”(如10万字以上法律合同对比分析)整理成专项数据集,提交给模型厂商进行针对性微调,或者用于内部提示词优化(如通过增加“分章节提取关键条款”的指令,提升国产模型在长文档对比场景的表现)。

4、持续优化:上线后的月度复盘与动态调整

替代模型正式上线后,企业需要建立“月度复盘”机制,结合业务反馈与技术指标,动态优化模型配置与选型策略,避免出现“一选定终身”的僵化局面:

① 指标复盘:

每月对模型的核心指标变化情况进行统计,包括准确率(如金融合规文档撰写准确率从92%降至88%)、成本波动(如API单价上调导致月度支出增加15%)、服务稳定性(如月度故障次数从1次增至3次)。若某个指标突破预设阈值(如准确率低于85%),需启动根因分析。例如,某科研机构发现文心一言4.0在材料科学论文撰写的准确率下降,经排查后发现是模型训练数据未覆盖2025年新发表的研究成果,通过补充最新文献数据集进行微调后,准确率回升至90%;

② 场景适配调整:

随着业务场景的不断拓展,需要重新评估模型的适配性。例如,某电商企业新增“跨境直播脚本生成”场景,原选用的通义千问2.0在小语种翻译(如东南亚小语种)准确率不足75%,此时需引入Gemini Ultra作为辅模型,利用其多语言优势弥补短板,形成“通义千问2.0(中文脚本) + Gemini Ultra(小语种翻译)”的组合方案;

③ 成本优化:

根据调用量变化情况调整部署方式,如果某模型月度调用量突破1亿token,可以与厂商协商阶梯定价(如调用量超1亿token后单价下调20%);若自托管模型的GPU利用率长期低于50%,可减少服务器节点(如从8台A100缩减至5台),从而降低运维成本。例如,某政务单位的Llama3 - 400B自托管集群,通过优化任务调度算法,将GPU利用率从45%提升至70%,年运维成本减少了20万元;

④ 合规更新:

密切跟踪国内外AI监管政策的变化,及时调整模型配置。例如,若中国《生成式AI服务管理暂行办法》新增“生成内容需标注来源”的要求,需在文心一言4.0的输出结果中自动添加“模型生成,仅供参考”标识;若美国进一步收紧AI出口管制,需立即停止使用GPT - 4.1处理敏感业务(如涉及核心技术的代码生成),并全面切换至国产模型。

行动建议

Anthropic对中资企业实施Claude服务限制,这一事件不仅是全球AI地缘格局发生变化的一个缩影,也倒逼国内企业加速推进“国产大模型替代”进程,助力实现“技术自主可控”目标。从短期来看,企业需要在30天过渡期内完成“替代模型选型 - 测试 - 上线”的闭环,以避免业务中断;从长期来看,企业需要建立“多模型冗余 + 动态优化 + 合规前置”的AI服务体系,降低对单一海外模型的依赖程度。

一、紧急行动(1周内):

企业应立即成立“Claude替代专项小组”,小组成员应涵盖技术、业务、合规等多个部门,明确各部门的分工(例如技术部门负责模型测试,合规部门负责数据出境评估),并制定详细、可行的落地时间表,确保在30天内完成核心业务的模型切换工作;

二、选型原则:

中资企业应优先选择“境内注册厂商 + 本地化部署”的国产模型(如文心一言4.0、DeepSeek R1),以此满足数据合规要求;外资企业可以考虑短期使用Claude 3.7(非中资控股)或GPT - 4.1,但需要预留替代方案,防范未来政策发生变化带来的风险;

三、风险规避:

企业应采用“主模型 + 辅模型”双供应商策略,例如选择“文心一言4.0(主) + Llama3 - 400B(辅)”,避免因单一模型服务中断而导致业务停摆;同时,所有模型调用都应通过企业API网关进行统一管控,严禁员工使用个人账号调用海外模型,防止数据泄露;

四、长期布局:

针对核心业务场景(如金融投研、工业设计),企业应投入必要资源进行国产模型的微调训练(例如基于企业私有数据优化模型的垂直领域能力),逐步实现“模型能力定制化 + 服务自主可控”,从而减少对外部模型的技术依赖程度。

面对全球AI服务格局的重构,国内企业无需过度恐慌,而应将此次限制视为“技术升级”的一个契机。通过实施精准选型、科学落地以及持续优化等策略,国产大语言模型完全能够满足多数业务场景的需求,甚至在中文理解、垂直行业适配等领域实现超越,助力企业在激烈的市场竞争中保持领先地位。

Claude限令#Anthropic#大语言模型#合规风险#长上下文理解#代码生成#多工具调用#国产模型#主流模型企业级适配能力

Claude限令与国产模型替代方案

Claude限令与国产模型替代方案

1032

1032

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?