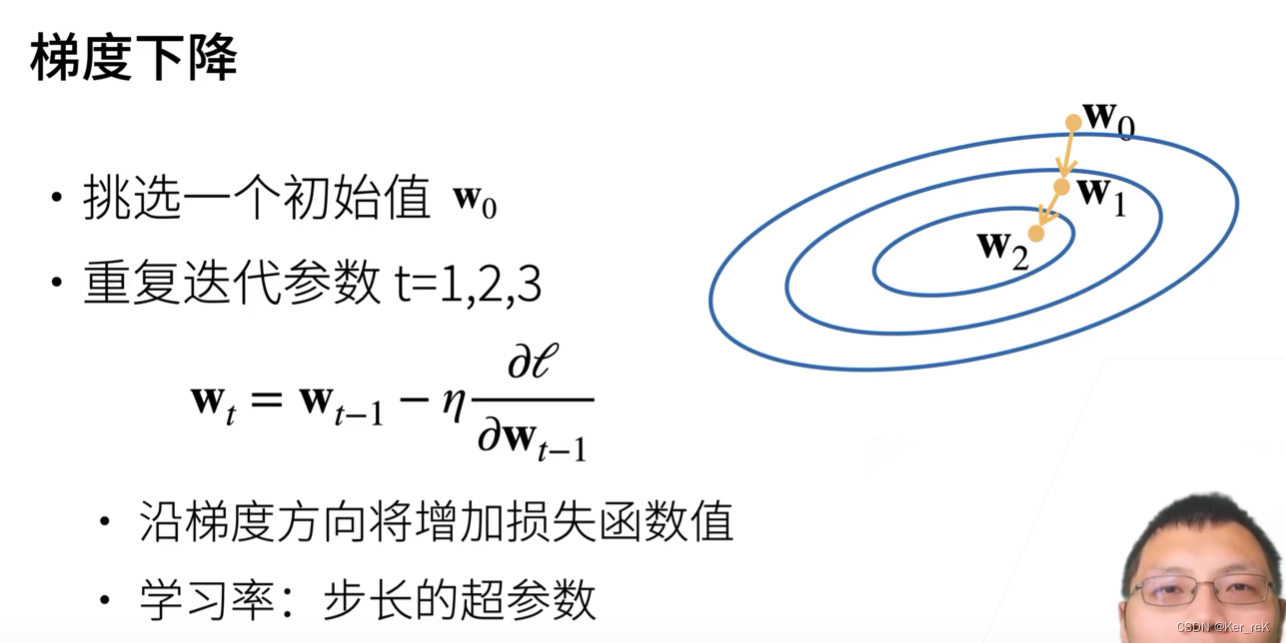

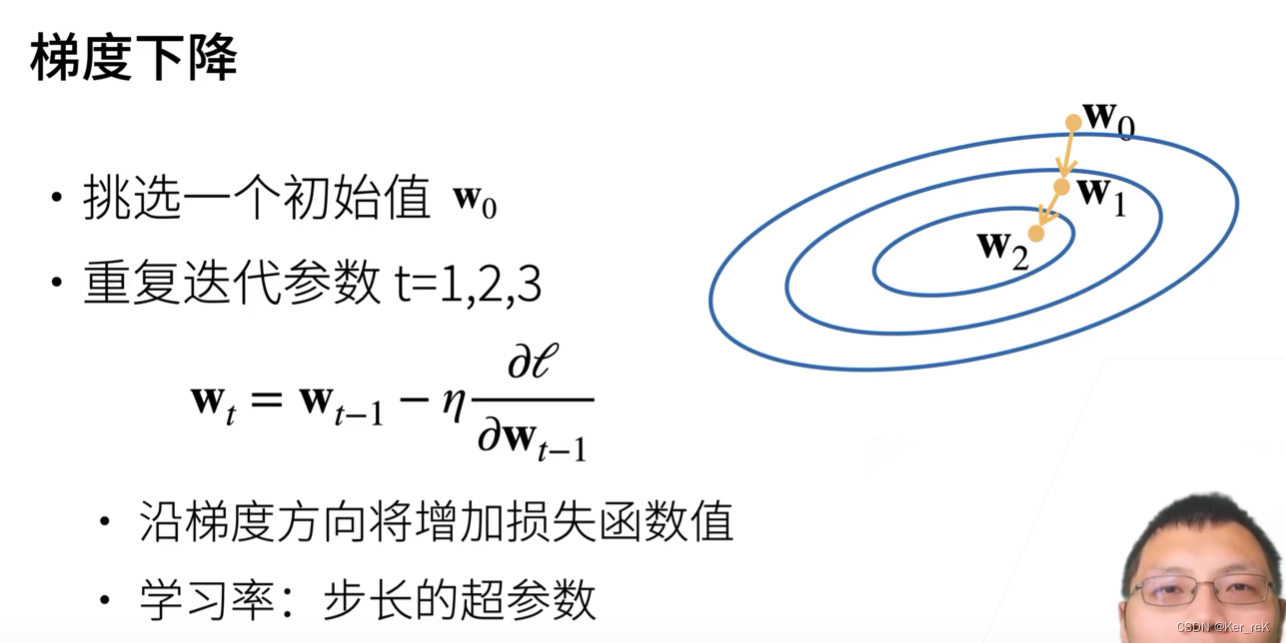

一、梯度下降 (当模型没有显示解时)

选择学习率时,不能太小(每次走的步长有限,需要走很多步骤),也不能太大

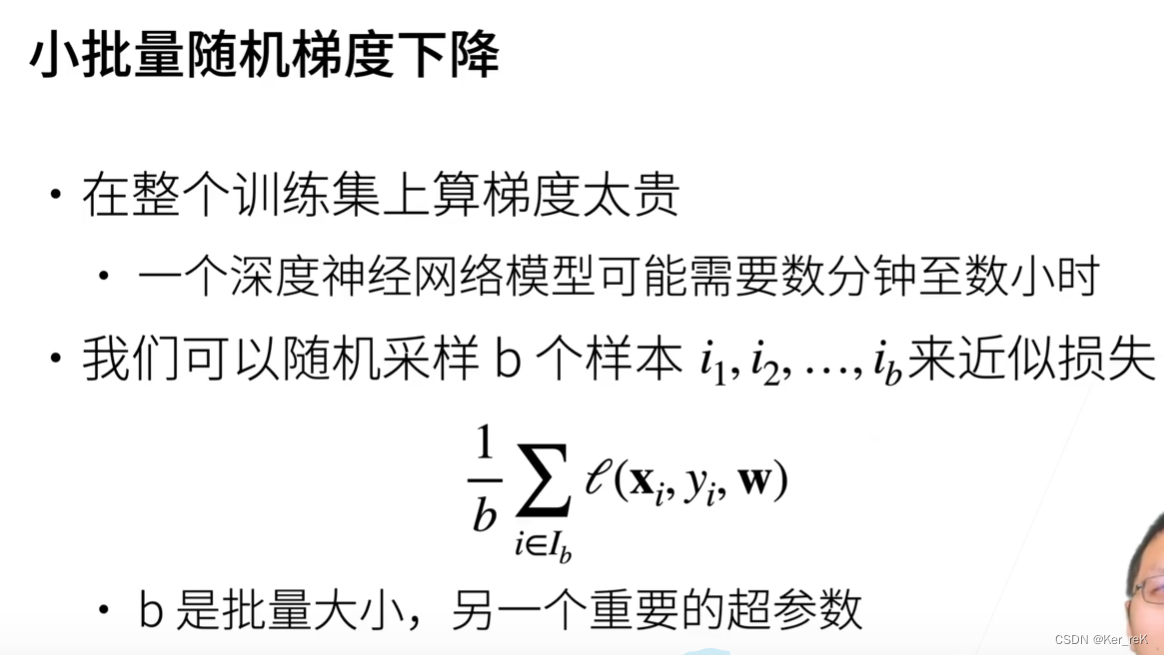

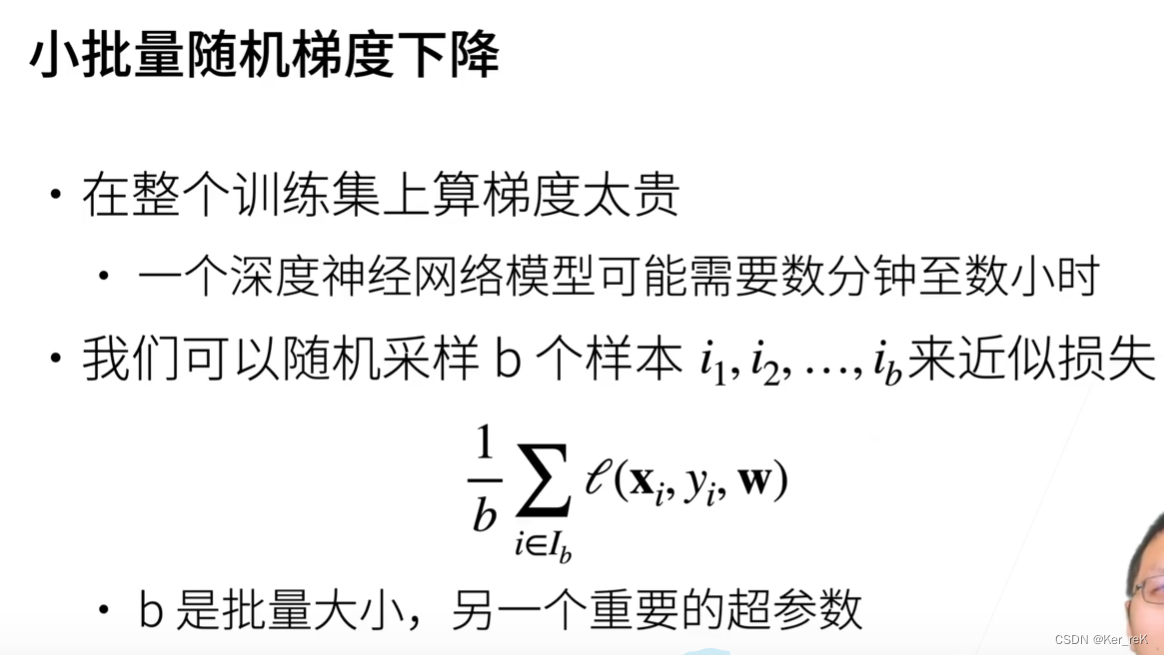

二、小批量随机梯度下降

选择批量大小时,不能太大,也不能太小:

1.太小:每次计算量太小,不适合并行来最大利用计算资源

2.太大:内存消耗增加,浪费计算

三、总结

本文探讨了在没有显式解的情况下如何选择梯度下降的学习率,强调了学习率不宜过大或过小的影响。接着介绍了小批量随机梯度下降,分析了批量大小选取的平衡点,指出批量太小可能导致计算效率低下,而太大则会增加内存消耗。总结了在实际优化过程中如何权衡这两者以实现更高效的训练过程。

本文探讨了在没有显式解的情况下如何选择梯度下降的学习率,强调了学习率不宜过大或过小的影响。接着介绍了小批量随机梯度下降,分析了批量大小选取的平衡点,指出批量太小可能导致计算效率低下,而太大则会增加内存消耗。总结了在实际优化过程中如何权衡这两者以实现更高效的训练过程。

一、梯度下降 (当模型没有显示解时)

选择学习率时,不能太小(每次走的步长有限,需要走很多步骤),也不能太大

二、小批量随机梯度下降

选择批量大小时,不能太大,也不能太小:

1.太小:每次计算量太小,不适合并行来最大利用计算资源

2.太大:内存消耗增加,浪费计算

三、总结

1701

1701

256

256

1371

1371

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?