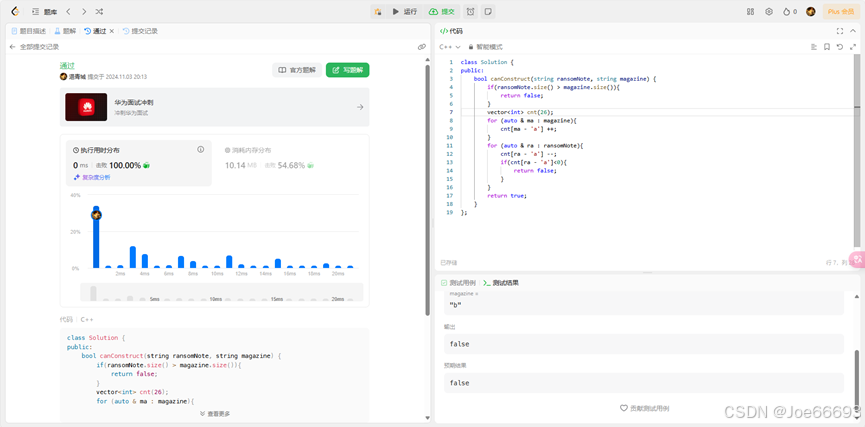

闯关任务:Leetcode 383 赎金信

class Solution {

public:

bool canConstruct(string ransomNote, string magazine) {

if(ransomNote.size() > magazine.size()){

return false;

}

vector<int> cnt(26);

for (auto & ma : magazine){

cnt[ma - 'a'] ++;

}

for (auto & ra : ransomNote){

cnt[ra - 'a'] --;

if(cnt[ra - 'a']<0){

return false;

}

}

return true;

}

};

这题我的方法比较原始,就是计数。

闯关任务:Vscode连接InternStudio debug笔记

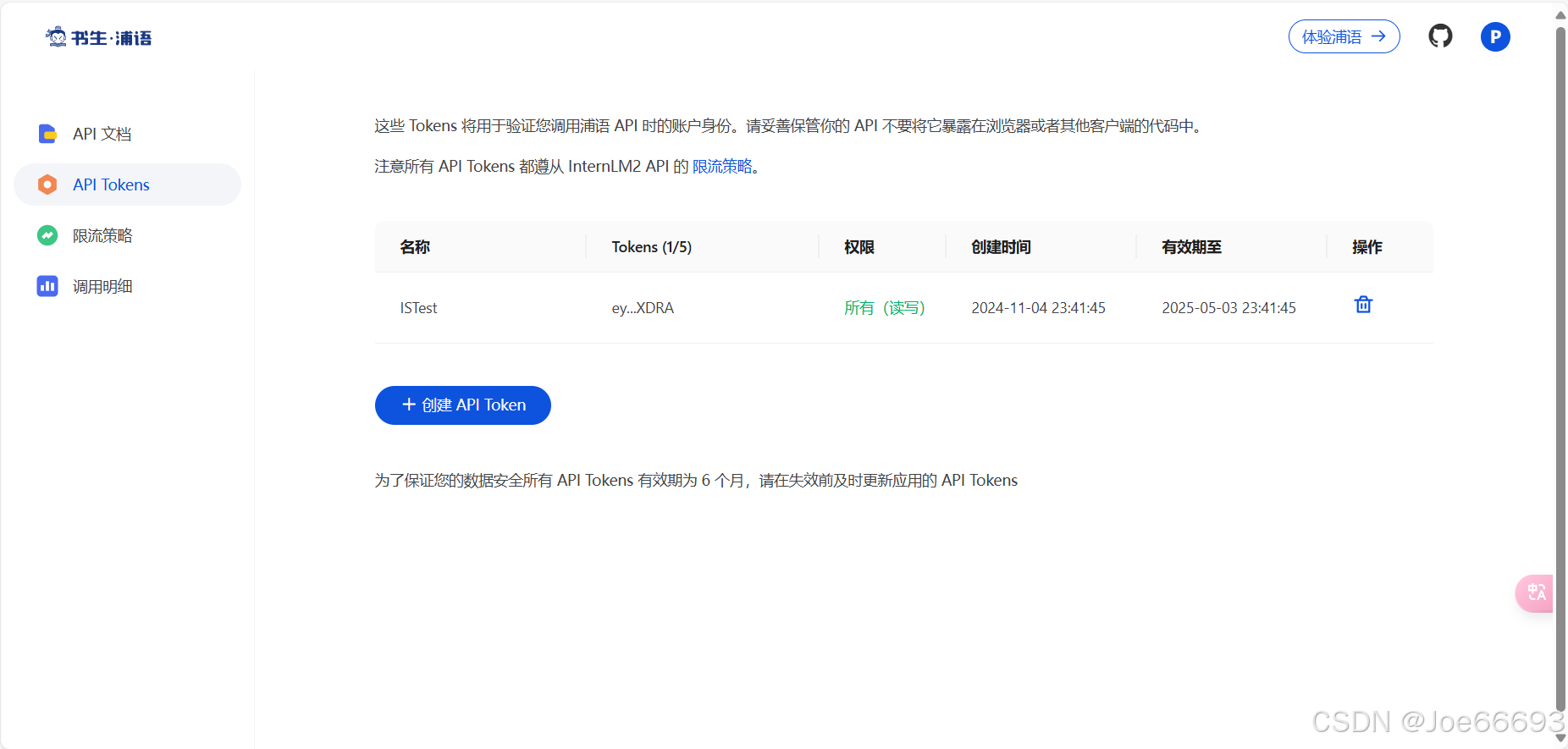

先上书生浦语平台申请API:https://internlm.intern-ai.org.cn/api/tokens![]() https://internlm.intern-ai.org.cn/api/tokens

https://internlm.intern-ai.org.cn/api/tokens

然后用API来调试代码:

from openai import OpenAI

import json

def internlm_gen(prompt,client):

'''

LLM生成函数

Param prompt: prompt string

Param client: OpenAI client

'''

response = client.chat.completions.create(

model="internlm2.5-latest",

messages=[

{"role": "user", "content": prompt},

],

stream=False

)

return response.choices[0].message.content

api_key = ''

client = OpenAI(base_url="https://internlm-chat.intern-ai.org.cn/puyu/api/v1/",api_key=api_key)

content = """

书生浦语InternLM2.5是上海人工智能实验室于2024年7月推出的新一代大语言模型,提供1.8B、7B和20B三种参数版本,以适应不同需求。

该模型在复杂场景下的推理能力得到全面增强,支持1M超长上下文,能自主进行互联网搜索并整合信息。

"""

prompt = f"""

请帮我从以下``内的这段模型介绍文字中提取关于该模型的信息,要求包含模型名字、开发机构、提供参数版本、上下文长度四个内容,以json格式返回。

`{content}`

"""

res = internlm_gen(prompt,client)

res_json = json.loads(res)

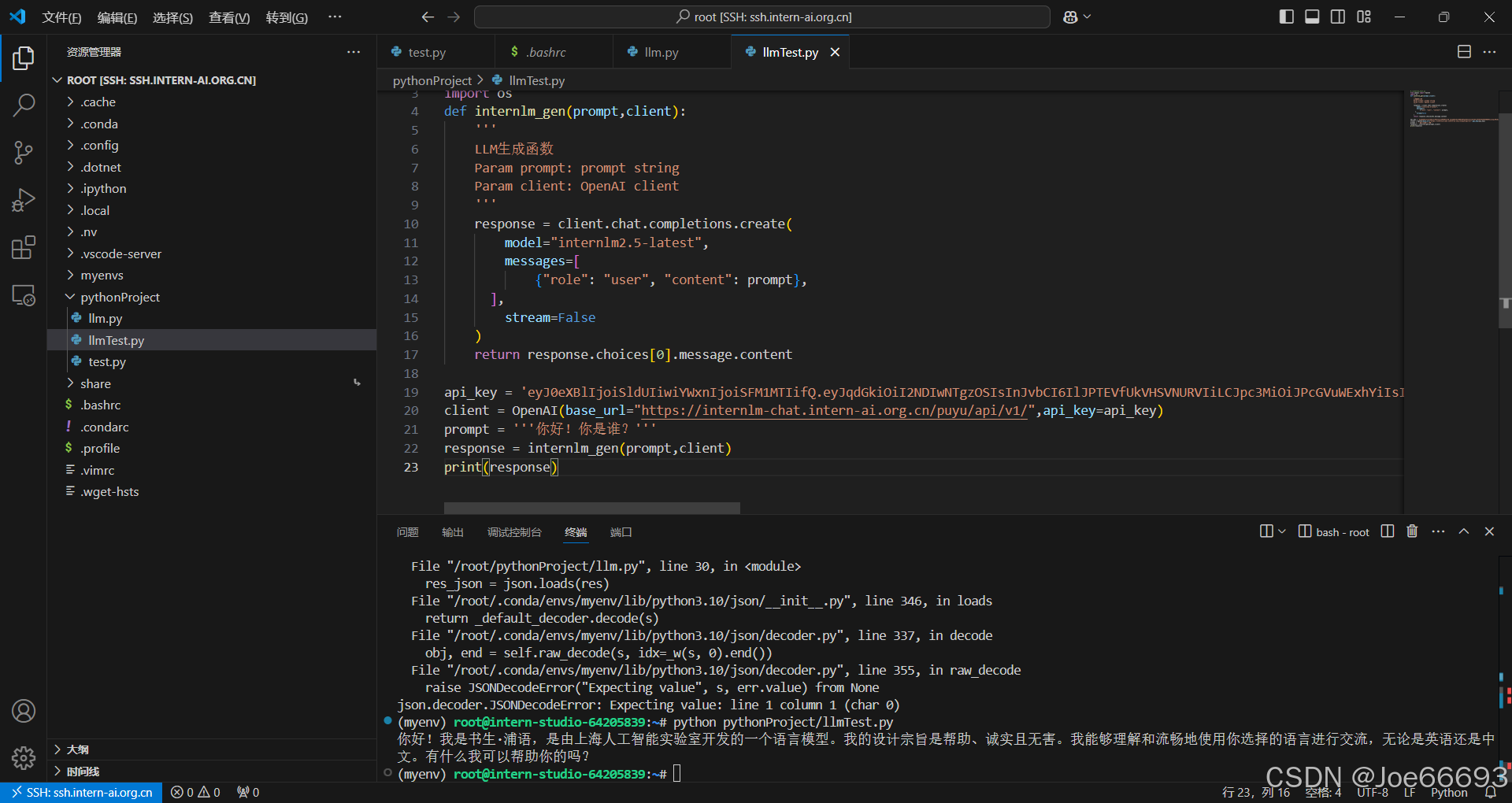

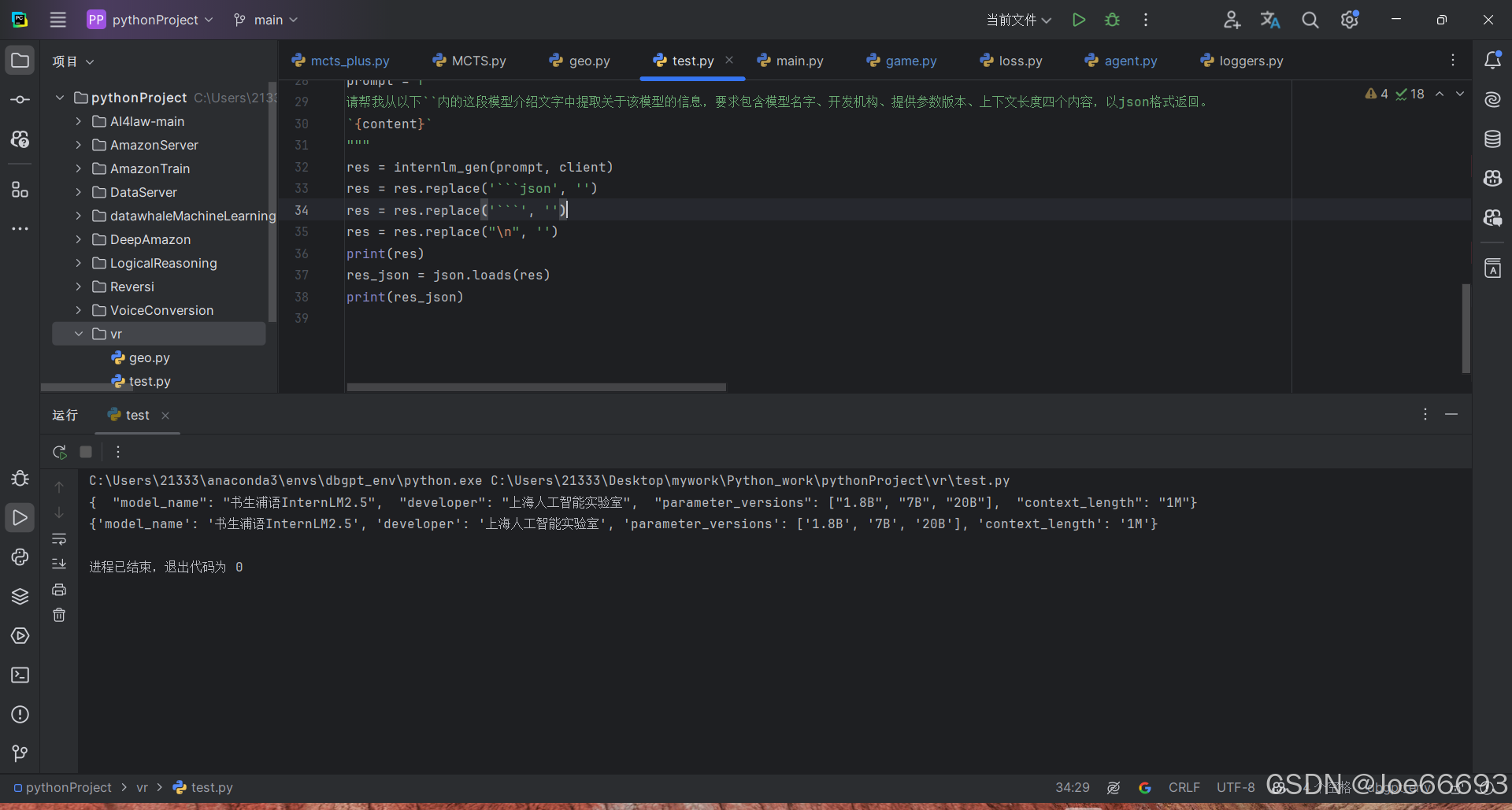

print(res_json)在调试之前,我们可以看到教程的代码是能跑的:(露出了一些key,但是无伤大雅)

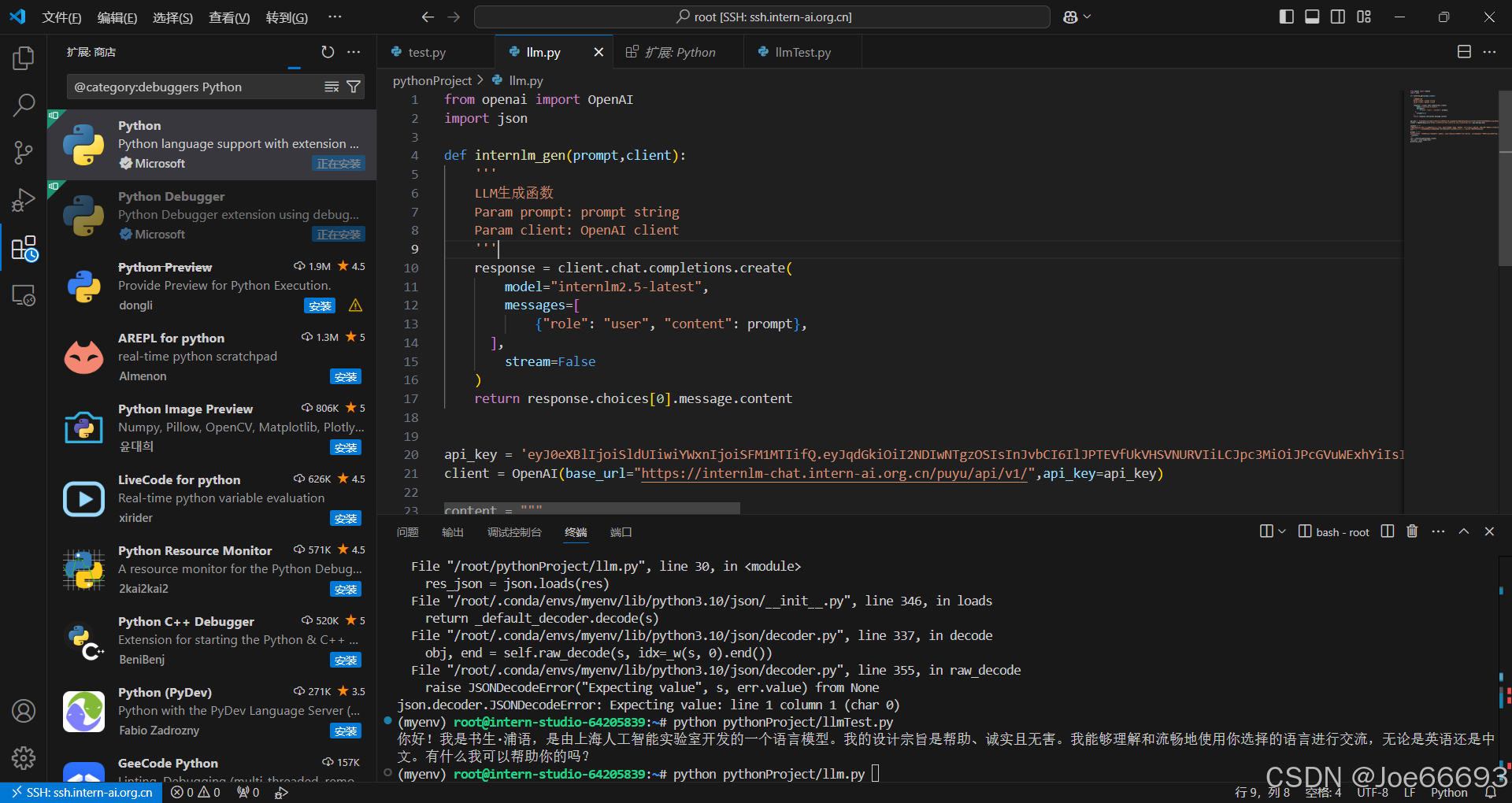

关于调试,我一直安不上python插件,就在本地的pycharm上调试了:

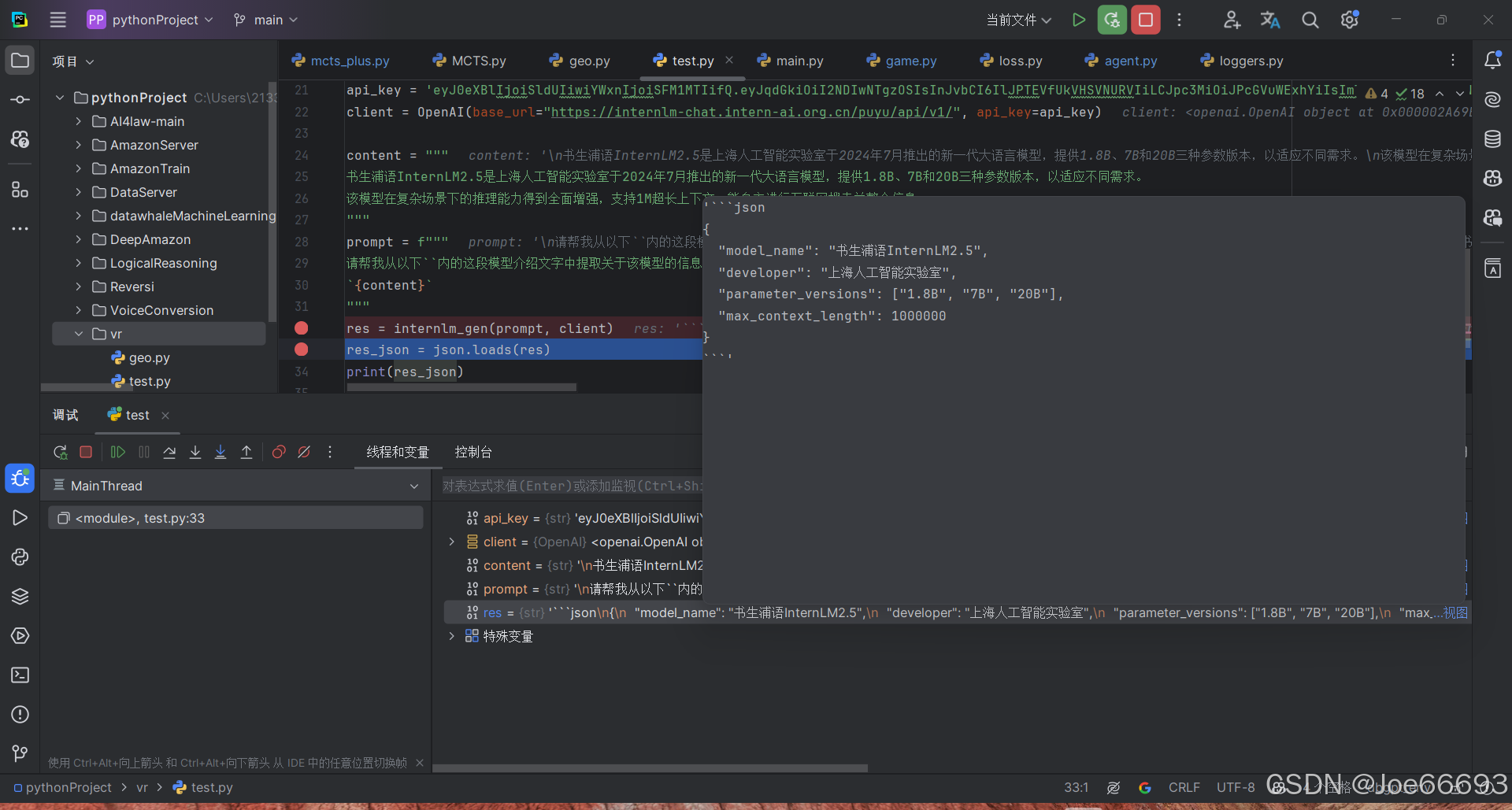

调试发现返回的不是json数据:

进行数据格式调整即可:

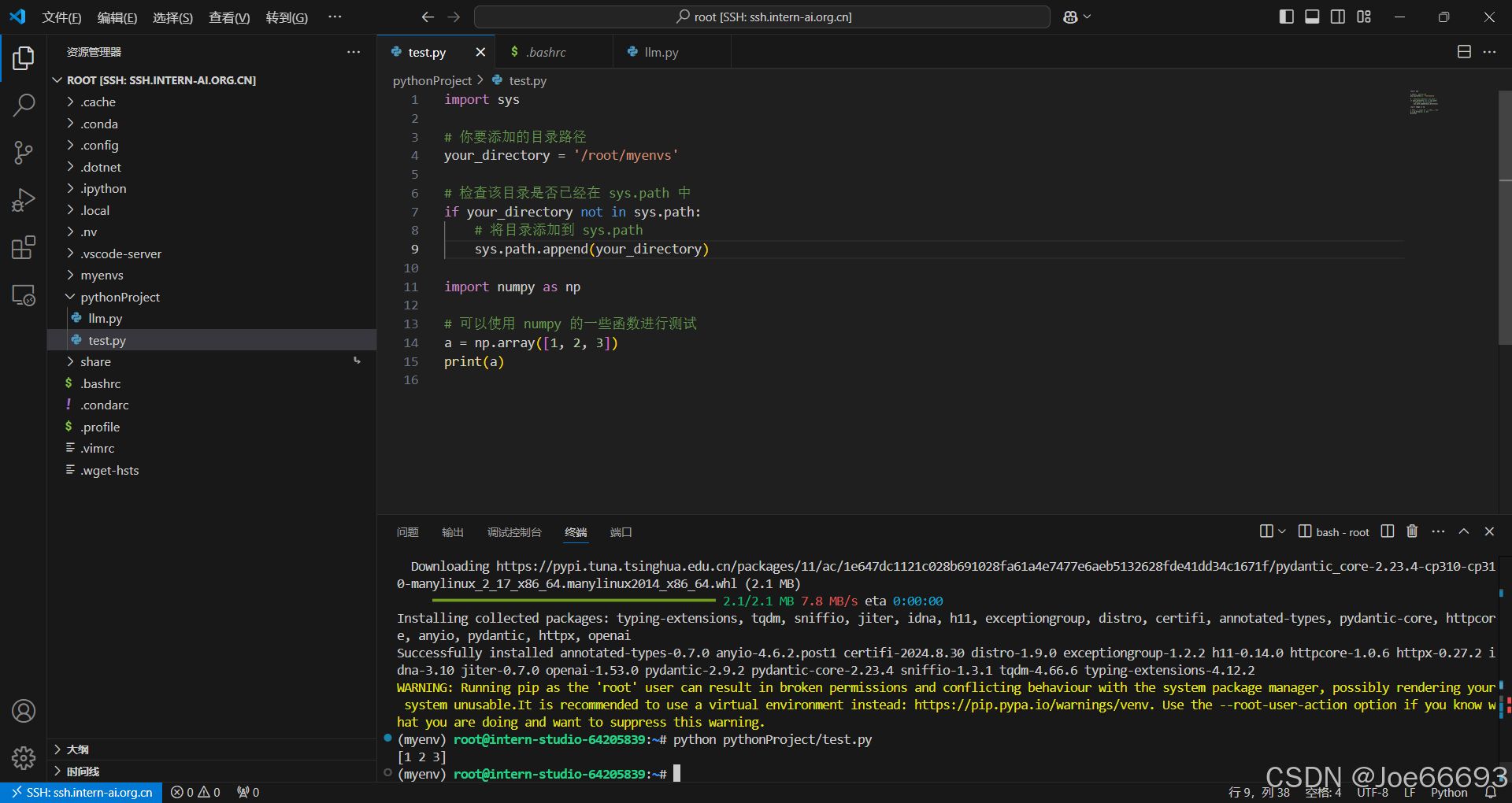

可选任务:pip安装到指定目录

一、安装 numpy 到指定目录

- 打开 VScode 的终端(Terminal)菜单,选择 “新建终端”。

- 在终端中输入以下命令安装 numpy 到

/root/myenvs目录:

pip install -t /root/myenvs numpy

二、创建并引用 numpy 的 Python 文件

- 在开发机上创建一个新的 Python 文件,可以使用 VScode 的文件操作功能来完成。

- 在新建的 Python 文件中添加以下代码来引用 numpy:

import sys

# 你要添加的目录路径

your_directory = '/root/myenvs'

# 检查该目录是否已经在 sys.path 中

if your_directory not in sys.path:

# 将目录添加到 sys.path

sys.path.append(your_directory)

import numpy as np

# 可以使用 numpy 的一些函数进行测试

a = np.array([1, 2, 3])

print(a)

952

952

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?