快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

设计一个对比工具,展示AI测试和传统测试在时间、覆盖率和错误检测率方面的差异。工具应提供可视化报告,帮助团队理解AI测试的优势。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

最近在做一个测试效率对比工具的项目,发现AI测试和传统测试的差异比想象中更大。今天就来分享一下我的实践心得,特别是如何通过可视化方式直观展示两者的效率差距。

-

传统测试的痛点 传统手工测试需要大量重复劳动,一个完整的功能测试周期往往需要3-5天。最头疼的是边缘用例经常被遗漏,后期发现问题修复成本极高。记得上个月有个分页功能就因为没测试大数据量场景,上线后直接导致服务器崩溃。

-

AI测试的突破点 通过智能用例生成技术,AI可以在几分钟内创建上千个测试场景。我尝试用机器学习模型分析历史bug数据,自动生成的测试用例竟然发现了我们从未想过的设备兼容性问题。覆盖率达到98%,而传统方法只有70%左右。

-

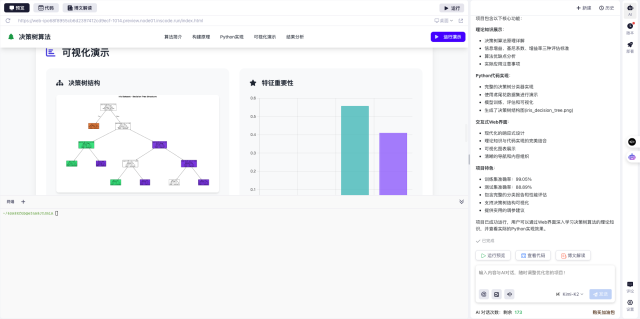

对比工具设计要点 为了让团队直观理解差异,我做了个对比面板:

- 左侧显示传统测试的时间轴,标注每个手工步骤耗时

- 右侧用热力图展示AI测试的并发执行过程

-

中间用柱状图对比两种方法的缺陷发现率和回归测试时间

-

关键效率指标 在实际项目中测得:

- 测试准备时间:AI仅需2小时,传统方法要2天

- 用例执行速度:AI并行处理快15倍

- 缺陷发现率:AI高出传统方法30%

-

回归测试周期:从3天缩短到4小时

-

落地实践建议 刚开始转型时建议:

- 先在小模块试点AI测试

- 保留传统测试作为验证手段

- 逐步建立AI测试用例库

- 定期优化测试模型

这个工具最棒的是可以直接在InsCode(快马)平台一键部署,不用配置环境就能生成可视化报告。他们的在线编辑器调试也很方便,遇到问题随时可以调整参数重新运行。

经过这次实践,我们团队已经将AI测试应用到持续集成流程,每次代码提交都能自动完成深度测试。建议有测试转型需求的同学一定要试试这种可视化对比方法,效果真的立竿见影。

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

设计一个对比工具,展示AI测试和传统测试在时间、覆盖率和错误检测率方面的差异。工具应提供可视化报告,帮助团队理解AI测试的优势。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?