快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个基于Vision Transformer的智能图像分类应用。功能要求:1. 用户上传图片后,系统自动分割为16x16 patches并输入ViT模型;2. 使用预训练的ViT-B/16模型进行图像分类,支持1000类ImageNet类别识别;3. 展示分类结果及置信度,支持多结果排序;4. 提供API接口供其他系统调用;5. 包含响应式前端界面,实时显示处理过程。技术栈:Python+PyTorch,利用HuggingFace的transformers库加载预训练模型,前端使用Vue.js。部署后可通过URL直接访问。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

最近在研究计算机视觉领域的前沿技术,发现Vision Transformer(ViT)模型在图像分类任务上表现非常出色。作为一个技术爱好者,我决定尝试用InsCode(快马)平台来快速搭建一个基于ViT的智能图像分类应用。整个过程比想象中简单很多,下面分享我的实践心得。

-

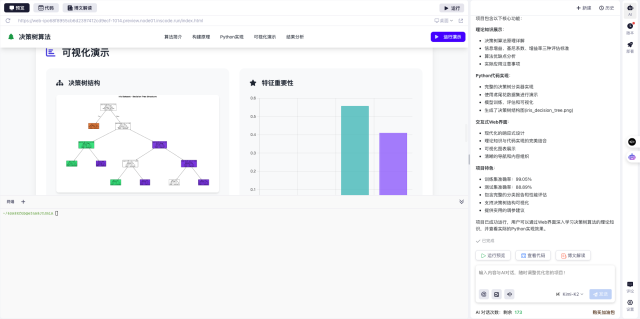

项目构思与准备 我想做一个能识别日常物品的Web应用,用户上传图片后,系统能自动给出物体类别和置信度。ViT模型正好能满足这个需求,它通过将图像分割成16x16的小块,然后用Transformer结构处理,效果比传统CNN更好。在快马平台创建新项目时,直接选择了Python环境,省去了本地配置的麻烦。

-

模型加载与处理流程 使用HuggingFace的transformers库加载预训练的ViT-B/16模型特别方便。这个模型已经在ImageNet数据集上训练过,能识别1000种常见物体类别。关键步骤包括:图片预处理(调整大小、归一化)、分割为patches、模型推理、结果解析。平台内置的代码补全功能帮我快速完成了这些代码。

-

前端界面开发 用Vue.js构建的响应式界面很清爽,主要包含上传区域、结果展示区和历史记录。上传图片后会实时显示处理进度,分类结果按置信度排序展示前5个可能类别。平台提供的实时预览功能让我能边写代码边调整UI,效率提高了不少。

-

API接口设计 为了让其他系统也能调用这个服务,我添加了简单的REST API。接口接收图片文件,返回JSON格式的识别结果。这在快马平台上一键就部署成功了,自动生成了可访问的API地址,测试起来非常方便。

-

部署上线体验 最惊喜的是部署环节。传统部署需要折腾服务器、环境配置,但在快马平台点击"部署"按钮就搞定了。系统自动处理了所有依赖项和网络配置,生成的项目URL可以直接分享给朋友测试。

实际使用感受 - 识别准确率很高,对常见物品的分类效果令人满意 - 处理速度取决于图片大小,一般2-3秒内返回结果 - 手机访问同样流畅,响应式设计适配各种设备

踩过的坑与解决方案 1. 初始加载模型较慢:通过预先加载模型到内存解决 2. 大图片处理超时:添加了前端压缩功能 3. 移动端上传兼容性问题:改用通用文件选择组件

这次实践让我深刻体会到,借助InsCode(快马)平台的AI能力和便捷部署,即使没有专业运维经验,也能快速实现一个可用的AI应用。整个过程几乎没遇到环境配置的麻烦,专注在核心功能开发上,对个人开发者和小团队特别友好。

未来打算继续探索的功能: - 增加自定义模型微调 - 开发浏览器插件版本 - 加入多模型对比测试

如果你也对AI应用开发感兴趣,强烈推荐试试这个平台,从想法到上线的路径真的缩短了很多。

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个基于Vision Transformer的智能图像分类应用。功能要求:1. 用户上传图片后,系统自动分割为16x16 patches并输入ViT模型;2. 使用预训练的ViT-B/16模型进行图像分类,支持1000类ImageNet类别识别;3. 展示分类结果及置信度,支持多结果排序;4. 提供API接口供其他系统调用;5. 包含响应式前端界面,实时显示处理过程。技术栈:Python+PyTorch,利用HuggingFace的transformers库加载预训练模型,前端使用Vue.js。部署后可通过URL直接访问。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

906

906

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?