背景

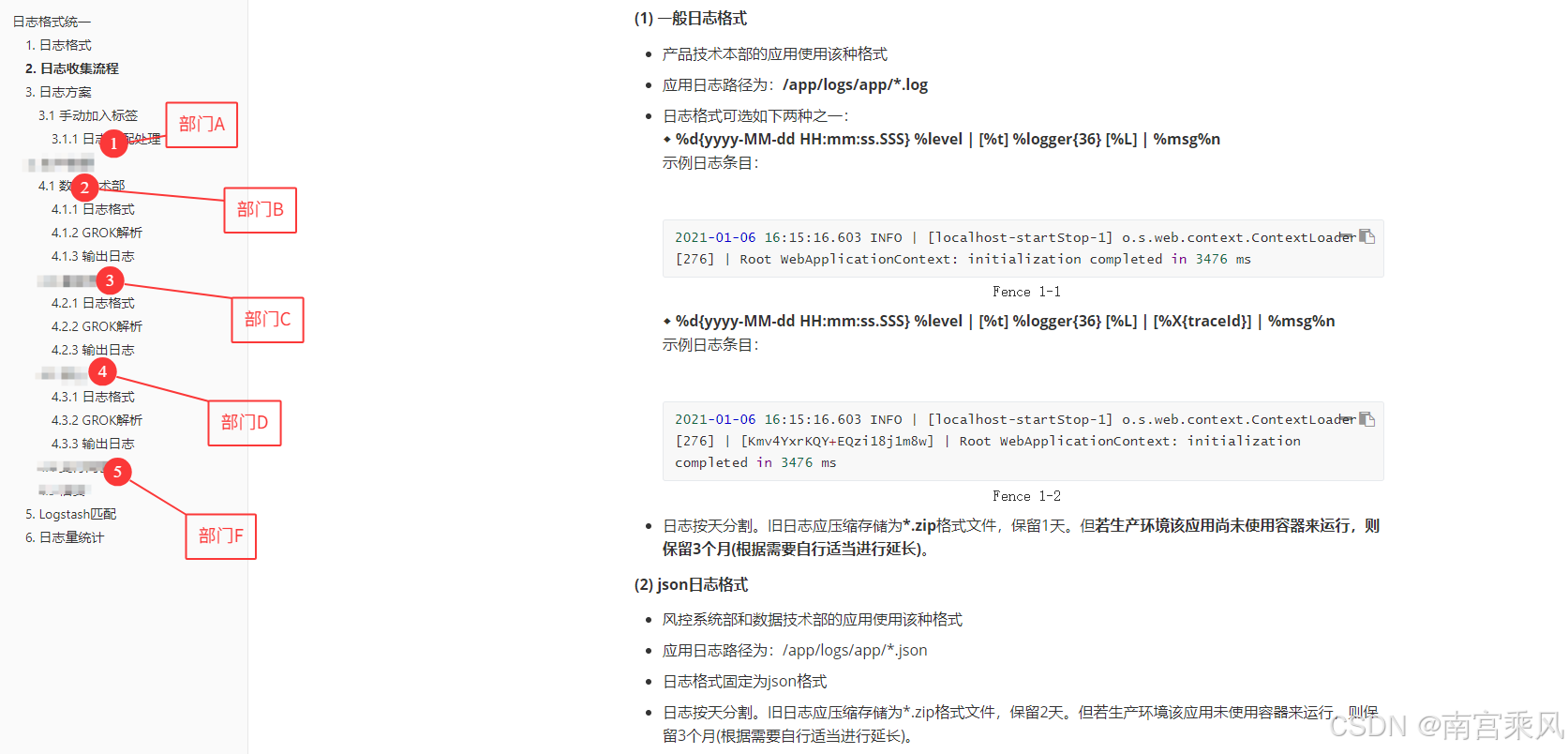

在多部门、多技术栈并存的企业环境中,日志收集与分析是保障系统稳定运行的核心能力之一。然而,不同开发团队采用各异的日志打印方式,导致日志数据结构混乱,严重影响后续的收集、存储、检索与告警效率。

比如我们大部门就有多套日志格式,不同小部门有不同的格式,导致我们运维任务和成本大幅度增加。

典型问题场景包括:

开发团队A使用Log4j,格式为[%d] %p %c - %m%n

团队B采用Logback,格式为%date %level [%thread] %logger - %msg%n

微服务C输出JSON格式日志但缺少统一字段规范

本文将介绍我们如何建立统一的日志格式规范,并基于 Filebeat + Logstash 实现多环境(宿主机/Kubernetes)下的高效日志采集、解析与存储。

为什么要统一日志格式?

遇到的问题:

- 各部门日志格式五花八门,结构不一

- 多行异常堆栈无法完整还原,频繁切段

- traceId/请求上下文缺失,无法链路追踪

- 结构化字段难以提取,告警系统误报频繁

统一格式的好处:

- 日志标准化后,便于多系统集中分析

- traceId 实现服务链路跟踪(可接入 Skywalking/Jaeger)

- 多行异常可合并为单条日志事件

- 方便在 Elasticsearch 中建立字段索引,用于筛选、聚合与报警

日志格式统一规范

在设计日志标准时,我们遵循以下关键原则:

机器可读性:便于采集工具自动解析

人类可读性:保留足够上下文,便于工程师直接阅读

完整性与高效性的平衡:包含必要字段但不过度冗余

可扩展性:支持未来增加新字段而不破坏兼容性

行业兼容性:符合主流日志框架的最佳实践

经过多轮评审,最终确定的标准日志格式为:

样例日志:

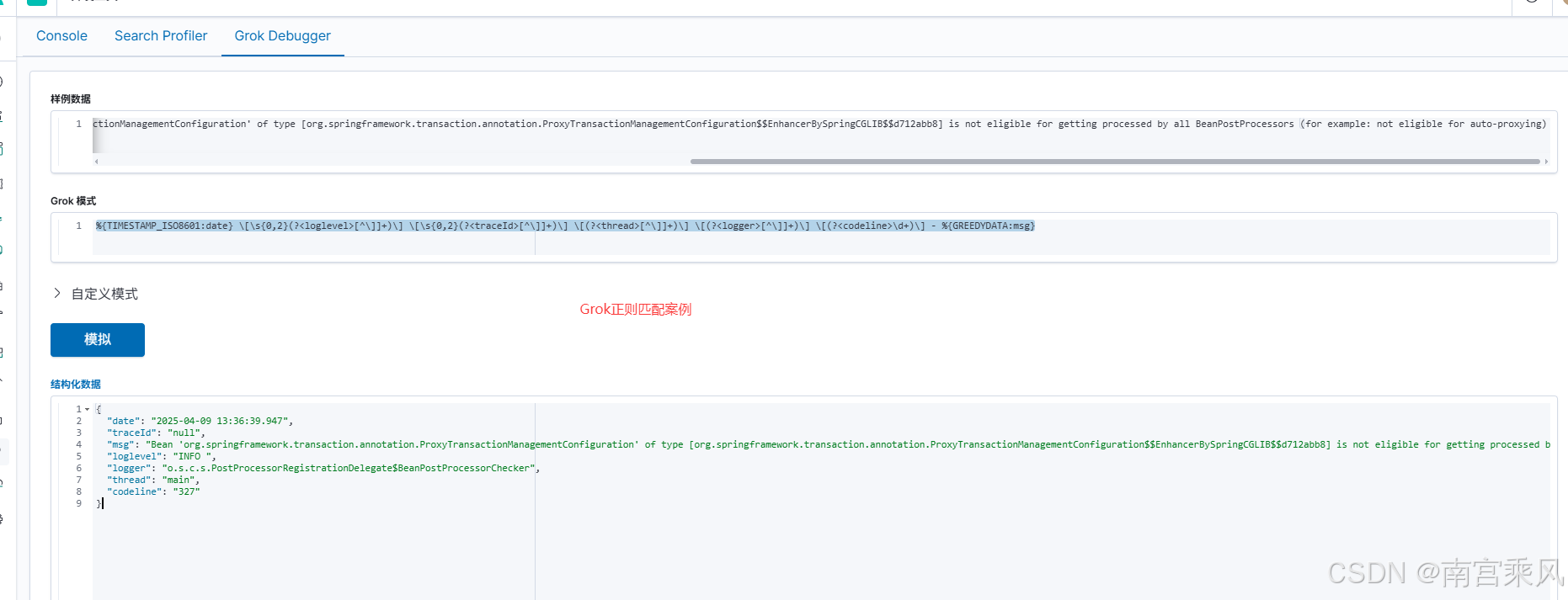

Grok语法

这个标准格式包含七大关键要素:

时间戳:精确到毫秒的ISO8601格式,确保跨时区协调

日志级别:统一5字符宽度对齐(ERROR/WARN/INFO/DEBUG)

追踪标识:分布式系统必备的traceId,缺省为null

线程信息:帮助理解异步处理流程

类名:缩写为36字符保持简洁

行号:精准定位日志产生位置

消息体:包含可选的异常堆栈信息

字段占位符 | 对应字段 | 说明 | 必要性 | 示例 |

%d{yyyy-MM-dd HH:mm:ss.SSS} | 时间戳 | 精确到毫秒的ISO8601格式 | 必要 | 2023-08-15 14:30:45.123 |

%-5level | 日志级别 | 右对齐,5字符宽度 | 必要 | INFO / ERROR |

%X{traceId:-null} | 请求链路ID | 分布式追踪标识 | 重要 | 3f5e8a2b1c9d4f7e |

%thread | 线程名 | 执行线程标识 | 必要 | http-nio-8080-exec-1 |

%logger{36} | 类名 | 截断到36字符的类全名 | 必要 | com.fjf.service.PaymentService |

%L | 代码行号 | 日志调用处的行号 | 可选 | 42 |

%msg | 日志内容 | 实际日志信息 | 核心 | “用户支付成功,金额:100.00” |

%wEx | 异常堆栈 | 附带异常时的堆栈信息 | 条件 | java.lang.NullPointerException… |

多语言实现示例

Java (Log4j2):

Python:

日志采集方案设计

混合环境下的采集策略

面对物理机与Kubernetes并存的混合环境,我们设计了分层采集方案:

宿主机 Filebeat 配置

技术关键点:

- multiline.pattern使用正则严格匹配标准格式的时间戳开头

- negate: true + match: after确保堆栈信息被正确关联到主日志行

- 通过fields添加主机IP等元信息,便于后续定位问题来源

Kubernetes Pod 内部 Filebeat ConfigMap

filebeat-configmap.yaml 可以注册到configmap中

✅ 说明:多行合并通过正则识别日志起始行(时间戳),其余行自动归入上一条日志。

K8s特定优化:

- 使用环境变量动态注入POD_IP和LOGTYPE

- 通配符路径匹配适配不同应用的日志文件

- 通过DaemonSet确保每个节点都有采集器

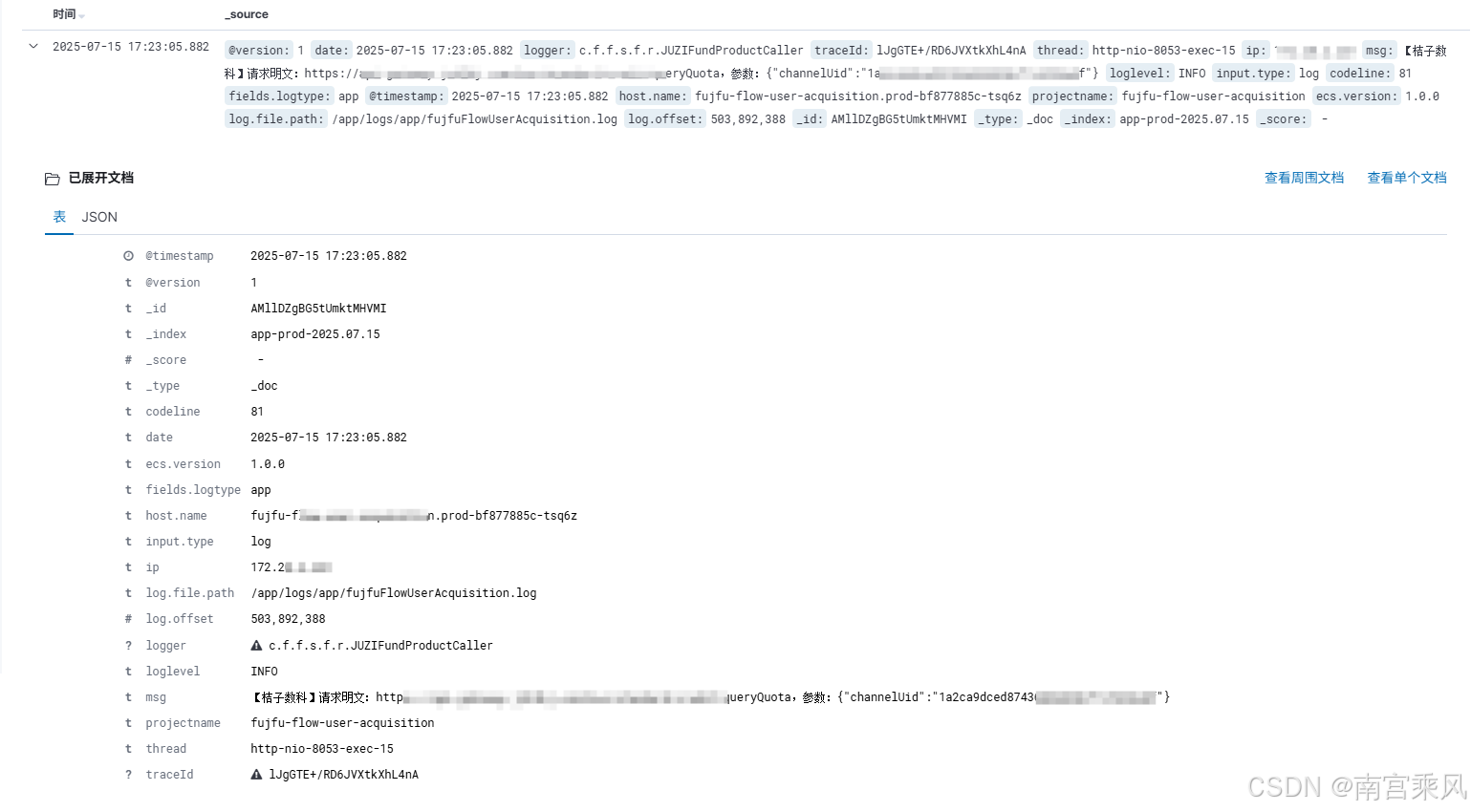

Logstash 解析规则设计

在 Logstash 中通过 filter 插件完成日志结构化处理,区分标准格式、PowerJob 特例与 JSON 格式:

生产案例:

关键处理阶段:

- 格式识别路由:区分JSON和文本日志

- 多模式Grok解析:主模式匹配标准格式,备用模式兼容历史格式

- 元数据丰富:从主机名提取项目标识

- 时间标准化:统一转化为ES兼容的时间戳

实践效果

引入统一日志系统后取得的可测量改进:

- 故障定位时间:从平均2.5小时缩短至30分钟

- 日志存储量:通过合理字段设计减少25%存储需求

- 日志利用率:结构化日志使90%的日志可被监控系统利用

- 异常检测:基于标准字段建立的规则发现率提升40%

4852

4852

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?