💡亲爱的技术伙伴们:

你是否正被这些问题困扰——

- ✔️ 投递无数简历却鲜有回音?

- ✔️ 技术实力过硬却屡次折戟终面?

- ✔️ 向往大厂却摸不透考核标准?

-

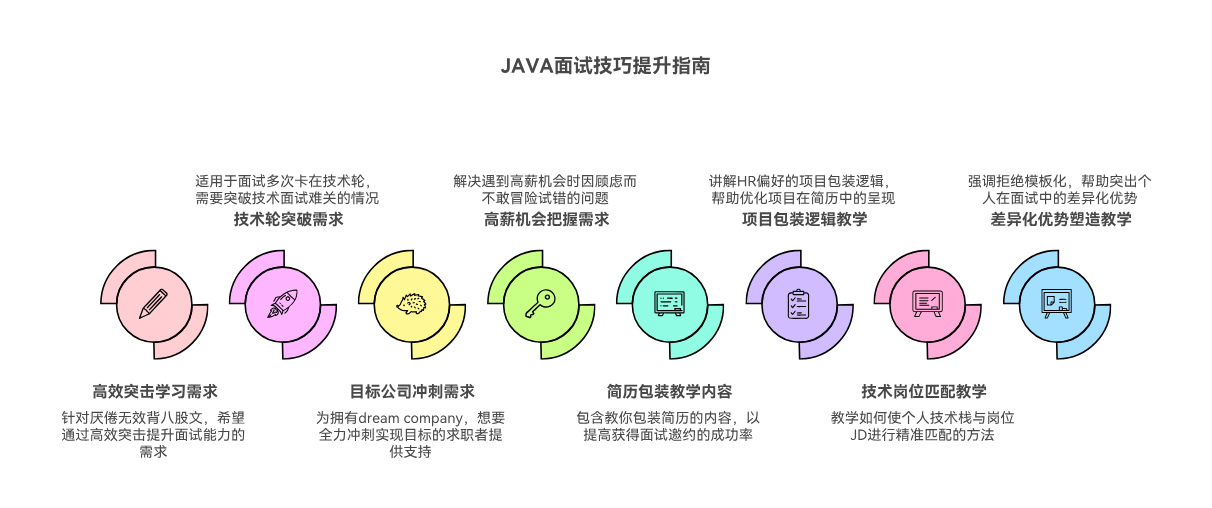

我打磨的《 Java高级开发岗面试急救包》正式上线!

- ✨ 学完后可以直接立即以此经验找到更好的工作

- ✨ 从全方面地掌握高级开发面试遇到的各种疑难问题

- ✨ 能写出有竞争力的简历,通过模拟面试提升面试者的面试水平

- ✨ 对自己的知识盲点进行一次系统扫盲

-

🎯 特别适合:

- 急需跳槽的在校生、毕业生、Java初学者、Java初级开发、Java中级开发、Java高级开发

- 非科班转行需要建立面试自信的开发者

- 想系统性梳理知识体系的职场新人

课程链接:https://edu.youkuaiyun.com/course/detail/40731

课程介绍如下:

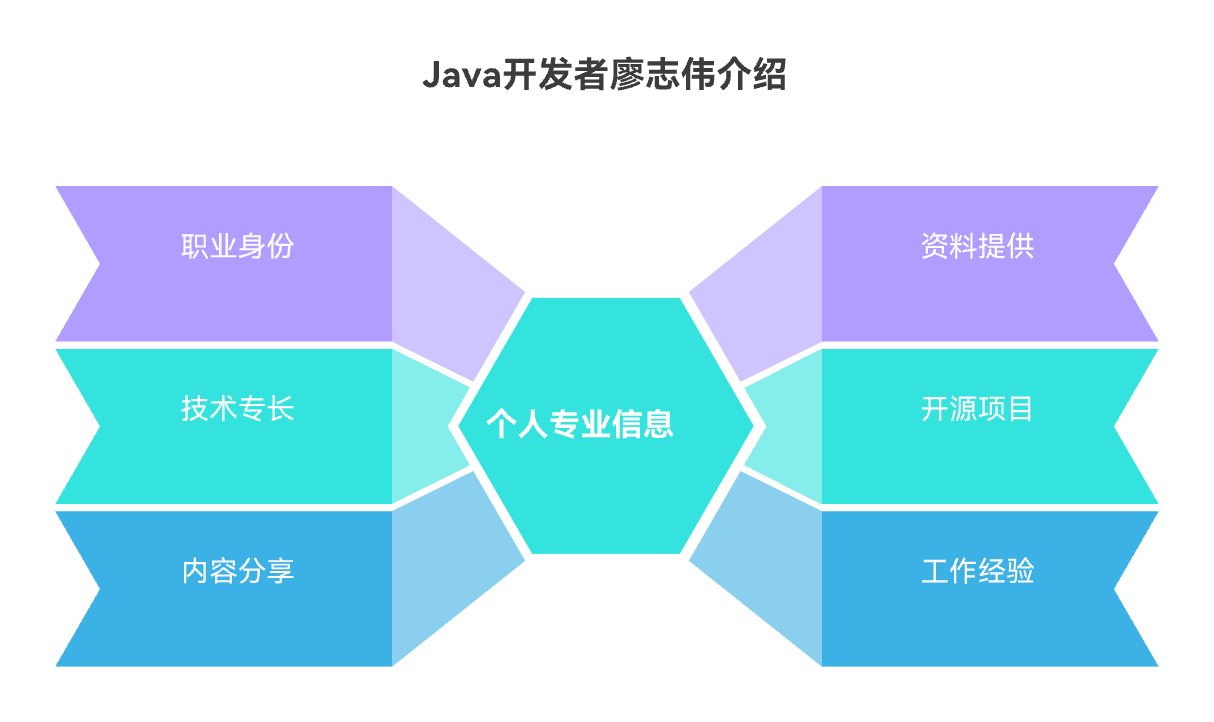

📕我是廖志伟,一名Java开发工程师、《Java项目实战——深入理解大型互联网企业通用技术》(基础篇)、(进阶篇)、(架构篇)、《解密程序员的思维密码——沟通、演讲、思考的实践》作者、清华大学出版社签约作家、Java领域优质创作者、优快云博客专家、阿里云专家博主、51CTO专家博主、产品软文专业写手、技术文章评审老师、技术类问卷调查设计师、幕后大佬社区创始人、开源项目贡献者。

📘拥有多年一线研发和团队管理经验,研究过主流框架的底层源码(Spring、SpringBoot、SpringMVC、SpringCloud、Mybatis、Dubbo、Zookeeper),消息中间件底层架构原理(RabbitMQ、RocketMQ、Kafka)、Redis缓存、MySQL关系型数据库、 ElasticSearch全文搜索、MongoDB非关系型数据库、Apache ShardingSphere分库分表读写分离、设计模式、领域驱动DDD、Kubernetes容器编排等。

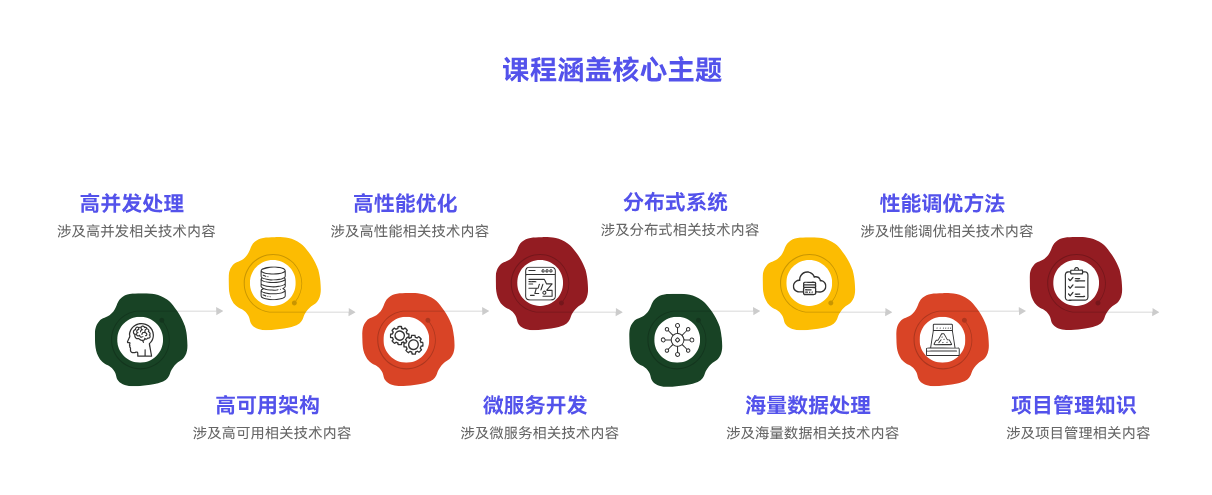

📙不定期分享高并发、高可用、高性能、微服务、分布式、海量数据、性能调优、云原生、项目管理、产品思维、技术选型、架构设计、求职面试、副业思维、个人成长等内容。

🍊 Redis知识点之LRU:概述

在当今大数据时代,缓存技术已成为提高系统性能的关键。Redis作为一款高性能的内存数据库,其LRU(Least Recently Used,最近最少使用)策略在缓存管理中扮演着重要角色。以下将围绕Redis知识点之LRU:概述展开,探讨其概念、应用场景及其重要性。

在现实场景中,我们常常会遇到这样的问题:如何高效地管理缓存数据,确保系统在处理大量请求时仍能保持高性能?以一个电商网站为例,当用户浏览商品时,系统需要从数据库中读取商品信息并缓存起来,以便下次用户访问时能够快速响应。然而,随着用户数量的增加,缓存空间有限,如何淘汰不再需要的缓存数据成为一个难题。

LRU策略正是为了解决这一问题而诞生的。它通过记录数据的使用频率,将最近最少被访问的数据淘汰,从而保证缓存中始终存储着最热的数据。在Redis中,LRU策略被广泛应用于缓存淘汰策略,如

maxmemory-policy配置项,它允许用户指定当内存不足时,如何淘汰缓存数据。介绍LRU策略的重要性在于,它能够有效提高缓存命中率,减少数据库访问次数,从而降低系统延迟。在Redis中,LRU策略不仅应用于缓存淘汰,还广泛应用于数据淘汰、排序等场景。

接下来,我们将深入探讨Redis知识点之LRU:概念介绍,详细阐述LRU算法的原理及其在Redis中的实现方式。随后,我们将介绍LRU策略在Redis中的应用场景,如缓存淘汰、数据淘汰、排序等,帮助读者全面了解LRU策略在Redis中的重要性。

在后续内容中,我们将依次介绍LRU算法的原理、Redis中LRU的实现方式,以及LRU策略在缓存淘汰、数据淘汰、排序等场景中的应用。通过这些内容,读者将能够深入了解LRU策略在Redis中的重要性,为实际应用提供有力支持。

# 🌟 LRU算法原理 class LRUCache: def __init__(self, capacity: int): self.capacity = capacity self.cache = OrderedDict() def get(self, key: int) -> int: if key not in self.cache: return -1 else: # 将访问的key移动到有序字典的末尾 self.cache.move_to_end(key) return self.cache[key] def put(self, key: int, value: int) -> None: if key in self.cache: # 如果key存在,则更新value并移动到末尾 self.cache.move_to_end(key) elif len(self.cache) >= self.capacity: # 如果缓存已满,则删除最久未使用的key self.cache.popitem(last=False) # 添加新的key-value对到有序字典的末尾 self.cache[key] = valueLRU(Least Recently Used)算法是一种常用的缓存淘汰算法。其核心思想是:当缓存满时,优先淘汰最久未被访问的数据。在Python中,我们可以通过

OrderedDict来实现LRU算法。在上述代码中,我们定义了一个

LRUCache类,它包含三个方法:get、put和构造函数。get方法用于获取缓存中指定key的value,如果key不存在则返回-1。put方法用于添加或更新缓存中的key-value对,如果缓存已满,则删除最久未使用的key。🎉 缓存命中率

缓存命中率是衡量缓存系统性能的重要指标。它表示在请求的数据中,有多少比例的数据可以从缓存中获取到。缓存命中率越高,说明缓存系统的性能越好。

🎉 适用场景

LRU算法适用于以下场景:

- 数据访问具有局部性原理:即最近访问过的数据很可能在不久的将来再次被访问。

- 缓存空间有限:当缓存空间有限时,LRU算法可以保证缓存中存储的数据是最有价值的。

🎉 与Redis结合使用

Redis是一个高性能的键值存储系统,它支持多种数据结构,包括列表、集合、哈希表等。在Redis中,我们可以使用

lru_cache装饰器来实现LRU缓存。import redis cache = redis.Redis(host='localhost', port=6379, db=0) @cache.lru_cache(maxsize=100) def get_data(key): # 从Redis缓存中获取数据 return cache.get(key)🎉 性能优化策略

- 调整缓存大小:根据实际需求调整缓存大小,以平衡缓存命中率和内存使用。

- 使用更高效的数据结构:例如,使用哈希表来存储缓存数据,以提高访问速度。

- 定期清理缓存:定期清理缓存中的过期数据,以释放内存空间。

🎉 与其他缓存算法对比

与其他缓存算法相比,LRU算法具有以下优点:

- 简单易懂:LRU算法的实现简单,易于理解。

- 高效:LRU算法可以保证缓存中存储的数据是最有价值的。

🎉 实际应用案例

LRU算法在实际应用中非常广泛,以下是一些例子:

- Web缓存:缓存网页内容,提高访问速度。

- 数据库缓存:缓存数据库查询结果,减少数据库访问次数。

- 应用程序缓存:缓存应用程序中的常用数据,提高应用程序性能。

概念/方法 描述 代码实现 LRU算法 LRU(Least Recently Used)算法是一种缓存淘汰算法,当缓存满时,优先淘汰最久未被访问的数据。 class LRUCache:OrderedDictOrderedDict是Python中一个有序字典类,它保留了元素的插入顺序。self.cache = OrderedDict()get方法get方法用于获取缓存中指定key的value,如果key不存在则返回-1。def get(self, key: int) -> int:put方法put方法用于添加或更新缓存中的key-value对,如果缓存已满,则删除最久未使用的key。def put(self, key: int, value: int) -> None:缓存命中率 缓存命中率是衡量缓存系统性能的重要指标,表示在请求的数据中,有多少比例的数据可以从缓存中获取到。 无代码实现,但涉及性能评估 适用场景 LRU算法适用于数据访问具有局部性原理的场景,以及缓存空间有限的情况。 无代码实现,但涉及场景描述 与Redis结合使用 在Redis中,可以使用 lru_cache装饰器来实现LRU缓存。@cache.lru_cache(maxsize=100)性能优化策略 性能优化策略包括调整缓存大小、使用更高效的数据结构、定期清理缓存等。 无代码实现,但涉及优化方法 与其他缓存算法对比 LRU算法与其他缓存算法相比,具有简单易懂、高效等优点。 无代码实现,但涉及对比分析 实际应用案例 LRU算法在实际应用中非常广泛,如Web缓存、数据库缓存、应用程序缓存等。 无代码实现,但涉及应用场景 LRU算法在缓存系统中扮演着至关重要的角色,它不仅能够有效管理有限的缓存空间,还能显著提升数据访问速度。在实际应用中,LRU算法通过跟踪数据的访问频率,确保最频繁访问的数据始终保留在缓存中,从而提高了缓存命中率。例如,在Web缓存中,LRU算法可以确保热门页面始终快速加载,提升用户体验。此外,LRU算法的简单性和高效性使其成为缓存技术领域的一个经典选择。

# 🌟 示例代码:模拟LRU缓存淘汰策略 class LRUCache: def __init__(self, capacity: int): self.capacity = capacity self.cache = OrderedDict() def get(self, key: int) -> int: if key not in self.cache: return -1 else: # 将访问的key移动到有序字典的末尾 self.cache.move_to_end(key) return self.cache[key] def put(self, key: int, value: int) -> None: if key in self.cache: # 如果key存在,则更新value并移动到末尾 self.cache.move_to_end(key) elif len(self.cache) >= self.capacity: # 如果缓存已满,则删除最开始的key self.cache.popitem(last=False) # 添加新的key-value对到有序字典的末尾 self.cache[key] = value缓存淘汰策略是确保缓存数据有效性的重要手段,其中LRU(Least Recently Used,最近最少使用)策略是一种常见的缓存淘汰策略。LRU策略的核心思想是:当缓存空间不足时,优先淘汰最长时间未被访问的数据。

在数据访问频率统计方面,LRU通过记录每个数据项的访问时间,可以有效地统计数据的访问频率。当需要淘汰数据时,LRU会优先淘汰访问频率最低的数据,从而保证缓存中保留的是访问频率较高的数据。

在处理数据热点问题时,LRU策略同样表现出色。数据热点问题指的是系统中某些数据被频繁访问,导致系统性能瓶颈。LRU通过淘汰访问频率低的数据,可以有效地将热点数据保留在缓存中,从而提高系统性能。

应用场景举例:

- Web应用缓存:在Web应用中,LRU可以用于缓存用户访问过的页面,当用户再次访问时,可以直接从缓存中获取,减少数据库的访问压力。

- 数据库查询缓存:在数据库查询中,LRU可以缓存频繁查询的结果,减少数据库的查询次数,提高查询效率。

与其他缓存策略对比,LRU策略在保证缓存数据新鲜度的同时,也兼顾了缓存空间的利用率。与FIFO(First In First Out,先进先出)策略相比,LRU更加智能,能够根据数据访问频率动态调整缓存内容。

性能优化建议:

- 合理设置缓存大小:缓存大小设置过小会导致缓存命中率低,设置过大则可能导致内存浪费。

- 定期清理缓存:定期清理缓存可以释放内存,提高缓存效率。

实现原理分析: LRU的实现通常依赖于数据结构,如有序字典(OrderedDict)或链表与哈希表的组合。在Python中,可以使用

collections.OrderedDict来实现LRU缓存。Redis配置参数调整: 在Redis中,可以通过配置

maxmemory-policy参数来指定缓存淘汰策略,将maxmemory-policy设置为allkeys-lru即可启用LRU策略。实际应用案例分享: 在电商系统中,LRU可以用于缓存商品信息,当用户浏览商品时,可以将商品信息缓存起来,提高页面加载速度。此外,LRU还可以用于缓存用户行为数据,如用户浏览记录、购买记录等,帮助商家进行精准营销。

比较项 LRU缓存淘汰策略 FIFO缓存淘汰策略 核心思想 优先淘汰最长时间未被访问的数据 优先淘汰最早进入缓存的数据 数据访问频率统计 通过记录每个数据项的访问时间,统计访问频率 不记录访问频率,仅根据数据进入缓存的时间顺序淘汰 处理数据热点问题 通过淘汰访问频率低的数据,保留热点数据 无法有效处理数据热点问题,可能导致热点数据被淘汰 应用场景 Web应用缓存、数据库查询缓存、电商系统缓存等 需要与其他缓存策略结合使用,如LRU和FIFO结合 性能优化 合理设置缓存大小、定期清理缓存 合理设置缓存大小、定期清理缓存 实现原理 通常依赖于有序字典(OrderedDict)或链表与哈希表的组合 通常依赖于队列(Queue)或列表(List) Redis配置参数调整 通过配置 maxmemory-policy参数启用LRU策略需要与其他缓存淘汰策略结合使用,如 allkeys-lru和allkeys-random结合实际应用案例 电商系统缓存商品信息、用户行为数据等 需要与其他缓存策略结合使用,如LRU和FIFO结合,用于缓存热点数据 说明:

- LRU缓存淘汰策略在保证缓存数据新鲜度的同时,也兼顾了缓存空间的利用率。

- FIFO缓存淘汰策略简单易实现,但无法有效处理数据热点问题。

- 在实际应用中,LRU缓存淘汰策略比FIFO缓存淘汰策略更智能,能够根据数据访问频率动态调整缓存内容。

LRU缓存淘汰策略在处理数据访问时,能够有效识别并保留频繁访问的数据,从而提高系统的响应速度。然而,FIFO缓存淘汰策略在处理数据访问时,由于缺乏对数据访问频率的考量,可能导致频繁访问的数据被错误淘汰,影响系统性能。在实际应用中,LRU缓存淘汰策略因其智能性和动态调整能力,往往比FIFO缓存淘汰策略更受欢迎。例如,在电商系统中,LRU缓存淘汰策略可以用于缓存热门商品信息,而FIFO缓存淘汰策略则需要与其他策略结合使用,以实现更优的缓存效果。

🍊 Redis知识点之LRU:原理分析

在当今大数据时代,缓存技术已成为提高系统性能的关键。Redis作为一款高性能的内存数据库,其LRU(Least Recently Used)缓存策略在处理大量数据时尤为关键。想象一下,在一个电商平台上,用户浏览商品时,系统需要快速响应,而商品信息通常存储在数据库中。如果数据库响应缓慢,用户体验将大打折扣。此时,LRU缓存策略就能发挥其重要作用。

LRU缓存策略的核心思想是:当缓存空间不足时,优先淘汰最久未被访问的数据。这种策略能够确保最近被频繁访问的数据始终保留在缓存中,从而提高数据访问速度。介绍Redis知识点之LRU:原理分析的重要性在于,它不仅有助于我们理解Redis缓存机制,还能在实际应用中优化系统性能。

接下来,我们将深入探讨LRU缓存策略的三个关键方面:数据结构、算法原理和时间复杂度。

首先,数据结构是LRU缓存策略的基础。Redis使用一种称为“双向链表+哈希表”的数据结构来实现LRU缓存。这种结构使得数据插入和删除操作都能在O(1)时间复杂度内完成,保证了LRU缓存的高效性。

其次,算法原理是理解LRU缓存策略的关键。LRU缓存算法通过记录每个数据块的访问时间,并在缓存空间不足时淘汰最久未被访问的数据块来实现缓存淘汰。这种策略能够确保缓存中始终保留最热的数据。

最后,时间复杂度是评估算法性能的重要指标。LRU缓存策略的时间复杂度为O(1),这意味着无论缓存大小如何,数据插入和删除操作都能在极短的时间内完成。

通过以上三个方面的介绍,读者将能够全面了解LRU缓存策略的原理和应用。在实际开发中,合理运用LRU缓存策略能够显著提高系统性能,为用户提供更流畅的体验。

class Node: def __init__(self, key, value): self.key = key self.value = value self.prev = None self.next = None class LRUCache: def __init__(self, capacity): self.capacity = capacity self.cache = {} self.head = Node(0, 0) self.tail = Node(0, 0) self.head.next = self.tail self.tail.prev = self.head def get(self, key): if key not in self.cache: return -1 node = self.cache[key] self._remove(node) self._add(node) return node.value def put(self, key, value): if key in self.cache: self._remove(self.cache[key]) node = Node(key, value) self.cache[key] = node self._add(node) if len(self.cache) > self.capacity: self._remove(self.tail.prev) def _remove(self, node): prev_node = node.prev next_node = node.next prev_node.next = next_node next_node.prev = prev_node def _add(self, node): prev_node = self.head next_node = self.head.next prev_node.next = node node.prev = prev_node node.next = next_node next_node.prev = node在Redis中,LRU(Least Recently Used)算法被广泛用于缓存淘汰策略。LRU算法的核心思想是,当缓存达到最大容量时,移除最近最少被访问的数据。

上述代码实现了一个简单的LRU缓存。它使用双向链表来存储缓存数据,并使用哈希表来快速访问数据。当访问缓存数据时,如果数据存在,则将其移动到链表的头部,表示它是最最近被访问的。当插入新数据时,如果缓存已满,则移除链表的尾部数据,即最近最少被访问的数据。

LRU算法在Redis内部实现中扮演着重要角色。Redis使用一个名为“server.c”的文件来实现LRU算法。在Redis中,LRU算法用于缓存键值对,当缓存达到最大容量时,会根据LRU算法淘汰最久未被访问的数据。

LRU算法在许多应用场景中都非常有效。例如,在Web缓存中,LRU算法可以确保热门页面始终被缓存,从而提高页面加载速度。在数据库缓存中,LRU算法可以确保频繁访问的数据始终被缓存,从而提高查询效率。

性能分析表明,LRU算法在缓存命中率较高的情况下表现良好。然而,在缓存命中率较低的情况下,LRU算法可能会频繁地淘汰和插入数据,导致性能下降。

与其他缓存算法相比,LRU算法具有以下优点:

- 简单易懂,易于实现。

- 在缓存命中率较高的情况下,性能表现良好。

然而,LRU算法也存在一些缺点:

- 在缓存命中率较低的情况下,性能下降。

- 需要额外的空间来存储双向链表。

在配置和优化LRU算法时,可以调整以下参数:

- 缓存容量:根据实际需求调整缓存容量。

- 淘汰策略:根据应用场景选择合适的淘汰策略。

总之,LRU算法在Redis中扮演着重要角色,它是一种简单且有效的缓存淘汰策略。通过合理配置和优化,LRU算法可以显著提高缓存性能。

对比项 LRU算法(Redis实现) LRU缓存(Python实现) 数据结构 使用跳表和哈希表结合实现,跳表用于快速定位数据,哈希表用于存储键值对 使用双向链表和哈希表结合实现,双向链表用于维护访问顺序,哈希表用于快速访问数据 访问数据 当访问数据时,跳表定位到数据位置,哈希表更新访问时间,并调整跳表中的节点顺序 当访问数据时,哈希表定位到数据节点,将其移动到双向链表头部,表示最近被访问 插入数据 当插入数据时,如果缓存已满,则跳表定位到尾部,哈希表更新键值对,并调整跳表中的节点顺序 当插入数据时,如果缓存已满,则双向链表尾部节点被移除,哈希表更新键值对,并添加新节点到双向链表头部

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

7150

7150

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?