大语言模型在数学推理方面取得了显著进展,通过采用强化学习方法,以正确最终答案作为奖励信号来扩展推理能力,在一年内便实现了从表现不佳到在 AIME 和 HMMT 等定量推理竞赛中达到饱和水平的飞跃。但这一方法仍面临根本性局限:正确的答案并不意味着推理过程正确,并且许多数学任务(如定理证明)要求严格的逐步推导过程,而非仅给出数值答案,因此依赖最终答案奖励的机制在此类任务中并不适用。

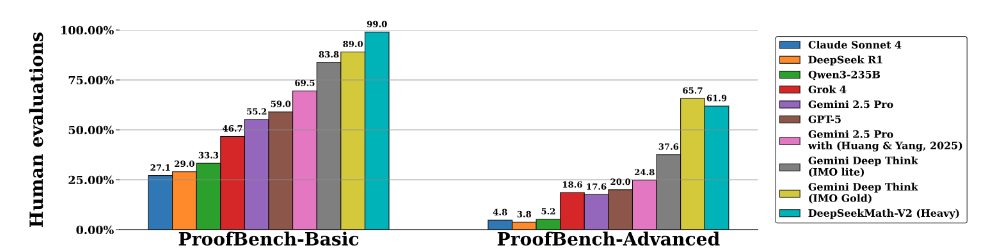

为突破深度推理瓶颈,DeepSeek 训练了准确且忠实的基于大型语言模型的验证器,用于评估定理证明。随后将其作为奖励模型训练证明生成器,使其能自我修正。通过扩展验证资源自动标注难例,持续提升验证器能力,形成生成与验证的增强循环。最终模型 DeepSeekMath-V2 在 IMO 2025、CMO 2024 获金牌级成绩,Putnam 2024 获 118/120分 的亮眼表现。

论文链接:https://go.hyper.ai/wftNU

最新 AI 论文:https://go.hyper.ai/hzChC

为了让更多用户了解学术界在人工智能领域的最新动态,HyperAI超神经官网(hyper.ai)现已上线「最新论文」板块,每天都会更新 AI 前沿研究论文。以下是我们为大家推荐的 5 篇热门 AI 论文,一起来速览本周 AI 前沿成果吧~

COSCon’25 第十届中国开源年会将于 2025 年 12 月 6——7 日在北京市海淀区丽亭华苑酒店举办。HyperAI超神经将作为联合出品社区,将在大会期间举办「产研开源协同论坛」。与此同时,HyperAI超神经将为大家带来为期两天的主论坛直播,快来预约围观吧!

本周论文推荐

1

DeepSeekMath-V2: Towards Self-Verifiable Mathematical Reasoning

大语言模型在数学推理方面取得了显著进展,这不仅为人工智能提供了一个重要的测试平台,若进一步发展,还可能对科学研究产生深远影响。但当前仍面临根本性局限:追求更高的最终答案准确率,并不能解决一个核心问题——正确的答案并不意味着推理过程正确。因此本文提出 DeepSeekMath-V2,在大规模测试计算资源的支持下,展现出强大的定理证明能力:在 2025 年国际数学奥林匹克和 2024 年中国数学奥林匹克中取得金牌级成绩,在 2024 年普特南数学竞赛中获得接近满分的 118/120分。

论文链接:https://go.hyper.ai/wftNU

lMO-ProofBench 测试结果

2

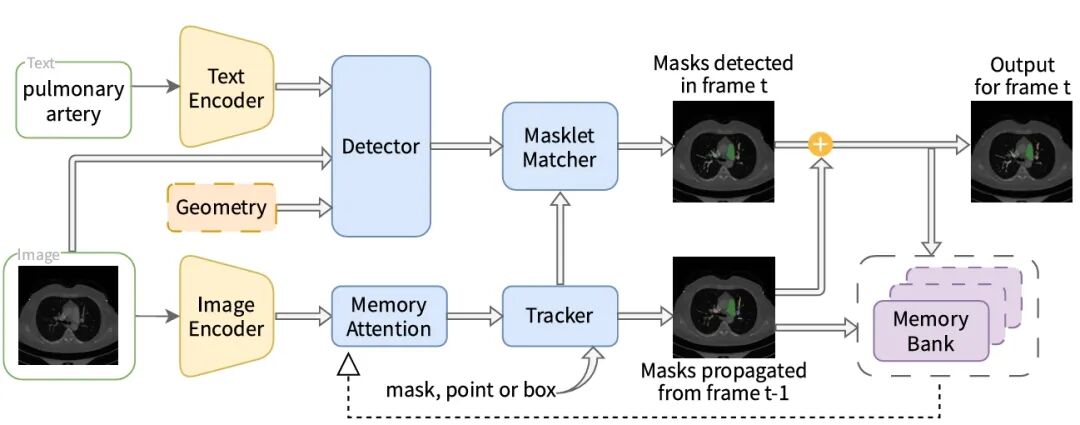

MedSAM3: Delving into Segment Anything with Medical Concepts

本文提出 MedSAM-3——一种可接受文本提示的医学图像与视频分割模型。通过在配以语义概念标签的医学图像数据上对 SAM 3 架构进行微调,MedSAM-3 实现了医学可提示概念分割(Promptable Concept Segmentation, PCS),使用户能够通过开放词汇的文本描述精准定位解剖结构,而不仅依赖于几何提示。

论文链接:https://go.hyper.ai/0EWF0

模型架构概述

3

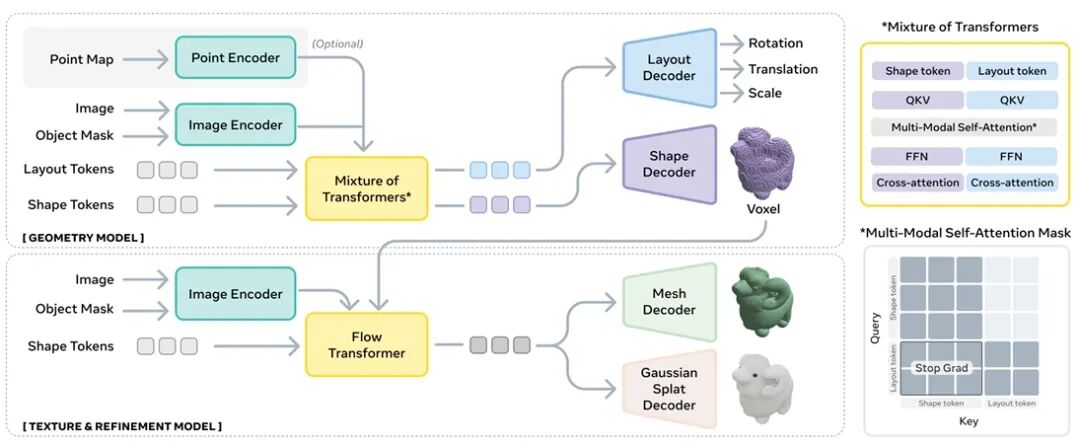

SAM 3D: 3Dfy Anything in Images

本文提出 SAM 3D,一种用于视觉引导的三维物体重建的生成模型,能够仅从单张图像中预测物体的几何结构、纹理信息及场景布局。该模型在自然图像场景中表现尤为出色,这类场景中遮挡和场景杂乱现象普遍,上下文提供的视觉识别线索起着更为关键的作用。

论文链接:https://go.hyper.ai/8GqYm

模型概述

4

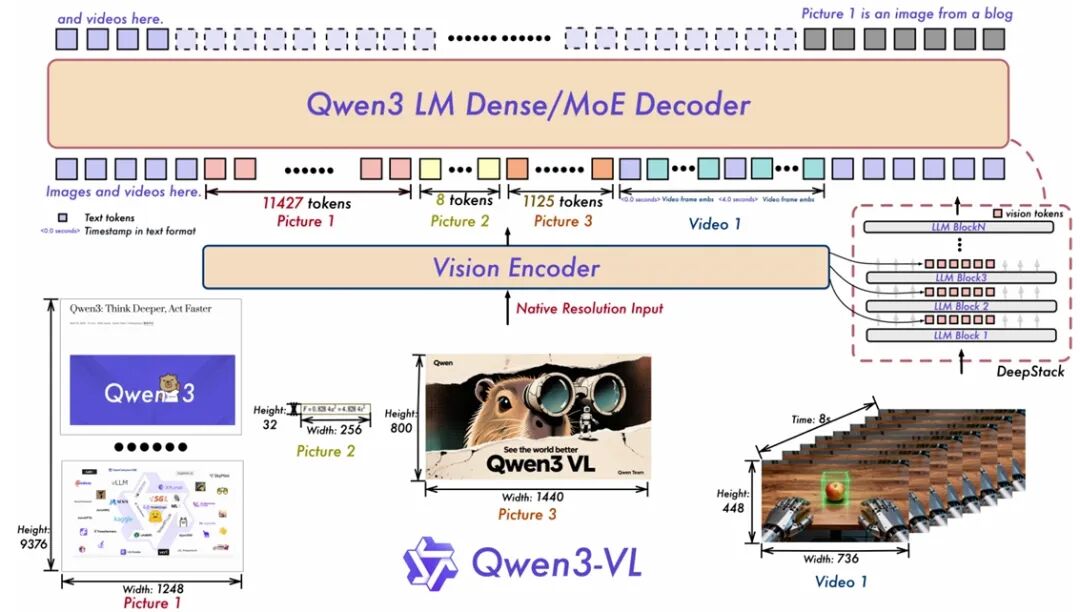

Qwen3-VL Technical Report

本文推出 Qwen3-VL,这是迄今为止 Qwen 系列中能力最强的视觉语言模型,在广泛的多模态基准测试中均展现出卓越性能。该模型原生支持长达 256K tokens 的交错上下文,能够无缝融合文本、图像与视频信息。模型家族涵盖密集架构(2B/4B/8B/32B)与混合专家架构(30B-A3B/235B-A22B),以适应不同场景下的延迟与质量权衡需求。

论文链接:https://go.hyper.ai/yeOZT

模型架构

5

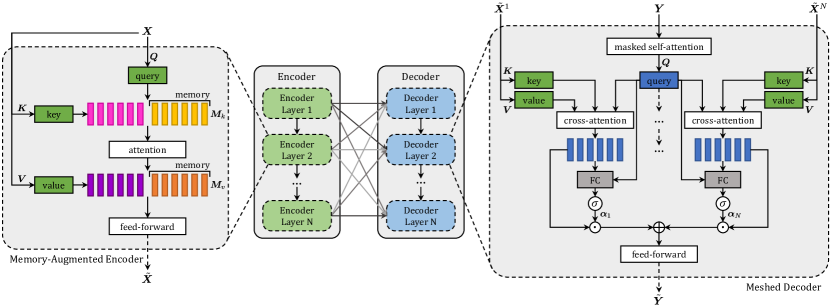

Meshed-Memory Transformer for Image Captioning

本文提出 M²——一种面向图像字幕生成的带记忆网格 Transformer(Meshed Transformer with Memory)。该架构在图像编码与语言生成两个阶段均实现改进:一方面,通过融合学习到的先验知识,构建图像区域间多层次关系表示;另一方面,在解码阶段采用类网格的连接结构,有效利用低层与高层特征。

论文链接:https://go.hyper.ai/eIKYK

模型架构图

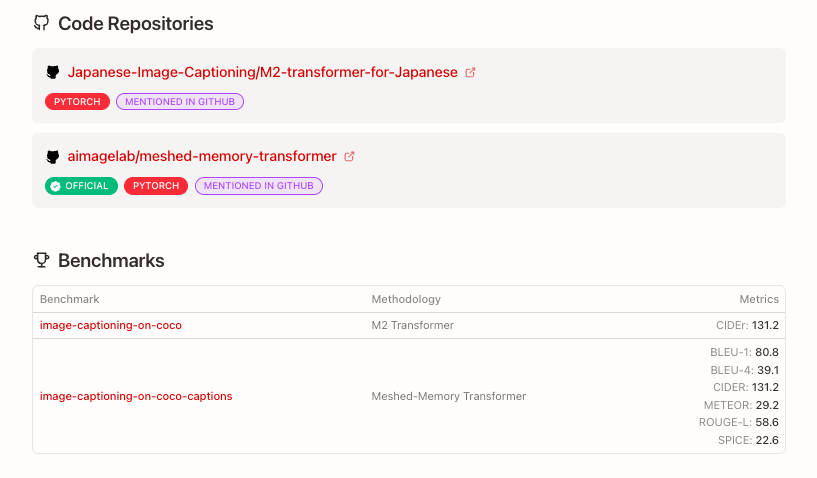

此外,该论文还提供了相关 Code 仓库和 Benchmarks 供大家查阅参考

以上就是本周论文推荐的全部内容,更多 AI 前沿研究论文,详见 hyper.ai 官网「最新论文」板块。

同时也欢迎研究团队向我们投稿高质量成果及论文,有意向者可添加神经星星微信(微信号:Hyperai01)。

下周再见!

1988

1988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?