2020 年 Meta 提出的 RAG(检索增强生成) 框架有效提升了 LLM 输出的准确性和可靠性,该技术从最初的简单检索+生成,已经发展到具备多轮推理、工具使用、上下文记忆等 Agent 特征的高级形态。当前大多数 RAG 引擎在文档解析方面相对简单,且依赖于现成的检索中间件,检索精度较差。

基于此,InfiniFlow 开源了 RAGFlow,这是一个基于深度文档理解的开源 RAG引擎。其不仅解决了上述难点,还提供了预构建的 RAG 工作流程,使用者只需按流程逐步操作,就能快速搭建起 RAG 系统。与 Qwen3 Embedding 集成后,能够实现一站式构建本地知识库、智能问答系统和 Agent。

目前,HyperAI超神经官网已上线了「构建 RAG 系统:基于 Qwen3 Embedding 的实践」教程,快来试试吧~

构建 RAG 系统:基于 Qwen3 Embedding 的实践

在线使用:https://go.hyper.ai/FFA7f

6 月 23 日-6 月 27 日,hyper.ai 官网更新速览:

* 优质公共数据集:10 个

* 优质教程精选:6 个

* 本周论文推荐: 5 篇

* 社区文章解读:3 篇

* 热门百科词条:5 条

* 7 月截稿顶会:5 个

访问官网:hyper.ai

公共数据集精选

1. Sekai 世界视频数据集

Sekai 是一个高质量第一人称视角全球视频数据集,旨在为视频生成和世界探索领域激发有价值的应用。该数据集专注于以自我为中心的世界探索,由 Sekai-Real 和 Sekai-Game 两部分组成,包含来自 100 多个国家和地区、750 个城市的超过 5,000 小时的步行或无人机视角视频。

直接使用:https://go.hyper.ai/YyBKB

数据集概览

2. Ecomapper 卫星图像数据集

该数据集包含超过 290 万张卫星图像,包括 RGB 影像以及特定的多光谱通道数据。数据图像均来自哥白尼哨兵卫星任务,涵盖多种土地覆盖类型和多个时间点,训练集有 98,930 个不同地理位置,测试集包含 5,494 个位置。每张图像的每个时间戳都配有相关的天气元数据,如温度、太阳辐射和降水信息。

直接使用:https://go.hyper.ai/1u8s6

数据集示例

3. NuScenes 自动驾驶数据集

NuScenes 是一个用于自动驾驶的公开数据集,包含来自波士顿和新加坡约 140 万张摄像头图像、39 万张激光雷达扫描图像、140 万张雷达扫描图像以及 4 万个关键帧中的 140 万个物体边界框。

直接使用:https://go.hyper.ai/rgw1k

4. Tahoe-100M 单细胞数据集

Tahoe‑100M 是全球最大的单细胞数据集,旨在为具备干预理解能力的大语言模型(LLM)提供真实且结构化的实验数据基础。该数据集包含超过 1 亿个细胞,覆盖超过 6 万次分子干预实验,映射了 50 种癌症模型对 1,100 多种药物治疗的反应。

直接使用:https://go.hyper.ai/Hfzva

5. WebClick 网页理解基准数据集

WebClick 是一个高质量的网页理解基准数据集,用于评估多模态模型和智能体理解网页界面、解读用户指令以及在数字环境中采取精准行动的能力。该数据集包含来自 100 多个网站的 1,639 张英文网页截图,这些截图配有精确标注的自然语言指令和像素级点击目标。

直接使用:https://go.hyper.ai/ezz46

6. DeepResearch Bench 深度研究基准数据集

DeepResearch Bench 是一个深度研究代理基准数据集,旨在揭示人类在不同领域的深度研究需求的真实分布。该数据集包含 100 个博士级研究任务,每个任务均由 22 个不同领域的专家精心打造。

直接使用:https://go.hyper.ai/yVHfH

7. SA-Text 图像文本数据集

SA-Text 是一个高质量场景图像的大规模基准数据集,专为文本感知图像恢复任务设计。该数据集包含105,330 张高分辨率场景图像,并配有多边形级别的文本标注,能够准确地描述文本在图像中的位置和形状,使模型能够更好地理解文本在图像中的位置和结构。

直接使用:https://go.hyper.ai/ICYIY

8. OCRBench 文本识别基准数据集

该数据集包含 1,000 个手动筛选和校正的问答对,这些问答对来自 5 项具有代表性的文本相关任务:文本识别、场景文本中心、文档导向、关键信息和手写数学表达式。

直接使用:https://go.hyper.ai/ZcKoD

9. Parse-PBMC 单细胞 RNA 测序数据集

Parse-PBMC 是一个开源的单细胞 RNA 测序数据集。该数据集是在一次实验中对 1,152 个样本中的 1 千万个细胞进行分析,主要用于研究人类外周血单个核细胞在不同条件下的基因表达特征。

直接使用:https://go.hyper.ai/CwOMc

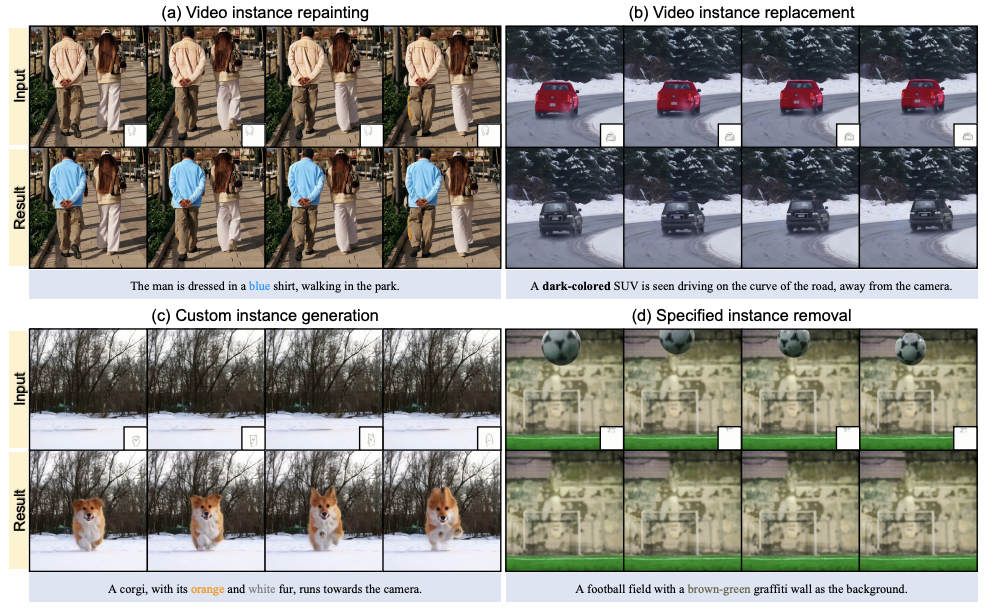

10. VIRESET 视频实例编辑数据集

VIRESET 旨在为视频实例重绘、时序分割等任务提供精确的标注支撑。该数据集包含 2 个内容,SA-V 增强掩码标注和86k 个视频片段。

直接使用:https://go.hyper.ai/5hnGF

公共教程精选

本周汇总了 2 类优质公共教程:

*大模型部署教程:3 个

*视频生成教程:3 个

大模型部署教程

1. 构建 RAG 系统:基于 Qwen3 Embedding 的实践

RAGFlow 是一个基于深度文档理解的开源 RAG(检索增强生成)引擎。与 LLM 集成后,它能够提供真实的问答功能,并以来自各种复杂格式数据的可靠引用为支撑。

在线运行:https://go.hyper.ai/FFA7f

2. vLLM+Open WebUI 部署 QwenLong-L1-32B

QwenLong-L1-32B 是首个基于强化学习训练的长文本推理大模型,专注于解决传统大模型在处理超长上下文(如 12 万 token)时出现的记忆力差,逻辑混乱等问题,突破了传统大模型的上下文限制,为金融、法律等高精度场景提供了低成本、高性能的解决方案。

在线运行:https://go.hyper.ai/f73C2

3. vLLM+Open WebUI 部署 Magistral-Small-2506

Magistral-Small-2506 基于 Mistral Small 3.1(2503)构建,增加了推理能力,通过 Magistral Medium 跟踪进行 SFT 并在顶部进行强化学习。它是一个参数量为 24B 的小型高效推理模型,能够在提供答案之前进行长链推理追踪,以更深入地理解和处理复杂问题,从而提高回答的准确性和合理性。

在线运行:https://go.hyper.ai/yLeoh

视频生成教程

1. MAGI-1:全球首个自回归视频生成大模型

Magi-1 是全球首个自回归视频生成大模型,通过自回归预测一系列视频块来生成视频,定义为连续帧的固定长度片段。它在以文本指令为条件的图像到视频任务上实现了强大的性能,提供了高度的时间一致性和可扩展性。

在线运行:https://go.hyper.ai/NZ6cc

2. FramePackLoop:开源无缝循环视频生成工具

FramePackLoop 是一个自动化帧序列处理与循环生成工具,旨在简化视频制作工作流程。该工具利用模块化架构实现帧序列打包、时间对齐和无缝循环合成。具体而言,它将光流估计与基于注意力的时间建模相结合,以保持帧间运动的连贯性。

在线运行:https://go.hyper.ai/WIRoM

Demo 示例

3. VIRES:草图与文本双引导的视频重绘

VIRES 一种结合草图与文本引导的视频实例重绘方法,支持对视频主体的重绘、替换、生成与移除等多种编辑操作。该方法利用文本生成视频模型的先验知识,确保时间上的一致性。实验结果表明,VIRES 在视频质量、时间一致性、条件对齐和用户评分等多方面均是优异表现。

在线运行:https://go.hyper.ai/GeZxZ

Demo 示例

💡我们还建立了 Stable Diffusion 教程交流群,欢迎小伙伴们扫码备注【SD教程】,入群探讨各类技术问题、分享应用效果~

本周论文推荐

1. Drag-and-Drop LLMs: Zero-Shot Prompt-to-Weights

本文引入了拖放式大型语言模型(DnD),这是一种基于提示的参数生成器,通过直接将少量未标记的任务提示映射到 LoRA 权重更新来消除每任务训练的需求。一个轻量级的文本编码器将每个提示批次提炼为条件嵌入,然后由级联超卷积解码器将其转换为完整的 LoRA 矩阵集合。

论文链接:https://go.hyper.ai/hAO8y

2. Light of Normals: Unified Feature Representation for Universal Photometric Stereo

本文提出了一种新型的通用照相立体(Universal Photometric Stereo,UniPS)方法,旨在解决在任意光照条件下恢复高精度表面法线的问题。实验结果表明,与现有最先进的通用照相立体方法相比, LINO-UniPS 在公共基准上的性能更优,并且显示出强大的泛化能力,能有效应对不同材料属性和光照场景。

论文链接:https://go.hyper.ai/oTFMo

3. Vision-Guided Chunking Is All You Need: Enhancing RAG with Multimodal Document Understanding

本文提出了一种新颖的多模态文档分块方法,该方法利用大型多模态模型(LMMs)批量处理 PDF 文档,同时保持语义连贯性和结构完整性。该方法以可配置的页面批次对文档进行处理,并保留跨批次的上下文信息,从而能够准确处理跨越多个页面的表格、嵌入的视觉元素和程序性内容。

论文链接:https://go.hyper.ai/IZA15

4. OmniGen2: Exploration to Advanced Multimodal Generation

本文介绍了 OmniGen2,这是一款多功能且开源的生成模型,旨在为多种生成任务提供统一的解决方案,包括文本到图像生成、图像编辑和上下文生成。与 OmniGen v1 不同,OmniGen2 为文本和图像模态设计了两条独立的解码路径,采用了非共享参数和分离的图像分词器。这一设计使得 OmniGen2 能够在现有的多模态理解模型基础上进行构建,而无需重新适应 VAE 输入,从而保留了原有的文本生成能力。

论文链接:https://go.hyper.ai/iCFzp

5. PAROAttention: Pattern-Aware ReOrdering for Efficient Sparse and Quantized Attention in Visual Generation Models

本文提出了一种新的模式感知标记重排序(PARO) 技术,该技术将多样化的注意力模式统一为硬件友好的块状模式。这种统一显著简化并增强了稀疏化和量化的效果。该方法中 PAROAttention 在几乎不损失指标的情况下实现了视频和图像生成,并且在显著降低密度和位宽的情况下,达到了与全精度基线几乎相同的结果,实现了 1.9 倍到 2.7 倍的端到端延迟加速。

论文链接:https://go.hyper.ai/sScNH

更多 AI 前沿论文:https://go.hyper.ai/iSYSZ

社区文章解读

1. DeepMind 发布 AlphaGenome,1 秒内完成所有模态和细胞类型的变异效应预测

谷歌 DeepMind 发布 AlphaGenome 模型,可预测数千种与其调控活性相关的分子属性,同时还可以通过比较变异与未变异序列的预测结果,评估基因变异或突变的影响。AlphaGenome 的重要突破之一便是能够直接从序列预测剪接连接点,并将其用于变异效应预测。

查看完整报道:https://go.hyper.ai/o8E1F

2. 从全心脏模型到基于 LLM 的疾病网络分析,清华长庚医院李栋从数据视角剖析医疗大模型发展趋势

清华长庚医院医学数据科学中心主任李栋教授在 2025 北京智源大会中,就「智慧医疗时代下如何应用医疗数据开展创新研究」进行了专题分享,介绍了大模型在智慧医疗时代带来的创新。

查看完整报道:https://go.hyper.ai/rAabv

3. 继 Evo 2 之后,Arc Institute 发布首个虚拟细胞模型 STATE,训练数据涉及 70 种不同细胞系

非盈利研究机构 Arc Institute 联合 UC 伯克利、斯坦福等高校的研究团队,推出了虚拟细胞模型 STATE,能够预测干细胞、癌细胞和免疫细胞在药物、细胞因子或遗传干预下的响应情况。实验结果显示,State 在预测干预后转录组变化的表现显著优于当前主流方法。

查看完整报道:https://go.hyper.ai/B3Rc6

热门百科词条精选

1. DALL-E

2. 倒数排序融合 RRF

3. 帕累托前沿 Pareto Front

4. 大规模多任务语言理解 MMLU

5. 对比学习 Contrastive Learning

这里汇编了数百条 AI 相关词条,让你在这里读懂「人工智能」:

https://go.hyper.ai/wiki

7 月截稿顶会

7 月 2 日

7:59:59

VLDB 2026

7 月 11 日

7:59:59

POPL 2026

7 月 15日

7:59:59

SODA 2026

7 月 18 日

7:59:59

SIGMOD 2026

7 月 19 日

7:59:59

ICSE 2026

一站式追踪人工智能学术顶会:https://go.hyper.ai/event

以上就是本周编辑精选的全部内容,如果你有想要收录 hyper.ai 官方网站的资源,也欢迎留言或投稿告诉我们哦!

下周再见!

关于 HyperAI超神经 (hyper.ai)

HyperAI超神经 (hyper.ai) 是国内领先的人工智能及高性能计算社区,致力于成为国内数据科学领域的基础设施,为国内开发者提供丰富、优质的公共资源,截至目前已经:

* 为 1800+ 公开数据集提供国内加速下载节点

* 收录 600+ 经典及流行在线教程

* 解读 200+ AI4Science 论文案例

* 支持 600+ 相关词条查询

* 托管国内首个完整的 Apache TVM 中文文档

访问官网开启学习之旅:

https://hyper.ai/

最后推荐一个「创作者激励计划」,感兴趣的小伙伴扫码即可参与!

往期推荐

744

744

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?