Pytorch显存充足出现CUDA error:out of memory错误

报错内容

Bug描述

显存充足,并且已经通过 torch.nn.DataParallel 指定GPU编号

CUDA与CUDNN均无错误,NVIDIA驱动无错误

解决方案

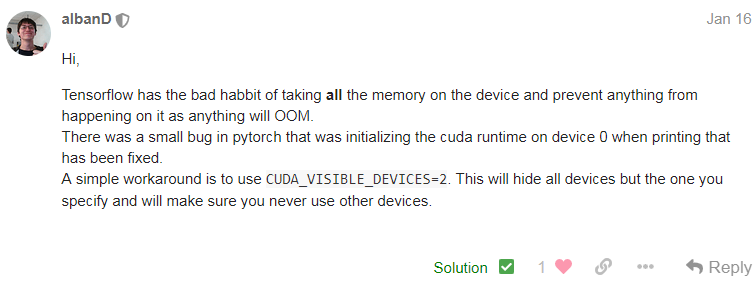

以上情况很可能是是Tensorflow和pytorch冲突导致的,因为我发现当我同学在0号GPU上运行程序我就会出问题。

详见pytorch官方论坛:

https://discuss.pytorch.org/t/gpu-is-not-utilized-while-occur-runtimeerror-cuda-runtime-error-out-of-memory-at/34780

使用 CUDA_VISIBLE_DEVICES 限制一下使用的GPU。

比如有0,1,2,3号GPU,CUDA_VISIBLE_DEVICES=2,3,则当前进程的可见GPU只有物理上的2、3号GPU,此时它们的编号也对应变成了0、1,即cuda:0对应2号GPU,cuda:1对应3号GPU。

# 使用python的os模块

import os

os.environ['CUDA_VISIBLE_DEVICES']='2, 3'

# 直接设置环境变量(linux系统)

export CUDA_VISIBLE_DEVICES=2,3

当Pytorch在CUDA环境下运行时,即使显存充足,也可能遇到'out of memory'错误。这可能是Tensorflow与Pytorch冲突导致的。解决方案是设置CUDA_VISIBLE_DEVICES环境变量,限制使用特定GPU,例如CUDA_VISIBLE_DEVICES=2,3,使得进程只使用物理上的2、3号GPU,避免资源冲突。"

132648321,19673927,Python实现计算IOU算法,"['计算机视觉', '图像处理', 'Python编程', '算法']

当Pytorch在CUDA环境下运行时,即使显存充足,也可能遇到'out of memory'错误。这可能是Tensorflow与Pytorch冲突导致的。解决方案是设置CUDA_VISIBLE_DEVICES环境变量,限制使用特定GPU,例如CUDA_VISIBLE_DEVICES=2,3,使得进程只使用物理上的2、3号GPU,避免资源冲突。"

132648321,19673927,Python实现计算IOU算法,"['计算机视觉', '图像处理', 'Python编程', '算法']

2864

2864

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?